Utf8 encode: PHP: utf8_encode — Manual

encodeURI() — JavaScript | MDN

Метод encodeURI () кодирует универсальный идентификатор ресурса (URI), замещая некоторые символы на одну, две, три или четыре управляющие последовательности, представляющие UTF-8 кодировку символа (четыре управляющие последовательности будут использованы только для символов, состоящих из двух «суррогатных» символов).

Предполагается, что URI является полным URI, поэтому метод не кодирует зарезервированные символы, имеющие особое значение в URI.

encodeURI заменяет все символы, кроме следующих с соответствующими UTF-8 управляющими последовательностями:

| Зарезервированные символы | ; , / ? : @ & = + $ |

| Неэкранируемые символы | латинские буквы, десятичные цифры, - _ . ! ~ * ' ( ) |

| Score | # |

Заметим, что encodeURI сам по себе не может сформировать правильные HTTP GET и POST запросы, такие как XMLHTTPRequests, потому, что «&», «+», и «=» не закодированы, которые воспринимаются как специальные символы в GET и POST запросах. encodeURIComponent, однако, кодирует эти символы

Замечание: URIError будет брошена, если попытаться закодировать суррогат, который не является частью высоко-низкой пары, например:

console.log(encodeURIComponent('\uD800\uDFFF'));

console.log(encodeURIComponent('\uD800'));

console.log(encodeURIComponent('\uDFFF'));Также заметим, что следуя наиболее свежей RFC3986 для URL, которая делает квадратные скобки защищёнными (для IPv6) и таким образом не кодирует, когда формирование чего-либо, не являющегося частью URL (такое как домен), следующий сниппет поможет:

function fixedEncodeURI (str) {

return encodeURI(str). replace(/%5B/g, '[').replace(/%5D/g, ']');

}

replace(/%5B/g, '[').replace(/%5D/g, ']');

}Юникод в Python — Введение в Python

Видео может быть заблокировано из-за расширений браузера. В статье вы найдете решение этой проблемы.

Unicode in Python

Before the Unicode

- Memory consists of bytes

- A string is a chain of bytes

- One byte can have up to 256 values

- One byte can mark one of 256 symbols

- To print a byte, you should find a symbol that it marks…

- … with a special table, named

Code page

ASCII Code page

- a special table that compares bytes with symbols

- ASCII table as a standard

- 0..127 for latin and system symbols

- 128..255 for extended symbols

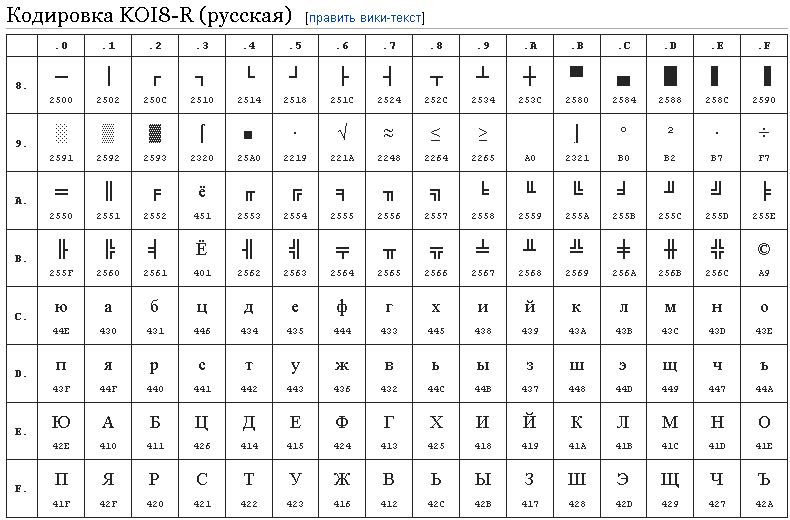

How about foreign languages?

- 0..127 for latin and system symbols anyway

- 128..255 for realm-specific symbols

- One realm — one code page

cp866DOS-Cyrilliccp1251Windows-Cyrilliccp1253Windows-Creek- etc

Encoding hell

- Lots of code pages

- Every message should declare the code page

- Encode/decode errors, strange symbols instead of text

- Remember your inbox 10 years ago

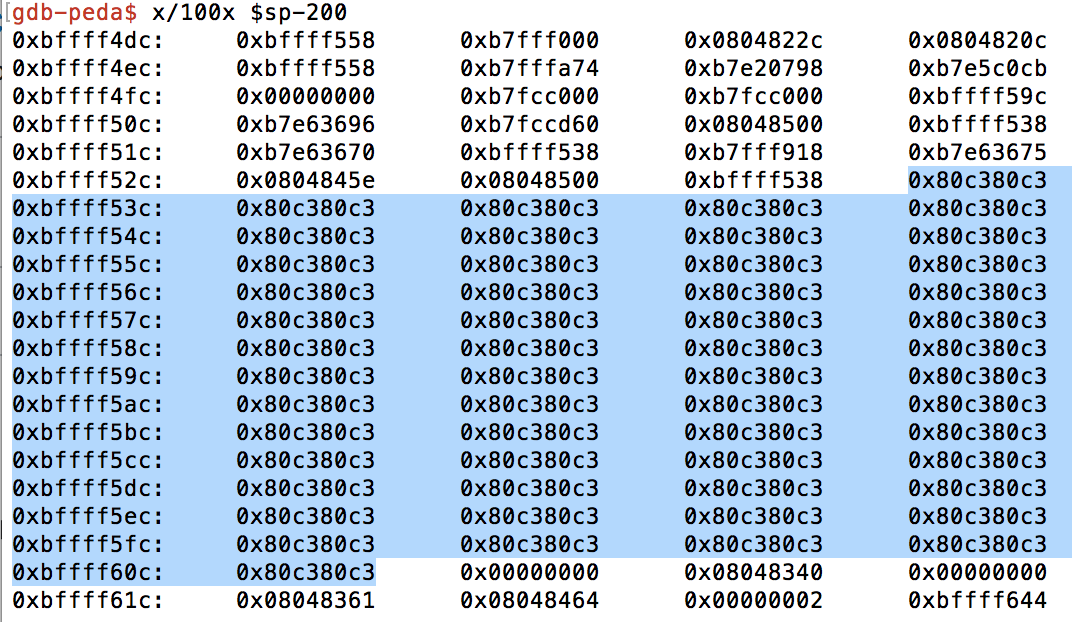

How does it fail

- User A types

"Привет"on Linux (utf-8) - The bytes are

\xd0\x9f\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82 - The program should send a header with encoding, but it doesn’t

- User B receives the message without header on Windows (cp1251)

- So default code page becomes cp1251

- Decoded message is

Привет - :—(

The solution is Unicode

- It’s a common unlimited alphabet

- Every symbol has its own number

- Unicode is growing

U+XXXXto refer a specific code

U+0031 1

U+00A9 ©

U+20AC €

U+266B ♫

U+4E64 乤

U+45B4 䖴

What is UTF?

- An algorithm how turn Unicode into bytes and read it back

- There are

UTF-8,-16and-32encodings UTF-8uses 1 byte for latin and 2 bytes for non-latinUTF-8is compatible with english text- Can encode large subset of Unicode

Still have problems with Unicode?

- Try to use

UTF-8encoding everywhere - Read Joel Spolsky «About Unicode and Character Sets»

Unicode in Python 2. x

x

- Unicode strings are declared with

u'...'prefix - The should be coding directive in your file

- Use

\uXXXXto refer unicode symbols0..FFFF \UXXXXXXXXto refer0..FFFFFFFFsymbols (rare)

# coding=utf-8 # -*- coding: utf-8 -*-

name = u'Иван'

name = u'Ιαννης'

name = u'João'

greet = u'\u041f\u0440\u0438\u0432\u0435\u0442'

print greet

>>> Привет

print u'\U0000041f\U00000440\U00000438\U00000432\U00000435\U00000442'

>>> Привет

data = u"""

Any string in english

Любая строка на русском

任何字符串在中國"""

print data

Any string in english

Любая строка на русском

任何字符串在中國

repr(data)

u'\nAny string in english\n\u041b\u044e\u0431\u0430\u044f \u0441\u0442\u0440\u043e\u043a\u0430 \u043d\u0430 \u0440\u0443\u0441\u0441\u043a\u043e\u043c\n\u4efb\u4f55\u5b57\u7b26\u4e32\u5728\u4e2d\u570b\n'

How to turn an object into Unicode

unicode([1, 2, True, {"test": 42}])

>>> u"[1, 2, True, {'test': 42}]"

unicode(obj) == obj. __unicode__()

class User(object):

def __unicode__(self):

return u'%s %s' % (self.name, self.surname)

user = User(...)

unicode(user) # u'Михаил Паниковский'

__unicode__()

class User(object):

def __unicode__(self):

return u'%s %s' % (self.name, self.surname)

user = User(...)

unicode(user) # u'Михаил Паниковский'

How to turn a 8-bit string into Unicode

message = '\xcf\xf0\xe8\xe2\xe5\xf2'

decoded = message.decode('cp1251')

repr(decoded)

>>> u'\u041f\u0440\u0438\u0432\u0435\u0442'

print decoded

Привет

message = '\x8f\xe0\xa8\xa2\xa5\xe2'

decoded = unicode(message, 'cp866')

>>> Привет

How to turn a Unicode into 8-bit string

udata = u'Сообщение'

udata.encode('cp1251')

>>> '\xd1\xee\xee\xe1\xf9\xe5\xed\xe8\xe5'

udata.encode('utf-8')

>>> '\xd0\xa1\xd0\xbe\xd0\xbe\xd0\xb1\xd1\x89\xd0\xb5\xd0\xbd\xd0\xb8'

Encode/decode chaining

u'Иван'.encode('cp866').decode('cp866')

>>> u'\u0418\u0432\u0430\u043d'

'\x88\xa2\xa0\xad'.decode('cp866').encode('utf-8')

>>> '\xd0\x98\xd0\xb2\xd0\xb0\xd0\xbd'

Encode/Decode errors

>>> u'Ivan'. encode('cp1251')

'Ivan'

>>> u'Иван'.encode('cp1251')

'\xc8\xe2\xe0\xed'

>>> u'任何字符串在中國'.decode('cp1251')

UnicodeEncodeError: 'ascii' codec can't encode characters in position 0-7: ordinal not in range(128)

encode('cp1251')

'Ivan'

>>> u'Иван'.encode('cp1251')

'\xc8\xe2\xe0\xed'

>>> u'任何字符串在中國'.decode('cp1251')

UnicodeEncodeError: 'ascii' codec can't encode characters in position 0-7: ordinal not in range(128)

The meaning of strings

- Unicode is a human string

- 8-bit string is just bytes

- Avoid printing bytes

- The result depends on locale, code page, etc

Don’t mix unicode and 8-bit strings!

u'Привет, ' + 'Ivan'

Привет, Ivan

u'Привет, ' + 'Иван'

>>> UnicodeDecodeError: 'ascii' codec can't decode byte 0xd0 in position 0: ordinal not in range(128)

name = '\xd0\x98\xd0\xb2\xd0\xb0\xd0\xbd'

u'Привет, ' + name.decode('utf-8')

>>> Привет, Иван

Methods are same

data = u'Юникод и Ко'

data.upper() # ЮНИКОД И КО

data.lower() # юникод и ко

data.split(u' ')

>>> [u'\u042e\u043d\u0438\u043a\u043e\u0434', u'\u0438', u'\u041a\u043e']

data. replace(u'Ко', u'Компания') # Юникод и Компания

replace(u'Ко', u'Компания') # Юникод и Компания

Остались вопросы? Задайте их в разделе «Обсуждение»

Вам ответят команда поддержки Хекслета или другие студенты.

Ошибки, сложный материал, вопросы >

Нашли опечатку или неточность?

Выделите текст, нажмите

ctrl + enter

и отправьте его нам. В течение нескольких дней мы исправим ошибку или улучшим формулировку.

Что-то не получается или материал кажется сложным?

Загляните в раздел «Обсуждение»:

- задайте вопрос. Вы быстрее справитесь с трудностями и прокачаете навык постановки правильных вопросов, что пригодится и в учёбе, и в работе программистом;

- расскажите о своих впечатлениях. Если курс слишком сложный, подробный отзыв поможет нам сделать его лучше;

- изучите вопросы других учеников и ответы на них. Это база знаний, которой можно и нужно пользоваться.

Об обучении на Хекслете

Исчерпывающее руководство по Юникоду и кодировке символов в Python

Работа с кодировкой символов на Python, да и на любом другом языке, временами выглядит довольно сложной. На Stack Overflow можно найти тысячи вопросов, посвящённых таким исключениям, как

На Stack Overflow можно найти тысячи вопросов, посвящённых таким исключениям, как UnicodeDecodeError и UnicodeEncodeError. Данное руководство призвано прояснить сложные аспекты работы с этими исключениями и продемонстрировать, что работа с текстовыми и двоичными данными на Python 3 может быть приятной. В Python хорошо реализована поддержка Юникода, однако для работы с кодировкой всё же потребуется приложить усилия.

Вводная часть статьи даст общее понимание работы с Юникодом, не привязанное к какому-то определённому языку, однако практические примеры будут приведены именно на Python, а их описание будет довольно лаконичным.

Изучив эту статью, вы:

- Освоите концепции кодировки символов и системы нумерации;

- Поймёте, как кодировка работает с объектами

strиbytes; - Узнаете, как в Python поддерживается система нумерации посредством различных форм литералов

int; - Познакомитесь со встроенными функциями языка, относящимися к кодировке и системе нумерации.

Система нумерации и кодировка символов настолько тесно связаны, что их придётся раскрыть в одном руководстве, в противном случае материал будет неполным.

Прим. Статья ориентирована на Python 3, а все примеры кода созданы с помощью оболочки CPython 3.7.2. Большая часть более ранних версий Python 3 также будут корректно обрабатывать код. Если вы всё ещё используете Python 2 и различия в обработке текста и бинарных данных между 2 и 3 версиями языка вас отпугивают, это руководство может помочь вам преодолеть барьер.

Что такое кодировка символов?

Существуют десятки, если не сотни, кодировок символов. Понять эту концепцию легче всего, разобрав одну из самых простых, ASCII.

Независимо от того, занимаетесь вы самообразованием или получили более формальное образование в сфере IT , наверняка пару раз вы уже видели таблицу ASCII. Эта таблица — хорошее начало для изучения принципов кодировки, так как она простая и маленькая (как вы увидите дальше, даже слишком маленькая).

Она охватывает следующее:

- Символы английского алфавита в нижнем регистре: от a до z;

- Символы английского алфавита в верхнем регистре: от A до Z;

- Некоторые знаки препинания и символы: например «$» или «!»;

- Символы, отображаемые как пустое место: пробел (« »), символ новой строки, возврата каретки, горизонтальной и вертикальной табуляции и несколько других;

- Некоторые непечатаемые символы: такие как бекспейс, «\b», которые просто невозможно отобразить, так, как к примеру, букву А.

Приведём формальное определение кодировки символов.

На самом высоком уровне — это способ перевода символов (таких как буквы, знаки пунктуации, служебные знаки, пробелы и контрольные символы) в целые числа и затем непосредственно в биты. Каждый символ может быть закодирован уникальным двоичным кодом. Если вы плохо знакомы с концепцией битов, не волнуйтесь, мы вскоре о ней поговорим.

Группы символов выделяют в отдельные категории. Каждому символу соответствует кодовая точка, которую можно рассматривать просто как целое число. В таблице ASCII символы сегментированы следующим образом:

В таблице ASCII символы сегментированы следующим образом:

| Диапазон кодовых точек | Класс |

|---|---|

| от 0 до 31 | Контрольные и неотображаемые символы |

| от 32 до 64 | Знаки пунктуации, символы, числа и пробел |

| от 65 до 90 | Буквы английского алфавита в верхнем регистре |

| от 91 до 96 | Дополнительные графемы, такие как [ и \ |

| от 97 до 122 | Буквы английского алфавита в нижнем регистре |

| от 123 до 126 | Дополнительные графемы, такие как { и | |

| 127 | Контрольный неотображаемый символ (DEL) |

Всего кодировка ASCII содержит 128 символов. В таблице ниже вы видите исчерпывающий набор знаков, которые позволяет отобразить эта кодировка. Если вы не видите какого-то символа, значит вы просто не сможете его вывести с помощью ASCII.

| Кодовая точка | Символ (имя) | Кодовая точка | Символ (имя) |

|---|---|---|---|

| 0 | NUL (Null) | 64 | @ |

| 1 | SOH (Start of Heading) | 65 | A |

| 2 | STX (Start of Text) | 66 | B |

| 3 | ETX (End of Text) | 67 | C |

| 4 | EOT (End of Transmission) | 68 | D |

| 5 | ENQ (Enquiry) | 69 | E |

| 6 | ACK (Acknowledgment) | 70 | F |

| 7 | BEL (Bell) | 71 | G |

| 8 | BS (Backspace) | 72 | H |

| 9 | HT (Horizontal Tab) | 73 | I |

| 10 | LF (Line Feed) | 74 | J |

| 11 | VT (Vertical Tab) | 75 | K |

| 12 | FF (Form Feed) | 76 | L |

| 13 | CR (Carriage Return) | 77 | M |

| 14 | SO (Shift Out) | 78 | N |

| 15 | SI (Shift In) | 79 | O |

| 16 | DLE (Data Link Escape) | 80 | P |

| 17 | DC1 (Device Control 1) | 81 | Q |

| 18 | DC2 (Device Control 2) | 82 | R |

| 19 | DC3 (Device Control 3) | 83 | S |

| 20 | DC4 (Device Control 4) | 84 | T |

| 21 | NAK (Negative Acknowledgment) | 85 | U |

| 22 | SYN (Synchronous Idle) | 86 | V |

| 23 | ETB (End of Transmission Block) | 87 | W |

| 24 | CAN (Cancel) | 88 | X |

| 25 | EM (End of Medium) | 89 | Y |

| 26 | SUB (Substitute) | 90 | Z |

| 27 | ESC (Escape) | 91 | [ |

| 28 | FS (File Separator) | 92 | \ |

| 29 | GS (Group Separator) | 93 | ] |

| 30 | RS (Record Separator) | 94 | ^ |

| 31 | US (Unit Separator) | 95 | _ |

| 32 | SP (Space) | 96 | ` |

| 33 | ! | 97 | a |

| 34 | " | 98 | b |

| 35 | # | 99 | c |

| 36 | $ | 100 | d |

| 37 | % | 101 | e |

| 38 | & | 102 | f |

| 39 | ' | 103 | g |

| 40 | ( | 104 | h |

| 41 | ) | 105 | i |

| 42 | * | 106 | j |

| 43 | + | 107 | k |

| 44 | , | 108 | l |

| 45 | - | 109 | m |

| 46 | . | 110 | n |

| 47 | / | 111 | o |

| 48 | 0 | 112 | p |

| 49 | 1 | 113 | q |

| 50 | 2 | 114 | r |

| 51 | 3 | 115 | s |

| 52 | 4 | 116 | t |

| 53 | 5 | 117 | u |

| 54 | 6 | 118 | v |

| 55 | 7 | 119 | w |

| 56 | 8 | 120 | x |

| 57 | 9 | 121 | y |

| 58 | : | 122 | z |

| 59 | ; | 123 | { |

| 60 | < | 124 | | |

| 61 | = | 125 | } |

| 62 | > | 126 | ~ |

| 63 | ? | 127 | DEL (delete) |

Модуль string

Модуль string — простой и удобный инструмент, разграничивающий содержащиеся в ASCII символы по группам, разделяя их в строки-константы. _`{|}~»»»

_`{|}~»»»

printable = digits + ascii_letters + punctuation + whitespace

Большинство этих констант исчерпывающе описаны их идентификаторами. Мы вкратце коснёмся констант hexdigits и octdigits.

Мы можем использовать определённые в модуле константы для рутинных операций:

>>> import string

>>> s = "What's wrong with ASCII?!?!?"

>>> s.rstrip(string.punctuation)

'What's wrong with ASCII'Прим. Обратите внимание, string.printable включает string.whitespace. Это несколько не соответствует тому, как печатаемые символы определяет метод str.isprintable(), который не рассматривает ни один из символов {'\v', '\n', '\r', '\f', '\t'} как печатаемый.

Это различие происходит из определения метода: str.isprintable() рассматривает что-либо печатаемым, если «все символы рассматриваются как печатаемые методом repr().

Что такое биты

Настало время вспомнить, что такое бит, базовая единица информации, которой оперируют вычислительные устройства.

Бит — это сигнал, который имеет два возможных состояния. Есть различные способы символического отображения этих состояний:

- 0 или 1;

- «да» или «нет»;

TrueилиFalse;- «включено» или «выключено».

Таблица ASCII из предыдущего раздела использует то, что обычно назвали бы числами (от 0 до 127), однако для наших целей важно понимать, что это десятичные числа (с основанием 10).

Каждое из этих десятичных чисел можно выразить последовательностью бит (числом с основанием 2). Вот таблица соотношения двоичных и десятичных чисел:

| Десятичное | Двоичное (кратко) | Двоичное (в байте) |

|---|---|---|

| 0 | 0 | 00000000 |

| 1 | 1 | 00000001 |

| 2 | 10 | 00000010 |

| 3 | 11 | 00000011 |

| 4 | 100 | 00000100 |

| 5 | 101 | 00000101 |

| 6 | 110 | 00000110 |

| 7 | 111 | 00000111 |

| 8 | 1000 | 00001000 |

| 9 | 1001 | 00001001 |

| 10 | 1010 | 00001010 |

Обратите внимание, что при увеличении десятичного числа n для его отображения (а следовательно и для отображения символа, относящегося к этому числу) требуется всё больше значимых бит.

Вот удобный метод представить строки ASCII как последовательность бит. Каждый символ из строки ASCII переводится в последовательность из 8 нолей и единиц с пробелами между этими последовательностями:

>>> def make_bitseq(s: str) -> str:

... if not s.isascii():

... raise ValueError("ASCII only allowed")

... return " ".join(f"{ord(i):08b}" for i in s)

>>> make_bitseq("bits")

'01100010 01101001 01110100 01110011'

>>> make_bitseq("CAPS")

'01000011 01000001 01010000 01010011'

>>> make_bitseq("$25.43")

'00100100 00110010 00110101 00101110 00110100 00110011'

>>> make_bitseq("~5")

'01111110 00110101'Прим. Обратите внимание, что метод .isascii() появился в Python 3.7.

Строковой литерал f-string f"{ord(i):08b}" использует мини-язык форматирования Format Specification Mini-Language, а именно его возможность замещения полей при форматировании строк.

- левая часть выражения,

ord(i), представляет объект, значение которого будет отформатировано и отображено при выводе.ord()возвращает кодовую точку одиночного символаstrв десятичном выражении; - Правая сторона выражения определяет форматирование объекта.

08означает ширина 8, заполнение нулями, аbработает как команда вывести число в двоичном (binary) эквиваленте.

На самом деле этот метод можно использовать разве что для развлечения. Он выдаст ошибку для любого символа, не представленного в ASCII-таблице. Позже мы рассмотрим, как эта проблема решается в других кодировках.

Нам нужно больше бит

Исходя из определения бита, можно вывести следующую закономерность: при определённом количестве бит n с их помощью можно выразить 2n разных значений.

def n_possible_values(nbits: int) -> int:

return 2 ** nbitsВот что это означает:

- 1 бит позволяет выразить 21 == 2 возможных значения;

- 8 бит позволяют выразить 28 == 256 возможных значений;

- 64 бита позволяют выразить 264 == 18 446 744 073 709 551 616 возможных значений.

В качестве естественного вывода из приведённой выше формулы мы можем установить следующее: для того, чтобы вычислить количество бит, необходимых для выражения определённого числа разных значений, нам нужно найти n в уравнении 2n=x, где переменная x известна.

Вот как можно это рассчитать:

>>> from math import ceil, log

>>> def n_bits_required(nvalues: int) -> int:

... return ceil(log(nvalues) / log(2))

>>> n_bits_required(256)

8Округление вверх в методе n_bits_required() требуется для расчёта значений, которые не являются чистой степенью двойки. К примеру, вам нужно сохранить набор из 110 различных символов. Для этого потребуется log(110) / log(2) == 6.781 бит, но поскольку бит для вычислительной техники является мельчайшей неделимой величиной, для отображения 110 различных значений нам понадобится 7 бит, при этом несколько значений останутся невостребованными.

>>> n_bits_required(110)

7Всё сказанное служит для обоснования одной идеи: ASCII, строго говоря, семибитная кодировка. Эта таблица содержит 128 кодовых точек, и, соответственно, символов, от 0 до 127 включительно. Это требует 7 бит:

>>> n_bits_required(128) # от 0 до 127

7

>>> n_possible_values(7)

128Проблема заключается в том, что современные компьютеры не используют для хранения чего-либо семибитные последовательности. Основной единицей хранения информации современных вычислительных устройств являются восьмибитные последовательности, байты.

Прим. В этой статье под байтом подразумевается группа из 8 бит, как повелось с 60-х годов прошлого века. Если вам не по душе это новомодное название, можете называть их октетами.

То, что ASCII-таблица использует 7 бит из доступных 8, означает, что память вычислительного устройства, занятого строками символов ASCII, наполовину пуста. Для того, чтобы лучше понять, почему это происходит, вернитесь к приведённой выше таблице соответствия двоичных и десятичных чисел. Вы можете выразить числа 0 и 1 с помощью 1 бита, или вы можете использовать 8 бит, чтобы выразить их как 00000000 и 00000001 соответственно.

Для того, чтобы лучше понять, почему это происходит, вернитесь к приведённой выше таблице соответствия двоичных и десятичных чисел. Вы можете выразить числа 0 и 1 с помощью 1 бита, или вы можете использовать 8 бит, чтобы выразить их как 00000000 и 00000001 соответственно.

Прим. перев. Если быть точным, то пустой остаётся только одна восьмая часть памяти. Однако с помощью именно этого незадействованного бита можно было бы создать вдвое больше кодовых точек.

Вы можете выразить числа от 0 до 3 всего двумя битами, от 00 до 11, или использовать 8 бит, чтобы выразить их как 00000000, 00000001, 00000010 и 00000011. Самая большая кодовая точка ASCII, 127, требует только 7 значимых бит.

С учётом этого взгляните, как метод make_bitseq() преобразует строки ASCII в строки, состоящие из байт, где каждый символ требует один байт:

>>> make_bitseq("bits")

'01100010 01101001 01110100 01110011'Неэффективное использование восьмибитной структуры памяти современных вычислительных устройств привело к появлению неструктурированного семейства конфликтующих кодировок, задействующих оставшуюся незанятой половину кодовых точек, доступных в одном байте.

Несмотря на попытку задействовать дополнительный бит, эти конфликтующие кодировки не могли отобразить все возможные символы, используемые человечеством в письменности.

Со временем появилась одна большая схема кодировки, которая объединила их. Однако, прежде чем мы до этого доберёмся, поговорим немного о краеугольных камнях схем кодировки символов — системах счисления.

Изучаем основы: другие системы счисления

В ASCII-таблице, как мы увидели, каждый символ соответствует числу от 0 до 127.

Этот диапазон чисел выражен в десятичной системе счисления. Именно эту систему используют для счёта люди, просто потому что на руках у нас по 10 пальцев.

Однако существуют и другие системы счисления, которые, в частности, широко используются в исходном коде CPython. Следует понимать, что действительное число не изменяется, а системы счисления просто по-разному его выражают.

Вопрос, какое число записано в строке "11" покажется странным, ведь для большинства очевидно, что это одиннадцать.

Однако в строке может быть представлено и другое число, в зависимости от системы счисления. Помимо десятичной, используются такие общепринятые альтернативы:

- Двоичная: с основой 2;

- Восьмеричная: с основой 8;

- Шестнадцатеричная (hex): с основой 16.

Что же мы подразумеваем, говоря что определённая система счисления имеет основу N?

Один из способов объяснения разных систем счисления заключается в том, чтобы представить, что у вас N пальцев.

Если же вам требуется более подробное объяснение систем счисления, обратитесь к книге Чарльза Петцольда «Код». В этой книге детально объясняются основы работы вычислительной техники.

Конструктор int() — один из способов показать, как разные системы счисления преобразуют одну и ту же строку с помощью Python. Если вы передадите str в int(), Python по умолчанию будет считать, что строка содержит число в десятичной системе. Однако вы можете дать другие указания:

Однако вы можете дать другие указания:

>>> int('11')

11

>>> int('11', base=10) # 10 установлено по умолчанию

11

>>> int('11', base=2) # Двоичная

3

>>> int('11', base=8) # Восьмеричная

9

>>> int('11', base=16) # Шестнадцатеричная

17Чаще в Python для обозначения того, что целое число представлено в системе счисления, отличной от десятичной, используют префиксы-литералы. Для каждой из трёх альтернативных систем существует свой литерал.

| Тип литерала | Префикс | Пример |

|---|---|---|

| Нет | Нет | 11 |

| Binary literal | 0b или 0B | 0b11 |

| Octal literal | 0o или 0O | 0o11 |

| Hex literal | 0x или 0X | 0x11 |

Всё это — разновидности целочисленных литералов. Результаты применения префиксов будут такими же, как и в случае использования

Результаты применения префиксов будут такими же, как и в случае использования int() с определением параметра base. Для Python всё это просто целые числа:

>>> 11

11

>>> 0b11 # Двоичный литерал

3

>>> 0o11 # Восьмеричный литерал

9

>>> 0x11 # Шестнадцатеричный литерал

17В таблице ниже отражено, как можно ввести десятичные числа от 0 до 20 в двоичном, восьмеричном и шестнадцатеричном эквиваленте. Любой из этих способов можно использовать как в оболочке интерпретатора Python, так и в исходном коде, и все эти числа будут рассматриваться как относящиеся к типу int.

| Десятичные | Двоичные | Восмеричные | Шестнадцатеричные |

|---|---|---|---|

0 | 0b0 | 0o0 | 0x0 |

1 | 0b1 | 0o1 | 0x1 |

2 | 0b10 | 0o2 | 0x2 |

3 | 0b11 | 0o3 | 0x3 |

4 | 0b100 | 0o4 | 0x4 |

5 | 0b101 | 0o5 | 0x5 |

6 | 0b110 | 0o6 | 0x6 |

7 | 0b111 | 0o7 | 0x7 |

8 | 0b1000 | 0o10 | 0x8 |

9 | 0b1001 | 0o11 | 0x9 |

10 | 0b1010 | 0o12 | 0xa |

11 | 0b1011 | 0o13 | 0xb |

12 | 0b1100 | 0o14 | 0xc |

13 | 0b1101 | 0o15 | 0xd |

14 | 0b1110 | 0o16 | 0xe |

15 | 0b1111 | 0o17 | 0xf |

16 | 0b10000 | 0o20 | 0x10 |

17 | 0b10001 | 0o21 | 0x11 |

18 | 0b10010 | 0o22 | 0x12 |

19 | 0b10011 | 0o23 | 0x13 |

20 | 0b10100 | 0o24 | 0x14 |

Кстати, вы можете сами убедиться, что подобные способы записи чисел очень часто используется в Стандартной Библиотеке Python. Найдите папку

Найдите папку lib/python3.7/ в своей системе, перейдите в неё и введите команду:

$ grep -nri --include "*\.py" -e "\b0x" lib/python3.7Команда сработает в любой Unix-системе с утилитой grep. С её помощью вы найдёте все шестнадцатеричные литералы. Для поиска двоичных используйте \b0b, а для восьмеричных — \b0o.

Для чего же нужны альтернативные литералы целых чисел? Если коротко, числа 2, 8 и 16, в отличие от 10, являются степенями двойки. Основанные на них системы счисления выражают численные значения способами, более удобными для обработки бинарными вычислительными устройствами. К примеру, 65536, или 216, в шестнадцатеричной системе просто 10000 или, используя литерал, 0x10000.

Введение в Юникод

Как видите, проблема ASCII в том, что этой таблицы недостаточно для отображения знаков, символов и глифов, использующихся во всех языках и диалектах мира. Её недостаточно даже для английского языка.

Юникод служит тем же целям, что и ASCII, но содержит намного больший набор кодовых точек. В период времени между появлением ASCII и принятием Юникода использовалось ещё несколько различных кодировок, но рассматривать их подробно нет смысла, так как Юникод и одна из его схем, UTF-8, в настоящее время стали использоваться практически повсеместно.

Вы можете представить Юникод как расширенную версию ASCII-таблицы — с 1 114 112 возможными кодовыми точками, от 0 до 1 114 111. Это 17*(216) или 0x10ffff в шестнадцатеричном представлении. Фактически, ASCII является частью Юникода, так как первые 128 символов этих кодировок полностью совпадают.

Чтобы соблюсти технические детали, сам по себе Юникод не является кодировкой. Он скорее реализуется в различных кодировках символов, как вы вскоре увидите. По структуре Юникод скорее ассоциативный массив (что-то вроде dict) или база данных, состоящая из таблицы с двумя колонками. В этой таблице разные символы (такие как "a", "¢", или даже "ቈ") соотносятся с различными целыми положительными числами. Кодировка же должна предоставлять несколько больше возможностей.

Кодировка же должна предоставлять несколько больше возможностей.

Юникод содержит практически любой символ, который только можно представить, включая дополнительные непечатаемые. Например, кодовая точка 8207 соответствует отметке RTL, которая используется для смены направления письма. Она полезна в текстах, где абзацы на одном из европейских языков соседствуют с абзацами на арабских языках.

Прим. Кстати, если уж мы хотим быть совсем точны в деталях, то надо отметить ещё один факт. Исторически сложилось, что в Юникоде доступны только 1 111 998 кодовых точек.

Юникод и UTF-8

Довольно скоро стало понятно, что все необходимые символы невозможно вместить в таблицу, используя только один байт. Современные, более ёмкие кодировки требовали использования больших объёмов.

Ранее мы упоминали, что Юникод сам по себе не является кодировкой. И вот почему.

Юникод не содержит указаний по извлечению из текста бит, он работает только с кодовыми точками. В нём нет стандарта конверсии текста в двоичные данные и обратно.

Юникод является абстрактным стандартом кодировки. Для практического его применения чаще всего используют схему UTF-8. Стандарт Юникод (таблица соответствий символов кодовыми точкам) определяет несколько различных кодировок на основе единого набора символов.

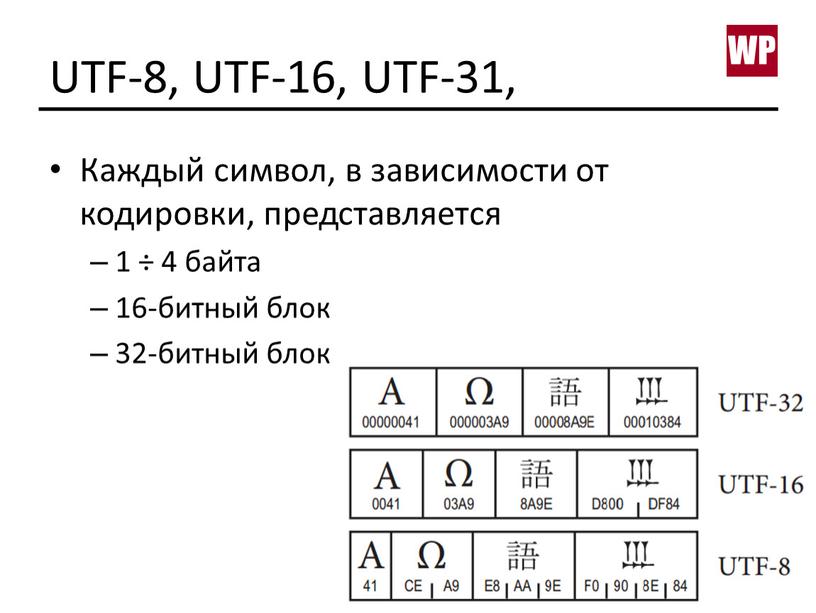

Как и менее распространённые UTF-16 и UTF-32, UTF-8 — формат кодировки для отображения символов Юникода в двоичном виде, используя один или несколько байт на один символ. UTF-16 и UTF-32 мы обсудим чуть позже, но пока нам интересен UTF-8 как самый популярный формат.

Сначала требуется разобрать термины «кодирование» и «декодирование».

Кодирование и декодирование в Python 3

Тип данных str в Python 3 рассчитан на представление текста в удобном для чтения формате и может содержать любые символы Юникода.

Тип bytes, напротив, представляет двоичные данные, последовательность байт, без указания на кодировку.

Кодирование и декодирование — это процесс перехода данных из одной формы в другую.

В методах .encode() и .decode() по умолчанию используется параметр "utf-8", однако для большей уверенности этот параметр можно определить самостоятельно:

>>> "résumé".encode("utf-8")

b'r\xc3\xa9sum\xc3\xa9'

>>> "El Niño".encode("utf-8")

b'El Ni\xc3\xb1o'

>>> b"r\xc3\xa9sum\xc3\xa9".decode("utf-8")

'résumé'

>>> b"El Ni\xc3\xb1o".decode("utf-8")

'El Niño'str.encode() возвращает объект типа bytes. И литералы этого типа объектов (такие как b"r\xc3\xa9sum\xc3\xa9"), и его отображение допускают только символы ASCII.

Вот почему при вызове "El Niño".encode("utf-8"), ASCII-совместимое "El" отображается как есть, а n с тильдой экранируется в "\xc3\xb1". Этой с виду неудобочитаемой последовательностью представлены два байта, 0xc3 и 0xb1 в шестнадцатеричной системе:

>>> " ".join(f"{i:08b}" for i in (0xc3, 0xb1))

'11000011 10110001'Таким образом символ ñ требует два байта для бинарного представления с помощью UTF-8.

Прим. Если вы введёте help(str.encode), скорее всего, увидите параметр по умолчанию encoding='utf-8'. Однако имейте в виду, что настройки Windows для Python 3.6 могут отличаться, поэтому использовать методы кодирования и декодирования без указания необходимой кодировки (например "résumé".encode()) следует с осторожностью.

Python 3: всё на Юникоде

Python 3 полностью реализован на Юникоде, а точнее на UTF-8. Вот что это означает:

- По умолчанию предполагается, что исходный код Python 3 написан с помощью UTF-8. Это значит, что вам не нужно использовать определение

# -*- coding: UTF-8 -*-в начале файлов.pyв этой версии языка. - Все тексты (объекты формата

str) реализованы на Юникоде. Кодированный текст представлен двоичными данными (bytes). Типstrможет содержать любой символ-литерал из Юникода (например"Δv / Δt"), и все они хранятся в Юникоде. - Любой из символов Юникода приемлем в качестве идентификатора. Например, вы можете использовать выражение

résumé = "~/Documents/resume.pdf". - В модуле

reпо умолчанию установлен флагre.UNICODE, а неre.ASCII. Это означает, чтоr"\w"соответствует буквам из Юникода, а не просто символам ASCII. - По умолчанию

encodingвstr.encode()вbytes.decode()установлен в UTF-8.

Нужно отметить также нюанс, касающийся встроенного метода open(). Его параметр encoding зависит от платформы и определяется значением locale.getpreferredencoding():

>>> # Mac OS X High Sierra

>>> import locale

>>> locale.getpreferredencoding()

'UTF-8'

>>> # Windows Server 2012; другие сборки Windows могут использовать UTF-16

>>> import locale

>>> locale.getpreferredencoding()

'cp1252'Мы делаем упор на эти моменты, чтобы вы вдруг не подумали, что кодировка UTF-8 является универсальной. Она действительно широко распространена, но вы вполне можете столкнуться и с другими вариантами. Не будет лишним предусмотреть это в коде.

Один байт, два байта, три байта, четыре…

Одна из важнейших особенностей UTF-8 состоит в том, что это кодировка с переменным размером.

Вспомните раздел, посвящённый ASCII. Любой символ в этой таблице требует максимум одного байта пространства. Это можно быстро проверить с помощью следующего генератора:

>>> all(len(chr(i).encode("ascii")) == 1 for i in range(128))

TrueС UTF-8 дела обстоят по-другому. Символы Юникода могут занимать от одного до четырёх байт. Вот пример четырёхбайтного символа:

>>> ibrow = "🤨"

>>> len(ibrow)

1

>>> ibrow.encode("utf-8")

b'\xf0\x9f\xa4\xa8'

>>> len(ibrow.encode("utf-8"))

4

>>> # Вызов list() с объектом типа bytes возвращает

>>> # значение каждого байта

>>> list(b'\xf0\x9f\xa4\xa8')

[240, 159, 164, 168]Это небольшая, но важная особенность метода len():

- Размер единичного символа Юникода в объекте

strязыка Python всегда будет равен 1, вне зависимости от количества занимаемых байт. - Длина того же символа в объекте типа

bytesбудет варьироваться от 1 до 4.

Таблица ниже показывает, сколько байт занимают основные типы символов.

| Десятичный диапазон | Шестнадцатеричный диапазон | Включённые символы | Примеры |

|---|---|---|---|

| от 0 до 127 | от "\u0000" до "\u007F" | U.S. ASCII | "A", "\n", "7", "&" |

| от 128 до 2047 | от "\u0080" до "\u07FF" | Большая часть латинских алфавитов* | "ę", "±", "ƌ", "ñ" |

| от 2048 до 65535 | от "\u0800" до "\uFFFF" | Дополнительные части многоязыковых символов (BMP)** | "ത", "ᄇ", "ᮈ", "‰" |

| от 65536 до 1114111 | от "\U00010000" до "\U0010FFFF" | Другое*** | "𝕂", "𐀀", "😓", "🂲", |

*Такие как английский, арабский, греческий, ирландский.

**Масса языков и символов, в основном китайский, японский и корейский с разделением по томам (а также ASCII и латиница).

***Дополнительные символы китайского, японского, корейского и вьетнамского, а также другие символы и эмоджи.

Прим. У UTF-8 есть и другие технические особенности. Те, кто работает на Python, редко с ними сталкиваются, поэтому мы не будем раскрывать их в этой статье, но упомянем вкратце, чтобы сохранить полноту картины. Так, UTF-8 использует коды-префиксы, указывающие на количество байт в последовательности. Такой приём позволяет декодеру группировать байты в условиях кодировки с переменным размером. Количество байт в последовательности определяется первым её байтом. Другие технические подробности можно найти на странице Википедии, посвящённой UTF-8 или на официальном сайте.

Особенности UTF-16 и UTF-32

Рассмотрим альтернативные кодировки, UTF-16 и UTF-32. Различие между ними и UTF-8 в основном практическое. Продемонстрируем величину расхождения с помощью перевода туда и обратно:

>>> letters = "αβγδ"

>>> rawdata = letters.encode("utf-8")

>>> rawdata.decode("utf-8")

'αβγδ'

>>> rawdata.decode("utf-16") # 😧

'뇎닎돎듎'В данном случае, когда мы кодируем четыре буквы греческого алфавита в двоичные данные с помощью UTF-8, а декодируем обратно в текст с использованием UTF-16, на выходе получается строка с совершенно другими символами (из корейского алфавита).

Так происходит, если для кодирования и декодирования применяют разные кодировки. Два варианта декодирования одного бинарного объекта могут вернуть текст даже на другом языке.

Таблица ниже демонстрирует количество байт, используемых в разных кодировках:

| Кодировка | Байт на символ (включительно) | Варьируемая длина |

|---|---|---|

| UTF-8 | От 1 до 4 | Да |

| UTF-16 | От 2 до 4 | Да |

| UTF-32 | 4 | Нет |

Любопытный аспект семейства UTF: UTF-8 не всегда занимает меньше памяти, чем UTF-16. Хотя с точки зрения математики это выглядит маловероятным, однако это возможно:

>>> text = "記者 鄭啟源 羅智堅"

>>> len(text.encode("utf-8"))

26

>>> len(text.encode("utf-16"))

22Так получается из-за того, что кодовые точки в диапазоне от U+0800 до U+FFFF (от 2048 до 65535 в десятичной системе) в кодировке UTF-8 занимают три байта, а в UTF-16 только два.

Это не означает, что нужно работать с UTF-16, независимо от того, насколько часто вы работаете с символами в этом диапазоне. Один из самых важных поводов придерживаться UTF-8 — в мире кодировок лучше держаться вместе с большинством.

Кроме того, в 2019 году компьютерная память стоит дёшево, и экономия четырёх байт за счёт использования нестандартной кодировки вряд ли стоит усилий.

Прим. перев. Есть и более весомые причины использовать UTF-8. Среди них её обратная совместимость с ASCII, а также то, что это самосинхронизирующаяся кодировка.

Python и встроенные функции

Вы освоили самую сложную часть статьи. Теперь посмотрим, как всё изученное реализуется на Python.

В Python есть несколько встроенных функций, каким-либо образом относящихся к системам счисления и кодировке:

Логически их можно сгруппировать по назначению.

ascii(),bin(),hex()иoct()предназначены для различного представления вводных данных. Все они возвращаютstr. Первая,ascii(), производит представление объекта в ASCII, экранируя не входящие в эту таблицу символы. Оставшиеся три дают соответственно двоичное, шестнадцатеричное и восьмеричное представление целого числа. Все эти функции меняют только представление объекта, не изменяя непосредственно вводные данные.bytes(),str()иint()— конструкторы классов соответствующих типов:bytes,str, иint. Все они предлагают способы подогнать данные под желаемый тип.ord()иchr()выполняют противоположные действия.ord()конвертирует символ в десятичную кодовую точку, аchr()принимает в качестве аргумента целое число, и возвращает символ, кодовой точкой которого это число является.

В таблице ниже эти функции разобраны более подробно:

| Функция | Форма | Тип аргументов | Тип возвращаемых данных | Назначение |

|---|---|---|---|---|

ascii() | ascii(obj) | Различный | str | Представление объекта символами ASCII. Не входящие в таблицу символы экранируются |

bin() | bin(number) | number: int | str | Бинарное представление целого чиста с префиксом "0b" |

bytes() | bytes(последовательность_целых_чисел)

| Различный | bytes | Приводит аргумент к двоичным данным, типу bytes |

chr() | chr(i) | i: int

| str | Преобразует кодовую точку (целочисленное значение) в символ Юникода |

hex() | hex(number) | number: int | str | Шестнадцатеричное представление целого числа с префиксом "0x" |

int() | int([x])

| Различный | int | Приводит аргумент к типу int |

oct() | oct(number) | number: int | str | Восьмеричное представление целого числа с префиксом "0o" |

ord() | ord(c) | c: str

| int | Возвращает значение кодовой точки символа Юникода |

str() | str(object=’‘)

| Различный | str | Приводит аргумент к текстовому представлению, типу str |

Дальше можно посмотреть полезные примеры использования этих функций.

ascii():

>>> ascii("abcdefg")

"'abcdefg'"

>>> ascii("jalepeño")

"'jalepe\\xf1o'"

>>> ascii((1, 2, 3))

'(1, 2, 3)'

>>> ascii(0xc0ffee) # Шестнадцатеричный литерал (int)

'12648430'bin():

>>> bin(0)

'0b0'

>>> bin(400)

'0b110010000'

>>> bin(0xc0ffee) # Шестнадцатеричный литерал (int)

'0b110000001111111111101110'

>>> [bin(i) for i in [1, 2, 4, 8, 16]] # `int` + обработка списка

['0b1', '0b10', '0b100', '0b1000', '0b10000']bytes():

>>> # Последовательность целых чисел

>>> bytes((104, 101, 108, 108, 111, 32, 119, 111, 114, 108, 100))

b'hello world'

>>> bytes(range(97, 123)) # Последовательность целых чисел

b'abcdefghijklmnopqrstuvwxyz'

>>> bytes("real 🐍", "utf-8") # Строка + кодировка

b'real \xf0\x9f\x90\x8d'

>>> bytes(10)

b'\x00\x00\x00\x00\x00\x00\x00\x00\x00\x00'

>>> bytes.fromhex('c0 ff ee')

b'\xc0\xff\xee'

>>> bytes.fromhex("72 65 61 6c 70 79 74 68 6f 6e")

b'realpython'chr():

>>> chr(97)

'a'

>>> chr(7048)

'ᮈ'

>>> chr(1114111)

'\U0010ffff'

>>> chr(0x10FFFF) # Шестнадцатеричный литерал (int)

'\U0010ffff'

>>> chr(0b01100100) # Двоичный литерал (int)

'd'hex():

>>> hex(100)

'0x64'

>>> [hex(i) for i in [1, 2, 4, 8, 16]]

['0x1', '0x2', '0x4', '0x8', '0x10']

>>> [hex(i) for i in range(16)]

['0x0', '0x1', '0x2', '0x3', '0x4', '0x5', '0x6', '0x7',

'0x8', '0x9', '0xa', '0xb', '0xc', '0xd', '0xe', '0xf']int():

>>> int(11.0)

11

>>> int('11')

11

>>> int('11', base=2)

3

>>> int('11', base=8)

9

>>> int('11', base=16)

17

>>> int(0xc0ffee - 1.0)

12648429

>>> int.from_bytes(b"\x0f", "little")

15

>>> int.from_bytes(b'\xc0\xff\xee', "big")

12648430oct():

>>> ord("a")

97

>>> ord("ę")

281

>>> ord("ᮈ")

7048

>>> [ord(i) for i in "hello world"]

[104, 101, 108, 108, 111, 32, 119, 111, 114, 108, 100]str():

>>> str("str of string")

'str of string'

>>> str(5)

'5'

>>> str([1, 2, 3, 4]) # Like [1, 2, 3, 4].__str__(), but use str()

'[1, 2, 3, 4]'

>>> str(b"\xc2\xbc cup of flour", "utf-8")

'¼ cup of flour'

>>> str(0xc0ffee)

'12648430'Литералы для строк на Python

Вместо использования конструктора str(), объект этого типа чаще вводят напрямую:

>>> meal = "shrimp and grits"Выглядит достаточно просто. Но есть один аспект, о котором нужно помнить. Поскольку Python позволяет использовать все возможности Юникода, можно «напечатать» символы, которых вы никогда не найдёте на клавиатуре. Можно скопировать и вставить их прямо в оболочку интерпретатора:

>>> alphabet = 'αβγδεζηθικλμνξοπρςστυφχψ'

>>> print(alphabet)

αβγδεζηθικλμνξοπρςστυφχψКроме ввода через консоль реальных, неэкранированых символов Юникода, существуют и другие способы ввода текстовых строк.

Самые насыщенные разделы документации Python посвящены лексическому анализу. В частности, раздел о строках и литералах. Возможно, для понимания данного аспекта языка этот раздел придётся неоднократно перечитать.

Кроме прочего, там говорится о шести возможных способах ввода одного символа Юникода.

Первый, и самый распространённый метод, как вы уже видели — прямой ввод. Проблема состоит в поиске необходимых сочетаний клавиш. Здесь и могут пригодиться другие способы получения и представления символов. Вот полный список:

| Экранирующая последовательность | Значение | Как отобразить "a" |

|---|---|---|

"\ooo" | Символ с восьмеричным значением ooo | "\141" |

"\xhh" | Символ с шестнадцатеричным значением hh | "\x61" |

"\N{name}" | Символ с именем name в базе данных Юникода | "\N{LATIN SMALL LETTER A}" |

"\uxxxx" | Символ с шестнадцатибитным (двухбайтным) шестнадцатеричным значением xxxx | "\u0061" |

"\Uxxxxxxxx" | Символ с тридцатидвухбитным (четырёхбайтным) шестнадцатеричным значением xxxxxxxx | "\U00000061" |

Это соответствие можно проверить на практике:

>>> (

... "a" ==

... "\x61" ==

... "\N{LATIN SMALL LETTER A}" ==

... "\u0061" ==

... "\U00000061"

... )

TrueНужно однако упомянуть и два основных затруднения при использовании этих методов:

- Не каждый способ работает со всеми символами. Шестнадцатеричное представление числа 300 выглядит как

0x012c, а это значение просто не поместится в экранирующий код"\xhh", так как в нём допускаются всего две цифры. Самая большая кодовая точка, которую можно втиснуть в этот формат —"\xff"("ÿ"). Аналогичо"\ooo"можно использовать только до"\777"("ǿ"). - Для

\xhh,\uxxxx, и\Uxxxxxxxxтребуется вводить ровно столько цифр, сколько указано в примерах. Это может стать неприятным сюрпризом, поскольку обычно основанные на Юникоде таблицы содержат кодовые точки для символов с префиксомU+и варьирующимся количеством шестнадцатеричных символов. В этих таблицах кодовые точки отображают только значимые цифры.

Например, если вы обратитесь к сайту unicode-table.com с целью получить данные готического символа faihu (или fehu), "𐍆", его кодовая точка будет U+10346.

Как же можно разместить его в "\uxxxx" или "\Uxxxxxxxx"? В "\uxxxx" эту кодовую точку вместить невозможно, поскольку она соответствует четырёхбайтному символу. А чтобы представить его в "\Uxxxxxxxx", придётся выровнять последовательность с левой стороны:

>>> "\U00010346"

'𐍆'Это также значит, что экранирующая последовательность "\Uxxxxxxxx" — единственная последовательность, способная вместить любой символ Юникода.

Прим. Вот код небольшой, но удобной функции, переводящей записи типа "U+10346" в приемлемый для Python формат с помощью str.zfill():

>>> def make_uchr(code: str):

... return chr(int(code.lstrip("U+").zfill(8), 16))

>>> make_uchr("U+10346")

'𐍆'

>>> make_uchr("U+0026")

'&'Другие поддерживаемые Python кодировки

Пока что мы рассказали про 4 разные кодировки символов:

- ASCII;

- UTF-8;

- UTF-16;

- UTF-32.

Однако существует большое количество и других вариантов кодировки.

Один из примеров — Latin-1 (другое название ISO-8859-1). Это базовая кодировка для Hypertext Transfer Protocol (HTTP) в спецификации RFC 2616. Для Windows существует собственный вариант Latin-1, который называется cp1252.

Прим. Кодировка ISO-8859-1 всё ещё широко используется. Библиотека requests неукоснительно придерживается спецификации RFC 2616, используя её по умолчанию для содержимого отзывов HTTP/HTTPS. Если в заголовке Content-Type находится слово «text» и не выбрана другая кодировка, requests использует ISO-8859-1.

Полный список допустимых кодировок можно найти в документации модуля codecs, входящего в набор стандартных библиотек Python.

Среди этих кодировок стоит упомянуть ещё одну, зачастую весьма полезную. Это "unicode-escape". Если вы декодировали str и хотите быстро получить представление содержащихся в ней экранированных литералов Юникода, можно определить эту кодировку в .encode:

>>> alef = chr(1575) # Или "\u0627"

>>> alef_hamza = chr(1571) # Или "\u0623"

>>> alef, alef_hamza

('ا', 'أ')

>>> alef.encode("unicode-escape")

b'\\u0627'

>>> alef_hamza.encode("unicode-escape")

b'\\u0623'Вы знаете, что говорят насчёт предположений…

Хотя Python по умолчанию предполагает, что файлы и код созданы на основе кодировки UTF-8, вам, как программисту, не следует делать аналогичное предположение относительно сторонних данных.

Когда вы получаете данные в двоичном коде из внешних источников, из файла или по сетевому соединению, стоит проверить, указана ли кодировка. Если нет — вы можете уточнить.

Все операции ввода-вывода осуществляют в байтах, наборе нулей и единиц, пока вы не сообщите системе кодировку для преобразования этих данных в текст.

Приведём пример того, что может пойти не так. Допустим, вы подписаны на API, который передаёт вам рецепт блюда дня. Вы получаете его в формате bytes и раньше всегда без проблем декодировали с использованием .decode("utf-8") . Но именно в этот день часть рецепта выглядела так:

>>> data = b"\xbc cup of flour"Похоже, нам потребуется мука, но сколько?

>>> data.decode("utf-8")

Traceback (most recent call last):

File "", line 1, in

UnicodeDecodeError: 'utf-8' codec can't decode byte 0xbc in position 0: invalid start byteА вот и та самая неприятная ошибка UnicodeDecodeError. Подобное вполне может произойти, когда вы делаете предположение об используемой кодировке. Уточняем у разработчика ресурса, предоставляющего API. Выясняется, что полученный вами файл был закодирован с помощью Latin-1:

>>> data.decode("latin-1")

'¼ cup of flour'Именно в этом и крылась проблема. В Latin-1 каждый символ кодируется одним байтом, в вот в UTF-8 символ «¼» требует два байта ("\xc2\xbc").

Как видите, делать предположения относительно кодировки полученных данных довольно рискованно. Обычно это UTF-8, однако в тех случаях, когда это не так, у вас могут возникнуть проблемы.

Если уж у вас нет другого выхода и кодировку приходится угадывать, обратите внимание на библиотеку chardet. В ней используются разработанные в Mozilla методы, позволяющие сделать обоснованное предположение насчёт кодировки данных. Однако учтите, что такие инструменты должны быть вашим последним средством, не стоит прибегать к ним, если есть возможность решить вопрос другим способом.

Всякая всячина: unicodedata

Нельзя не упомянуть также модуль unicodedata. Он позволяет взаимодействовать с базой данных символов Юникода (Unicode Character Database, UCD).

>>> import unicodedata

>>> unicodedata.name("€")

'EURO SIGN'

>>> unicodedata.lookup("EURO SIGN")

'€'Подводим итоги

Итак, в этой статье вы познакомились со следующими концепциями кодировки символов в Python:

- Фундаментальные принципы кодировки символов и систем счисления;

- Целочисленные, двоичные, восьмеричные, шестнадцатеричные, строковые и байтовые литералы в Python;

- Встроенные функции языка, работающие с кодировкой и системами счисления;

- Особенности обработки текстовых и двоичных данных.

Дополнительные источники

Ещё больше информации можно получить из следующих материалов (на английском языке):

- UTF-8 Everywhere Manifesto.

- Joel Spolsky: Минимальный уровень знаний о Юникоде и наборах символов, требующийся каждому разработчику ПО (Без отговорок!).

- David Zentgraf: Что обязательно должен знать о кодировках и наборах символов каждый программист для работы с текстом.

- Mozilla: Комплексный подход к определению языков и кодировок.

- Wikipedia.

- John Skeet: Юникод и .NET.

- Network Working Group, RFC 3629: UTF-8, формат преобразования ISO 10646.

- Unicode Technical Standard #18: Регулярные выражения Юникода.

В документации языка нашему вопросу посвящены два раздела:

Перевод статьи Unicode & Character Encodings in Python: A Painless Guide

Что такое кодировка UTF-8? Руководство для непрограммистов

Текст: его важность в Интернете само собой разумеется. Это первая буква «Т» в «HTTP», единственная буква «Т» в «HTML», и практически каждый веб-сайт так или иначе использует ее, будь то URL-адрес, часть маркетингового текста, обзор продукта, вирусный твит или Сообщение блога. (Привет!)

Но веб-текст на самом деле может быть не таким простым, как вы думаете. Рассмотрим тысячи языков, на которых сегодня говорят, или все знаки препинания и символы, которые мы можем добавить, чтобы улучшить их, или тот факт, что создаются новые смайлики, чтобы уловить каждую человеческую эмоцию.Как веб-сайты все это хранят и обрабатывают?

По правде говоря, даже такая простая вещь, как текст, требует хорошо скоординированной, четко определенной системы для отображения в веб-браузерах. В этом посте я расскажу об основах одной технологии, имеющей ключевое значение для текста в Интернете, UTF-8 . Мы изучим основы хранения и кодирования текста и обсудим, как это помогает разместить на вашем сайте привлекательные слова.

Прежде чем мы начнем, вы должны быть знакомы с основами HTML и готовы погрузиться в легкую информатику.

Что такое UTF-8?

UTF-8 означает «Формат преобразования Unicode — 8 бит». Пока это нам не помогает, так что давайте вернемся к основам.

Двоичный: как компьютеры хранят информацию

Для хранения информации компьютеры используют двоичную систему. В двоичном формате все данные представлены последовательностями из единиц и нулей. Самая основная единица двоичного кода — это бит , который представляет собой всего лишь единицу 1 или 0. Следующая по величине единица двоичного кода, байт, состоит из 8 бит.Пример байта — «01101011».

Каждый цифровой актив, с которым вы когда-либо сталкивались — от программного обеспечения до мобильных приложений, от веб-сайтов до историй в Instagram — построен на этой системе байтов, которые связаны друг с другом таким образом, чтобы они имели смысл для компьютеров. Когда мы говорим о размерах файлов, мы имеем в виду количество байтов. Например, килобайт — это примерно тысяча байт, а гигабайт — примерно миллиард байтов.

Текст — один из многих ресурсов, которые хранятся и обрабатываются компьютерами.Текст состоит из отдельных символов, каждый из которых представлен в компьютерах строкой битов. Эти строки собираются в цифровые слова, предложения, абзацы, любовные романы и т. Д.

ASCII: преобразование символов в двоичные

Американский стандартный код обмена информацией (ASCII) был ранней стандартизированной системой кодирования текста. Кодирование — это процесс преобразования символов человеческих языков в двоичные последовательности, которые могут обрабатывать компьютеры.

Библиотека

ASCII включает все прописные и строчные буквы латинского алфавита (A, B, C…), каждую цифру от 0 до 9 и некоторые общие символы (например, /,! И?). Он присваивает каждому из этих символов уникальный трехзначный код и уникальный байт.

В таблице ниже показаны примеры символов ASCII с соответствующими кодами и байтами.

| Знак | Код ASCII | БАЙТ |

| А | 065 | 01000001 |

| a | 097 | 01100001 |

| B | 066 | 01000010 |

| б | 098 | 01100010 |

| Z | 090 | 01011010 |

| z | 122 | 01111010 |

| 0 | 048 | 00110000 |

| 9 | 057 | 00111001 |

| ! | 033 | 00100001 |

| ? | 063 | 00111111 |

Подобно тому, как символы объединяются для образования слов и предложений на языке, двоичный код делает это в текстовых файлах.Итак, фраза «Быстрая коричневая лисица перепрыгивает через ленивого пса». в двоичном формате ASCII будет:

01010100 01101000 01100101 00100000 01110001

01110101 01101001 01100011 01101011 00100000

01100010 01110010 01101111 01110111 01101110

00100000 01100110 01101111 01111000 00100000

01101010 01110101 01101101 01110000 01110011

00100000 01101111 01110110 01100101 01110010

00100000 01110100 01101000 01100101 00100000

01101100 01100001 01111010 01111001 00100000

01100100 01101111 01100111 00101110

Это мало что значит для нас, людей, но это хлеб с маслом для компьютера.

Число символов, которые может представлять ASCII, ограничено числом доступных уникальных байтов, поскольку каждый символ получает один байт. Если вы посчитаете, то обнаружите, что существует 256 различных способов сгруппировать восемь единиц и нулей вместе. Это дает нам 256 различных байтов или 256 способов представления символа в ASCII. Когда в 1960 году был представлен ASCII, это было нормально, поскольку разработчикам требовалось всего 128 байт для представления всех необходимых им английских символов и символов.

Но по мере глобального распространения компьютерных технологий компьютерные системы начали хранить текст не только на английском, но и на других языках, многие из которых использовали символы, отличные от ASCII.Были созданы новые системы для сопоставления других языков с одним и тем же набором из 256 уникальных байтов, но использование нескольких систем кодирования было неэффективным и запутанным. Разработчикам требовался лучший способ кодирования всех возможных символов с помощью одной системы.

Unicode: способ сохранить каждый символ, когда-либо

Введите Unicode, систему кодирования, которая решает проблему пространства ASCII. Как и ASCII, Unicode назначает уникальный код, называемый кодовой точкой , каждому символу. Однако более сложная система Unicode может генерировать более миллиона кодовых точек, чего более чем достаточно, чтобы учесть каждый символ на любом языке.

Unicode теперь является универсальным стандартом для кодирования всех человеческих языков. И да, он даже включает смайлики.

Ниже приведены несколько примеров текстовых символов и соответствующих им кодовых точек. Каждая кодовая точка начинается с буквы «U» для «Unicode», за которой следует уникальная строка символов для представления символа.

| Знак | Кодовая точка |

| А | U + 0041 |

| a | U + 0061 |

| 0 | U + 0030 |

| 9 | U + 0039 |

| ! | U + 0021 |

| Ø | U + 00D8 |

| ڃ | U + 0683 |

| ಚ | U + 0C9A |

| 𠜎 | U + 2070E |

| 😁 | U + 1F601 |

Если вы хотите узнать, как генерируются кодовые точки и что они означают в Unicode, ознакомьтесь с этим подробным объяснением.

Итак, теперь у нас есть стандартизированный способ представления каждого символа, используемого каждым человеческим языком, в одной библиотеке. Это решает проблему нескольких систем маркировки для разных языков — любой компьютер на Земле может использовать Unicode.

Но только Unicode не хранит слова в двоичном формате. Компьютерам нужен способ перевода Unicode в двоичный код, чтобы его символы можно было хранить в текстовых файлах. Вот где пригодится UTF-8.

UTF-8: последний фрагмент головоломки

UTF-8 — это система кодирования Unicode.Он может преобразовать любой символ Юникода в соответствующую уникальную двоичную строку, а также может преобразовать двоичную строку обратно в символ Юникода. Это значение «UTF» или «Формат преобразования Unicode».

Существуют и другие системы кодирования Unicode, помимо UTF-8, но UTF-8 уникален, поскольку представляет символы в однобайтовых единицах. Помните, что один байт состоит из восьми бит, отсюда и «-8» в его названии.

Более конкретно, UTF-8 преобразует кодовую точку (которая представляет один символ в Unicode) в набор от одного до четырех байтов.Первые 256 символов в библиотеке Unicode, которые включают символы, которые мы видели в ASCII, представлены как один байт. Символы, которые появляются позже в библиотеке Unicode, кодируются как двухбайтовые, трехбайтовые и, возможно, четырехбайтовые двоичные единицы.

Ниже приведена та же таблица символов сверху, с выводом UTF-8 для каждого добавленного символа. Обратите внимание, что некоторые символы представлены одним байтом, а другие используют больше.

| Знак | Кодовая точка | Двоичная кодировка UTF-8 |

| А | U + 0041 | 01000001 |

| a | U + 0061 | 01100001 |

| 0 | U + 0030 | 00110000 |

| 9 | U + 0039 | 00111001 |

| ! | U + 0021 | 00100001 |

| Ø | U + 00D8 | 11000011 10011000 |

| ڃ | U + 0683 | 11011010 10000011 |

| ಚ | U + 0C9A | 11100000 10110010 10011010 |

| 𠜎 | U + 2070E | 11110000 10100000 10011100 10001110 |

| 😁 | U + 1F601 | 11110000 10011111 10011000 10000001 |

Почему UTF-8 преобразовывает одни символы в один байт, а другие — в четыре байта? Короче для экономии памяти.Используя меньше места для представления более общих символов (например, символов ASCII), UTF-8 уменьшает размер файла, позволяя использовать гораздо большее количество менее распространенных символов. Эти менее распространенные символы кодируются в два или более байта, но это нормально, если они хранятся редко.

Пространственная эффективность — ключевое преимущество кодировки UTF-8. Если бы вместо этого каждый символ Unicode был представлен четырьмя байтами, текстовый файл, написанный на английском языке, был бы в четыре раза больше, чем тот же файл, закодированный с помощью UTF-8.

Еще одним преимуществом кодировки UTF-8 является ее обратная совместимость с ASCII. Первые 128 символов в библиотеке Unicode соответствуют символам в библиотеке ASCII, а UTF-8 переводит эти 128 символов Unicode в те же двоичные строки, что и ASCII. В результате UTF-8 может без проблем принимать текстовый файл, отформатированный с помощью ASCII, и преобразовывать его в читаемый человеком текст.

Символы UTF-8 в веб-разработке

UTF-8 — наиболее распространенный метод кодировки символов, используемый сегодня в Интернете, и набор символов по умолчанию для HTML5.Более 95% всех веб-сайтов, в том числе и ваш собственный, хранят персонажей таким образом. Кроме того, распространенные методы передачи данных через Интернет, такие как XML и JSON, кодируются стандартами UTF-8.

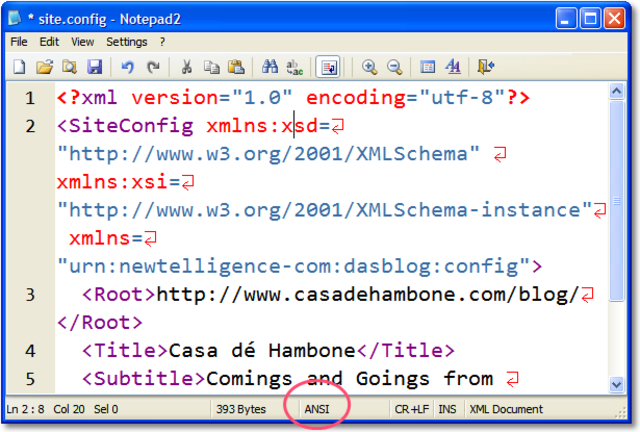

Поскольку в настоящее время это стандартный метод кодирования текста в Интернете, все страницы вашего сайта и базы данных должны использовать кодировку UTF-8. Система управления контентом или конструктор веб-сайтов по умолчанию сохранят ваши файлы в формате UTF-8, но все же рекомендуется следить за тем, чтобы вы придерживались этой передовой практики.

Текстовые файлы, закодированные с помощью UTF-8, должны указывать на это программному обеспечению, обрабатывающему их.В противном случае программа не сможет должным образом преобразовать двоичный код обратно в символы. В файлах HTML вы можете увидеть строку кода, подобную следующему, вверху:

Это сообщает браузеру, что файл HTML закодирован в UTF-8, чтобы браузер мог преобразовать его обратно в разборчивый текст.

UTF-8 против UTF-16

Как я уже упоминал, UTF-8 — не единственный метод кодирования для символов Юникода — существует также UTF-16.Эти методы различаются количеством байтов, необходимых для хранения символа. UTF-8 кодирует символ в двоичную строку из одного, двух, трех или четырех байтов. UTF-16 кодирует символ Unicode в строку из двух или четырех байтов.

Это различие видно из их названий. В UTF-8 наименьшее двоичное представление символа — это один байт или восемь битов. В UTF-16 наименьшее двоичное представление символа составляет два байта или шестнадцать бит.

Как UTF-8, так и UTF-16 могут переводить символы Unicode в удобные для компьютера двоичные файлы и обратно.Однако они несовместимы друг с другом. Эти системы используют разные алгоритмы для сопоставления кодовых точек с двоичными строками, поэтому двоичный вывод для любого заданного символа будет отличаться от обоих методов:

| Знак | Двоичная кодировка UTF-8 | Двоичная кодировка UTF-16 |

| А | 01000001 | 01000001 11011000 00001110 11011111 |

| 𠜎 | 11110000 10100000 10011100 10001110 | 01000001 11011000 00001110 11011111 |

Кодировка

UTF-8 предпочтительнее UTF-16 на большинстве веб-сайтов, поскольку она использует меньше памяти.Напомним, что UTF-8 кодирует каждый символ ASCII всего одним байтом. UTF-16 должен кодировать эти же символы в двух или четырех байтах. Это означает, что текстовый файл на английском языке с кодировкой UTF-16 будет как минимум в два раза больше размера того же файла с кодировкой UTF-8.

UTF-16 более эффективен, чем UTF-8, только на некоторых неанглоязычных сайтах. Если веб-сайт использует язык с символами, находящимися дальше в библиотеке Unicode, UTF-8 будет кодировать все символы как четыре байта, тогда как UTF-16 может кодировать многие из тех же символов только как два байта.Тем не менее, если ваши страницы заполнены буквами ABC и 123, придерживайтесь UTF-8.

Расшифровка мира кодировки UTF-8

Это было много слов о словах, поэтому давайте резюмируем то, что мы рассмотрели:

- Компьютеры хранят данные, включая текстовые символы, как двоичные (единицы и нули).

- ASCII был ранним способом кодирования или отображения символов в двоичный код, чтобы компьютеры могли их хранить. Однако в ASCII не было достаточно места для представления нелатинских символов и чисел в двоичном формате.

- Unicode был решением этой проблемы. Unicode присваивает уникальный «код» каждому символу на каждом человеческом языке.

- UTF-8 — это метод кодировки символов Юникода. Это означает, что UTF-8 берет кодовую точку для данного символа Юникода и переводит ее в строку двоичного кода. Он также делает обратное, считывая двоичные цифры и преобразуя их обратно в символы.

- UTF-8 в настоящее время является самым популярным методом кодирования в Интернете, поскольку он может эффективно хранить текст, содержащий любые символы.

- UTF-16 — еще один метод кодирования, но он менее эффективен для хранения текстовых файлов (за исключением тех, которые написаны на некоторых неанглийских языках).

Перевод Unicode — это не то, о чем большинству из нас нужно думать при просмотре или разработке веб-сайтов, и именно в этом суть — создать бесшовную систему обработки текста, которая работает для всех языков и веб-браузеров. Если он работает хорошо, вы этого не заметите.

Но если вы обнаружите, что страницы вашего веб-сайта занимают чрезмерно много места или если ваш текст усеян буквами и, пора применить ваши новые знания о UTF-8.

Кодировка строки Python ()

Начиная с Python 3.0, строки хранятся как Unicode, т.е. каждый символ в строке представлен кодовой точкой. Итак, каждая строка — это просто последовательность кодовых точек Unicode.

Для эффективного хранения этих строк последовательность кодовых точек преобразуется в набор байтов. Этот процесс известен как encoding .

Существуют различные кодировки, которые по-разному обрабатывают строку. Популярные кодировки: utf-8 , ascii и т. Д.

Используя метод строки encode () , вы можете преобразовать некодированные строки в любые кодировки, поддерживаемые Python. По умолчанию Python использует кодировку utf-8 .

Синтаксис метода encode () :

string.encode (кодировка = 'UTF-8', errors = 'strict')

String encode () Параметры

По умолчанию метод encode () не требует никаких параметров.

Возвращает версию строки в кодировке utf-8.В случае сбоя возникает исключение UnicodeDecodeError .

Однако он принимает два параметра:

- кодировка — тип кодировки, в котором строка должна быть закодирована в

- ошибок — ответ при сбое кодирования. Есть шесть типов реакции на ошибку

- strict — ответ по умолчанию, который вызывает исключение UnicodeDecodeError при сбое

- ignore — игнорирует некодируемый юникод из результата

- replace — заменяет некодируемый юникод на вопросительный знак ?

- xmlcharrefreplace — вставляет ссылку на символ XML вместо некодируемого юникода

- backslashreplace — вставляет escape-последовательность \ uNNNN вместо некодируемого юникода

- namereplace — вставляет \ N {…} escape-последовательность вместо некодируемого юникода

Пример 1: Кодирование по умолчанию Utf-8 Кодировка

# строка Unicode

строка = 'pythön!'

# напечатать строку

print ('Строка:', строка)

# кодировка по умолчанию в utf-8

строка_utf = строка.encode ()

# результат печати

print ('Закодированная версия:', string_utf)

Выход

Строка: pythön! Закодированная версия: b'pyth \ xc3 \ xb6n! '

Пример 2: Кодирование с параметром ошибки

# строка Unicode

строка = 'pythön!'

# напечатать строку

print ('Строка:', строка)

# игнорировать ошибку

print ('Закодированная версия (с игнорированием):', string.encode ("ascii", "игнорировать"))

# заменить ошибку

print ('Закодированная версия (с заменой):', string.encode ("ascii", "replace"))

Выход

Строка: pythön! Закодированная версия (с игнорированием): b'pythn! ' Закодированная версия (с заменой): b'pyth? N! '

Примечание: Попробуйте также другие параметры кодировки и ошибок.

utf8 — язык программирования Go

Обзор ▹

Обзор ▾

Пакет utf8 реализует функции и константы для поддержки текста, закодированного в

UTF-8.Он включает функции для перевода между рунами и последовательностями байтов UTF-8.

См. Https://en.wikipedia.org/wiki/UTF-8.

Константы

Числа, необходимые для кодирования.

const (

RuneError = '\ uFFFD'

RuneSelf = 0x80

MaxRune = '\ U0010FFFF'

UTFMax = 4

) func DecodeLastRune (p [] byte) (r rune, size int)

DecodeLastRune распаковывает последнюю кодировку UTF-8 в p и возвращает руну и

его ширина в байтах.Если p пусто, возвращается (RuneError, 0). В противном случае, если

кодировка недействительна, возвращается (RuneError, 1). Оба невозможны

результаты для правильного непустого UTF-8.

Кодировка недействительна, если это неверный UTF-8, кодирует руну, которая

вне диапазона или не является самой короткой кодировкой UTF-8 для

значение. Никакая другая проверка не выполняется.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

b: = [] байт («Привет,»)

for len (b)> 0 {

r, размер: = utf8.DecodeLastRune (b)

fmt.Printf («% c% v \ n», r, размер)

b = b [: len (b) -размер]

}

}

界 3 世 3 1 , 1 o 1 l 1 l 1 e 1 H 1

Запустить

Формат

доля

func DecodeLastRuneInString (s строка) (r руна, размер int)

DecodeLastRuneInString похож на DecodeLastRune, но его ввод — это строка. Если

s пусто, он возвращает (RuneError, 0). В противном случае, если кодировка недействительна,

он возвращает (RuneError, 1).Оба результата невозможны для правильного,

непустой UTF-8.

Кодировка недействительна, если это неверный UTF-8, кодирует руну, которая

вне диапазона или не является самой короткой кодировкой UTF-8 для

значение. Никакая другая проверка не выполняется.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

str: = «Привет, 世界»

for len (str)> 0 {

r, размер: = utf8.DecodeLastRuneInString (str)

fmt.Printf («% c% v \ n», r, размер)

str = str [: len (str) -size]

}

}

界 3 世 3 1 , 1 o 1 l 1 l 1 e 1 H 1

Запустить

Формат

доля

func DecodeRune (p [] byte) (r rune, size int)

DecodeRune распаковывает первую кодировку UTF-8 в p и возвращает руну и

его ширина в байтах.Если p пусто, возвращается (RuneError, 0). В противном случае, если

кодировка недействительна, возвращается (RuneError, 1). Оба невозможны

результаты для правильного непустого UTF-8.

Кодировка недействительна, если это неверный UTF-8, кодирует руну, которая

вне диапазона или не является самой короткой кодировкой UTF-8 для

значение. Никакая другая проверка не выполняется.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

b: = [] байт («Привет,»)

for len (b)> 0 {

r, размер: = utf8.DecodeRune (b)

fmt.Printf («% c% v \ n», r, размер)

b = b [размер:]

}

}

H 1 e 1 l 1 l 1 o 1 , 1 1 世 3 界 3

Запустить

Формат

доля

func DecodeRuneInString (s строка) (r руна, размер int)

DecodeRuneInString похож на DecodeRune, но его ввод — это строка. Если s

пусто, он возвращает (RuneError, 0). В противном случае, если кодировка недействительна, она

возвращает (RuneError, 1).Оба результата невозможны для правильного, непустого

UTF-8.

Кодировка недействительна, если это неверный UTF-8, кодирует руну, которая

вне диапазона или не является самой короткой кодировкой UTF-8 для

значение. Никакая другая проверка не выполняется.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

str: = «Привет, 世界»

for len (str)> 0 {

r, размер: = utf8.DecodeRuneInString (str)

fmt.Printf («% c% v \ n», r, размер)

str = str [размер:]

}

}

H 1 e 1 l 1 l 1 o 1 , 1 1 世 3 界 3

Запустить

Формат

доля

func EncodeRune (p [] byte, r rune) int

EncodeRune записывает в p (который должен быть достаточно большим) кодировку UTF-8 руны.Если руна выходит за пределы допустимого диапазона, она записывает кодировку RuneError.

Возвращает количество записанных байтов.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

г: = ‘世’

buf: = make ([] байт, 3)

n: = utf8.EncodeRune (buf, r)

fmt.Println (buf)

fmt.Println (n)

}

Запустить

Формат

доля

▾ Пример (OutOfRange)

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

руны: = [] руна {

// Меньше 0, вне допустимого диапазона.-1,

// Больше 0x10FFFF, вне допустимого диапазона.

0x110000,

// Символ замены Unicode.

utf8.RuneError,

}

for i, c: = range runes {

buf: = make ([] байт, 3)

size: = utf8.EncodeRune (buf, c)

fmt.Printf («% d:% d% [2] s% d \ n», i, buf, size)

}

}

0: [239 191 189] � 3 1: [239 191 189] � 3 2: [239 191 189] � 3

Запустить

Формат

доля

func FullRune (p [] byte) bool

FullRune сообщает, начинаются ли байты в p с полной кодировки руны UTF-8.Неверная кодировка считается полной руной, поскольку она преобразуется в руну ошибки шириной 1.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

buf: = [] байт {228, 184, 150} // 世

fmt.Println (utf8.FullRune (buf))

fmt.Println (utf8.FullRune (buf [: 2]))

}

Запустить

Формат

доля

func FullRuneInString (s строка) bool

FullRuneInString похож на FullRune, но его ввод — это строка.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

str: = «世»

fmt.Println (utf8.FullRuneInString (str))

fmt.Println (utf8.FullRuneInString (str [: 2]))

}

Запустить

Формат

доля

func RuneCount (p [] byte) int

RuneCount возвращает количество рун в p.Ошибочные и короткие

кодировки рассматриваются как отдельные руны шириной 1 байт.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

buf: = [] byte («Привет,»)

fmt.Println («bytes =», len (buf))

fmt.Println («runes =», utf8.RuneCount (buf))

}

Запустить

Формат

доля

func RuneCountInString (s строка) (n int)

RuneCountInString похож на RuneCount, но его ввод — это строка.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

str: = «Привет, 世界»

fmt.Println («bytes =», len (str))

fmt.Println («runes =», utf8.RuneCountInString (str))

}

Запустить

Формат

доля

func RuneLen (r rune) int

RuneLen возвращает количество байтов, необходимое для кодирования руны.Он возвращает -1, если руна не является допустимым значением для кодирования в UTF-8.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

fmt.Println (utf8.RuneLen (‘a’))

fmt.Println (utf8.RuneLen (‘界’))

}

Запустить

Формат

доля

func RuneStart (b byte) bool

RuneStart сообщает, может ли байт быть первым байтом закодированного,

возможно неверная руна.Второй и последующие байты всегда имеют два верхних

бит установлен на 10.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

buf: = [] байт («а 界»)

fmt.Println (utf8.RuneStart (buf [0]))

fmt.Println (utf8.RuneStart (buf [1]))

fmt.Println (utf8.RuneStart (buf [2]))

}

Запустить

Формат

доля

func Допустимый (p [] байт) bool

Valid сообщает, состоит ли p полностью из валидных рун в кодировке UTF-8.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

действительный: = [] байт («Привет,»)

неверно: = [] байт {0xff, 0xfe, 0xfd}

fmt.Println (utf8.Valid (действительный))

fmt.Println (utf8.Valid (недействительно))

}

Запустить

Формат

доля

func ValidRune (r rune) bool

ValidRune сообщает, можно ли юридически закодировать r как UTF-8.Кодовые точки, которые находятся вне диапазона или являются суррогатной половиной, являются незаконными.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

действительный: = ‘a’

неверно: = руна (0xfffffff)

fmt.Println (utf8.ValidRune (действительный))

fmt.Println (utf8.ValidRune (недействительно))

}

Запустить

Формат

доля

func ValidString (s строка) bool

ValidString сообщает, состоит ли s полностью из допустимых рун в кодировке UTF-8.

▾ Пример

основной пакет

Импортировать (

«fmt»

«Юникод / UTF8»

)

func main () {

действительно: = «Привет, 世界»

неверно: = строка ([] байт {0xff, 0xfe, 0xfd})

fmt.Println (utf8.ValidString (действительный))

fmt.Println (utf8.ValidString (недопустимый))

}

Запустить

Формат

доля

Выбор и применение кодировки символов

Выбор и применение кодировки символов

Целевая аудитория:

HTML-кодеры (с использованием редакторов или сценариев), разработчики сценариев (PHP, JSP и т. Д.)), Кодировщиков CSS, менеджеров веб-проектов и всех, кто плохо знаком с кодировками символов и нуждается в введении в то, как выбирать и применять кодировки символов.

Какую кодировку символов я должен использовать для своего контента и как применить ее к моему контенту?