Настройка сети esxi: Особенности настройки сети в VMware Vsphere 5.0, 5.5, 6.0

Особенности настройки сети в VMware Vsphere 5.0, 5.5, 6.0

Здесь мы рассмотрим порядок и некоторые тонкости настройки сети на хостах VMware ESXi и в vCenter Server. Если вы не используете сетевое хранилище данных (СХД) и у вас в сети (в частности в среде виртуализации) только 1 VLAN, ничего этого вам настраивать не нужно, все и так будет работать.

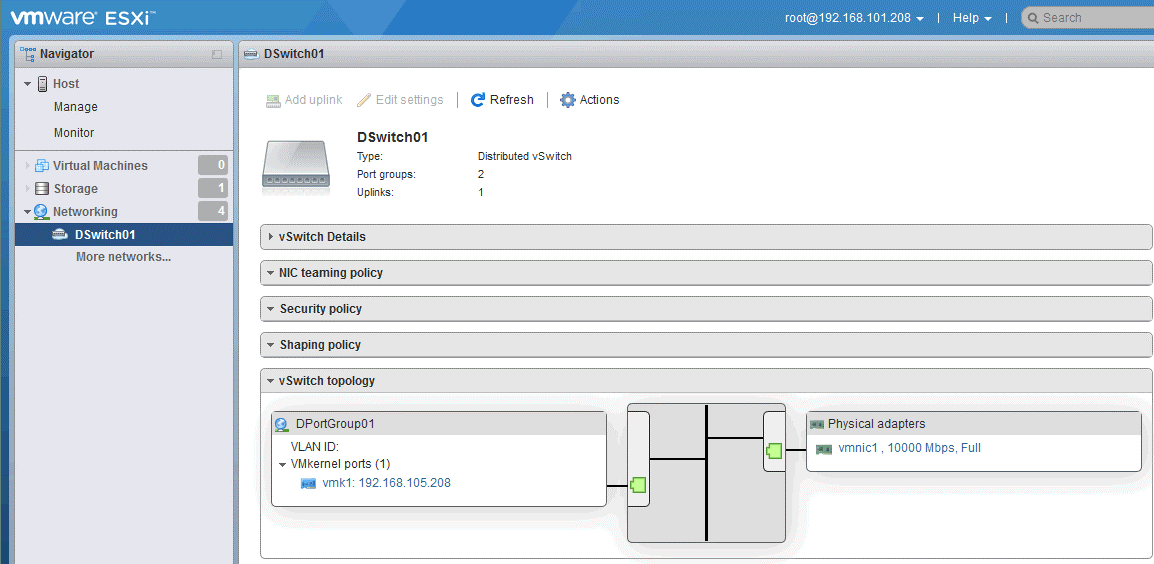

Есть 2 способа настроек: vSphere Standart Switch (vSS) и vSphere Distributed Switch (vDS). vDS доступен только в самой дорогой редакции VMware Enterprise Plus. Пока у вас не установлен vCenter Server на хостах вам доступен только vSS. Естественно если vCenter Server установлен, но недоступен (например из-за какого-то сбоя), то производить настройку/перенастройку vDS также не удастся. Основное преимущество vDS — единая настройка сети для всех хостов. Конечно есть и еще плюсы: можно шейпить исходящий трафик, поддерживаются Private VLAN, Netflow, Port Mirroring, балансировка нагрузки между сетевыми интерфейсами… Но я считаю, если у вас до 10 серверов и до 10 VLAN, то вполне можно обойтись vSS. Поэтому настройку vDS в данной статье я рассматривать не буду.

Поэтому настройку vDS в данной статье я рассматривать не буду.

Так как хост выступает в качестве среды виртуализации, он внутри себя имеет можно сказать небольшую серверную комнату с виртуальными машинами и виртуальными коммутаторами. Так вот сетевые платы хоста — это как бы каналы связи, приходящие в эту виртуальную серверную комнату. В серверной мы подключаем сетевые платы серверов к портам коммутаторов и настраиваем эти порты. Так же и внутри виртуального коммутатора мы, делая настройки, подключаем виртуальные машины к виртуальному коммутатору, и настраиваем через какой канал тот или иной коммутатор будет работать с тем или иным сервисом.

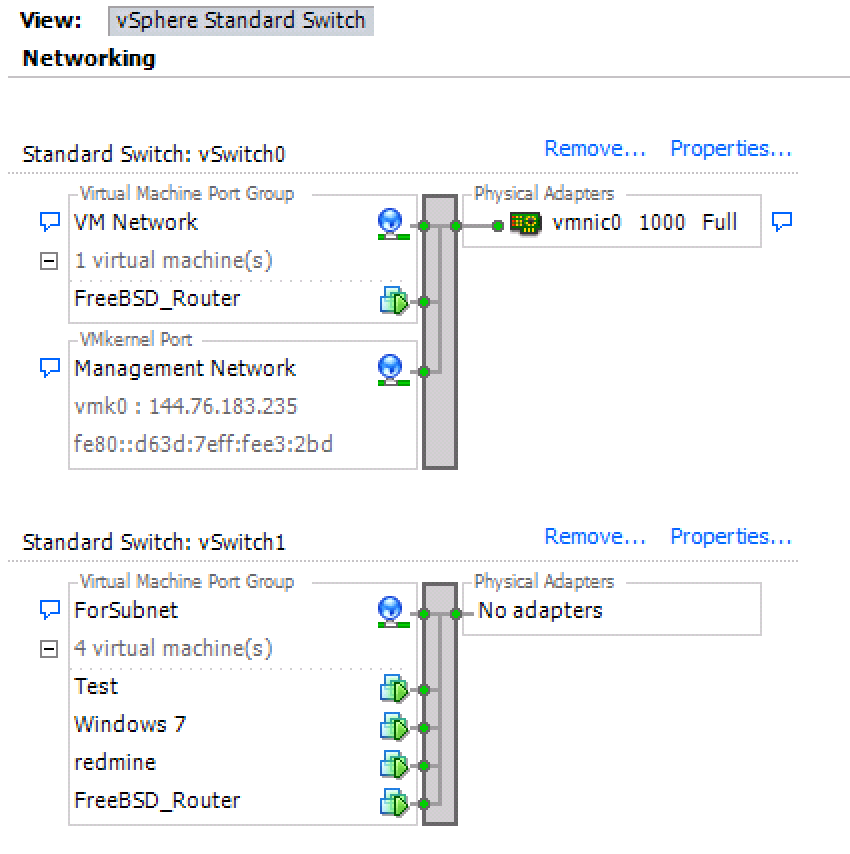

Итак у вас есть один или несколько хостов с ESXi. Вы подключились к ним через vSphere Client. Выбираете у хоста вкладку Configuration, пункт Networking и видите список свитчей и порт-групп в них. Сразу после установки ESXi создается один Standart Switch: vSwitch0 с двумя порт-группами. Порт-группы бывают двух видов (это выбирается при их создании) Virtual Machine и VMkernel. Первый тип нужен для работы виртуальных машин, второй для внутренних сервисов системы виртуализации (управления, перемещения виртуальных машин между хостами, подключения к СХД по iSCSI и работе VSAN — виртуального хранилища данных). Так вот по умолчанию создана Virtual Machine Port Group — VM Network и VMkernel Port — Management Network. Рядом с порт-группами указаны какие физические сетевые адаптеры подключены к этому vSwitch0 (они обозначаются vmnic0, vmnic1 и т.д.). Это те сетевые адаптеры, которые вы выбрали в конце установке ESXi. Так вот каждая физическая сетевая карта может быть подключена только к одному vSwitch. Большого смысла создавать второй, третий и т.д. vSwitch в небольшой сети я не вижу, ведь разделить работу различных сервисов и виртуальных машин по разным сетевым картам можно и внутри одного vSwitch, но в некоторых случаях это может быть удобно, хотя всегда можно разнести сетевые карты по разным свитчам, даже не прерывая работу системы.

Первый тип нужен для работы виртуальных машин, второй для внутренних сервисов системы виртуализации (управления, перемещения виртуальных машин между хостами, подключения к СХД по iSCSI и работе VSAN — виртуального хранилища данных). Так вот по умолчанию создана Virtual Machine Port Group — VM Network и VMkernel Port — Management Network. Рядом с порт-группами указаны какие физические сетевые адаптеры подключены к этому vSwitch0 (они обозначаются vmnic0, vmnic1 и т.д.). Это те сетевые адаптеры, которые вы выбрали в конце установке ESXi. Так вот каждая физическая сетевая карта может быть подключена только к одному vSwitch. Большого смысла создавать второй, третий и т.д. vSwitch в небольшой сети я не вижу, ведь разделить работу различных сервисов и виртуальных машин по разным сетевым картам можно и внутри одного vSwitch, но в некоторых случаях это может быть удобно, хотя всегда можно разнести сетевые карты по разным свитчам, даже не прерывая работу системы.

Вот так выглядит настройка сети по умолчанию. Как вы видите у меня задействовано 2 сетевых адаптера хоста, vmnic0 — подключен на скорости 1000Мбит/с и vmnic1 — находится в режиме stand by (на готове), т.е. пока работает основной адаптер — этот ожидает, и включается когда линк на основном пропадает.

Как вы видите у меня задействовано 2 сетевых адаптера хоста, vmnic0 — подключен на скорости 1000Мбит/с и vmnic1 — находится в режиме stand by (на готове), т.е. пока работает основной адаптер — этот ожидает, и включается когда линк на основном пропадает.

Для настроек свитча нужно нажать Properties и откроется окно настроек:

Здесь можно настроить сам vSwitch, порт-группы VM Network и Management Network или создать новые.

Настройка сети на VMWare ESXi в Hetzner.de | Глеб Воронов

Недавно мы установили ESXi на VDS в датацентре Hetzner. Теперь необходимо создавать виртуалки, ставить системы и работать. Как быть с сетью и IP адресами? Особенности две:

1) ESXi не умеет маршрутизацию

2) Хитрая система подсети в Hetzner

Для того что бы можно было парковать подсеть необходимо следующее:

1) Сам сервер с ESXi

2) Дополнительный IP с привязанным к нему MAC-адресом (запрашивается через Robot-панель)

3) Сама подсеть, смаршрутизированная на IP из предыдущего пункта

IP и подсеть заказываются в Robot панели в меню Servers во вкладке IPs

В самом низу нажимаем на «Ordering of additional IP, failover IP or subnet» и выбираем «One additional IP with costs» за 0,84 евро в месяц

В поле ниже нужно написать для чего нужен этот адрес

Практически сразу приходит письмо на почту с настройками сети и MAC-адресом, который нужно будет указать интерфейсу в виртуальной машине, что бы сеть подхватилась.

Следующий шаг — подсеть. Заказывается в том же меню.

После того как бюрократия закончилась приступим к созданию виртуальной машины, которая и будет заниматься роутингом.

Небольшие подготовительные работы. Создаём виртуальный свитч.

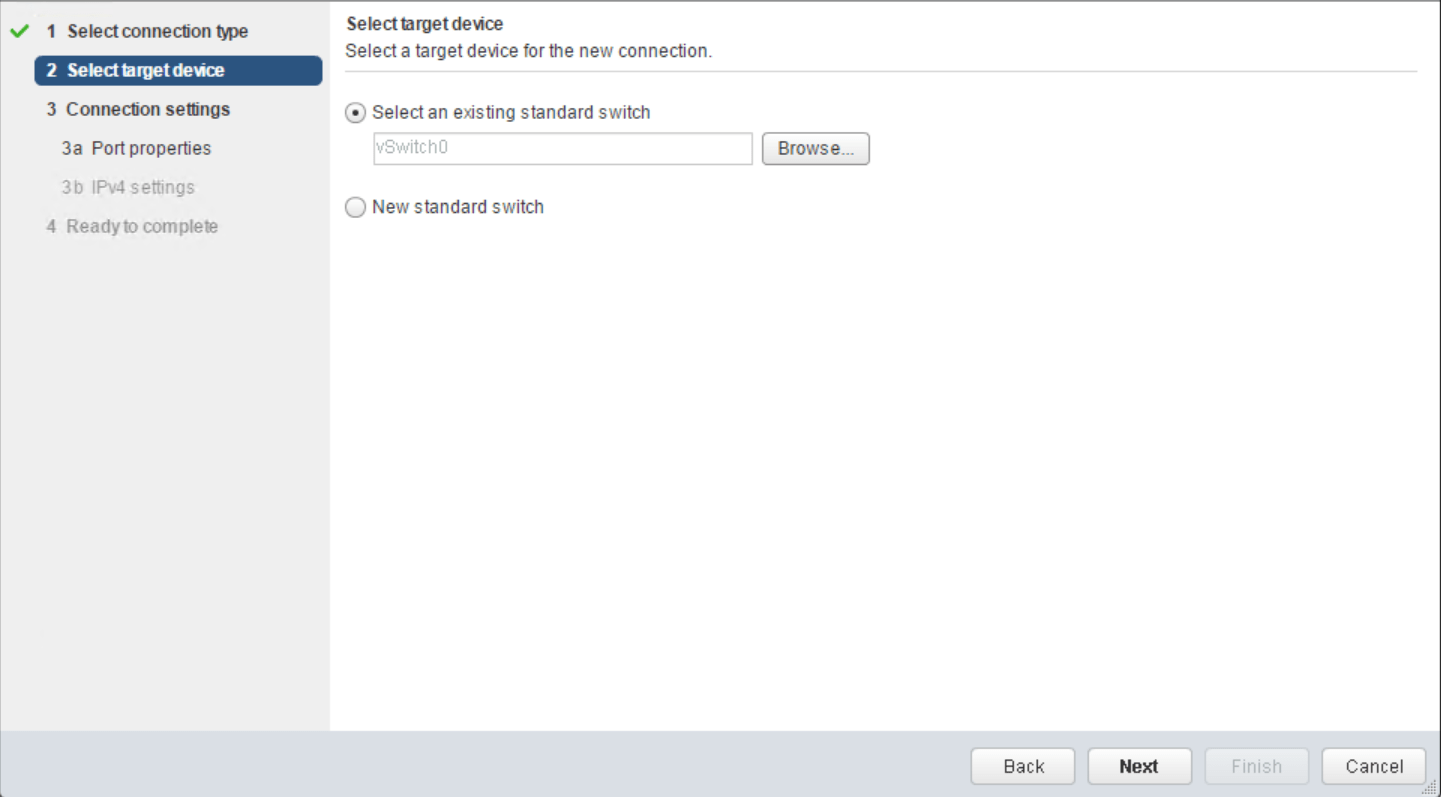

В программе VMware vSphere Client авторизируемся и переходим в Configuration -> Hardware -> Networking

Нажимаем Add Networking. В «Connection type» выбираем «Virtual Machine» -> Далее

«Create a vSphere standard Switch» -> Далее

«Network Label» указываем «ForSubnet«, WLAN ID не трогаем -> Next -> Finish

Создаём виртуальную машину с двумя сетевыми карточками, одна из которых подключена к основному интерфейсу, а вторая к свитчу. На картинке она называется FreeBSD_Router. Как видно она присутствует в обеих. Не забываем указать для VM Network тот MAC адрес, который выдал Hetzner

Как видно она присутствует в обеих. Не забываем указать для VM Network тот MAC адрес, который выдал Hetzner

При установке фряха сама подхватила сетевые настройки по DHCP. Но потом для надежности я прописал их руками. Займёмся конфигурацией второго интерфейса. Выбираем предпоследний IP из списка (последний — broadcast, зажали айпишник, жуки 🙂 ) и указываем ему соответствующую маску. У меня сеть /28, соответствует маске 255.255.255.240

В итоге получился такой конфиг:

#Network hostname="router" gateway_enable="YES" defaultrouter="144.76.183.200" ifconfig_em0="inet 144.76.183.201 netmask 255.255.255.224" ifconfig_em1="inet 144.76.170.124 netmask 255.255.255.240"

Теперь при создании виртуалок сетевой интерфейс нужно будет назначать «ForSubnet» и настройки сети будут следующие:

IP: любой из списка, кроме последних двух Netmask: 255.255.255.240 Gateway: 144.76.170.124

В планах поднять DHCP и сделать привязку по MAC-ам, что бы виртуалочки сами подхватывали сеть и был порядок.

Раздел: VMWare

Метки: esxi, freebsd, hetzner, tradenark, vmware

Виртуальная машина ESXI получает неправильные настройки сети

Добрый день! Уважаемые читатели и гости одного из крупнейших IT блогов рунета Pyatilistnik.org. В прошлый раз мы с вами разобрали, как производится подключение к удаленному рабочему столу через Windows и Linux, это очень актуально в режим удаленной работы. Сегодня я хочу поговорить про административные вещи, а именно, о виртуализации. Встретился мне тут один интересный случай, когда при смене сетевого интерфейса виртуальная машина получила непонятные сетевые настройки, не те что должна была.

Описание ситуации

И так есть кластер построенный на гипервизоре ESXI 6.5, у одной из виртуальных машин необходимо было изменить тип сетевого интерфейса с VMXNET3 на E1000. После того, как преобразования были выполнены и виртуальная машина была запущена, она получила какие-то неправильные сетевые настройки, IP-адрес, шлюз и DNS сервера не из того VLAN.

Изначально виртуальная машина имела IP-адрес 10.11.22.4

Но после того, как интерфейс был изменен, должны были прилететь настройки APIPA, а тут статический IP-адрес 192.168.31.51. Сбросить его на DHCP или другой IP-адрес ни к чему не приводили.

Как устранить проблему с неправильным IP-адресом

Первое, что я начал делать, это поискать в реестре Windows, я вам уже делал подробный обзор, о тех утилитах которыми я пользуюсь. Открываем Registry Finder и начинаем искать не правильный IP_адрес, в моем случае это 192.168.31.51. Как видите в мое поле зрения вошли некоторые ветки реестра:

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet001\Services\ Tcpip\Parameters\Interfaces\GUID

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet001\Services\ WLBS\Parameters\Interfaces\GUID

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet001\Services\ GUID\Parameters\Tcpip

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet002\Services\ Tcpip\Parameters\Interfaces\GUID

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet002\Services\ WLBS\Parameters\Interfaces\GUID

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet002\Services\ GUID\Parameters\Tcpip

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet\Services\ Tcpip\Parameters\Interfaces\GUID

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet\Services\ WLBS\Parameters\Interfaces\GUID

- HKEY_LOCAL_MACHINE\SYSTEM\ControlSet\Services\ GUID\Parameters\Tcpip

В каждой из них есть ключи реестра IPAddress, DedicatedIPAddresses, которые и используются по какой-то причине операционной системой.

Я так же проверил, что в этих же ветках содержится и правильный IP-адрес.

Как видите в каждой из этих веток есть GUID сетевого интерфейса, в моей системе я вижу только один сетевой интерфейс, но в реестре их два. Давайте удостоверимся, что система видит их больше, для этого откройте оболочку PowerShell и введите команду:

Get-ItemProperty «HKLM:\SYSTEM\CurrentControlSet\services\Tcpip\Parameters\Interfaces\*» | select -ExpandProperty pschildname

В результате я удостоверился, что у меня есть некий фантом. Ранее я вам рассказывал, как определить GUID сетевого интерфейса, поэтому давайте убедимся, какой из них правильный, а какой нет. Напоминаю, правильный у меня тот интерфейс, который имеет тип VMXNET3 (Должен заканчиваться на D4).

В результате первый GUID заканчивающийся на B2} оказался старый интерфейс от сетевой карты, у которой тип был E1oo0 и производитель Intel. Именно он подставлялся, на свежедобавленный интерфейс, такого же типа E1000. Видимо, Windows оставляет у себя эту информацию после удаления интерфейсов, и потом ее восстанавливает если GUID одинаковые, видимо это нормальное поведение, которое и позволяет на лету менять оборудование.

Видимо, Windows оставляет у себя эту информацию после удаления интерфейсов, и потом ее восстанавливает если GUID одинаковые, видимо это нормальное поведение, которое и позволяет на лету менять оборудование.

У второго GUID все нормально, тип VMXNET3, это и есть текущий.

Вывод тут напрашивается сам собой, вам нужно удалить все старые упоминания, о вашем прошлом сетевом интерфейсе, проверьте у себя те ветки, что я привел вам выше, или так же еще воспользуйтесь утилитами по поиску в реестре. Вот такой вот интересный случай, который при незнании таких нюансов может вызвать кучу проблем. Небольшой совет, всегда при работах на серверах, заранее делайте снапшот, чтобы потом было легко откатиться и подумать в чем дело и не сидеть пол ночи в поисках решения. С вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org.

Доступ в Интернет к виртуальным машинам через Vsphere ESXI 6

у вашего ESXI статический ip правильный, был статический ip, предоставленный провайдером? или это подделка? если это фальшивый NAT, ваш путь к адресу провайдера или же IP-адрес ESXI

сейчас для DD-WRT есть 2 варианта

Простая версия

Отключить DHCP Подключите порт LAN к основной сети / к порту LAN основного маршрутизатора. Теперь у вас есть настройка только для AccesPoint, где клиентам предоставляются данные IP из вашей основной сети или основного маршрутизатора.

Теперь у вас есть настройка только для AccesPoint, где клиентам предоставляются данные IP из вашей основной сети или основного маршрутизатора.

Длинная версия

Вот как создать беспроводную точку доступа с помощью dd-wrt v24. Хард ресет или 30/30/30 роутер с настройками dd-wrt по умолчанию Подключиться к роутеру @ http://192.168.1.1

Примечание. Если этот маршрутизатор подключен к другому маршрутизатору, возможны конфликты (оба маршрутизатора могут иметь одинаковый IP-адрес). В данный момент отключите этот роутер от основного. Откройте вкладку «Настройка» -> «Основные настройки».

Тип подключения к глобальной сети: отключено

Локальный IP-адрес: 192.168.1.2 (т.е. отличается от основного маршрутизатора и вне пула DHCP основного маршрутизатора)

Маска подсети: 255.255.255.0 (то же самое, что и основной маршрутизатор)

DHCP-сервер: отключить (также снимите флажки DNSmasq options)

(Рекомендуется) Шлюз / Локальный DNS: IP-адрес основного маршрутизатора (без этого многие вещи не будут работать, так как ваш маршрутизатор не сможет получить доступ к Интернету или другой сети без него)

(Необязательно) Назначить порт WAN для коммутатора (отображается только при отключенном типе подключения WAN): включите этот параметр, если хотите использовать порт WAN в качестве порта коммутатора (необязательно). NTP-клиент: включить / отключить (если включен, укажите шлюз / локальный DNS выше) Помогите

NTP-клиент: включить / отключить (если включен, укажите шлюз / локальный DNS выше) Помогите

Сохранить

Откройте вкладку «Настройка» -> «Расширенная маршрутизация» (необязательно). Измените режим работы на: «Маршрутизатор». Откройте вкладку «Беспроводная сеть» -> «Основные настройки». Имя беспроводной сети (SSID): YourNetworkNameHere (необязательно) Диапазон чувствительности: максимальное расстояние (в метрах) до клиентов x2 Сохранить Откройте вкладку «Беспроводная сеть -> Безопасность беспроводной сети». Примечание. Безопасность не является обязательной, но рекомендуется! Клиенты должны поддерживать любой режим, который вы выбираете здесь. (Рекомендуется) Режим безопасности: WPA2

(Рекомендуется) Алгоритм WPA: AES

(Рекомендуется) Общий ключ WPA:> 8 символов Сохранить Открыть Сервисы -> вкладка Сервисы

(Необязательно) DNSMasq: отключить (включить, если вы используете дополнительные настройки DNSMasq)

(Необязательно) Демон ttraff: отключить

Сохранить

Откройте вкладку Безопасность -> Брандмауэр

Снимите все флажки, кроме «Фильтр многоадресной передачи». Отключите брандмауэр SPI. Сохраните. Откройте Администрирование -> вкладка «Управление» (рекомендуется).

Отключите брандмауэр SPI. Сохраните. Откройте Администрирование -> вкладка «Управление» (рекомендуется).

(Рекомендуется) Маршрутизация: отключена (включите, если вам нужно маршрутизировать между интерфейсами)

Применить настройки и подключить кабель Ethernet к основному маршрутизатору через канал связи «LAN-to-LAN» *

Перезагрузите маршрутизатор, чтобы убедиться, что все настройки были применены.

Возможно, вам придется перезагрузить компьютер или выполнить «ipconfig / release» + «ipconfig / renew» из командной строки Windows.

Установка гипервизора VmWare ESXi версии 4.1

В данной статье будет рассматриваться пошаговая установка гипервизора VmWare ESXi версии 4.1. Кратко — разница между ESX и ESXi состоит в следующем: ESX — это гипервизор, работающий под управлением Red Hat Linux, а ESXi — тот-же самый гипервизор, но под управлением “усеченного” варианта Linux.

- “Усеченность” состоит в отсутствии какого-либо функционала, не нужного для работы гипервизора.

Что наряду с некоторыми минусами имеет целый ряд неоспоримых преимуществ:

Что наряду с некоторыми минусами имеет целый ряд неоспоримых преимуществ: - Компактность — можно установить на флешку — вариант “Embedded”, что-бы максимально полно задействовать весь обьем локального хранилища, в отличии от установленного на локальное хранилище — вариант “Installable”. Различий в настройке и функциям нет.

- Законченное решение — данный сервер занимается только одним делом — обслуживанием гипервизора, “не распыляясь” на другой функционал.

0. Оглавление

- Подготовка к установке

- Установка ESXi-сервера версии 4.1

- Настройка ESXi-сервера с консоли

- Подключение к ESXi-серверу.

- Клиент ESXi-сервера.

1. Подготовка к установке

Подключим к будущему серверу монитор, клавиатуру и сеть. В случае если к серверу будет подключено несколько хранилищ рекомендуется, что-бы не запутаться при установке, подключить только то хранилище, на которое и будут установлены системные файлы.

Если планируется установка на флешку, то отключать внутреннее хранилище не нужно — отличим их по размеру 🙂

Итак, приступим:

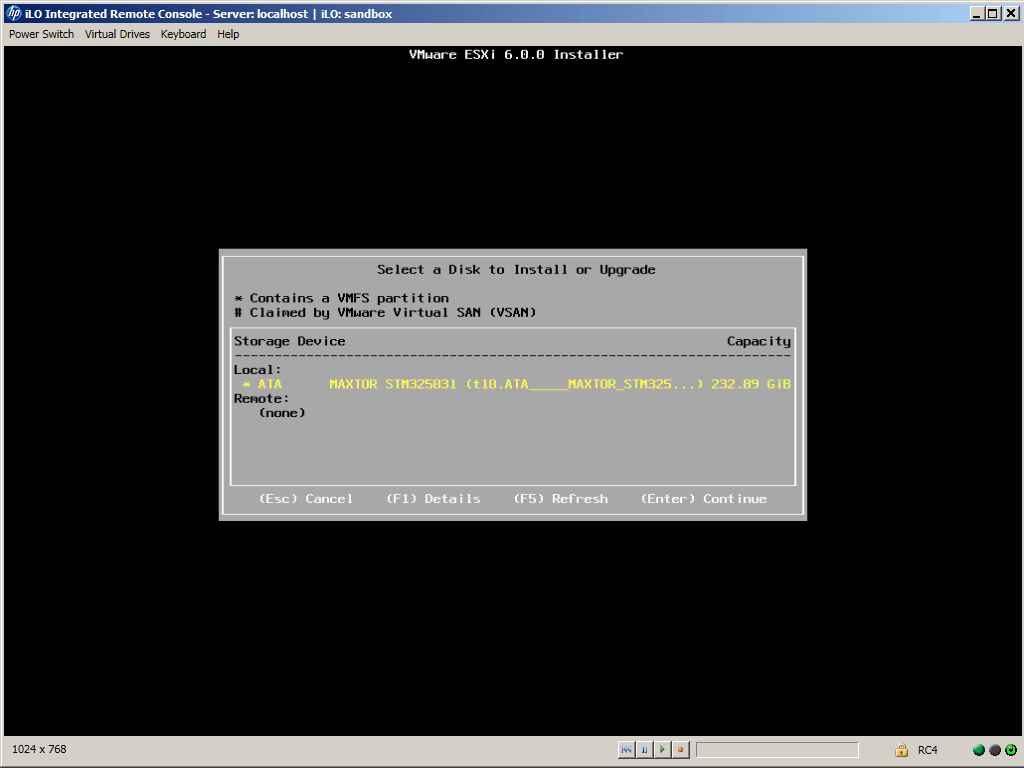

2.

Установка ESXi-сервера версии 4.1

Установка ESXi-сервера версии 4.1

Загрузившись с загрузочного диска увидим Boot menu. Выбираем пункт ESXi installer.

Приветственное окно. Enter.

Соглашаемся — F11.

Указываем диск для установки ESXi-сервера.

Подтверждаем — F11.

ESXi-сервер успешно установлен. Перегружаемся.

“Свежеустановленный” ESXi-сервер с консоли выглядит приблизительно так.

3. Настройка ESXi-сервера с консоли.

После инсталляции нужно сделать первичную настройку.

3.1 Пароль для доступа ESXi-серверу.

Первое что нам предстоит настроить — это административный пароль. Нажав F2, увидим окошко с полями логина и пароля. Изменять имя пользователя не рекомендуется, а пароль желательно ввести. В дальнейшем используя именно этот логин и пароль будет вестись управление ESXi-сервером. Попадаем в меню настроек.

3.

2 Настраиваем сеть.

2 Настраиваем сеть.

3.3 Конфигуратор сети.

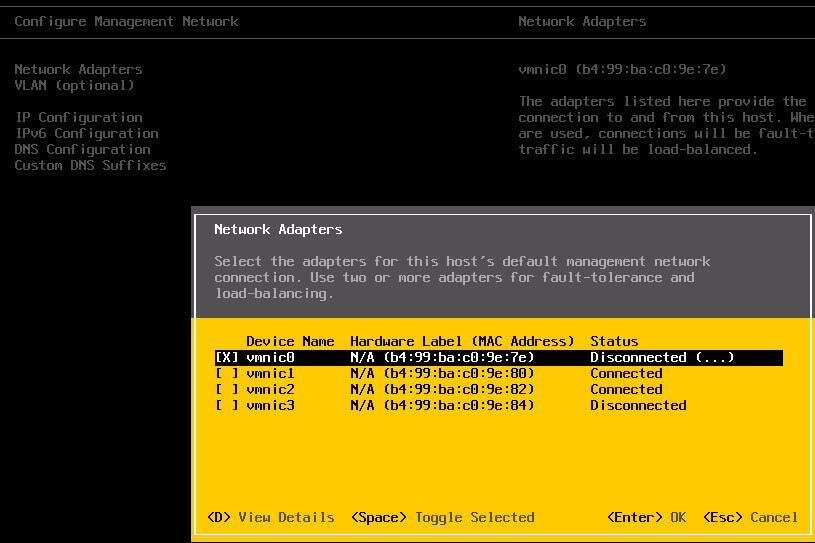

3.4 Выбор сетевого интерфейса.

В случае с одним сетевым интерфейсом все тривиально — ESXi сервер включается только в одну сеть и доступ виртуальных машин к сети и управление ESXi-сервером ведется через один сетевой интерфейс.

Картина несколько усложняется если сетевых интерфейсов несколько и подключены они к разным сетям.

Нужно указать сетевой интерфейс подключенный к той сети, с которой будет вестись управление ESXi-сервером.

Метод определения нужного нам сетевого интерфейса прост — отключим все сетевые интерфейсы от сети, за исключением одного, подключенного к основной сети. Желательно отмаркировать данный интерфейс на корпусе ESXi-сервера, дабы не ошибиться с подключением при установке в серверный шкаф.

Выходим из этого меню и заходим повторно. Теперь нет мук выбора нужного нам интерфейса.

Если к основной сети подключено более одного сетевого интерфейса можно подключить и отметить их все. Но обычно выбирается один.

Но обычно выбирается один.

Следующий шаг — настройка IP.

Выбор DHCP или static полностью зависит от настроек вашей сети и личных предпочтений. Рекомендую, при возможности, дать статический адрес. В этом случае при сбое или отключении DHCP-сервера сохранится доступ к управляющей консоли ESXi-сервера по IP адресу.

Далее — настройка DNS.

Как и при настройке IP здесь все зависит от настроек сети и вашего выбора.

При выходе из настроек сети будет запрос на сохранение настроек и рестарт сетевого сервиса. Отвечаем утвердительно.

На этом консольные настройки завершены. Нажимаем ESC и выходим из консоли. Монитор и клавиатуру можно отключить. Если есть отключенные сетевые интерфейсы — подключите их. Дальнейшее управление и настройка будут вестись по сети.

4. Подключение к ESXi-серверу.

Для работы и управления ESXi-сервером необходим другой компьютер с ОС Windows. Сначала поверим виден ли наш ESXi-сервер с компьютера с которого будет в дальнейшем производится управление ESXi-сервером.

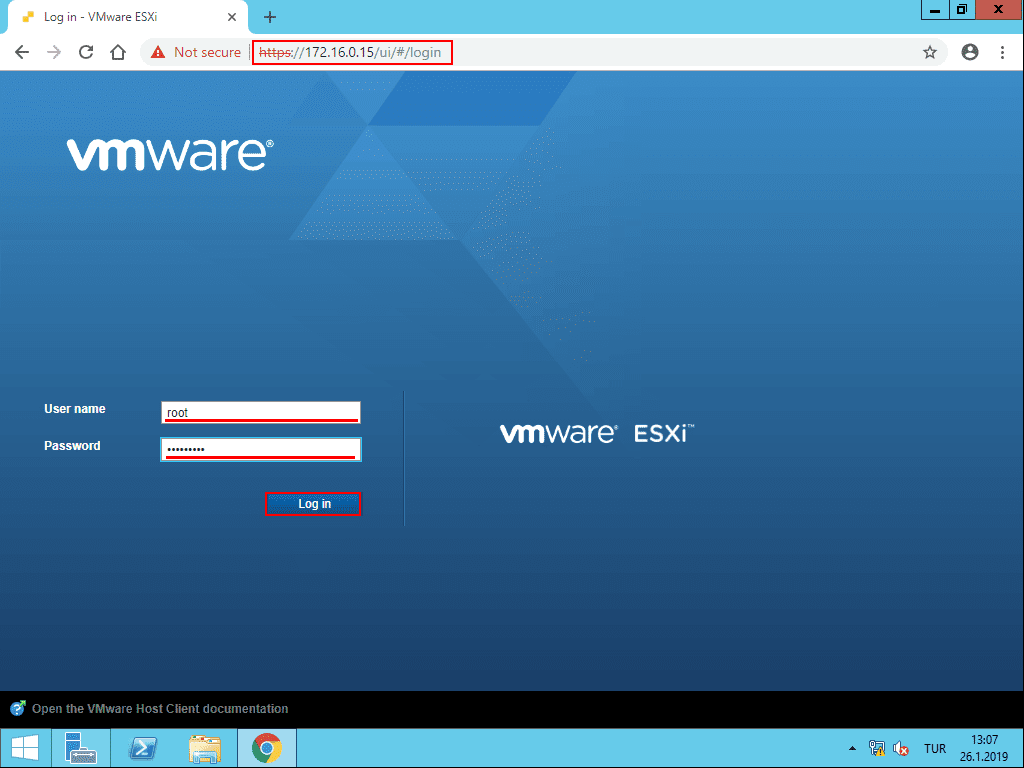

Если сервер виден, то открываем браузер и вводим строку с IP адресом ESXi-сервера. Например, вот так — http://192.168.162.128

Продолжаем все равно.

Подключение к ESXi-серверу произошло успешно. По ссылке “Download vSphere Client” загружаем с сайта vmware.com клиентскую программу по управлению ESXi-сервером.

Запускаем скаченный дистрибутив и начинаем процесс установки. Первое окно — выбор языка. Русского нет, выбираем английский.

Next. Еще раз Next.

Соглашаемся и жмем Next.

Заполняем поля и снова Next.

Указываем путь для установки.

Устанавливаем.

Установка успешно завершена.

Нажимаем Finish и перезагружаем компьютер.

5. Клиент ESXi-сервера.

На рабочем столе есть ярлык. Запускаем клиент ESXi-cервера.

Окно логина. Пароль вводили с консоли ESXi-сервера в начале его настройки.

Пароль вводили с консоли ESXi-сервера в начале его настройки.

Предупреждение о не доверенном сертификате. Устанавливаем галку в поле Install this….. и нажимаем Ignore.

Предупреждение о сроке действия временного ключа. 60 дней. Отлично.

Стартовый экран.

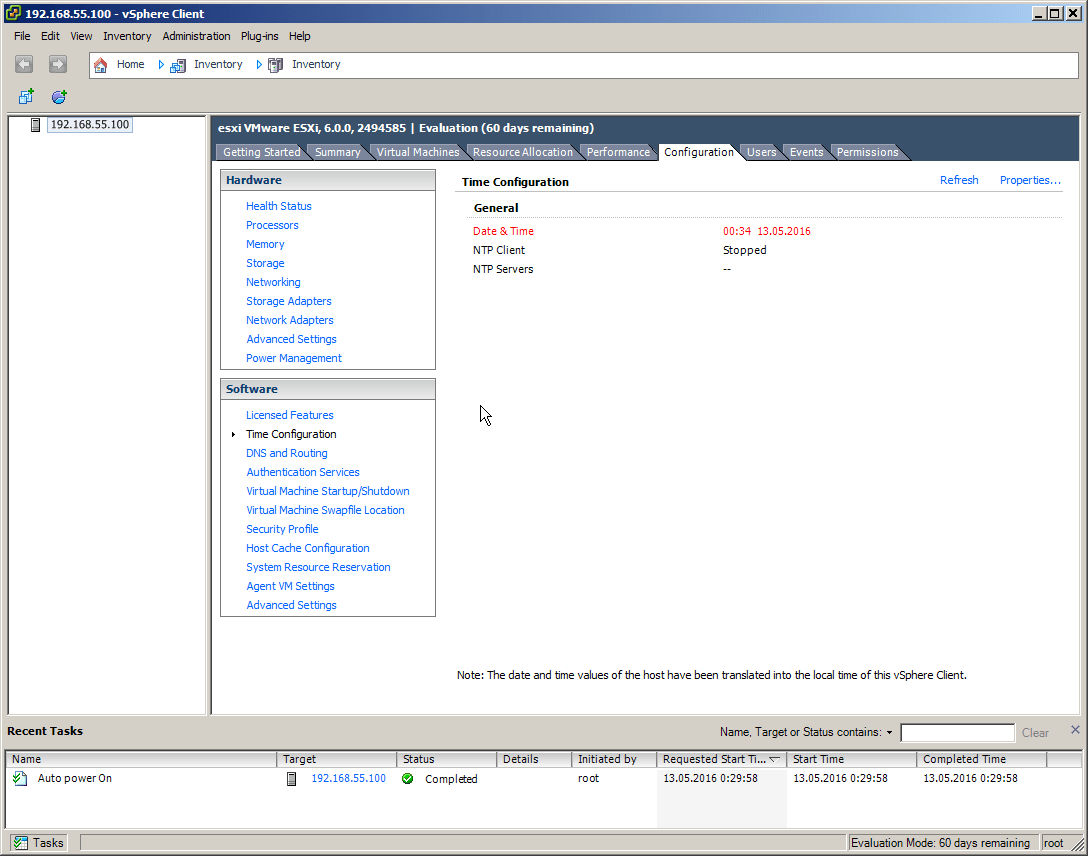

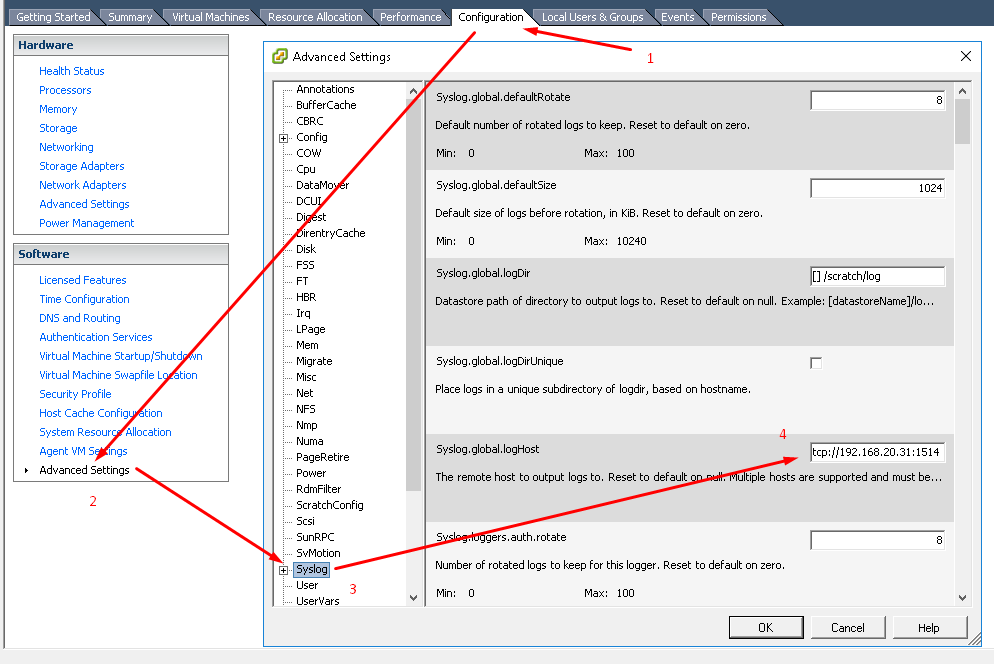

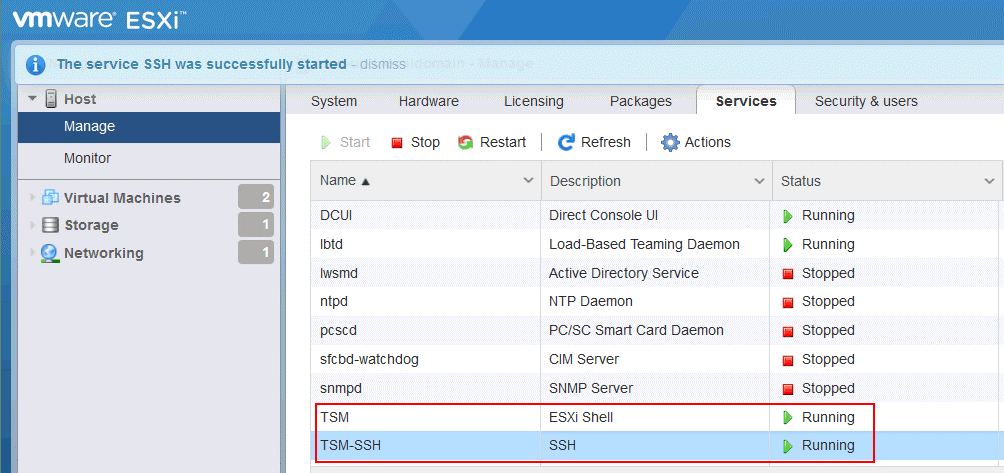

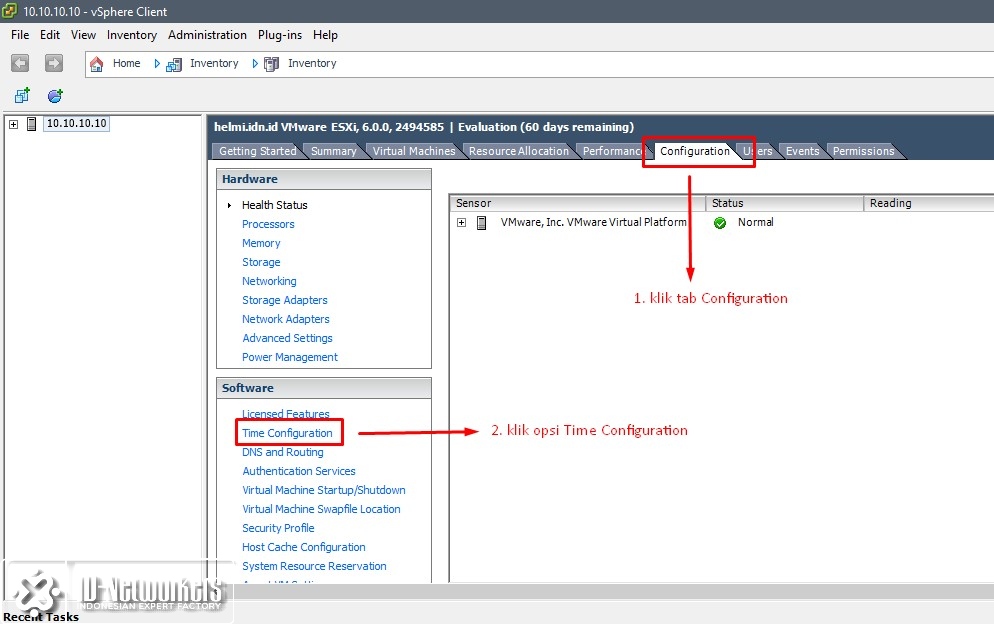

Выберем вкладку Configuration.

Проверим настройки.

Состояние сервера — все нормально.

Процессоры.

Память.

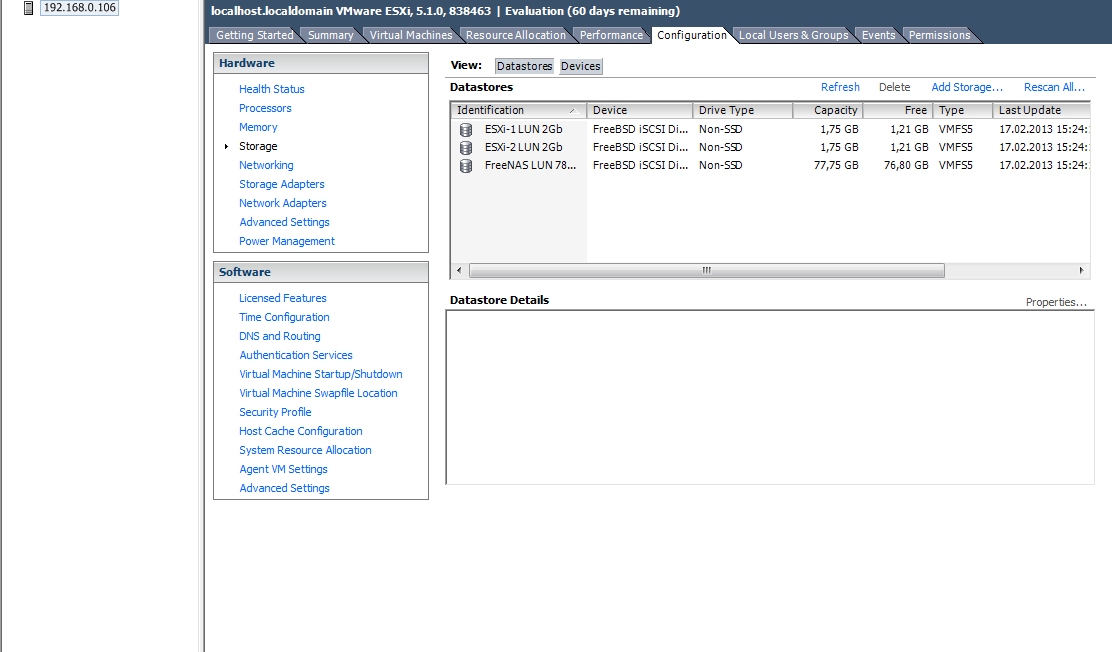

Хранилище.

Сеть, Здесь нужно указать на одну тонкость — подключение виртуальных машин (“VM Network”) и управление самим ESXi-сервером (“Management Network”) идет через виртуальный свитч, который, в свою очередь, подключен к реальной сети. То есть “внутри” ESXi-сервера есть не только виртуальные компьютеры, но и виртуальный свитч. Образно говоря, сетевые интерфейсы ESXi-сервера можно считать “наружными” портами виртуального свитча. Именно поэтому, после несложных настроек, можно включать в одну сеть несколько сетевых интерфейсов от одного ESXi-сервера.

Именно поэтому, после несложных настроек, можно включать в одну сеть несколько сетевых интерфейсов от одного ESXi-сервера.

“Лицензирование”. Все функции включены. Длительность действия — 60 дней. До окончания указанного срока необходимо установить новый лицензионный ключ. Максимальная функциональность включена в лицензии Enterprise Plus. Если ключ есть в данный момент, то его можно ввести сейчас, не дожидаясь окончания 60-и дневного срока.

“Time configuration”. Достаточно простой диалог для настройки службы времени. Нужно установить с точностью несколько минут текущее время, ввести хотя бы один адрес NTP, затем запустить сервис.

Сервис NTP успешно запущен.

Основные настройки необходимые для работы ESXi-cервера сделаны. Клиент для управления установлен. Можно переходить к созданию виртуальной инфраструктуры.

Смотрите также:

- Создание виртуальной машины в гипервизоре VmWare ESXi версии 4.

1

1Развертывание виртуальной инфраструктуры любой сложности начинается с такого шага, как создание виртуальной машины. В качестве примера сделаем виртуальную машину под установку WinXP в достаточно простой конфигурации — один процессор, 512…

- Миграция гипервизора ESXi с версии 4.1 на версию 5.1

В данной статье будет рассматриваться пошаговая миграция гипервизора VmWare ESXi версии 4.1 на версию 5.1. Необходимость такого действия может быть вызвана желанием использовать новые возможности гипервизора, появившиеся в версии 5.1.…

- Установка гипервизора VMware Workstation 10

Ошибки в работе системы, её сбой, внедрение вирусов и шпионского ПО – всего этого и прочих неприятностей в работе с компьютером можно избежать, если обучаться и вести эксперименты со сторонним…

Install, Configure, Manage v6.7 в Екатеринбурге

Модуль 1. Введение.

Модуль 2. Программный Центр Обработки Данных.

· Описание Программного Центра Обработки Данных.

· Описание ВМ.

· Общие ресурсы гипервизора ESXi.

· Централизованное управление: Описание vCenter Server.

· Лабораторная работа 1: Установка ESXi

· Лабораторная работа 2: Настройка хоста ESXi

Модуль 3. Создание ВМ.

· Введение в ВМ.

· Создание ВМ.

· Лабораторная работа 3: Разворачивание и настройка виртуальной машины

Модуль 4. VMware vCenter Server.

· Описание архитектуры vCenter Server.

· Установка, создание резервной копии и восстановление vCenter Server Appliance.

· Использование vSphere клиентов.

· Управление инфраструктурой объектов vCenter.

· Роли и полномочия vCenter Server для управления инфраструктурой.

· Лабораторная работа 4: Работа с vCenter Server

· Лабораторная работа 5: Навигация с помощью vSphere Clients

· Лабораторная работа 6: Создание папок в vCenter Server Appliance

Модуль 5. Настройка и управление виртуальными сетями.

Настройка и управление виртуальными сетями.

· Использование стандартных виртуальных коммутаторов.

· Настройки политик стандартных виртуальных коммутаторов.

· Лабораторная работа 7: Использование стандартных коммутаторов

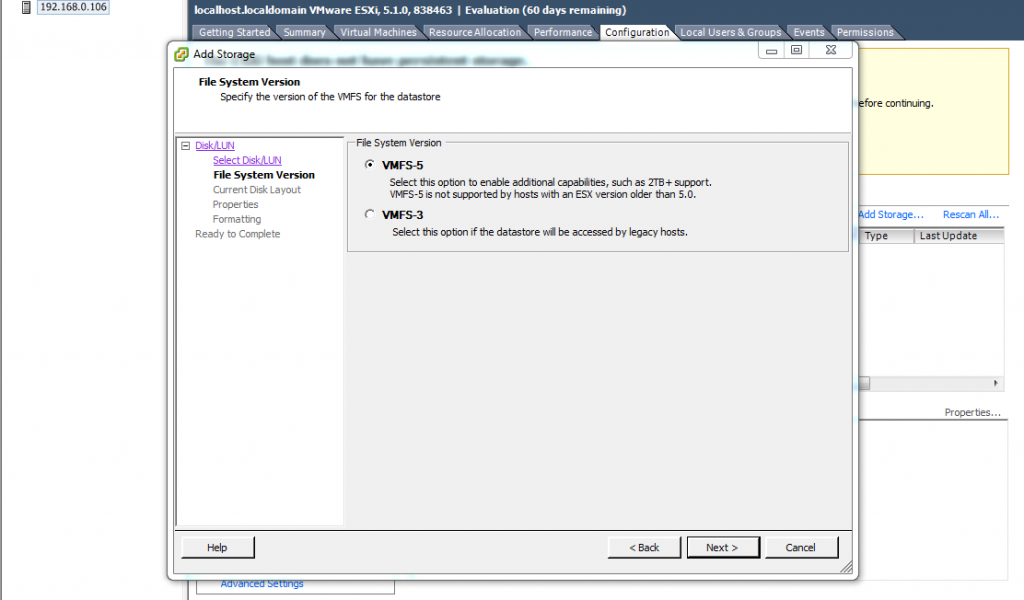

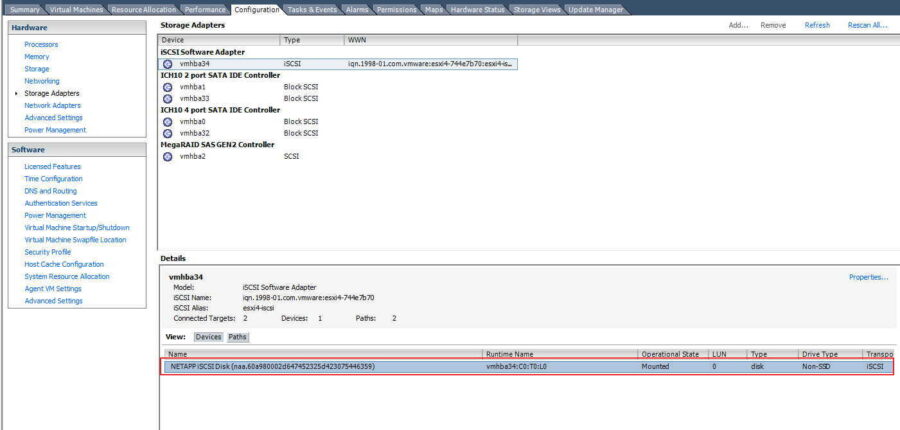

Модуль 6. Настройка и управление виртуальными системами храненения.

· Варианты СХД.

· Хранилища Fiber Channel (FC).

· Настройка iSCSI хранилищ.

· Использование хранилищ VMFS.

· Настройка NFS хранилищ.

· Хранилище Virtual SAN.

· Лабораторная работа 8: Доступ к iSCSI Storage

· Лабораторная работа 9: Управление VMFS Datastores

· Лабораторная работа 10: Доступ к NFS Storage

Модуль 7. Управление виртуальными машинами

· Создание шаблонов и клонирование виртуальных машин.

· Работа с библиотеками контента.

· Изменение параметров виртуальной машины.

· Миграция виртуальных машин.

· Создание моментальных снимков виртуальной машины.

· Лабораторная работа 11: Использование шаблонов и клонов

· Лабораторная работа 12: Модификация виртуальных машин

· Лабораторная работа 13: Миграция виртуальных машин

· Лабораторная работа 14: Управление виртуальными машинами

Модуль 8. Управление ресурсами и мониторинг.

· Концепции виртуальных процессоров и памяти

· Управление ресурсами и использование пулов ресурсов.

· Создание vApp.

· Мониторинг использования ресурсов.

· Применение сигналов.

· Лабораторная работа 15: Управление пулами ресурсов

· Лабораторная работа 16: Управление vApps

· Лабораторная работа 17: Мониторинг производительности виртуальных машин

· Лабораторная работа 18: Использование сигналов

Модуль 9. vSphere HA и Fault Tolerance, защита данных

vSphere HA и Fault Tolerance, защита данных

· Введение в технологии высокой доступности vSphere HA.

· Архитектура vSphere HA.

· Настройка vSphere HA.

· Введение в технологии Fault Tolerance (FT).

· vSphere Replication и vSphere Data Protection.

· Лабораторная работа 19: Использование vSphere HA

Модуль 10. vSphere Distributed Resource Scheduler (DRS).

· Архитектура vSphere DRS и ее настройка

· Лабораторная работа 20: Настройка vSphere DRS Cluster

Модуль 11. vSphere Update Manager.

· Управление изменениями на гипервизоре, оценка установленных патчей и обновлений на системе гипервизоров

· Лабораторная работа 21: Использование vSphere Update Manager

VMware vSphere: Install, Configure, Manage

VMWare vSphere

Установка, настройка, управление самый популярный курс VMware. Он представляет собой интенсивный практический тренинг, сфокусированный на установке, настройке и управлении VMware vSphere, которая включает VMware ESXi и VMware vCenter Server. Данный курс формирует комплексное понимание администрирования инфраструктуры vSphere для организаций любого размера. Прохождение данного курса подготовит слушателей к продвинутым курсам по vSphere.

Он представляет собой интенсивный практический тренинг, сфокусированный на установке, настройке и управлении VMware vSphere, которая включает VMware ESXi и VMware vCenter Server. Данный курс формирует комплексное понимание администрирования инфраструктуры vSphere для организаций любого размера. Прохождение данного курса подготовит слушателей к продвинутым курсам по vSphere.

Профиль аудитории

Курс ориентирован на администраторов, инженеров, ИТ-специалистов, работающих или планирующих работу с VMware vSphere.

По окончанию курса слушатели смогут:

- Описать программно-определяемый центр обработки данных (ЦОД)

- Развернуть хост ESXi и создать виртуальные машины

- Описать архитектуру vCenter Server

- Развернуть экземпляр vCenter Server или vCenter Server Appliance

- Использовать vCenter Server для управления хостом ESXi

- Настраивать и управлять инфраструктурой vSphere через VMware vSphere Client и VMware

- vSphere Web Client

- Настраивать виртуальные сети при помощи стандартных коммутаторов vSphere (Standard switches)

- Использовать vCenter Server для управления различными типами хранилища хоста

- Управлять виртуальными машинами, шаблонами, клонами и моментальными снимками

- Создавать vApp

- Описать и использовать библиотеки контента (Content library)

- Мигрировать виртуальные машины при помощи VMware vMotion

- Использовать VMware vSphere Storage vMotion для миграции хранилища виртуальных машин

- Вести мониторинг использования ресурсов и управлять пулами ресурсов

- Использовать VMware vRealize Operations Manager для поиска и устранения ошибок, через аналитику и предупреждения

- Управлять высокой доступностью VMware vSphere High Availability и VMware vSphere Fault Tolerance

- Использовать VMware vSphere Replication и VMware vSphere Data Protection для репликации виртуальных машин и восстановления данных

- Использовать кластера VMware vSphere Distributed Resource Scheduler (DRS) для улучшения масштабируемости хоста

- Использовать распределенные коммутаторы (Distributed switches) для улучшения масштабируемости сети

- Использовать VMware vSphere Update Manager для применения обновлений

- Выполнять базовое устранение неисправностей хостов ESXi, виртуальных машин и действий vCenter Server

Сертификационные экзамены

Нет

Программы сертификации

Нет

Модуль 1. Обзор курса

Обзор курса

- Введение в курс

- Введение и порядок изучения курса

- Цели курса

Модуль 2. Программно-определяемый центр обработки данных

- Программно-определяемый центр обработки данных

- Введение в программно-определяемый центр обработки данных

- Что нового в версии vSphere 6.5 — краткий обзор*

- vSphere Clients

- Лабораторная работа 1: Работа с VMware vSphere Clients

- Обзор ESXi

- Лабораторная работа 2: Настройка хостов ESXi

Модуль 3. Создание виртуальных машин

- Концепция виртуальных машин

- Создание виртуальных машин

- Лабораторная работа 3: Работа с виртуальными машинами

Модуль 4. vCenter Server

- Архитектура vCenter Server

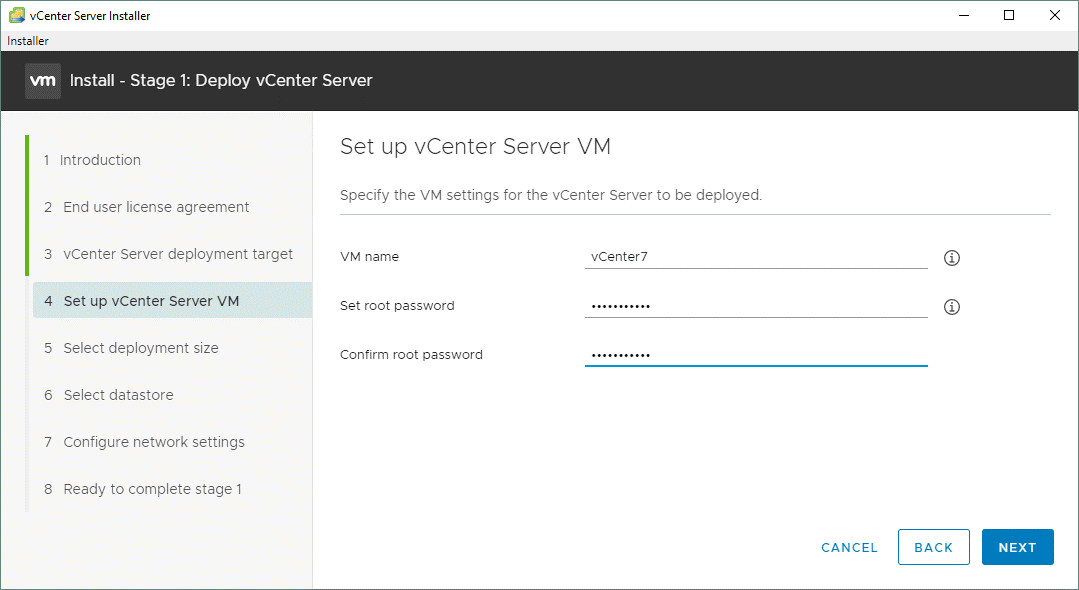

- Развертывание vCenter Server Appliance

- Лабораторная работа 4: Работа с vCenter Server

- vSphere Web Client

- Лабораторная работа 5: Использование vSphere Web Client

- Управление инвентаризацией vCenter Server

- Лабораторная работа 6: Создание папок в vCenter Server Appliance

Модуль 5. Создание и настройка виртуальных сетей

Создание и настройка виртуальных сетей

- Введение в vSphere Standard Switches

- Настройка политик стандартных коммутаторов

- Лабораторная работа 7: Использование стандартных коммутаторов

- Введение в распределенные коммутаторы (Distributed switches)

- Лабораторная работа 8: Использование распределенных коммутаторов

Модуль 6. Настройка и управление виртуальными хранилищами

- Концепция хранилищ

- Хранилища iSCSI

- Лабораторная работа 9: Настройка доступа к хранилищу iSCSI

- Хранилища NFS

- Лабораторная работа 10: Настройка доступа к хранилищу NFS

- Хранилища VMFS

- Лабораторная работа 11: Управление хранилищами VMFS

- Хранилища Virtual SAN

- Виртуальные тома

Модуль 7. Управление виртуальными машинами

- Создание шаблонов и клонов

- Лабораторная работа 12: Использование шаблонов и клонов

- Изменение виртуальных машин

- Лабораторная работа 13: Изменение виртуальных машин

- Миграция виртуальных машин

- Лабораторная работа 14: Миграция виртуальных машин

- Создание моментальных снимков виртуальных машин

- Лабораторная работа 15: Управление виртуальными машинами

- Создание vApp

- Лабораторная работа 16: vApps

- Работа с библиотеками контента

Модуль 8. Управление и мониторинг ресурсов

Управление и мониторинг ресурсов

- Концепция виртуальных процессоров и памяти

- Контроль использования ресурсов и пулы ресурсов

- Лабораторная работа 17: Управление пулами ресурсов

- Мониторинг использования ресурсов

- Лабораторная работа 18: Мониторинг производительности виртуальных машин

- Использование предупреждений

- Лабораторная работа 19: Использование предупреждений

- vRealize Operations Manager

- Лабораторная работа 20 (Опционально): Использование vRealize Operations Manager

Модуль 9. vSphere High Availability и vSphere Fault Tolerance

- Введение в vSphere HA

- Архитектура vSphere HA

- Настройка vSphere HA

- Лабораторная работа 21: Использование vSphere HA

- Введение в vSphere Fault Tolerance

- vSphere Replication и vSphere Data Protection

Модуль 10. Масштабирование хоста

- Кластер vSphere DRS

- Лабораторная работа 22: Внедрение кластера vSphere DRS

Модуль 11. vSphere Update Manager и обслуживание хоста

vSphere Update Manager и обслуживание хоста

- Введение в vSphere Update Manager и управление обновлениями

- Лабораторная работа 22: Использование vSphere Update Manager

- Профили хостов

Модуль 12. Установка компонентов VMware

- Установка ESXi

- Установка vCenter Server

* Более подробное описание новых технологий и изменений vSphere 6.5 включено в каждый из последующих модулей.

- Опыт системного администрирования ОС Windows Server

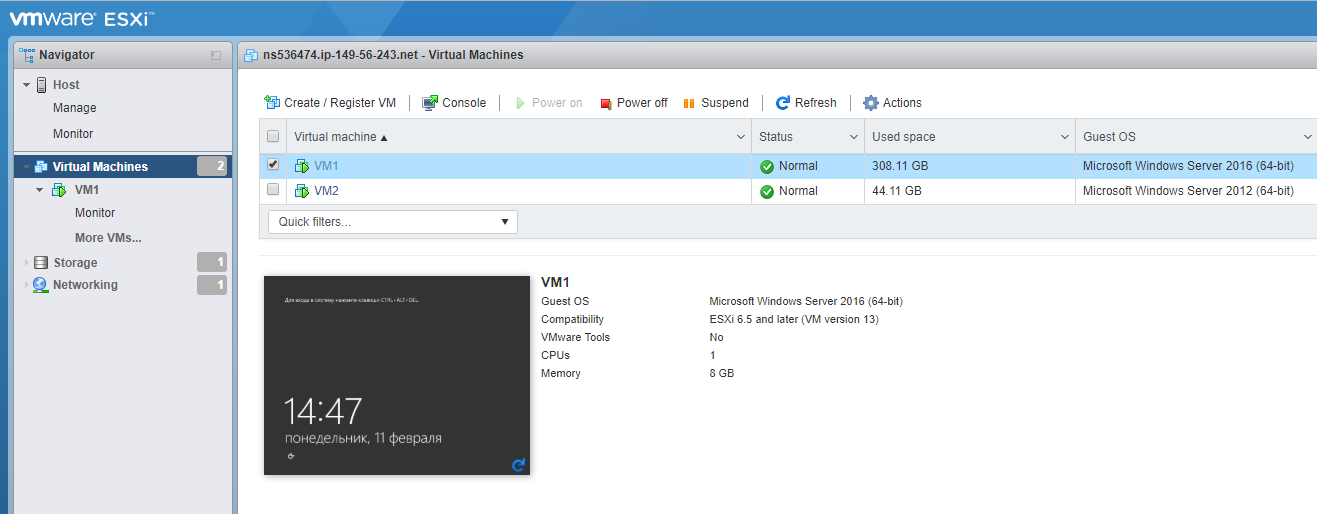

Как развернуть виртуальные локальные сети с помощью VMware ESXi 6.5 — статьи

Развертывание нескольких виртуальных локальных сетей позволяет создавать отдельные частные сети, по которым могут взаимодействовать только виртуальные машины, подключенные к этой сети. VMware ESXi 6.5 дает сетевым администраторам свободу и гибкость в настройке сети, которая лучше всего подходит для их уникальных вариантов использования. Эта статья научит вас всему, что вам нужно знать о подключении виртуальных машин к частной сети на выделенном сервере с помощью OVHcloud.

Предварительные требования

- Выделенный сервер OVHcloud с VMware ESXi 6.5

Темы

Настройка VLAN в VMware ESXi 6.5

VMware ESXi 6.5 будет обрабатывать всю маршрутизацию трафика для любых виртуальных машин на своем хосте. Поэтому сначала нам нужно настроить сеть в ESXi для маршрутизации трафика через выбранные VLAN. Для этого войдите в систему на своем хосте ESXi и выберите Networking на левой боковой панели. По умолчанию вы попадете на вкладку Группы портов .

На этой вкладке нажмите кнопку Добавить группу портов .Выберите имя для своей группы портов и действительный идентификатор VLAN, по которому вы хотите маршрутизировать трафик.

Примечание: Действительный идентификатор VLAN должен быть от 2 до 4000.

Нажмите кнопку Добавить , когда закончите, и ваша новая группа портов будет выбрана. На этом завершается все сетевое взаимодействие, необходимое ESXi для маршрутизации трафика виртуальных машин через VLAN. Тем не менее, нам все еще нужно изменить определенные настройки на наших виртуальных машинах, чтобы гарантировать, что сетевые адаптеры назначены нашим новым группам портов.

На этом завершается все сетевое взаимодействие, необходимое ESXi для маршрутизации трафика виртуальных машин через VLAN. Тем не менее, нам все еще нужно изменить определенные настройки на наших виртуальных машинах, чтобы гарантировать, что сетевые адаптеры назначены нашим новым группам портов.

Примечание: В этом примере мы предполагаем, что мы изменяем настройки на уже существующей виртуальной машине. Однако эти же настройки можно изменить во время создания виртуальной машины в ESXi.

Сначала щелкните вкладку Virtual Machines на левой боковой панели.

Щелкните нужную виртуальную машину.

Примечание: Чтобы внести следующие изменения в вашу виртуальную машину, она должна быть выключена.

Нажмите кнопку Edit , чтобы получить доступ к настройкам виртуальной машины.

Чтобы направить наш тегированный трафик VLAN, нам нужно добавить еще один сетевой адаптер к виртуальной машине. Для этого нажмите кнопку Добавить сетевой адаптер , появится вторая сетевая карта. Убедитесь, что новый сетевой адаптер помещен в группу портов, созданную вами ранее в этом руководстве.

Для этого нажмите кнопку Добавить сетевой адаптер , появится вторая сетевая карта. Убедитесь, что новый сетевой адаптер помещен в группу портов, созданную вами ранее в этом руководстве.

Теперь вы закончили настройку сети, которая вам нужна в ESXi. Примеры настройки сети на виртуальных машинах под управлением Ubuntu 18.04 или Windows Server 2016 см. В следующих двух разделах.Если вы используете другую операционную систему, требуемые настройки будут другими.

Настройка сети в Ubuntu 18.04

Последний шаг в настройке сети для трафика с тегами VLAN — назначить сетевой карте частный IP-адрес, который будет использоваться для маршрутизации трафика. Для этого сначала войдите на свой сервер через SSH или встроенную консоль ESXi. Затем введите следующую команду, чтобы найти имя вашего второго интерфейса.

$ ip добавить

Примечание. По умолчанию ESXi назначает имя ens192 второй сетевой карте, если вы используете адаптер VMXNET3. Если вы не используете адаптер по умолчанию, это будет второй интерфейс в списке.

Если вы не используете адаптер по умолчанию, это будет второй интерфейс в списке.

Мы настроим сетевой адаптер, который еще не настроен для общедоступной сети (тот, которому не назначен IP-адрес). Для этого откройте файл конфигурации Netplan в любом текстовом редакторе, используя следующую команду:

$ sudo vi /etc/netplan/01-netcfg.yaml

Попав в файл, отредактируйте его, чтобы он выглядел следующим образом. Если вы уже настроили общедоступный сетевой адаптер, создайте запись для частного сетевого адаптера непосредственно под общедоступным.Не удаляйте общедоступную сетевую карту из файла.

# Этот файл описывает сетевые интерфейсы, доступные в вашей системе.

# Для получения дополнительной информации см. Netplan (5).

сеть:

версия: 2

средство визуализации: networkd

ethernets:

ens192:

dhcp4: нет

адреса: [192.168.0.1/24]

Примечание: Вы можете использовать любой частный IP-адрес по вашему выбору. Обозначение CIDR будет определять подсеть, в которой различные IP-адреса могут связываться друг с другом.Все IP-адреса в VLAN должны находиться в одной подсети.

Обозначение CIDR будет определять подсеть, в которой различные IP-адреса могут связываться друг с другом.Все IP-адреса в VLAN должны находиться в одной подсети.

Сохраните файл и выйдите из него, а затем примените изменения, используя следующую команду:

$ применить sudo netplan

Это применит изменения, внесенные в файл конфигурации Netplan. Это завершает сетевое соединение, необходимое виртуальной машине Ubuntu 18.04 для отправки трафика с тегами VLAN. Далее мы рассмотрим, как выполнять те же действия в Windows Server 2016.

Настройка сети в Windows Server 2016

Примечание: Для того, чтобы Windows могла передавать любой трафик на другие устройства, необходимо убедиться, что он доступен для обнаружения другими устройствами.При настройке сети убедитесь, что она помечена как «Общедоступная», чтобы другие компьютеры в той же сети могли ее обнаружить.

Если вы используете Windows Server 2016, вам необходимо настроить интерфейс Ethernet1 с частным IP-адресом для маршрутизации трафика с тегами VLAN. Для этого войдите в свою виртуальную машину Windows, а затем войдите в диспетчер сервера. Нажмите Local Server на левой боковой панели, а затем нажмите кнопку IPv4, назначенную DHCP, кнопку с включенным IPv6 рядом с Ethernet1.

Для этого войдите в свою виртуальную машину Windows, а затем войдите в диспетчер сервера. Нажмите Local Server на левой боковой панели, а затем нажмите кнопку IPv4, назначенную DHCP, кнопку с включенным IPv6 рядом с Ethernet1.

Теперь щелкните правой кнопкой мыши адаптер Ethernet1 и выберите Свойства из раскрывающегося меню.

Дважды щелкните кнопку Internet Protocol Version 4 (TCP / IPv4) .

Щелкните маркер рядом с «Использовать следующий IP-адрес» и введите частный IP-адрес и маску подсети. Когда закончите, нажмите OK .

Примечание. Помните, что все частные IP-адреса, обменивающиеся данными через VLAN, должны находиться в одной подсети.Определите маску подсети в соответствии с вашими потребностями.

Заключение

Использование VMware ESXi для настройки сети через VLAN может значительно повысить безопасность данных. В этом руководстве вы узнали, как настроить группы портов ESXi и сетевые адаптеры, а также настроить сетевые адаптеры на отдельных виртуальных машинах. Мы настоятельно рекомендуем вам воспользоваться этой замечательной технологией для оптимизации производительности и безопасности вашей сети.

В этом руководстве вы узнали, как настроить группы портов ESXi и сетевые адаптеры, а также настроить сетевые адаптеры на отдельных виртуальных машинах. Мы настоятельно рекомендуем вам воспользоваться этой замечательной технологией для оптимизации производительности и безопасности вашей сети.

XClarity Administrator — Шаг 6. Установите и настройте виртуальное устройство Lenovo XClarity Administrator (ESXi с использованием VMware vSphere)

Установите и настройте виртуальное устройство XClarity Administrator на только что установленном хосте ESXi

с помощью мастера развертывания VMware vSphere.

Чтобы установить виртуальное устройство XClarity Administrator, выполните следующие действия.

(Дополнительно) Использование конфигурации

файл для установки настроек IP

Если вы

без использования DHCP-сервера, вы можете дополнительно использовать файл конфигурации

, чтобы указать параметры IP, которые вы хотите использовать для доступа к веб-интерфейсу XClarity Administrator с помощью сетевого интерфейса Eth0.

Файл конфигурации (eth0_config) содержится в файле ISO, который вы создаете и подключаете к виртуальному

машины перед первым запуском XClarity Administrator.Когда XClarity Administrator запускается в первый раз, он настраивает IP-адрес для

сеть Eth0, использующая статический IP-адрес, определенный в файле eth0_config, и отображает веб-интерфейс для установки

вверх и настройте соответствующие параметры (см. Настройка Lenovo XClarity Administrator).

Ограничение: Только

сеть Eth0 может быть настроена с помощью этого метода. Создание конфигурации

файл с именем eth2_config не настраивает

Сеть Eth2.

Для использования конфигурации

файла, выполните следующие действия перед включением виртуального устройства

Создайте файл с именем eth0_config (без расширения файла), который содержит следующие параметры IPv4

который вы хотите, чтобы виртуальная машина использовала при запуске.- IPV4_ADDR =

- IPV4_NETMASK =

- IPV4_GATEWAY =

- IPV6_ADDR =

- IPV6_GATEWAY =

Вы можете использовать команду echo для создания файла, например:

ECHO IPV4_ADDR = 1. 1.1.1> ./eth0_config

ECHO IPV4_NETMASK = 255.255.255.05 >> ./eth0_config

ECHO IPV4_GATEWAY = 1.1.1.5 >> ./eth0_config

ECHO IPV6_ADDR = 1001: 1002: 1003: 1004 :: 2 >> ./eth0_config

ECHO IPV6_GATEWAY = 1001: 1002: 1003: 1004 :: 1 >> ./eth0_config

1.1.1> ./eth0_config

ECHO IPV4_NETMASK = 255.255.255.05 >> ./eth0_config

ECHO IPV4_GATEWAY = 1.1.1.5 >> ./eth0_config

ECHO IPV6_ADDR = 1001: 1002: 1003: 1004 :: 2 >> ./eth0_config

ECHO IPV6_GATEWAY = 1001: 1002: 1003: 1004 :: 1 >> ./eth0_config Примечание. Поддерживаются параметры IPV6_ADDR и IPV6_GATEWAY.

в XClarity Administrator v1.1.1 и новее.Создайте ISO-образ, содержащий файл eth0_config.

Чтобы создать ISO-образ в Windows,

используйте ваше любимое программное обеспечение ISO. В Linux используйте команду mkisofs, например:mkisofs -V IP4ADDR -J -o ./boot.iso ./eth0_configгде -V — метка тома, -J — формат Joliet, -o — имя выходного файла,

и ./eth0_config — это файл, который нужно включить в

ISO образ.Загрузите ISO-образ в подходящее место

с помощью Datastore Browser.Подключите образ .ISO к виртуальной машине.

Файл ISO должен

Файл ISO должен

находятся в хранилище данных хоста ESXi, чтобы его можно было смонтировать как привод CD / DVD на виртуальной машине XClarity Administrator.- Щелкните виртуальную машину правой кнопкой мыши и выберите Изменить параметры.

- Щелкните Добавить, чтобы отобразить Добавить

Мастер оборудования. - Щелкните CD / DVD Drive, затем щелкните Next.

- Выберите «Использовать ISO-образ» и нажмите «Далее».

- Выберите образ ISO и нажмите Далее.

- Выберите узел виртуального устройства и нажмите Далее.

- Нажмите Готово.

Примечание. Вы можете отключить диск и удалить образ ISO после

вы входите в веб-интерфейс XClarity Administrator и завершаете настройку соответствующих параметров.

Что делать дальше

Войдите в систему и настройте XClarity Administrator (см. Доступ к веб-интерфейсу Lenovo XClarity Administrator в первый раз и Настройка Lenovo XClarity Administrator).

vSphere Основы сетевых технологий — Часть 1

В этой серии статей я обсуждаю некоторые сетевые аспекты vSphere, с которыми вы, вероятно, сталкивались при использовании программного обеспечения VMware. В этой первой части я буду говорить в основном о стандартном коммутаторе vSphere (vSS) в контексте его установки и настройки на автономном хосте ESXi (не управляемом vCenter Server). Я также рассмотрю адаптеры VMkernel, группы портов и некоторые стандартные настройки коммутатора.

Во второй части я представлю еще один тип виртуального коммутатора, называемый vSphere Distributed Switch, который доступен только на одном установленном сервере vCenter.

Стандартный коммутатор vSphere

Виртуальный коммутатор vSphere позволяет нескольким подключенным к нему виртуальным машинам обмениваться данными друг с другом, почти так же, как их физические аналоги при подключении к физическому коммутатору. Кроме того, vSS соединяет виртуальные сети с физическими, используя сетевые карты хоста ESXi, на которых был создан vSS, в качестве портов восходящей связи с физическим коммутатором.

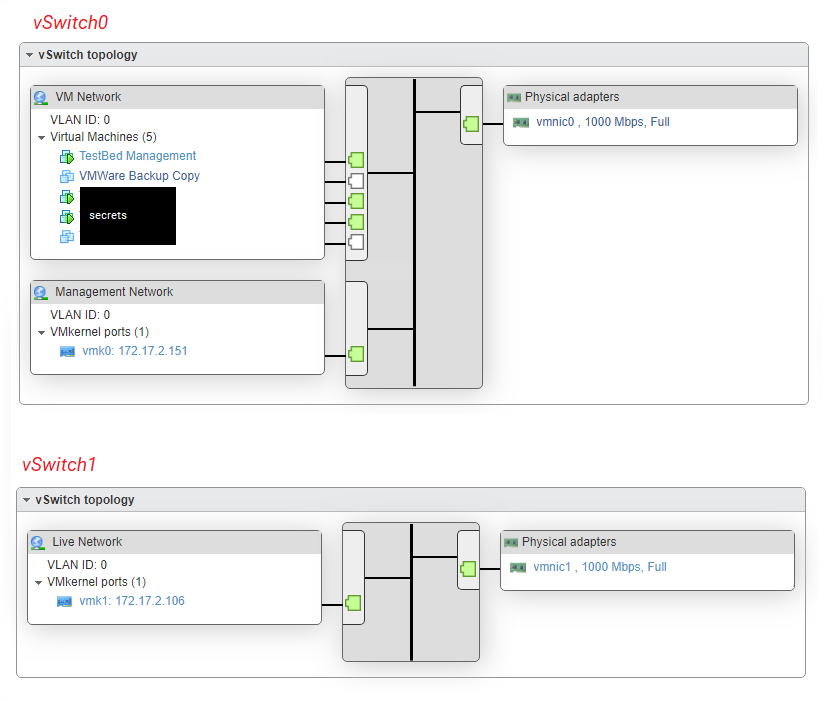

По умолчанию стандартный коммутатор создается автоматически при установке ESXi.Это обозначено как vSwitch0 , как показано на рисунке 1.

Примечание : Порт восходящей связи — это просто назначенный порт на сетевом устройстве, таком как коммутатор или маршрутизатор, который соединяет или каскадно соединяет одно сетевое оборудование с другим. На рисунке 1 показано, как два физических адаптера — помеченных 3 — на хосте ESXi, настроенном для этого поста, были назначены портами восходящей связи.

Рисунок 1. vSwitch0 автоматически создается при установке ESXi.

Присмотревшись к рисунку 1, вы также должны заметить заголовки Группа портов виртуальной машины и Порт VMkernel , обозначенные цифрами 1 и 2 соответственно.Я объясню, что они означают, в следующих разделах.

Группы портов

Группа портов, как следует из названия, представляет собой группу портов коммутатора. Применяя сетевую политику к группе портов, можно обеспечить соблюдение правил безопасности и формирования трафика. Кроме того, если на ваших физических коммутаторах настроены VLAN, вы можете назначить идентификатор VLAN для группы портов, чтобы любая виртуальная машина на ней во всех смыслах и целях находилась в этой конкретной VLAN.

Применяя сетевую политику к группе портов, можно обеспечить соблюдение правил безопасности и формирования трафика. Кроме того, если на ваших физических коммутаторах настроены VLAN, вы можете назначить идентификатор VLAN для группы портов, чтобы любая виртуальная машина на ней во всех смыслах и целях находилась в этой конкретной VLAN.

Когда вы создаете сетевую виртуальную машину, вы фактически подключаете ее виртуальные адаптеры к одной или нескольким группам портов.Рисунок 2 иллюстрирует этот аспект. Свойства виртуальной машины, включая выбранную группу портов, показаны в левой части рисунка 2, а настройки коммутатора, в которых определены группы портов, показаны справа. В этом случае я создал два стандартных коммутатора vSphere, каждый из которых имеет отдельную группу портов. Обратите внимание на то, что каждый коммутатор имеет свой собственный выделенный канал связи (vmnic0 и vmnic1).

СОВЕТ : Если есть необходимость изолировать одну или несколько виртуальных машин от остальной части сети, будь то физическая или виртуальная, вы можете просто создать стандартный коммутатор без указанных физических адаптеров (восходящих каналов). Любая виртуальная машина, размещенная в группе портов, связанной с коммутатором, по-прежнему сможет взаимодействовать с любой другой виртуальной машиной в той же группе портов, но будет полностью отключена от других сетей. Такая установка пригодится всякий раз, когда вам нужно реплицировать, скажем, живую среду в соответствии с той же адресацией уровня 3 (IPv4 / 6), но без воздействия на какие-либо производственные системы.

Любая виртуальная машина, размещенная в группе портов, связанной с коммутатором, по-прежнему сможет взаимодействовать с любой другой виртуальной машиной в той же группе портов, но будет полностью отключена от других сетей. Такая установка пригодится всякий раз, когда вам нужно реплицировать, скажем, живую среду в соответствии с той же адресацией уровня 3 (IPv4 / 6), но без воздействия на какие-либо производственные системы.

Рисунок 2 — Назначение виртуальной машины группе портов (слева) и группам портов, созданным на стандартном коммутаторе (справа).

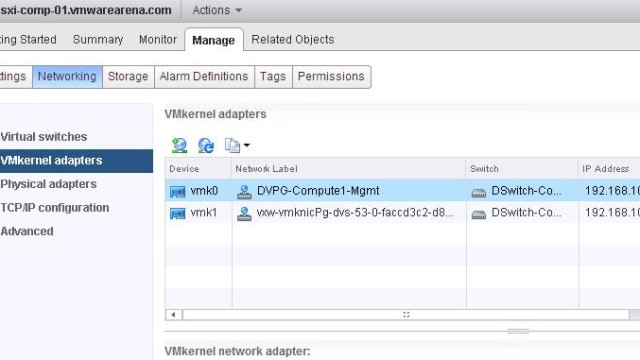

VMkernel

Сетевой интерфейс, адаптер или порт VMkernel — это в основном поставщик услуг, используемый хостом ESXi для связи с внешним миром и остальной частью инфраструктуры на основе VMware.Адаптеры VMkernel создаются в соответствии с типом служб, требуемых vMotion, Fault Tolerance, Management или, возможно, vSAN. Список служб, требующих VMkernel, изображен в разделе Services на рисунках 3 и 4. VMkernel назначается IP-адрес, используя DHCP или тот, который назначается вручную, причем последний вариант, на мой взгляд, является наиболее разумным. .

VMkernel назначается IP-адрес, используя DHCP или тот, который назначается вручную, причем последний вариант, на мой взгляд, является наиболее разумным. .

По умолчанию vmk0 — это первый созданный адаптер VMkernel, который включен для трафика управления.Интересно, что вы все равно сможете подключиться к ESXi, если флажок Management установлен.

Рисунок 3. Использование хост-клиента VMware на ESXi 6U2 для управления VMkernel.

Рисунок 4. Использование клиента C # vSphere для управления VMkernel.

После создания VMkernel вы столкнетесь с чем-то похожим на группу портов, но не совсем. Это, по сути, порт. В зависимости от инструмента, использованного для его создания, все может немного запутаться.Например, при использовании клиента C # vSphere вам будет простительно думать, что VMkernel на самом деле является группой портов, поскольку для обоих используется один и тот же значок (рисунок 5).

Рисунок 5. Свойства VMkernel с точки зрения клиента C # vSphere

Максимальные сети vSphere

Прежде чем продолжить, я собираюсь перечислить несколько максимумов vSphere 6. 0, относящихся к стандартным коммутаторам. Вы найдете полный список здесь.

0, относящихся к стандартным коммутаторам. Вы найдете полный список здесь.

- 512- Группы портов на стандартный коммутатор.

- 1016 — Максимальное количество активных портов на хост.

- 4096 — Общее количество портов коммутатора виртуальной сети на хост.

- 4088 — Порты создания виртуального сетевого коммутатора на стандартный коммутатор.

Создание виртуального стандартного коммутатора

Есть несколько способов создать стандартный коммутатор. К ним относятся PowerCLI, ESXCLI, стандартный и веб-клиент vSphere, а также недавно представленный клиент хоста VMware, если вы перешли на ESXi 6.0 обновление 2. Вот краткое изложение.

ESXCLI

Используйте что-то вроде замазки для SSH к хосту ESXi и выполните следующую команду, чтобы создать 24-портовый коммутатор с именем myVSS .

esxcli network vswitch standard add -P = 24 -v = myVSS

esxcli network vswitch стандартное дополнение -P = 24 -v = myVSS |

PowerCLI

Подключитесь к хосту ESXi с помощью командлета Connect-VIServer , а затем выполните следующую команду, чтобы создать тот же коммутатор, что и команда ESXCLI.

Новый-VirtualSwitch -name myVSS3 -NumPorts 24

New-VirtualSwitch -name myVSS3 -NumPorts 24 |

Примечание : Начиная с ESX 5.5, коммутаторы создаются эластичными, что означает отсутствие необходимости указывать количество портов, поскольку они добавляются динамически по мере необходимости. Я включил этот параметр только для полноты картины. Фактически, в случае PowerCLI параметр ports полностью игнорируется.

Толстый клиент vSphere

При использовании клиентов vSphere просто выделите хост ESXi, на котором вы хотите создать коммутатор, перейдите на вкладку Configuration и нажмите Add Networking , как показано на рисунке 6-9. Затем выберите Виртуальная машина (если это не вводит в заблуждение, я не знаю, что это такое), привязав ее к физическому узлу, а также создайте для нее новую группу портов.

Рисунок 6. Добавление нового vSwitch с помощью клиента vSphere

Рисунок 7. Выбор виртуальной машины для создания виртуального коммутатора

Рисунок 8 — Привязка виртуального коммутатора к физическому узлу ESXi (восходящий канал)

Рисунок 9 — Назначение метки группы портов и идентификатора VLAN

Клиент хоста VMware

Если у вас ESX 6.0 U2 (или установили fling), вы также можете использовать клиент хоста VMware для создания стандартного коммутатора. После входа в систему выберите Networking из Navigator и перейдите на вкладку Virtual Switches . Нажмите Добавить стандартный виртуальный коммутатор и введите данные. Это так просто.

Рисунок 10. Использование хост-клиента VMware для создания стандартного коммутатора

Рисунок 11 — Завершение стандартного коммутатора с использованием VMware Host Client

Настройка стандартного коммутатора

В этом разделе я буду использовать клиент C # vSphere и ESXi 6. 0 Настройка U2. Напоминаем, что vSwitch0 создается автоматически в процессе установки ESXi.

0 Настройка U2. Напоминаем, что vSwitch0 создается автоматически в процессе установки ESXi.

Чтобы просмотреть конфигурацию коммутатора, выделите IP-адрес или имя хоста, выберите вкладку Configuration и выберите Networking в разделе Hardware . Щелкните Properties , как показано на рисунке 6.

Рисунок 12 — Просмотр конфигурации настольного коммутатора

На следующем экране вы найдете 2 вкладки, одна называется Порты (вероятно, из-за отсутствия лучшего названия), а другая — Сетевые адаптеры .Я начну с последнего, так как вернусь к нему позже. По сути, здесь вы привяжете физические сетевые карты хоста ESXi к виртуальному коммутатору. Связывание двух или более сетевых карт обеспечит возможность агрегирования каналов и переключения при отказе.

Рисунок 13. Сетевые карты ESX, используемые в качестве восходящих каналов виртуальным коммутатором

На вкладке Порты — что касается vSwitch0 — вы найдете три элемента, созданные автоматически при первой установке ESXi. Это конфигурация vSwitch, группа портов по умолчанию и VMkernel. Вы сможете добавить другие группы портов и ядра VM с помощью кнопки Добавить в нижней части окна свойств vSwitch.

Это конфигурация vSwitch, группа портов по умолчанию и VMkernel. Вы сможете добавить другие группы портов и ядра VM с помощью кнопки Добавить в нижней части окна свойств vSwitch.

Рисунок 14. Просмотр свойств vSwitch, таких как количество портов и размер MTU

Еще раз, все может немного запутаться в зависимости от клиента или метода, используемого для создания и управления сетью. Как показано на рисунке 15, вам нужно выбрать Virtual Machine в качестве типа подключения, если вы хотите создать новую группу портов.

Рисунок 15 — Создание новой группы портов

Чтобы просмотреть настройки виртуального коммутатора, просто нажмите кнопку Изменить . Здесь вы найдете 4 вкладки, относящиеся к сетевой политике коммутатора, содержащие различные параметры и настройки, которые управляют как коммутатором, так и тем, как он обрабатывает трафик. Опять же, в зависимости от используемого инструмента, некоторые параметры могут быть доступны или недоступны. Например, NIC Teaming недоступен при использовании VMware Host Client (по крайней мере, мне не удалось найти его в списке).

Например, NIC Teaming недоступен при использовании VMware Host Client (по крайней мере, мне не удалось найти его в списке).

Рисунок 16. Просмотр параметров vSwitch с помощью хост-клиента VMware — опция объединения сетевых адаптеров

Стандартные настройки и политики коммутатора

Доступ к конфигурации коммутатора можно получить, нажав кнопку Edit , когда выделен элемент конфигурации vSwitch. Откроется окно с ранее упомянутыми вкладками. Имейте в виду, что настройки и параметры, установленные на уровне vSwitch, распространяются на все остальные элементы в списке конфигурации.Тем не менее, опция переопределения доступна для каждого элемента.

Рисунок 17 — Настройки, установленные на уровне vSwitch, распространяются вниз

Давайте рассмотрим настройки / параметры, находящиеся на каждой вкладке.

Общий

Здесь вы устанавливаете необходимое количество портов коммутатора (макс. 4088) и размер MTU (Максимальный блок передачи). Последнее обычно меняется, если в ваших сетях включены кадры jumbo.

4088) и размер MTU (Максимальный блок передачи). Последнее обычно меняется, если в ваших сетях включены кадры jumbo.

Рисунок 18 — Общие настройки vSwitch

Безопасность

На вкладке Security вы найдете 3 параметра, определяющие политику безопасности для коммутатора.

Рисунок 19 — Настройки безопасности для vSwitch

Доступны следующие настройки;

- Promiscuous Mode — Если установлено значение accept, любая виртуальная машина на коммутаторе, имеющая виртуальный адаптер в неразборчивом режиме, сможет подслушивать весь трафик, проходящий через коммутатор.

- Изменения MAC-адреса — Определяет, что происходит при изменении MAC-адреса сетевого адаптера на виртуальной машине. Если установлено значение «Отклонить», весь трафик, исходящий от виртуальной машины, отбрасывается, если предоставленный MAC-адрес не совпадает с адресом, найденным в файле конфигурации виртуальной машины vmx.

- Поддельные передачи — Если установлено отклонение, кадры с поддельными MAC-адресами источника будут отброшены.

Формирование трафика

Политика формирования трафика, если она включена, регулирует полосу пропускания и размер пакета на коммутаторе. Это может пригодиться, если на коммутаторе создано несколько групп портов и вы хотите применить базовый уровень использования трафика для всех групп портов. Опять же, такая политика может быть переопределена, если требуется для каждой группы портов.

Рисунок 20 — Настройки формирования трафика для vSwitch

Объединение сетевых карт, отработка отказа и балансировка нагрузки

Если у вас есть 2 или более физических сетевых адаптеров ESXi, привязанных к виртуальному коммутатору, вы сможете увеличить доступность полосы пропускания с помощью Ether Channel или Link Aggregation Control Protocol (LACP). Для этого может потребоваться знакомство с некоторыми продвинутыми сетевыми концепциями (в зависимости от вашего опыта), которые я не собираюсь здесь обсуждать. Тем не менее, это отличная статья, в которой подробно рассматривается, как настроить ESXi для использования LACP и EtherChannel, реализованных на коммутаторах Cisco и HP.

Для этого может потребоваться знакомство с некоторыми продвинутыми сетевыми концепциями (в зависимости от вашего опыта), которые я не собираюсь здесь обсуждать. Тем не менее, это отличная статья, в которой подробно рассматривается, как настроить ESXi для использования LACP и EtherChannel, реализованных на коммутаторах Cisco и HP.

На вкладке NIC Teaming вы найдете несколько вариантов аварийного переключения. В приведенном ниже примере у меня есть две физические сетевые карты, настроенные как , активные адаптеры . Это гарантирует, что канал связи сохраняется, если какой-либо адаптер отключается. Я также мог бы переместить один адаптер в группу Standby Adapters . Когда вы это сделаете, резервный адаптер станет активным только при выходе из строя всех сетевых адаптеров в группе активных адаптеров .

Рисунок 21 — Настройки vSwitch для объединения и переключения при отказе

Настройка группы портов

Большинство только что описанных настроек одинаково применимы при настройке группы портов, главное отличие состоит в том, что они находятся на вкладке Общие .

Рисунок 22 — Установка имени группы портов и идентификатора VLAN

Параметр Network Label не требует пояснений. Это имя, которое вы назначаете группе портов, и то, что вы видите в списке, когда подключаете виртуальный адаптер виртуальной машины к сети. С другой стороны, настройка VLAN ID немного более интересна, хотя и необязательна. Если у вас есть VLAN, настроенные на ваших физических коммутаторах, ESXi работает 3 различными способами, чтобы учитывать VLAN, а именно:

- Тегирование внешнего коммутатора (EST) — Требуется, когда тегирование пакетов VLAN выполняется на физическом коммутаторе.Сетевые адаптеры хоста ESXi в этом случае подключены к портам доступа на физическом коммутаторе. Идентификатор VLAN должен быть установлен на 0.

- Маркировка виртуального коммутатора (VST) — В отличие от EST, все теги VLAN выполняются виртуальным коммутатором перед тем, как покинуть хост. Сетевые адаптеры хоста должны быть подключены к магистральным портам на физическом коммутаторе.

Группам портов, подключенным к виртуальному коммутатору, назначается идентификатор VLAN от 1 до 4094.

Группам портов, подключенным к виртуальному коммутатору, назначается идентификатор VLAN от 1 до 4094.

- Маркировка виртуального гостя (VGT) — С VGT все теги VLAN выполняется виртуальной машиной.Теги VLAN сохраняются между сетевым стеком виртуальной машины и внешним коммутатором, когда кадры проходят к виртуальным коммутаторам и от них. Сетевые адаптеры хоста должны быть подключены к магистральным портам на физическом коммутаторе. Для стандартного коммутатора идентификатор VLAN для групп портов с VGT должен иметь значение 4095.

Настройка VMkernel

Существует 2 основных аспекта настройки VMkernel, его IP-адреса и предоставляемых им услуг. На вкладке General вы можете указать имя для VMkernel, предоставляемые услуги, а также значение MTU, если вы используете что-либо, кроме значения по умолчанию 1500.На вкладке IP Settings вы найдете настройки для IP-адреса и маски сети. Остальные вкладки снова идентичны тем, которые были ранее закрыты, со всеми наследуемыми настройками, которые, тем не менее, можно переопределить.

Остальные вкладки снова идентичны тем, которые были ранее закрыты, со всеми наследуемыми настройками, которые, тем не менее, можно переопределить.

Рисунок 23 — Настройка VMkernel

Рисунок 24 — Назначение IP-адреса и маски подсети для VMkernel

Заключение

На этом первая часть серии завершена.Я думаю, что я рассмотрел основные аспекты стандартных коммутаторов vSphere, и хотя, вероятно, их больше, чем можно сказать, мне нужно где-то подвести черту, чтобы это не превратилось в один громадный пост.

Во второй части этой серии статей я расскажу о распределенных коммутаторах, полезной функции при управлении несколькими хостами через vCenter Server, а также обо всем остальном, что могло оказаться невозможным.

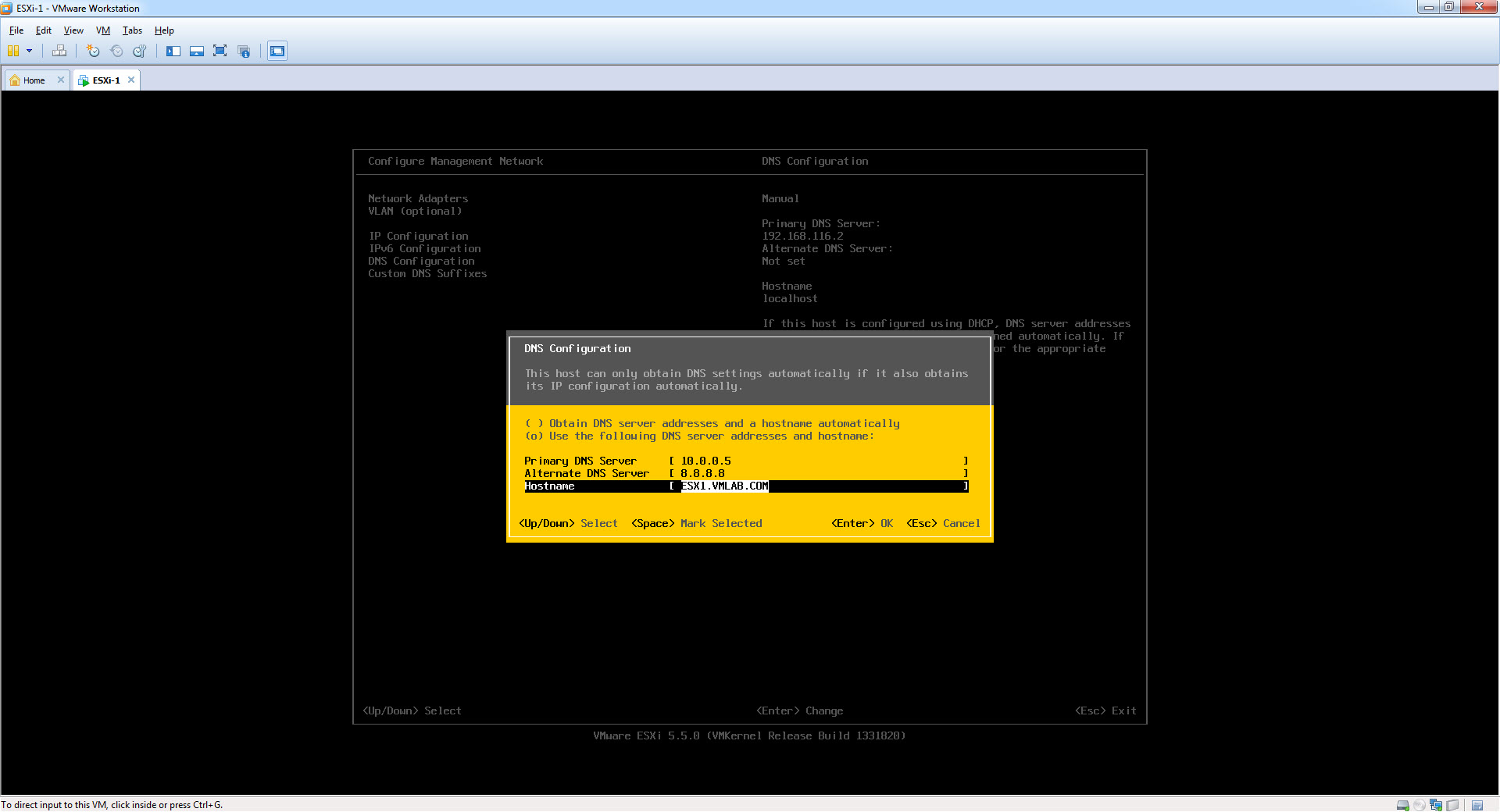

vSphere 6.5 — Настройка сети управления ESXi

В прошлой статье мы видели пошаговую процедуру установки для ESXi 6.5. После завершения установки нам нужно настроить сеть управления, чтобы подключить хост к сети. После настройки newtorking управления мы можем подключить хост к vCenter или консоли ESXi и выполнить дальнейшую настройку.

После настройки newtorking управления мы можем подключить хост к vCenter или консоли ESXi и выполнить дальнейшую настройку.

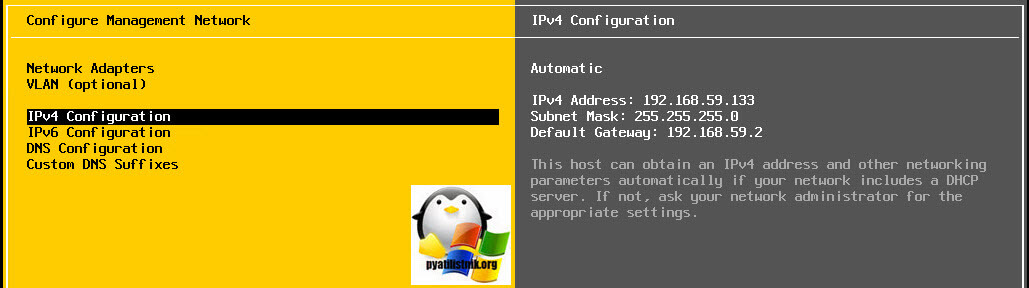

В этой начальной конфигурации мы вносим следующие изменения.

- Настроить IP-адрес

- Настройка DNS-серверов

- Настройка имени FQDN для хостов ESXi

- Отключить IPv6, если не требуется

Давайте посмотрим здесь: —

- Доступ к консоли DCUI для ESXi.

- Нажмите F2, чтобы войти в конфигурацию.

- Введите учетные данные root и нажмите Enter.

- Для настройки доступны следующие параметры. Мы переходим к настройке начальной конфигурации сети.

- Щелкните Configure Management Network и нажмите Enter.

- В разделе «Настроить сеть управления» вы увидите следующие параметры.

- Сетевые адаптеры — позволит выбрать NIC для сети управления.

Он создаст стандартный коммутатор как vSwitch0 и порт ядра vmk0 на ESXi с выбранными картами NIC

Он создаст стандартный коммутатор как vSwitch0 и порт ядра vmk0 на ESXi с выбранными картами NIC - VLAN — позволяет выбрать идентификатор VLAN для сети управления.

- Конфигурация IPv4 — позволяет настроить IPv4 для сети управления.

- IPv6 — Это позволит настроить IPv6, если вы хотите.Если не хотите настраивать IPv6, отключите файл configure. Мы увидим в следующих шагах.

- Конфигурация DNS — позволяет настроить DNS-серверы и имя хоста для ESXi.

- Пользовательский суффикс — позволяет добавить доменное имя в ESXi.

- Обратите внимание, что всю эту настройку вы можете выполнить из vCenter или консоли ESXi. Однако, чтобы подключить ESXi к сети, нам необходимо выполнить эту первоначальную настройку из DCUI для сети управления ESXi.

- Сетевые адаптеры и конфигурацию VLAN мы ставим по умолчанию.

Он будет рассматривать vmnic0 в качестве сетевого порта управления. Нажмите на IPv4, настройте и добавьте IP.

Он будет рассматривать vmnic0 в качестве сетевого порта управления. Нажмите на IPv4, настройте и добавьте IP.

- Введите информацию IPv4 и нажмите Enter.

- Выберите Конфигурация IPv6 и нажмите Enter.

- Выберите опцию « Отключить IPv6 » и нажмите Enter.

- Требуется перезагрузка хоста ESXi.

- Выберите DNS Configuration и укажите сведения об IP-адресе DNS.

- Введите имя хоста ESXi Host, которому нужно дать имя.

- Введите имя суффикса, которое вы хотите добавить как полное доменное имя. Это может быть доменное имя. Нажмите Ввод.

- После завершения настройки Нажмите ESCAPE для выхода из конфигурации сети.

- Он перезапустит хост, поскольку мы отключили IPv6.

- Выполняется перезапуск хоста.

- После успешной перезагрузки хоста и возврата консоли DCUI. Значит, сейчас в сети. Вы можете снова проверить подключение, выбрав опцию «Проверить сеть» в . Нажмите F2 >> Страница конфигурации >> Проверить сеть управления .

- Host готов к добавлению в Виртуальный центр. Вы можете управлять другой конфигурацией из Virtual Center Console.

Сеть управления

· Интегрированные контейнеры VMware vSphere 1.2 Документация

Сеть управления — это сеть, в которой виртуальная машина конечной точки VCH подключается к vCenter Server и хостам ESXi. Назначая определенную сеть управления, вы изолируете подключения к ресурсам vSphere от общедоступной сети. VCH использует эту сеть для обеспечения функции присоединения API Docker.

vic-machine Опции

Вы назначаете определенную сеть для трафика между VCH и ресурсами vSphere, указав параметр vic-machine create --management-network при развертывании VCH. Вы также можете маршрутизировать входящие соединения от хостов ESXi к VCH через общедоступную сеть, а не через сеть управления, указав параметр

Вы также можете маршрутизировать входящие соединения от хостов ESXi к VCH через общедоступную сеть, а не через сеть управления, указав параметр --asymmetric-routes .

- сеть управления

Краткое наименование : --mn

Группа портов, которую VCH использует для связи с vCenter Server и хостами ESXi. Виртуальные машины контейнера используют эту сеть для связи с VCH.

ВАЖНЫЕ ПРИМЕЧАНИЯ :

- Поскольку сеть управления предоставляет доступ к вашей среде vSphere, а виртуальные машины контейнеров используют эту сеть для связи с VCH, всегда используйте безопасную сеть для сети управления.

- Виртуальные машины контейнера обмениваются данными с ВМ конечной точки VCH по сети управления, когда требуется интерактивная оболочка. Пока обмен данными зашифрован, открытые ключи не проверяются, что оставляет возможности для атак типа «злоумышленник в середине». Это соединение используется только тогда, когда интерактивная консоль включена (

stdin/out/err), и ни для каких других целей.

- В идеале используйте отдельные сети для сети управления и контейнерных сетей.

- Наиболее безопасная настройка — убедиться, что VCH могут получить доступ к vCenter Server и хостам ESXi непосредственно через сеть управления, и что в сети управления есть записи маршрутов для подсетей, которые содержат как целевой сервер vCenter, так и соответствующие хосты ESXi. Если в сети управления нет записей маршрутов для подсетей vCenter Server и хоста ESXi, необходимо настроить асимметричную маршрутизацию. Дополнительные сведения об асимметричной маршрутизации см. В разделе о параметре

--asymmetric-routes.

Когда вы создаете VCH, vic-machine create проверяет, что брандмауэр на хостах ESXi разрешает соединения с портом 2377 из сети управления VCH. Если доступ к порту 2377 на хостах ESXi ограничен IP-адресом, и если эти ограничения блокируют доступ к сетевому интерфейсу управления, vic-machine create завершается с ошибкой конфигурации межсетевого экрана:

Конфигурация межсетевого экрана неверна из-за разрешенных ограничений IP на хостах: "/ га-датацентр / хост / локальный хост.localdomain / localhost.localdomain " Брандмауэр должен разрешать исходящий dst 2377 / tcp к интерфейсу управления VCH

Для получения информации о том, как открыть порт 2377, см. Открытие необходимых портов на хостах ESXi.

ПРИМЕЧАНИЕ : Если сеть управления использует DHCP, vic-machine проверяет состояние межсетевого экрана сети управления перед тем, как VCH получит IP-адрес. Следовательно, невозможно полностью оценить, разрешает ли межсетевой экран IP-адрес VCH.В этом случае vic-machine create выдает предупреждение.

Невозможно полностью проверить конфигурацию брандмауэра из-за использования DHCP в сети управления IP-адрес интерфейса управления VCH, назначенный DHCP, должен быть разрешен разрешенными настройками IP. Разрешенная конфигурация IP брандмауэра может препятствовать необходимому подключению на хостах: "/ha-datacenter/host/localhost.localdomain/localhost.localdomain" Брандмауэр должен разрешать исходящий dst 2377 / tcp к интерфейсу управления VCH

Использование :

- сеть управления имя_группы_портов

Если вы не укажете эту опцию, VCH будет использовать общедоступную сеть для трафика управления. Если вы укажете недопустимое имя группы портов,

Если вы укажете недопустимое имя группы портов, vic-machine create завершится ошибкой и предложит допустимые группы портов.

- асимметричные маршруты

Краткое наименование : --ar

Разрешает входящие соединения от хостов ESXi к VCH через общедоступную сеть, а не через сеть управления. Эта опция позволяет контейнерам в мостовых сетях косвенно обращаться к активам в управляющих или клиентских сетях через общедоступный интерфейс, если эти ресурсы маршрутизируются из общедоступной сети.Если в сети управления нет записей маршрута для подсетей хоста vCenter Server и ESXi, и вы не задали --asymmetric-routes , контейнеры, которые запускаются без указания -d , остаются в начальном состоянии.

В этом сценарии используйте параметр --asymmetric-routes , чтобы разрешить трафик управления от хостов ESXi к VCH проходить через общедоступную сеть. Установив параметр --asymmetric-routes , вы устанавливаете пересылку обратного пути в виртуальной машине конечной точки VCH в свободный режим, а не в строгий режим по умолчанию. Для получения информации о пересылке по обратному пути и свободном режиме см. Https://en.wikipedia.org/wiki/Reverse_path_forwarding.

Для получения информации о пересылке по обратному пути и свободном режиме см. Https://en.wikipedia.org/wiki/Reverse_path_forwarding.

Использование :

- асимметричные маршруты

Параметр --asymmetric-routes не принимает аргументов. Если вы не установите --asymmetric-routes , весь трафик управления будет маршрутизироваться через сеть управления.

Пример

vic-machine Команды

В этом примере развертывается VCH со следующей конфигурацией:

- Задает целевой экземпляр vCenter Server, имя пользователя vCenter Server, пароль, центр обработки данных и кластер, хранилище образов, группу портов для сети моста, имя для VCH и отпечаток сертификата vCenter Server.

- Защищает подключения к Docker API с помощью автоматически сгенерированного сертификата сервера без проверки сертификата клиента, задав значение

--no-tlsverify. - Направляет общедоступный трафик и трафик управления на существующую группу портов с именем

сеть 1и трафик API Docker в сетьсеть 2.

- Не указывает параметр

--public-network, поэтому трафик от виртуальных машин контейнера и VCH по умолчанию направляется в сеть виртуальных машин.

vic-machine- operating_system создать --target 'Администратор @ vsphere.local ': пароль @ vcenter_server_address / dc1 - кластер вычислительных ресурсов1 --image-store datastore1 - мост-сеть vch2-мост - сеть управления 'сеть 1' --client-network 'сеть 2' --name vch2 --thumbprint certificate_thumbprint --no-tls

В следующем примере развертывается аналогичный VCH, но указывается --asymmetric-routes , чтобы разрешить входящие соединения от хостов ESXi к VCH через общедоступную сеть, а не через сеть управления.

vic-machine- operating_system создать --target '[email protected]': пароль @ vcenter_server_address / dc1 - кластер вычислительных ресурсов1 --image-store datastore1 - мост-сеть vch2-мост - сеть управления 'сеть 1' --client-network 'сеть 2' --name vch2 --thumbprint certificate_thumbprint --no-tlsverify --асимметричные маршруты

Как добавить vLAN в VMware vSphere 5, 5.

5 или 6, / сеть виртуальных машин ESXi — Serenity-Networks

5 или 6, / сеть виртуальных машин ESXi — Serenity-Networks

Это простое пошаговое руководство по добавлению / назначению vLAN для сети виртуальной машины vSwitch на VMware ESXi и vSphere 5, 5.5 и 6. Другой способ добавить группы портов к vSwitch. Это довольно простой процесс, но если вы никогда не делали этого раньше, это может немного запутать. Мы собираемся создать группу портов виртуальной машины (сеть), которая будет назначена исключительно идентификатору vLAN.В этом руководстве предполагается, что вы уже создали виртуальную локальную сеть на своем коммутаторе и настроили магистральный порт для виртуальной инфраструктуры.

Сначала войдите в клиент vSphere. После этого перейдите к Home> Inventory> Hosts and Clusters (при использовании vSphere). Если вы входите непосредственно на сервер ESXi, вы уже должны быть там, где должны быть, сразу после входа в систему. Выберите свой хост ESXi в левом столбце, а затем выберите вкладку Configuration. На странице конфигурации выберите Сеть. Выберите Properties для vSwitch , которому вы хотите назначить вашу vLAN. В моем случае я выбираю свойств vSwitch0.

На странице конфигурации выберите Сеть. Выберите Properties для vSwitch , которому вы хотите назначить вашу vLAN. В моем случае я выбираю свойств vSwitch0.

Теперь нам нужно добавить группу портов эксклюзивно для vLAN. Щелкните Добавить.

Теперь вам нужно выбрать тип подключения. Выберите виртуальную машину, затем нажмите «Далее».

Теперь вам нужно пометить новую группу портов и ввести идентификатор vLAN. Имя может быть любым, но я предлагаю сделать его похожим на ваш идентификатор vLAN, чтобы вы знали, что оно связано с этой конкретной vLAN. Идентификатор vLAN должен соответствовать идентификатору vLAN , который вы выбрали на коммутаторе во время настройки.

Продолжайте и нажмите «Далее» , и вы сможете просмотреть свои изменения.

Нажмите «Готово» , и все готово. Вы также можете пойти дальше и нажать Close на странице свойств vSwitch. Теперь, когда вы перейдете к назначению сети виртуальной машины виртуальной машине, у вас будет возможность выбрать новую группу портов (сеть).

Вот и все. Если у вас есть какие-либо вопросы, задавайте их, задавая вопросы ниже. Спасибо!

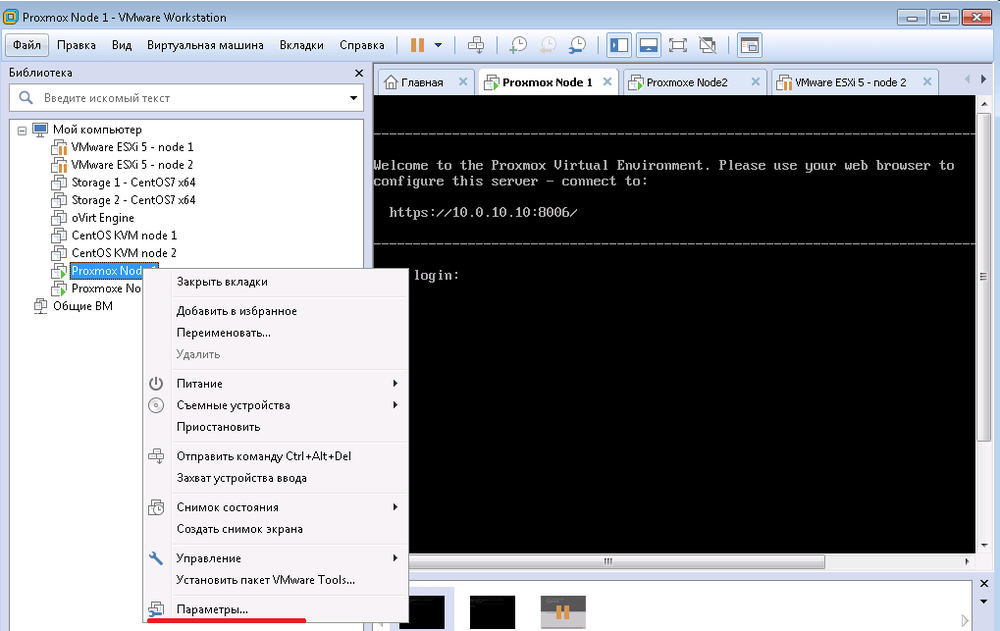

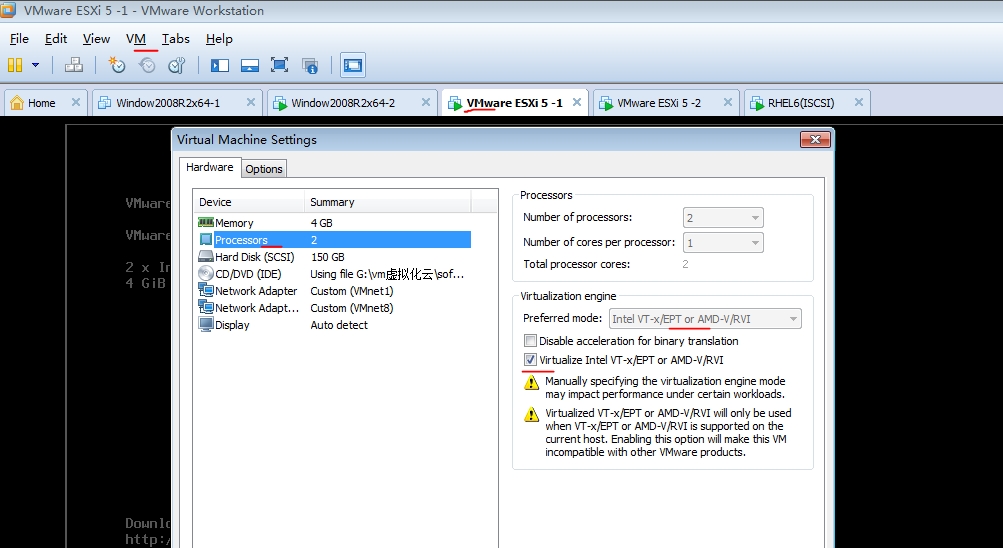

Как создать изолированную тестовую среду VMware

Обновление схемы Active Directory — необратимая операция, поэтому мне нужна тестовая среда, которая полностью изолирована от производства для тестирования всех затронутых приложений / виртуальных машин.

Одно требование — сохранить настройки IP-адресов кандидатов на тестирование, второе — чтобы было очень легко клонировать виртуальные машины от производства к тестированию.

Есть несколько способов / конструкций для выполнения этих требований — я решил использовать следующий, так как его очень легко ввести в эксплуатацию, не вкладывая много времени и оборудования.

Недостаток в том, что единственная возможность получить доступ к тестовым виртуальным машинам — это через консоль клиента webclient / vSphere:

Вся тестовая среда работает на одном хосте VMware ESXi, оборудованном достаточным объемом оперативной памяти и локальными дисками.Хост ESXi имеет доступ к выделенному LUN в общем хранилище для удобного обмена виртуальными машинами.

Чтобы убедиться, что виртуальные машины тестовой среды не имеют сетевого доступа к производственной среде, я настроил vSwitch для виртуальных машин без физического адаптера.

Второй vSwitch подключен к сети (трафик управления и vMotion включены). Таким образом, вы можете получить доступ к виртуальным машинам через консоль клиента webclient / vSphere и клонировать их из производственной среды для тестирования.