Нейронные самообучающиеся сети: Ученые РФ создали робота, способного самообучаться благодаря нейронной сети — Наука

Ученые РФ создали робота, способного самообучаться благодаря нейронной сети — Наука

МОСКВА, 20 мая. /ТАСС/. Ученые Нижегородского государственного университета им. Лобачевского (ННГУ) создали робота с возможностью самообучения на основе искусственной нейронной сети. Технологии, заложенные в разработку, могут в дальнейшем использоваться для создания более сложных роботизированных устройств для применения на промышленных объектах, в космосе и под водой, сообщила в понедельник пресс-служба Минобрнауки РФ.

«Нижегородские ученые создали уникального нейроробота с возможностью обучения и, что важно, самообучения на основе искусственно созданной нейронной сети. Технологии, заложенные в нейророботе, могут быть в дальнейшем использованы для создания более сложных роботизированных устройств (в том числе беспилотных транспортных средств), обладающих свойствами позиционирования в динамично меняющейся среде и применяться, как на промышленных объектах, так и в труднодоступных местах: в космосе и глубоко под водой», — говорится в сообщении.

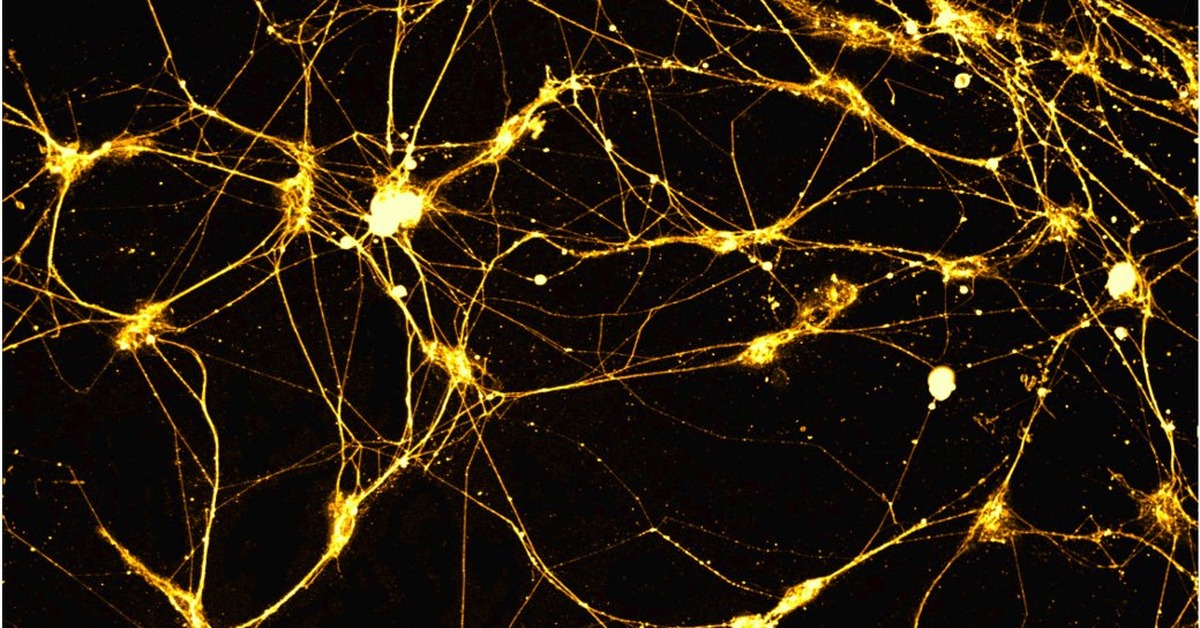

Понимание процессов обучения в нейронных сетях, нейроны которых близки по своим характеристикам к нейронам головного мозга, является ключевым вопросом в нейронауке. В настоящее время на рынке нет устройств, имеющих такое нейроподобное управление. Ученые ННГУ в исследовании показали, что виртуальная нейронная сеть может управлять роботом при определенном воздействии.

Самообучающийся нейроробот оснащен ультразвуковыми датчиками расстояния и чувствительным бампером с датчиками касания. Датчики позволяют детектировать препятствия с левой и правой стороны. Активность сенсорных нейронов зависит от сигналов с датчиков. «Нейроробот обучается в процессе взаимодействия с внешней средой — двигаясь вперед, он получает стимуляцию от датчиков. В результате такого самообучения робот начинает объезжать препятствия заранее, не касаясь их», отмечается в сообщении.

Кроме того, робот способен переобучиться при смене положения ультразвуковых датчиков расстояния. Следующим шагом развития проекта, как пояснили ученые, станет разработка коммерческого продукта «нейроконструктор». Робототехнические конструкторы, представленные в настоящее время на рынке, не имеют такого нейроподобного управления. Коммерческий продукт в дальнейшем может быть востребован в образовательной сфере, например, с его помощью студенты смогут моделировать нейронные сети. А также в сфере игровой индустрии.

Робототехнические конструкторы, представленные в настоящее время на рынке, не имеют такого нейроподобного управления. Коммерческий продукт в дальнейшем может быть востребован в образовательной сфере, например, с его помощью студенты смогут моделировать нейронные сети. А также в сфере игровой индустрии.

Отмечается, что проект выполняется в рамках Национальной технологической инициативы и ее рынка «Нейронет», что предполагает активное развитие средств человеко-машинных коммуникаций, основанных на передовых разработках в нейротехнологиях и повышающих продуктивность человеко-машинных систем, производительность психических и мыслительных процессов. Новые технологии, продукты и услуги «Нейронет» будут разрабатываться на основе результатов интенсивного изучения человеческого мозга и нервной системы.

Нейронные сети — математический аппарат

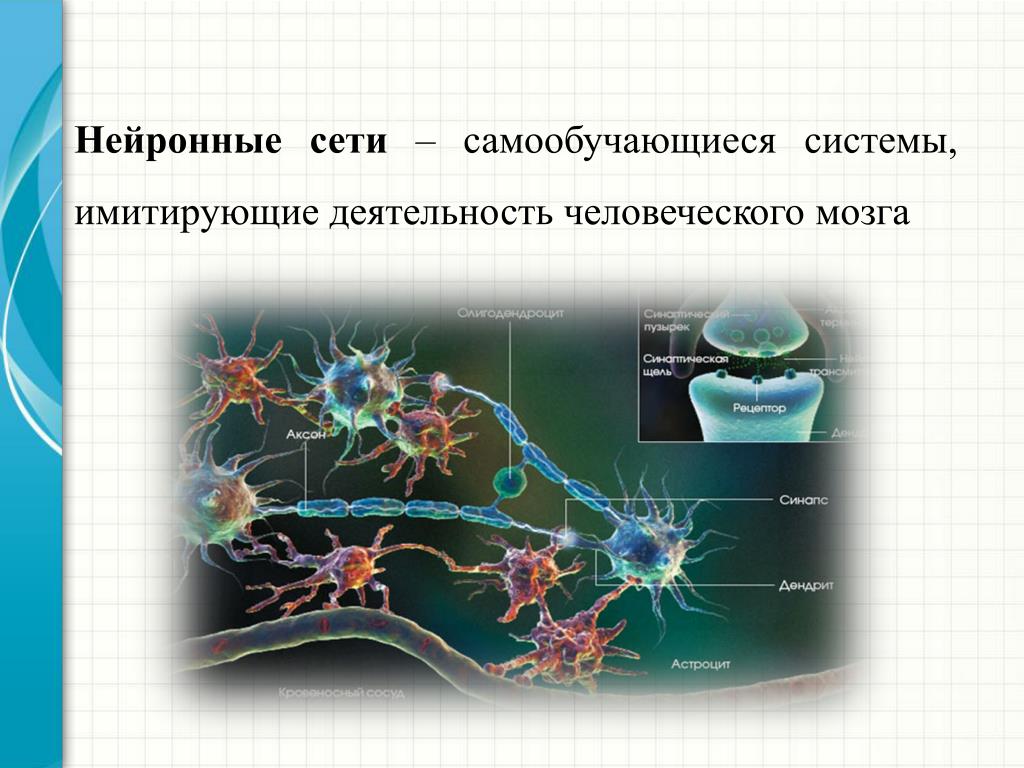

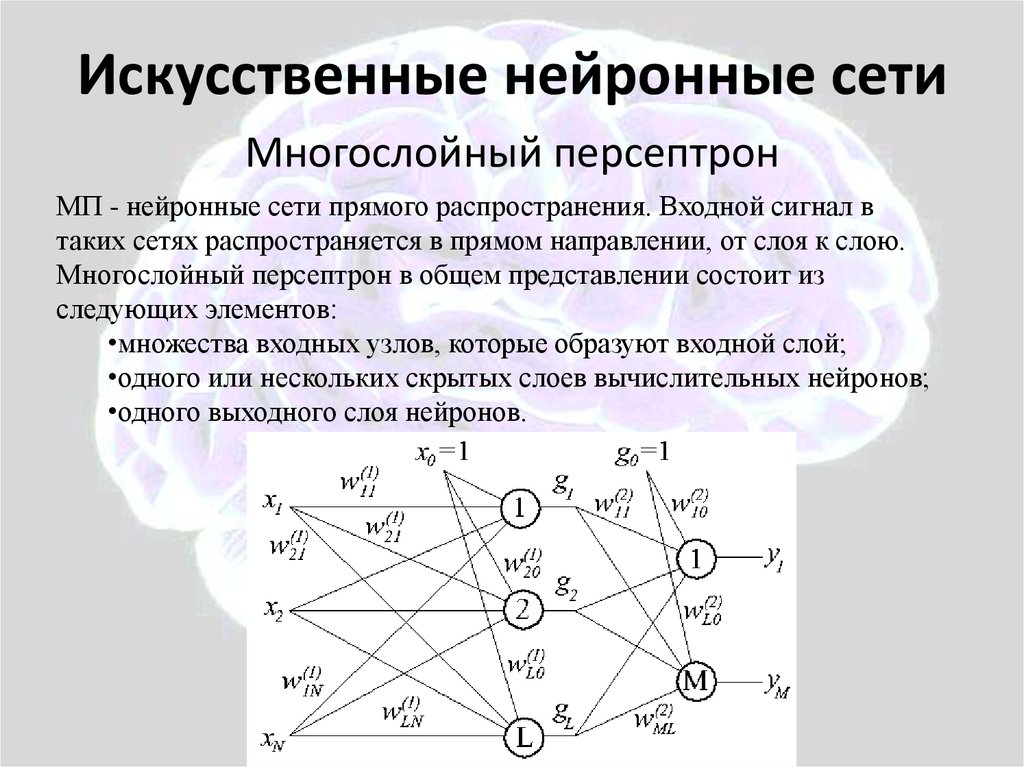

В наши дни возрастает необходимость в системах, которые способны не только выполнять однажды запрограммированную последовательность действий над заранее определенными данными, но и способны сами анализировать вновь поступающую информацию, находить в ней закономерности, производить прогнозирование и т. д. В этой области приложений самым лучшим образом зарекомендовали себя так называемые нейронные сети – самообучающиеся системы, имитирующие деятельность человеческого мозга. Рассмотрим подробнее структуру искусственных нейронных сетей (НС) и их применение в конкретных задачах.

д. В этой области приложений самым лучшим образом зарекомендовали себя так называемые нейронные сети – самообучающиеся системы, имитирующие деятельность человеческого мозга. Рассмотрим подробнее структуру искусственных нейронных сетей (НС) и их применение в конкретных задачах.

Искусственный нейрон

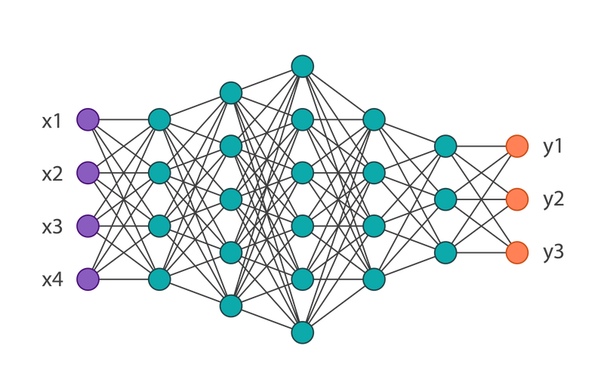

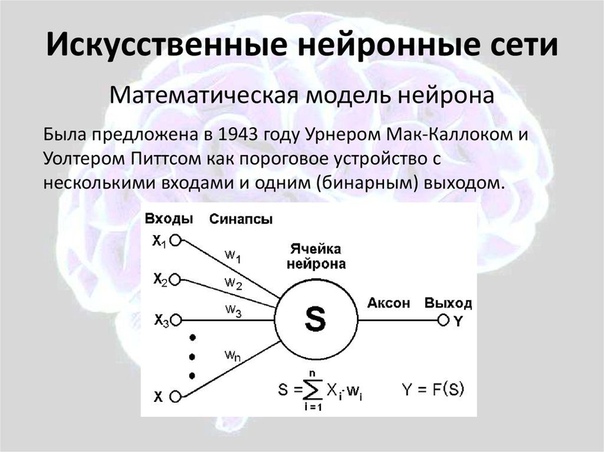

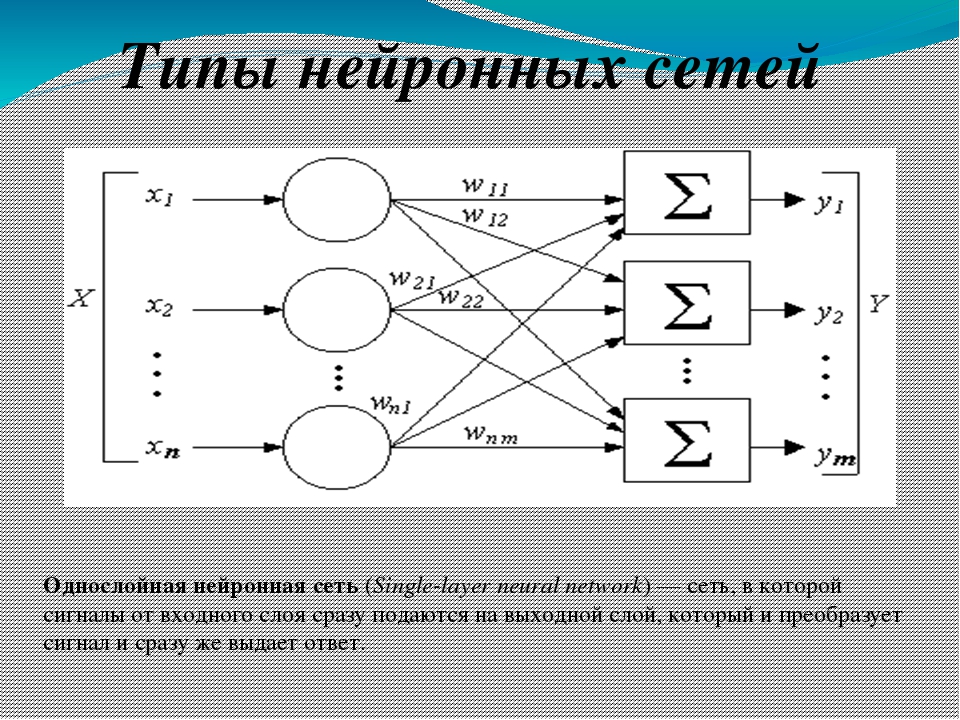

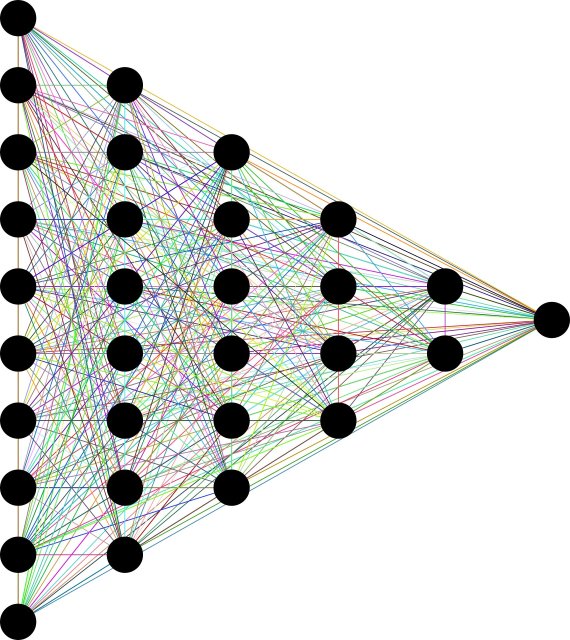

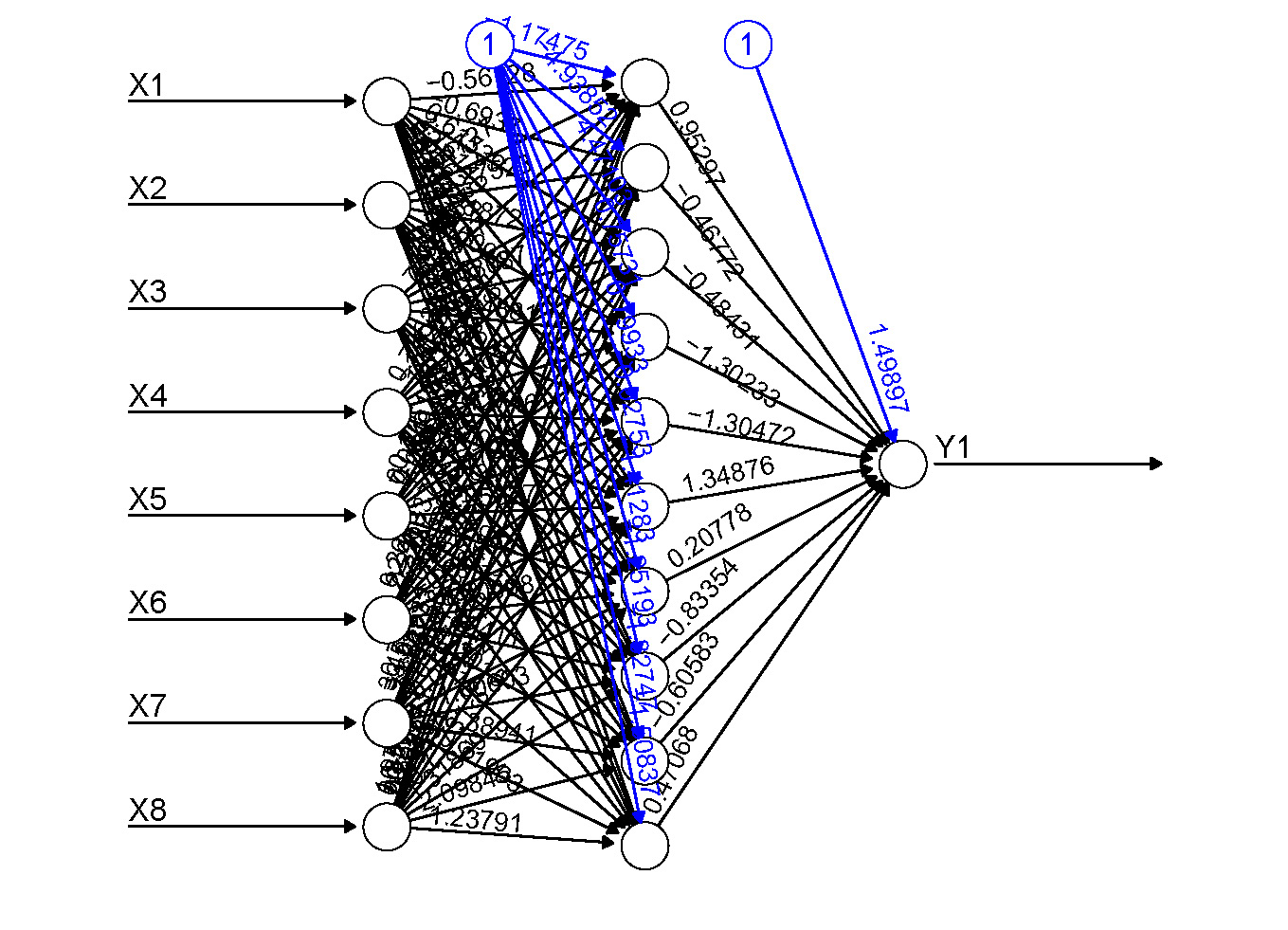

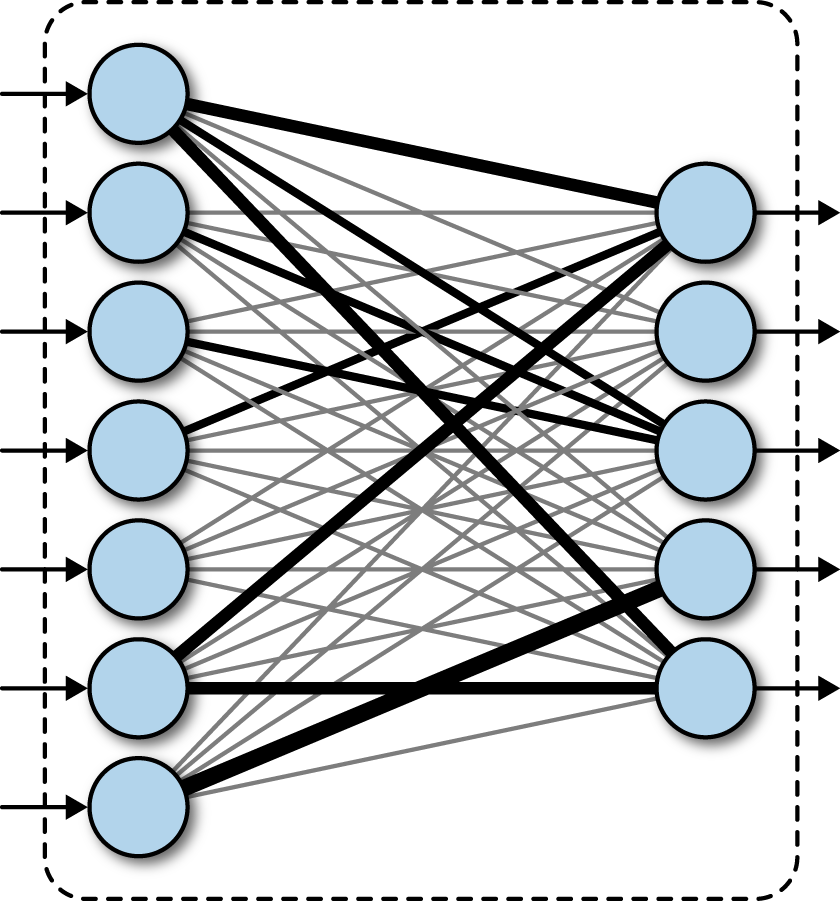

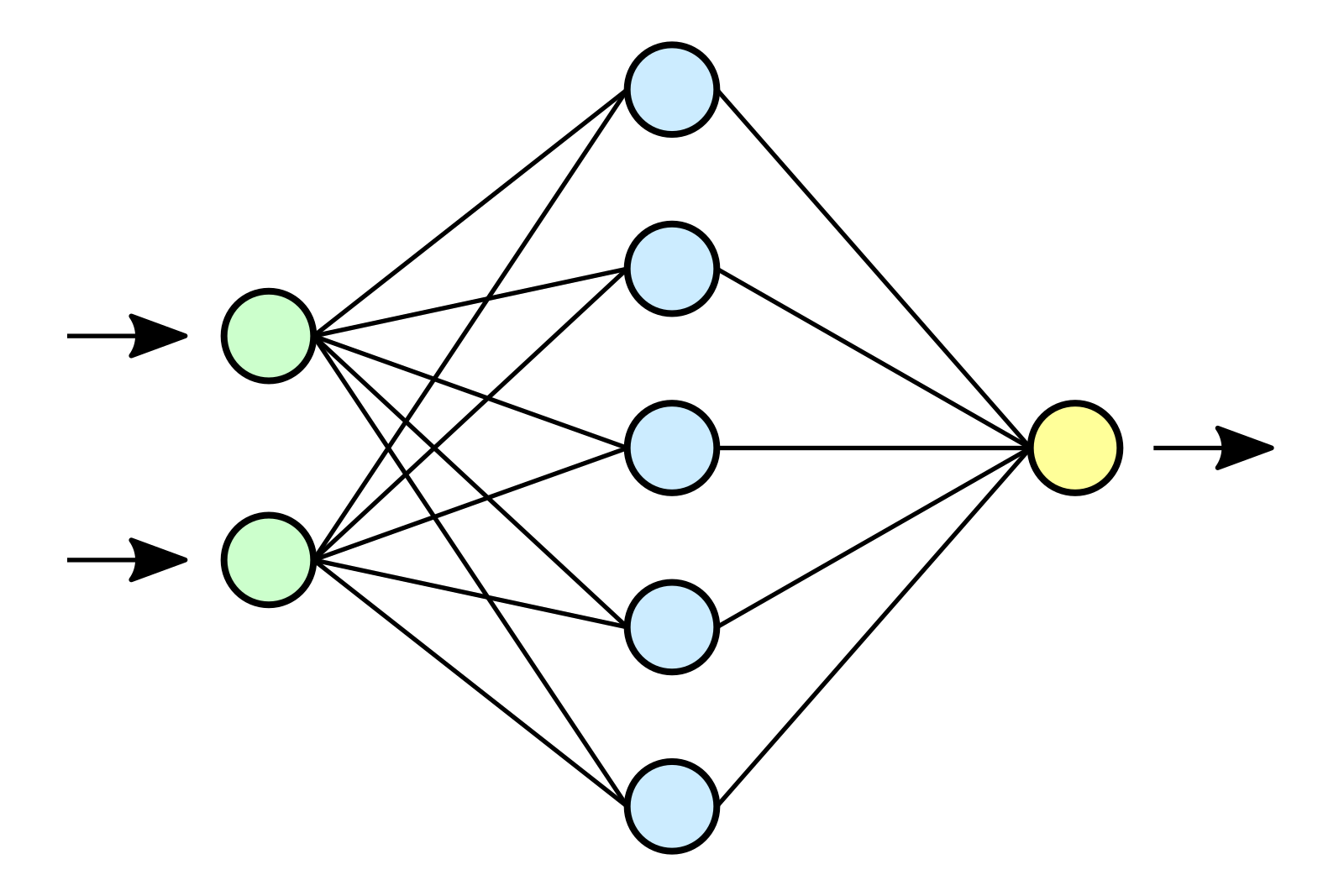

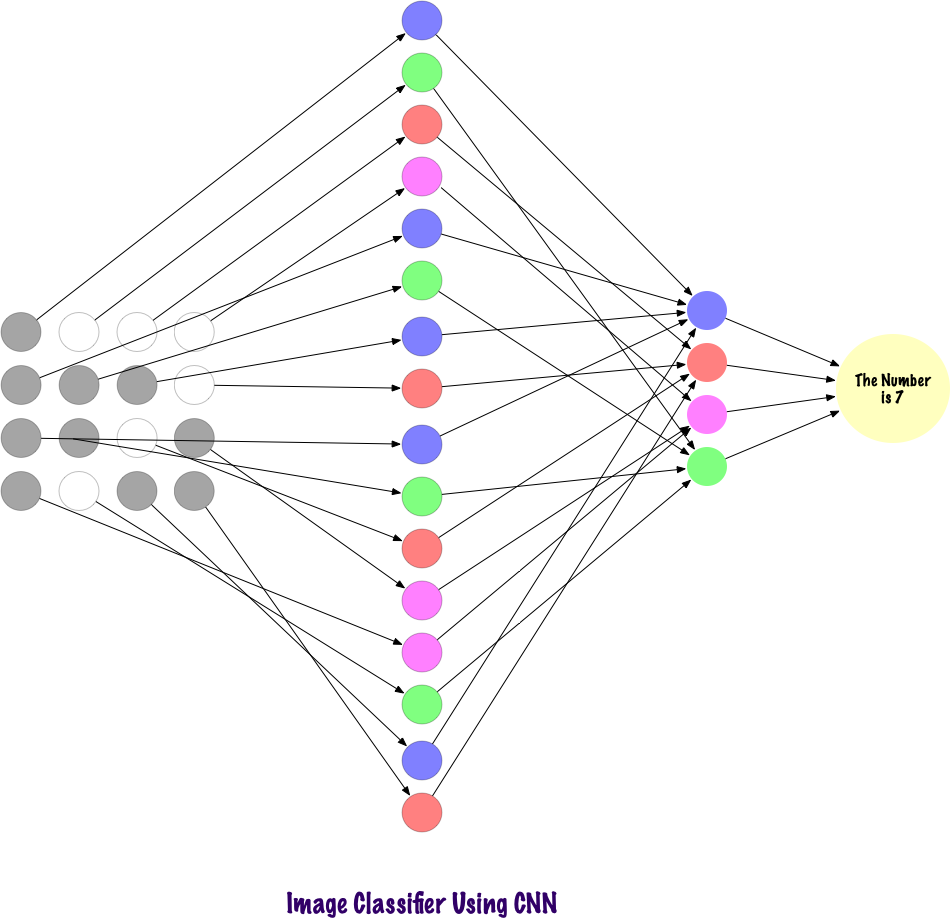

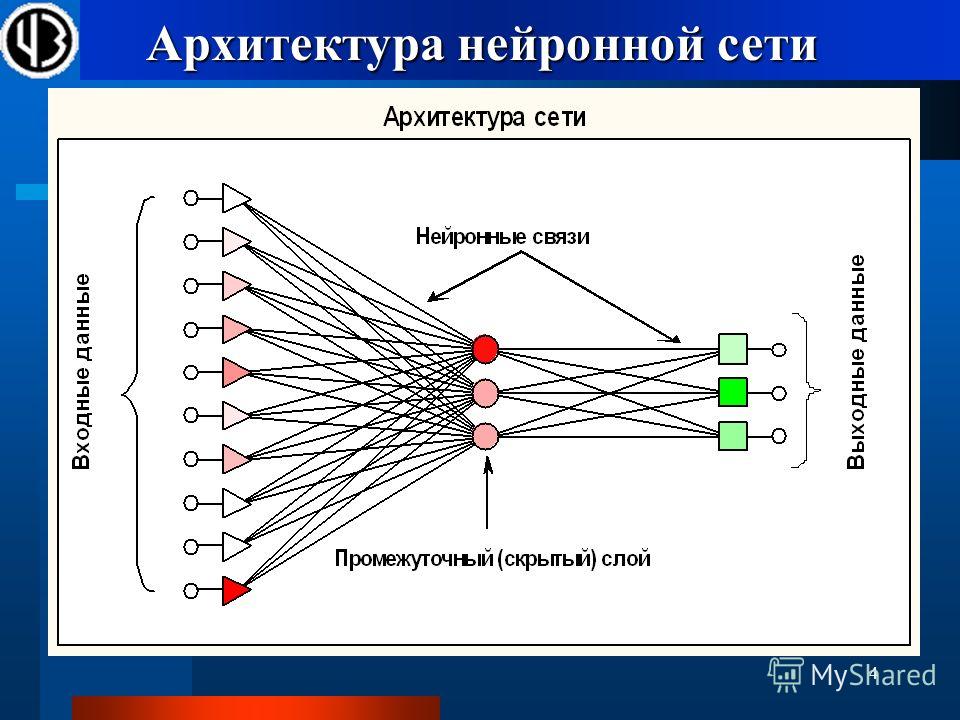

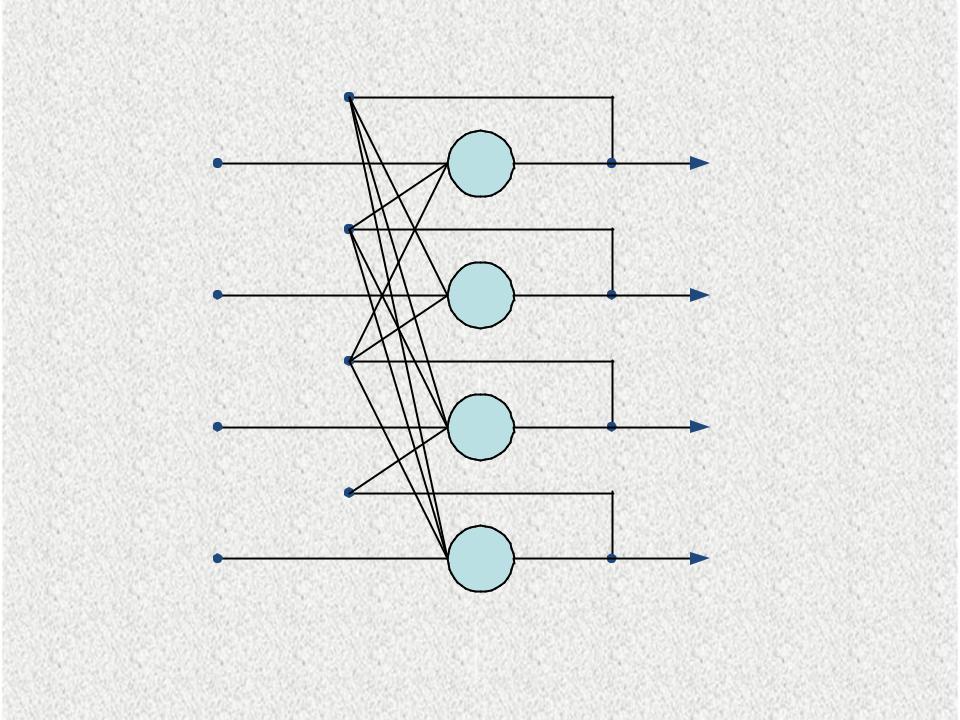

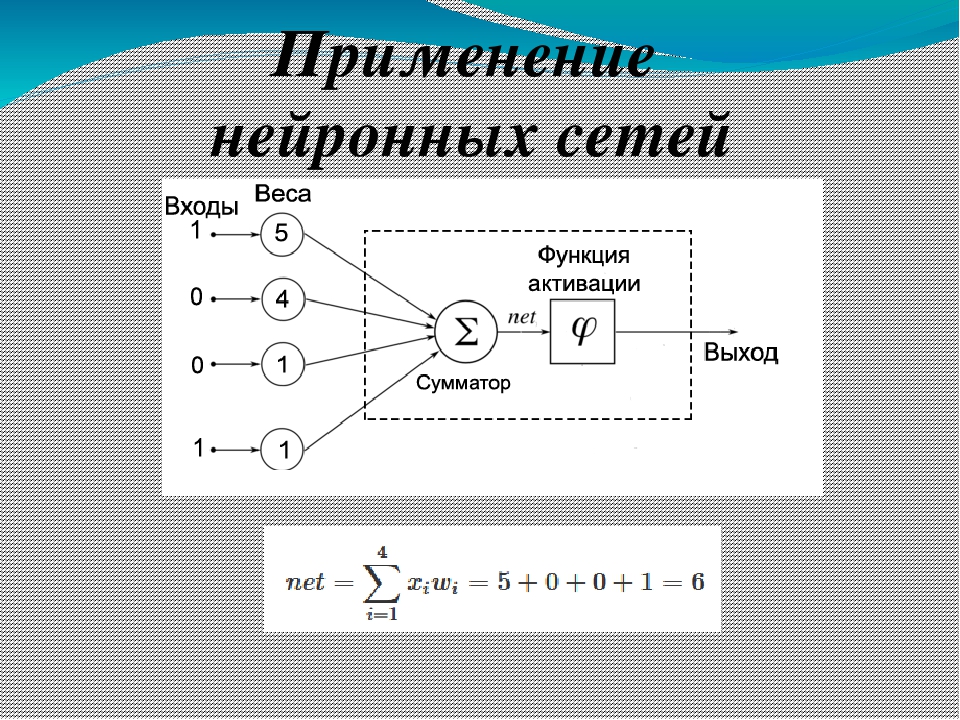

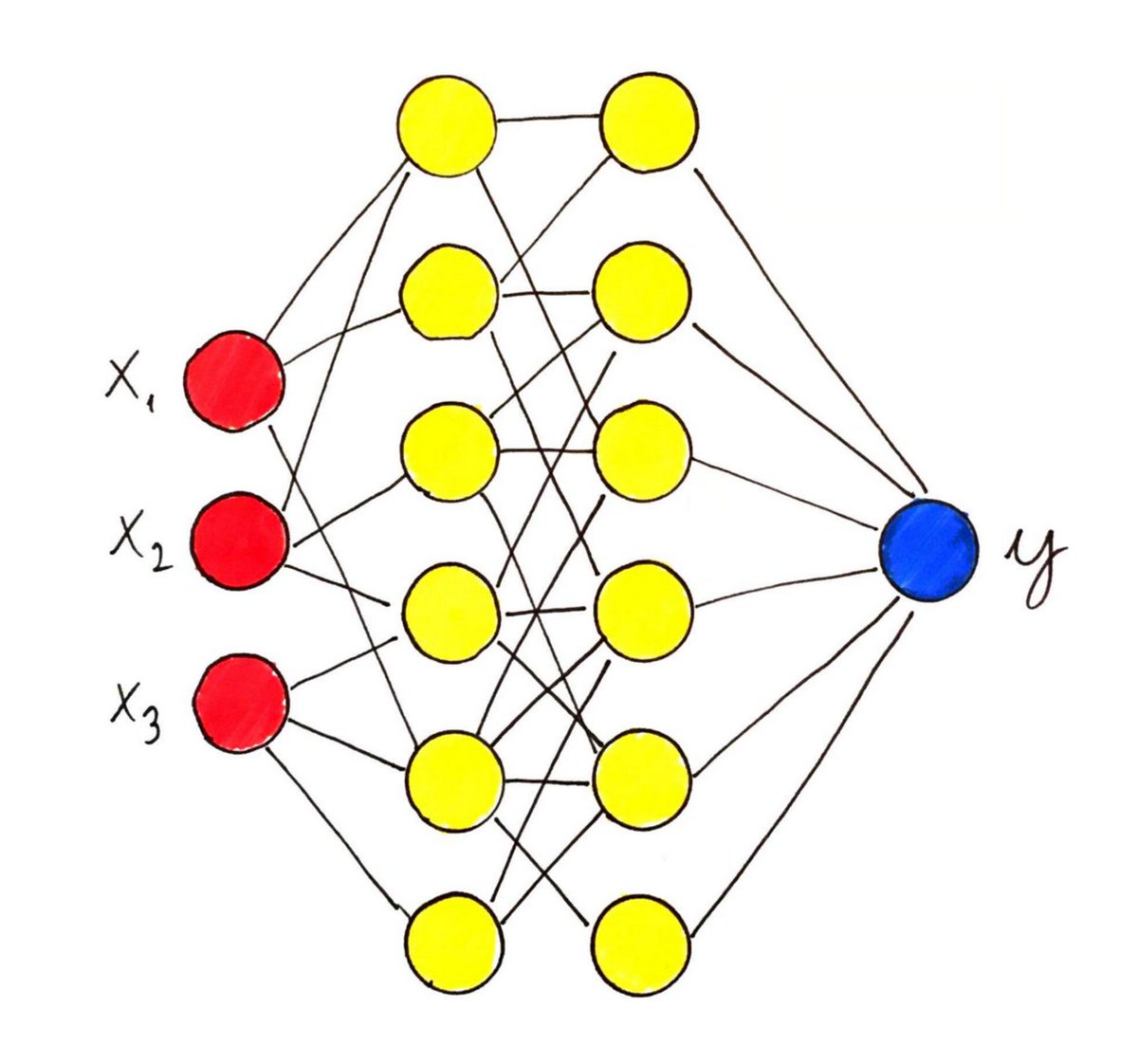

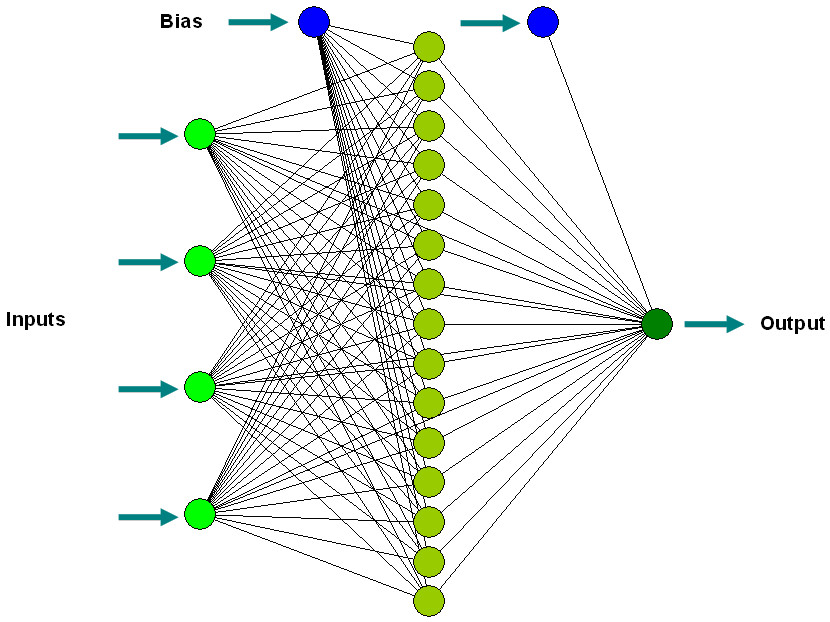

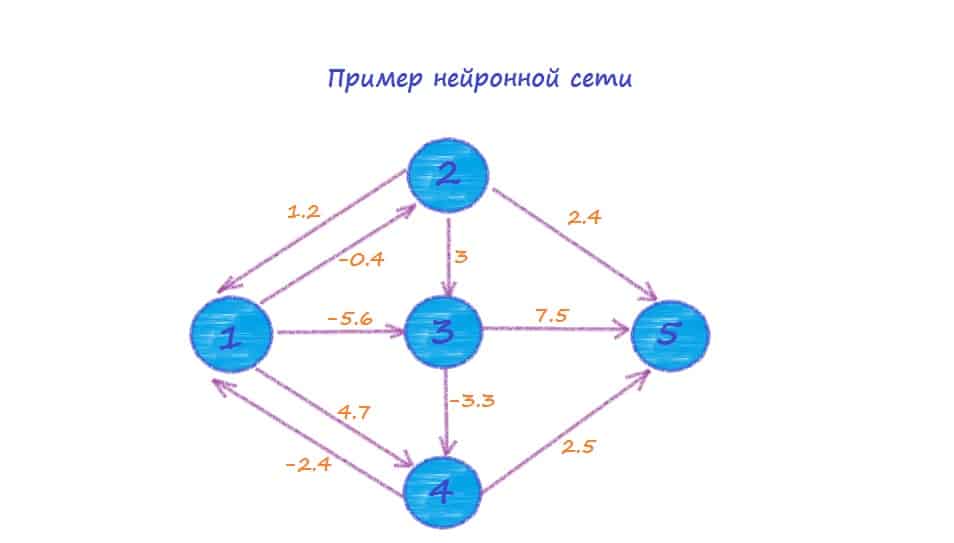

Несмотря на большое разнообразие вариантов нейронных сетей, все они имеют общие черты. Так, все они, так же, как и мозг человека, состоят из большого числа связанных между собой однотипных элементов – нейронов, которые имитируют нейроны головного мозга. На рис. 1 показана схема нейрона.

Из рисунка видно, что искусственный нейрон, так же, как и живой, состоит из синапсов, связывающих входы нейрона с ядром; ядра нейрона, которое осуществляет обработку входных сигналов и аксона, который связывает нейрон с нейронами следующего слоя. Каждый синапс имеет вес, который определяет, насколько соответствующий вход нейрона влияет на его состояние. Состояние нейрона определяется по формуле

$S =\sum \limits_{i=1}^{n} \,x_iw_i$, (1)

$\sum \limits_{k=1}^{N} k^2$, (1)

где

n – число входов нейрона

xi – значение i-го входа нейрона

wi – вес i-го синапса.{-ax}}$, (3)

Основное достоинство этой функции в том, что она дифференцируема на всей оси абсцисс и имеет очень простую производную:

$f’\,(x) = \alpha f(x)\,\bigl(1\,-\,f\,(x)\bigr)$, (4)

При уменьшении параметра a сигмоид становится более пологим, вырождаясь в горизонтальную линию на уровне 0,5 при a=0. При увеличении a сигмоид все больше приближается к функции единичного скачка.

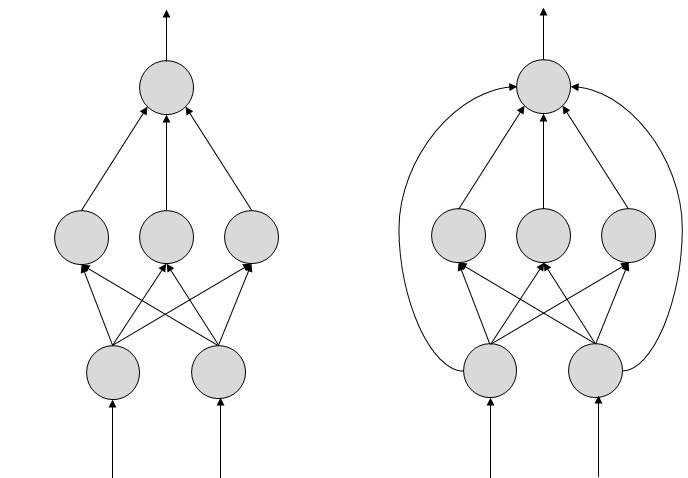

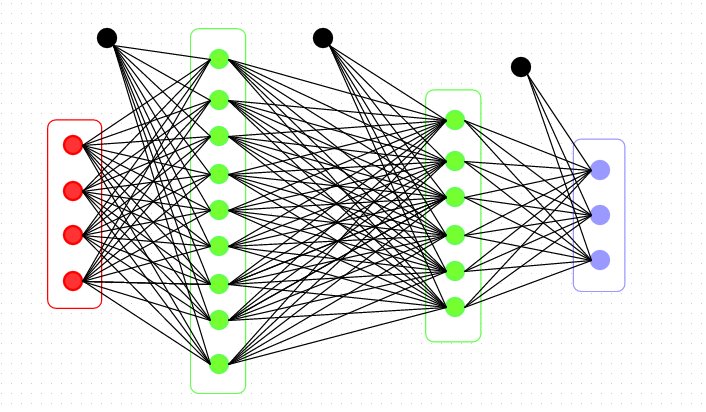

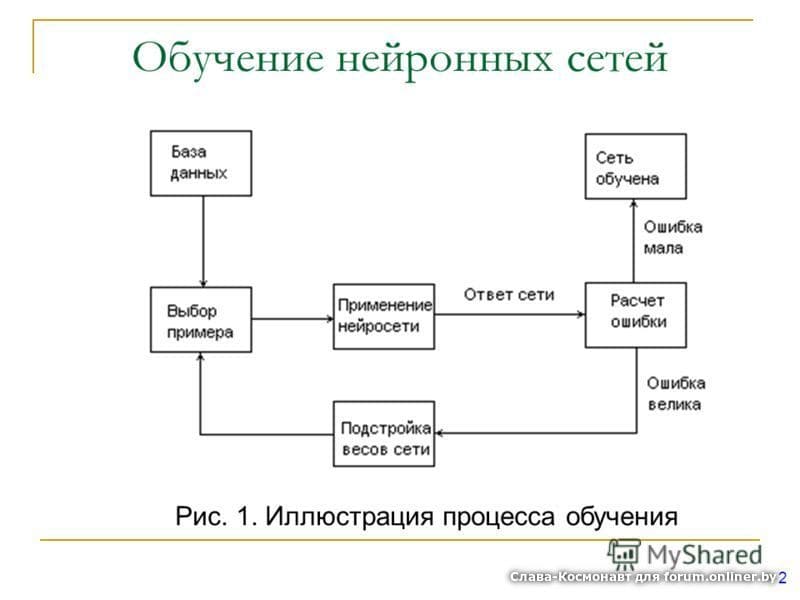

Нейронные сети обратного распространения

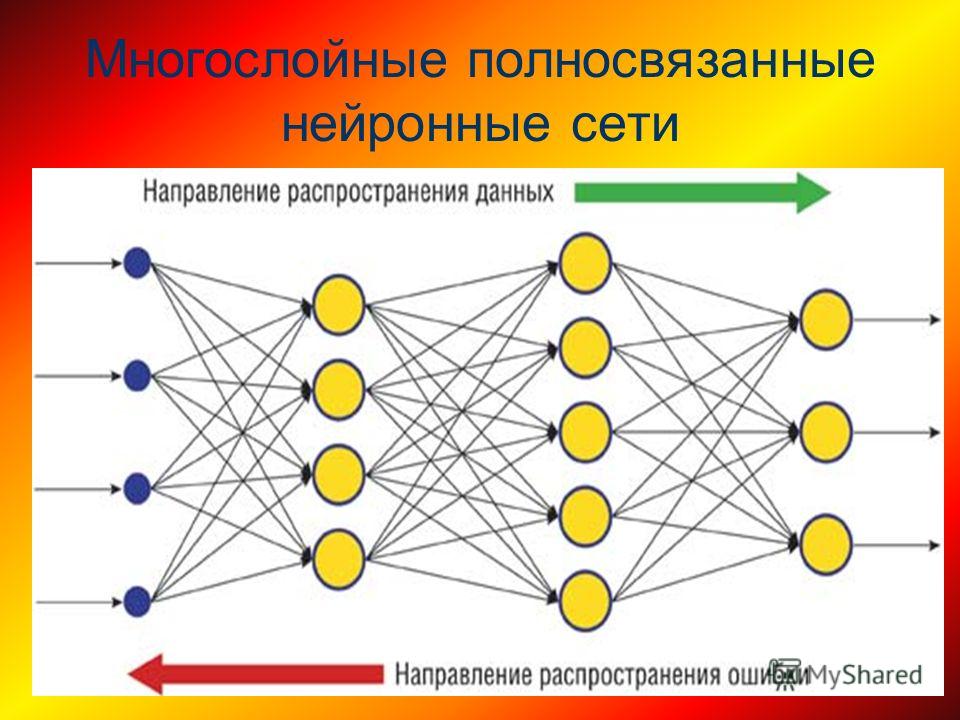

Нейронные сети обратного распространения – это мощнейший инструмент поиска закономерностей, прогнозирования, качественного анализа. Такое название – сети обратного распространения (back propagation) они получили из-за используемого алгоритма обучения, в котором ошибка распространяется от выходного слоя к входному, т. е. в направлении, противоположном направлению распространения сигнала при нормальном функционировании сети.

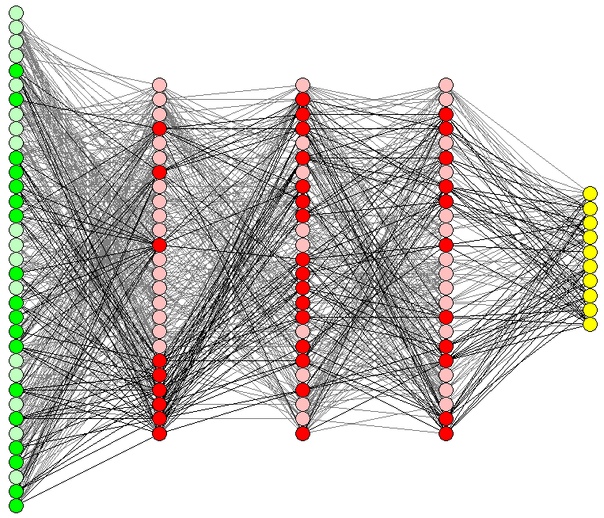

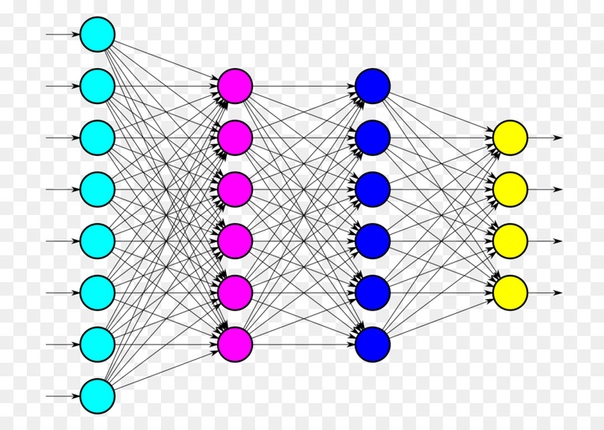

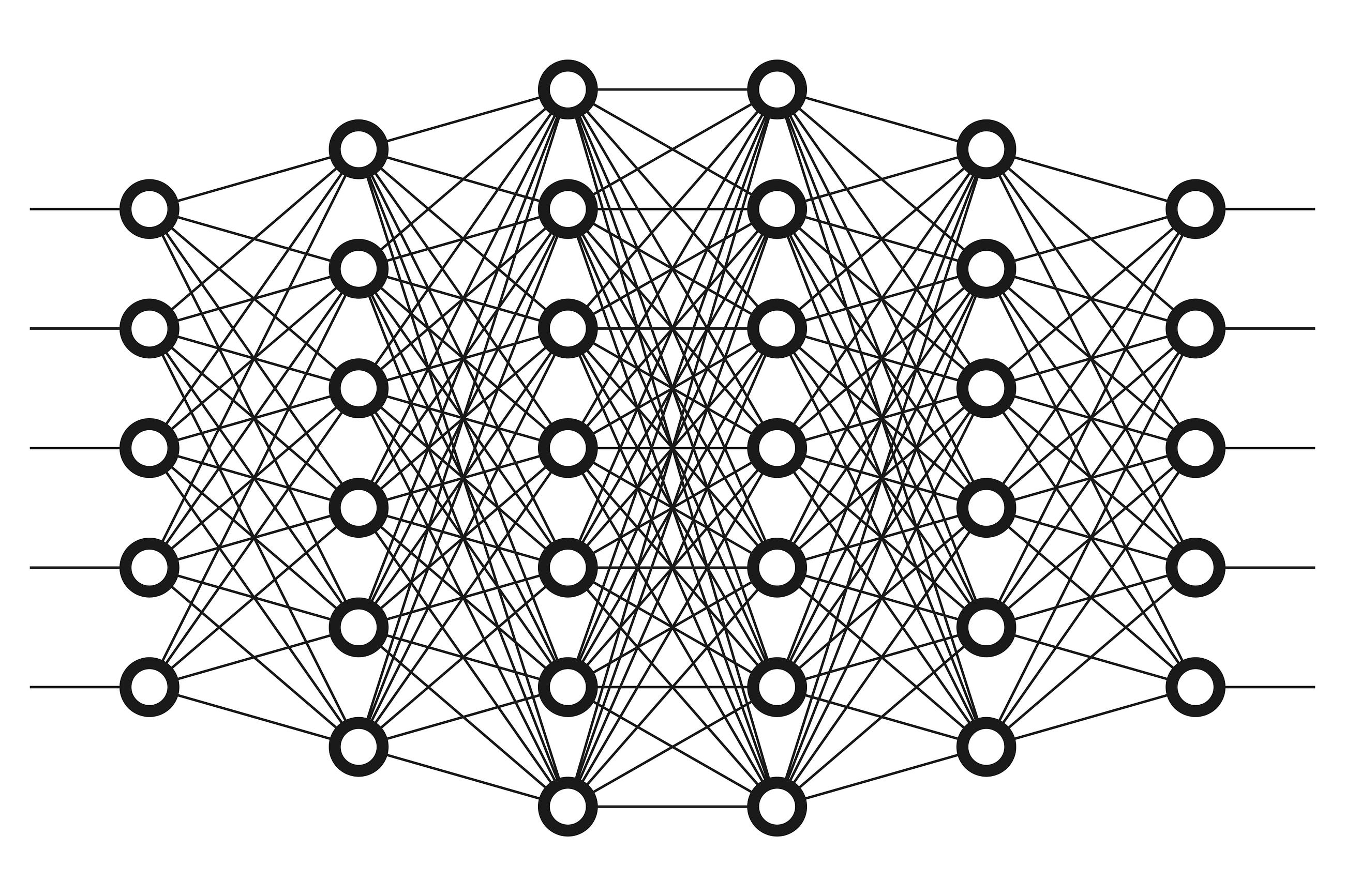

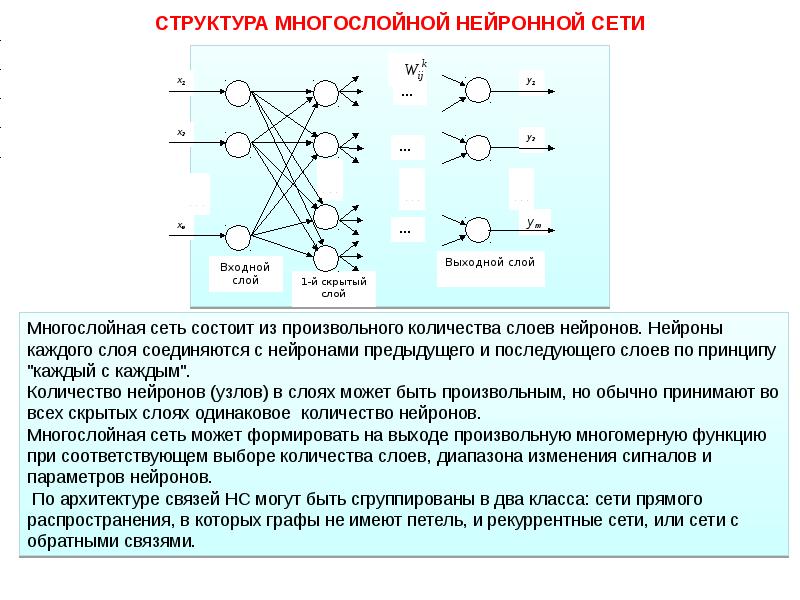

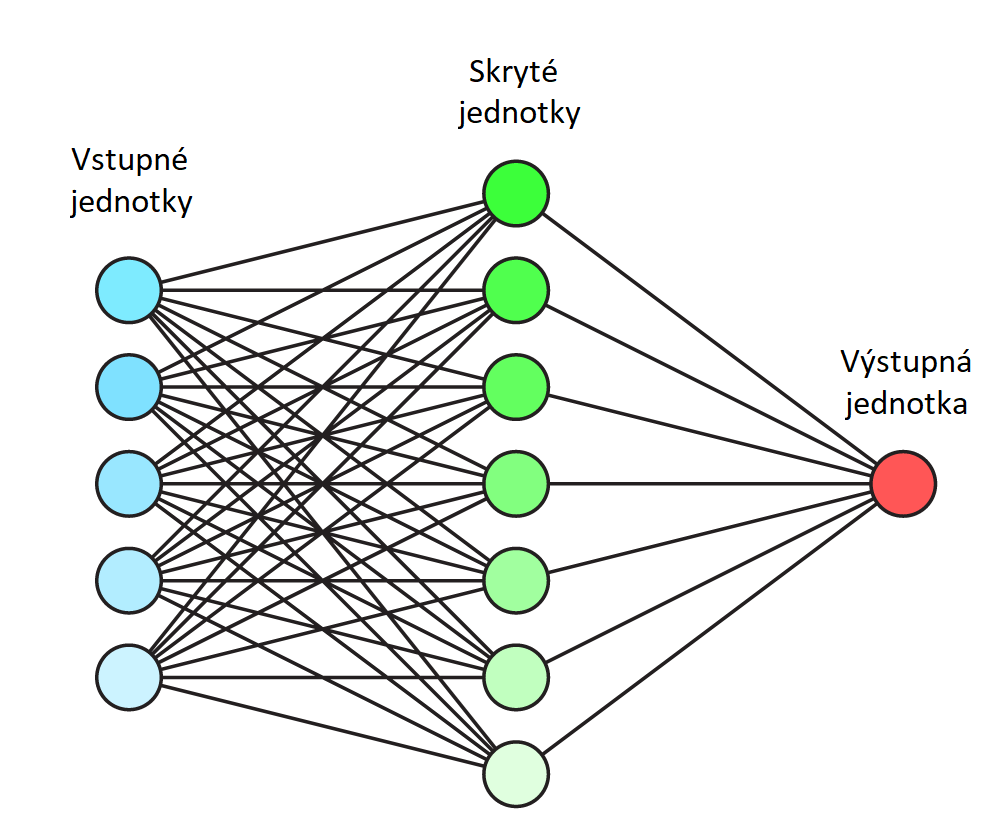

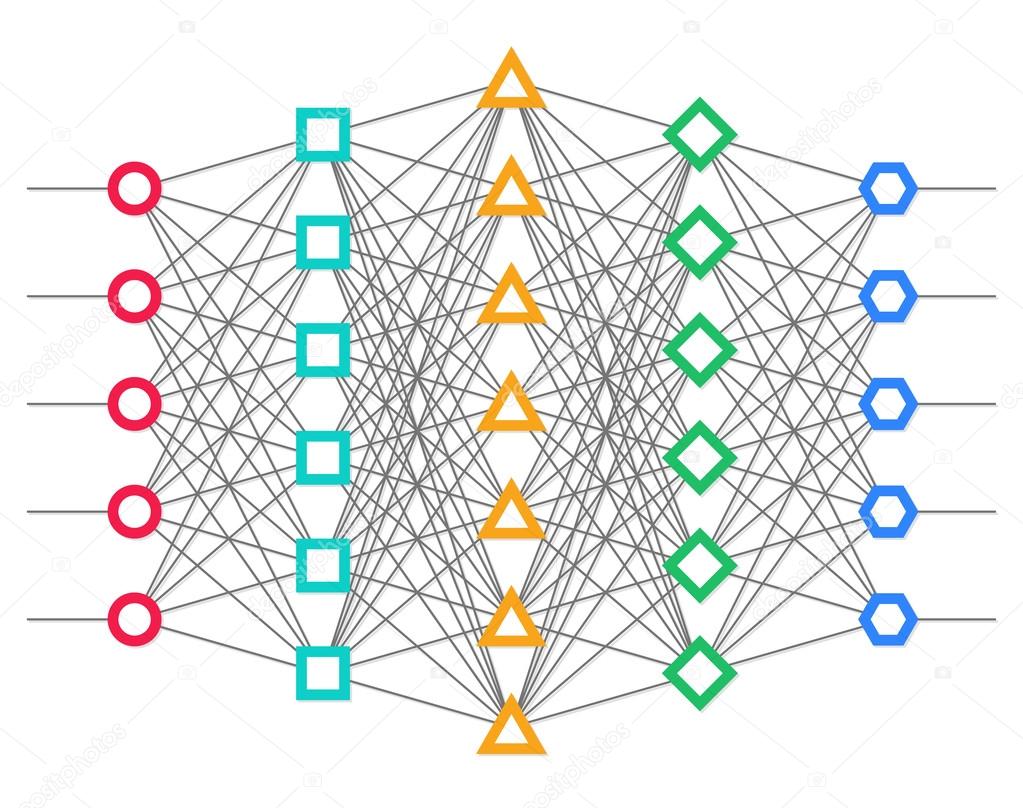

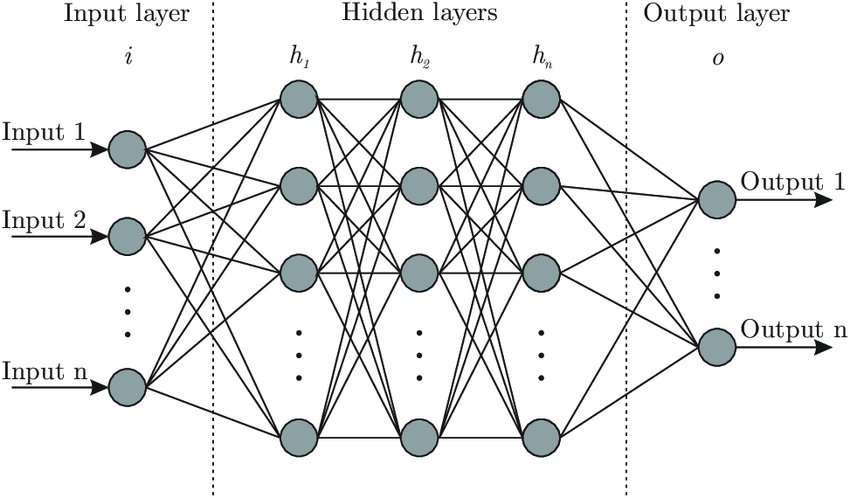

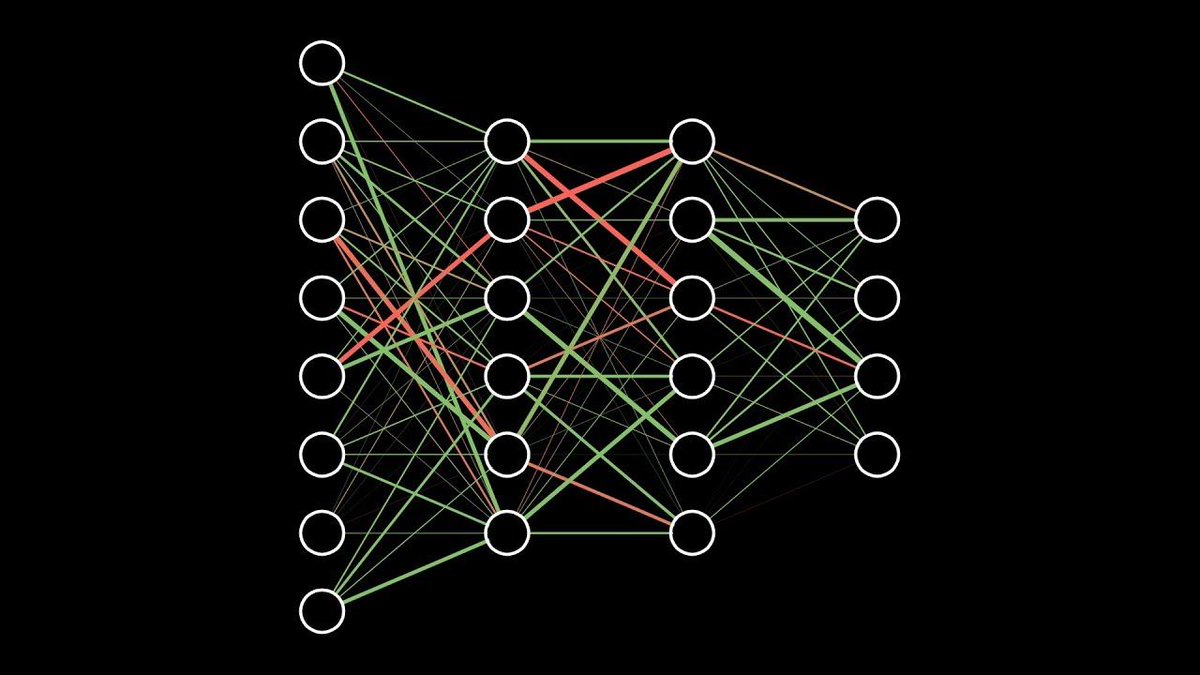

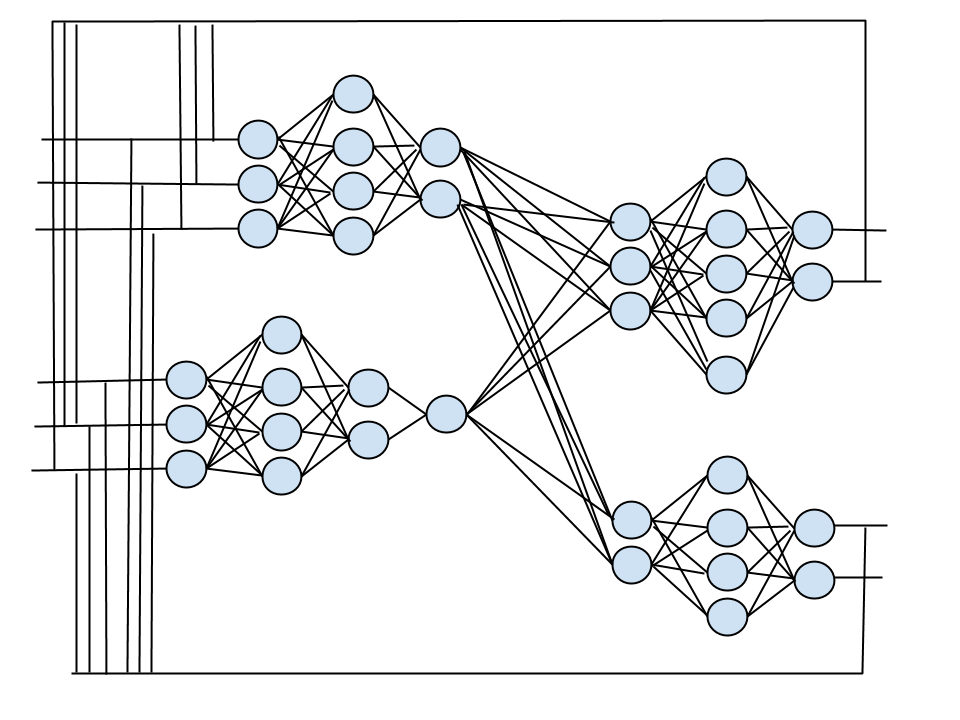

Нейронная сеть обратного распространения состоит из нескольких слоев нейронов, причем каждый нейрон слоя i связан с каждым нейроном слоя i+1, т.

2$, (5)

где

yj – значение j-го выхода нейросети,

dj – целевое значение j-го выхода,

p – число нейронов в выходном слое.

Обучение нейросети производится методом градиентного спуска, т. е. на каждой итерации изменение веса производится по формуле:

$\Delta\,w_{ij} = -\,\eta\,\cdot\,\frac{\partial\,E}{\partial\,w_{ij}}$, (6)

где h – параметр, определяющий скорость обучения.

$\frac{\partial\,E}{\partial\,w_{ij}} = \frac{\partial\,E}{\partial\,y_i}\,\cdot\,\frac{dy_i}{dS_j}\,\cdot\,\frac{\partial\,S_j}{\partial\,w_{ij}}$, (7)

где

yj – значение выхода j-го нейрона,

Sj – взвешенная сумма входных сигналов, определяемая по формуле (1).

При этом множитель

$\frac{\partial\,S_j}{\partial\,w_{ij}} = x_i$, (8)

где

xi – значение i-го входа нейрона.

{(n)}\,(t\,-\,1)$ , (13.1)

Дополнительным преимуществом от введения момента является способность алгоритма преодолевать мелкие локальные минимумы.

Представление входных данных

Основное отличие НС в том, что в них все входные и выходные параметры представлены в виде чисел с плавающей точкой обычно в диапазоне [0..1]. В то же время данные предметной области часто имеют другое кодирование. Так, это могут быть числа в произвольном диапазоне, даты, символьные строки. Таким образом данные о проблеме могут быть как количественными, так и качественными. Рассмотрим сначала преобразование качественных данных в числовые, а затем рассмотрим способ преобразования входных данных в требуемый диапазон.

Качественные данные мы можем разделить на две группы: упорядоченные (ординальные) и неупорядоченные. Для рассмотрения способов кодирования этих данных мы рассмотрим задачу о прогнозировании успешности лечения какого-либо заболевания. Примером упорядоченных данных могут, например, являться данные, например, о дополнительных факторах риска при данном заболевании.

нет

ожирение

алкоголь

курение

гипертония

А также возможным примером может быть, например, возраст больного:

до 25 лет

25-39 лет

40-49 лет

50-59 лет

60 и старше

Опасность каждого фактора возрастает в таблицах при движении слева направо.

В первом случае мы видим, что у больного может быть несколько факторов риска одновременно. В таком случае нам необходимо использовать такое кодирование, при котором отсутствует ситуация, когда разным комбинациям факторов соответствует одно и то же значение. Наиболее распространен способ кодирования, когда каждому фактору ставится в соответствие разряд двоичного числа. 1 в этом разряде говорит о наличии фактора, а 0 о его отсутствии. Параметру нет можно поставить в соответствии число 0.

Таким образом для представления всех факторов достаточно 4-х разрядного двоичного числа. Таким образом число 10102 = 1010 означает наличие у больного гипертонии и употребления алкоголя, а числу 00002 соответствует отсутствие у больного факторов риска. Таким образом факторы риска будут представлены числами в диапазоне [0..15].

Во втором случае мы также можем кодировать все значения двоичными весами, но это будет нецелесообразно, т.к. набор возможных значений будет слишком неравномерным. В этом случае более правильным будет установка в соответствие каждому значению своего веса, отличающегося на 1 от веса соседнего значения. Так, число 3 будет соответствовать возрасту 50-59 лет. Таким образом возраст будет закодирован числами в диапазоне [0..4].

В принципе аналогично можно поступать и для неупорядоченных данных, поставив в соответствие каждому значению какое-либо число. Однако это вводит нежелательную упорядоченность, которая может исказить данные, и сильно затруднить процесс обучения.

В качестве одного из способов решения этой проблемы можно предложить поставить в соответствие каждому значению одного из входов НС. В этом случае при наличии этого значения соответствующий ему вход устанавливается в 1 или в 0 при противном случае. К сожалению, данный способ не является панацеей, ибо при большом количестве вариантов входного значения число входов НС разрастается до огромного количества. Это резко увеличит затраты времени на обучение. В качестве варианта обхода этой проблемы можно использовать несколько другое решение. В соответствие каждому значению входного параметра ставится бинарный вектор, каждый разряд которого соответствует отдельному входу НС.

Литература

- Dirk Emma Baestaens, Willem Max Van Den Bergh, Douglas Wood, «Neural Network Solution for Trading in Financial Markets», Pitman publishing

- R. M. Hristev, «Artifical Neural Networks»

- С. Короткий, «Нейронные сети: Алгоритм обратного распространения»

- С. Короткий, «Нейронные сети: Основные положения»

Нейросеть | BaseGroup Labs

Назначение

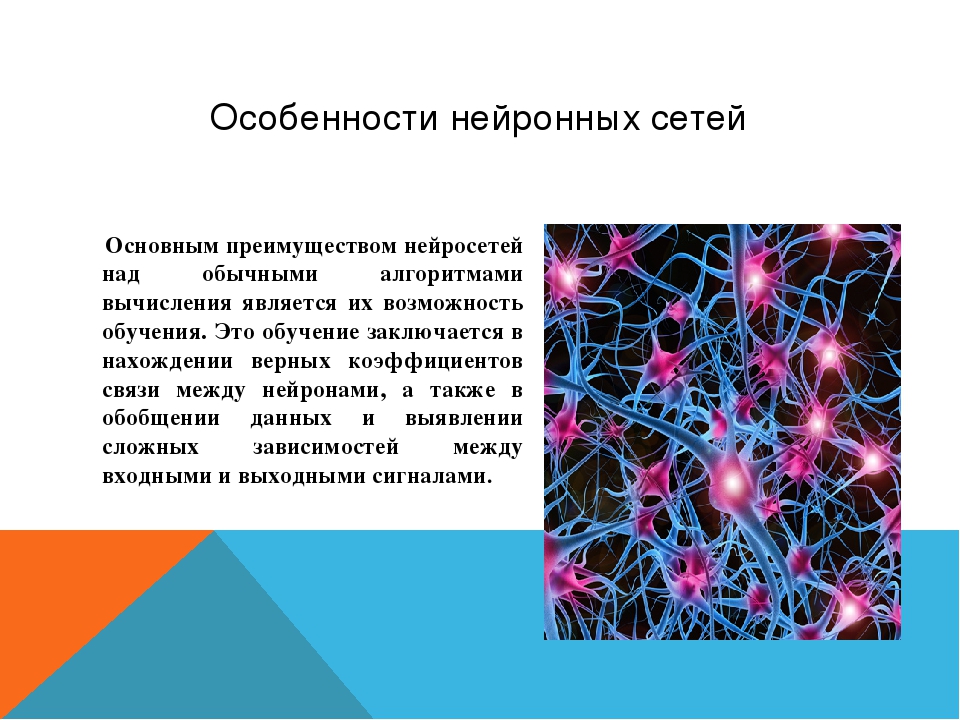

Нейронные сети представляют собой самообучающиеся модели, имитирующие деятельность человеческого мозга.

Они способны не только выполнять однажды запрограммированную последовательность действий над заранее определенными данными, но и сами анализировать вновь поступающую информацию.Основным достоинством нейронных сетей является возможность эффективно строить нелинейные зависимости, более точно описывающие наборы данных по сравнению с линейными методами статистики.

Данный обработчик позволяет задать структуру нейронной сети, определить ее параметры и обучить с помощью одного из доступных в системе алгоритмов. В результате будет получен эмулятор нейронной сети, который может быть использован для решения задач прогнозирования, классификации, поиска скрытых закономерностей, сжатия данных и многих других приложений.

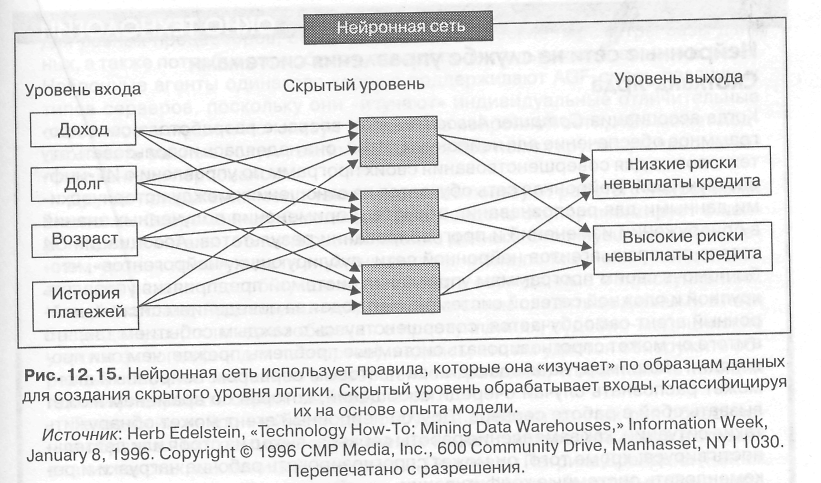

Примеры применения

Оценка кредитоспособности клиента при выдаче кредитов. На базе алгоритма строятся скоринговые карты, модели аппликационного и поведенческого скоринга. Это позволяет проводить выбранную кредитную политику и снижать уровень просроченной задолженности.

Медицинская диагностика. Алгоритм, обрабатывая накопленные данные клинических исследований, моделирует сложные зависимости между симптомами и заболеваниями. Это позволяет поставить верный диагноз, произвести мониторинг состояния пациента, оценить эффективность лечения…

Прогноз остатков на счетах. Используя информацию об ежедневных остатках на счетах клиентов, обработчик преобразует ее во временные ряды и построит прогноз остатка на будущее. Благодаря этому появляется возможность управлять ликвидностью банка.

Анализ миграции клиентов – перемещение клиентов между поставщиками товаров и услуг. Алгоритм позволяет оценить вероятность ухода клиента. На основе результатов таких исследований можно разработать методы работы с клиентами, чтобы повысить их лояльность к компании.

Описание алгоритма

Нейронная сеть состоит из простейших вычислительных элементов — искусственных нейронов, связанных между собой.

Каждый нейрон имеет несколько входных и одну выходную связь. В процессе работы нейронной сети значения входных переменных $x_i$ передаются по межнейронным связям и умножаются на весовые коэффициенты $w_i$, полученные значения взвешенно суммируются в нейроне.

В нейронных сетях нейроны объединяются в слои, при этом выходы нейронов предыдущего слоя являются входами нейронов следующего слоя. В каждом слое нейроны выполняют параллельную обработку данных.

Алгоритм построения нейронных сетей и их применение в конкретных задачах подробно рассматриваются в статьях «Нейронные сети — математический аппарат», «Применение нейронных сетей для задач классификации» и «NeuralBase — нейросеть за 5 минут».

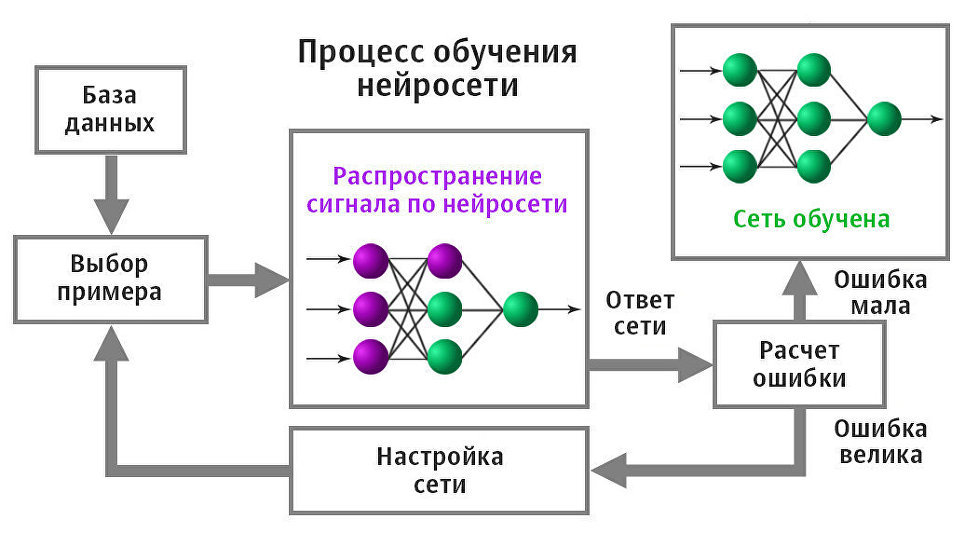

Обучение нейронной сети с учителем, без учителя, с подкреплением

Обучить нейронную сеть можно разными способами: с учителем, без учителя, с подкреплением. Но как выбрать оптимальный алгоритм и чем они отличаются? Есть несколько способов собрать мебель из IKEA.

Каждый из них приводит к собранному дивану или стулу. Но в зависимости от предмета мебели и его составляющих один способ будет более разумным, чем другие.

Есть руководство по эксплуатации и все нужные детали? Просто следуйте инструкции. Ну как, получается? Можно выбросить руководство и работать самостоятельно. Но стоит перепутать порядок действий, и уже вам решать, что делать с этой кучей деревянных болтов и досок.

Все то же самое с глубоким обучением (deep learning). Разработчик предпочтет алгоритм с конкретным способом обучения, учитывая вид данных и стоящую перед ним задачу.

Результат обучения нейронной сети — кластеризация изображений

При обучении с учителем нейронная сеть обучается на размеченном наборе данных и предсказывает ответы, которые используются для оценки точности алгоритма на обучающих данных. При обучении без учителя модель использует неразмеченные данные, из которых алгоритм самостоятельно пытается извлечь признаки и зависимости.

Обучение с частичным привлечением учителя представляет собой нечто среднее.

Оно использует небольшое количество размеченных данных и большой набор неразмеченных. А обучение с подкреплением тренирует алгоритм при помощи системы поощрений. Агент получает обратную связь в виде вознаграждений за правильные действия. Похожим образом дрeссируют животных.

Для каждого способа обучения рассмотрим примеры подходящих для него данных и задач.

Обучение с учителем

Обучение с учителем (supervised learning) предполагает наличие полного набора размеченных данных для тренировки модели на всех этапах ее построения.

Наличие полностью размеченного датасета означает, что каждому примеру в обучающем наборе соответствует ответ, который алгоритм и должен получить. Таким образом, размеченный датасет из фотографий цветов обучит нейронную сеть, где изображены розы, ромашки или нарциссы. Когда сеть получит новое фото, она сравнит его с примерами из обучающего датасета, чтобы предсказать ответ.

Пример обучения с учителем — классификация (слева), и дальнейшее ее использование для сегментации и распознавания объектов

В основном обучение с учителем применяется для решения двух типов задач: классификации и регрессии.

В задачах классификации алгоритм предсказывает дискретные значения, соответствующие номерам классов, к которым принадлежат объекты. В обучающем датасете с фотографиями животных каждое изображение будет иметь соответствующую метку — «кошка», «коала» или «черепаха». Качество алгоритма оценивается тем, насколько точно он может правильно классифицировать новые фото с коалами и черепахами.

А вот задачи регрессии связаны с непрерывными данными. Один из примеров, линейная регрессия, вычисляет ожидаемое значение переменной y, учитывая конкретные значения x.

Более утилитарные задачи машинного обучения задействуют большое число переменных. Как пример, нейронная сеть, предсказывающая цену квартиры в Сан-Франциско на основе ее площади, местоположения и доступности общественного транспорта. Алгоритм выполняет работу эксперта, который рассчитывает цену квартиры исходя из тех же данных.

Таким образом, обучение с учителем больше всего подходит для задач, когда имеется внушительный набор достоверных данных для обучения алгоритма.

Но так бывает далеко не всегда. Недостаток данных — наиболее часто встречающаяся проблема в машинном обучении на 2018 год.

Обучение без учителя

Идеально размеченные и чистые данные достать нелегко. Поэтому иногда перед алгоритмом стоит задача найти заранее не известные ответы. Вот где нужно обучение без учителя.

В обучении без учителя (unsupervised learning) у модели есть набор данных, и нет явных указаний, что с ним делать. Нейронная сеть пытается самостоятельно найти корелляции в данных, извлекая полезные признаки и анализируя их.

Кластеризация данных на основе общих признаков

В зависимости от задачи модель систематизирует данные по-разному.

- Кластеризация. Даже без специальных знаний эксперта-орнитолога можно посмотреть на коллекцию фотографий и разделить их на группы по видам птиц, опираясь на цвет пера, размер или форму клюва. Именно в этом заключается кластеризация — наиболее распространенная задача для обучения без учителя.

Алгоритм подбирает похожие данные, находя общие признаки, и группируют их вместе.

- Обнаружение аномалий. Банки могут обнаружить мошеннические операции, выявляя необычные действия в покупательском поведении клиентов. Например, подозрительно, если одна кредитная карта используется в Калифорнии и Дании в один и тот же день. Похожим образом, обучение без учителя используют для нахождения выбросов в данных.

- Ассоциации. Выберете в онлайн-магазине подгузники, яблочное пюре и детскую кружку-непроливайку и сайт порекомендует вам добавить нагрудник и радионяню к заказу. Это пример ассоциаций: некоторые характеристики объекта коррелируют с другими признаками. Рассматривая пару ключевых признаков объекта, модель может предсказать другие, с которыми существует связь.

- Автоэнкодеры. Автоэнкодеры принимают входные данные, кодируют их, а затем пытаются воссоздать начальные данные из полученного кода. Не так много реальных ситуаций, когда используют простой автоэнкодер.

Но стоит добавить слои и возможности расширятся: используя зашумленные и исходные версии изображений для обучения, автоэнкодеры могут удалять шум из видеоданных, изображений или медицинских сканов, чтобы повысить качество данных.

В обучении без учителя сложно вычислить точность алгоритма, так как в данных отсутствуют «правильные ответы» или метки. Но размеченные данные часто ненадежные или их слишком дорого получить. В таких случаях, предоставляя модели свободу действий для поиска зависимостей, можно получить хорошие результаты.

Обучение с частичным привлечением учителя

Это золотая середина.

Обучение с частичным привлечением учителя (semi-supervised learning) характеризуется своим названием: обучающий датасет содержит как размеченные, так и неразмеченные данные. Этот метод особенно полезен, когда трудно извлечь из данных важные признаки или разметить все объекты – трудоемкая задача.

Обучение с частичным привлечением учителя часто используют для решения медицинских задач, где небольшое количество размеченных данных может привести к значительному повышению точности

Этот метод машинного обучения распространен для анализа медицинских изображений, таких как сканы компьютерной томографии или МРТ.

Опытный рентгенолог может разметить небольшое подмножество сканов, на которых выявлены опухоли и заболевания. Но вручную размечать все сканы — слишком трудоемкая и дорогостоящая задача. Тем не менее нейронная сеть может извлечь информацию из небольшой доли размеченных данных и улучшить точность предсказаний по сравнению с моделью, обучающейся исключительно на неразмеченных данных.

Популярный метод обучения, для которого требуется небольшой набор размеченных данных, заключается в использовании генеративно-состязательной сети или GAN.

Представьте себе соревнование двух нейронных сетей, где каждая пытается перехитрить другую. Это GAN. Одна из сетей, генератор, пытается создать новые объекты данных, которые имитируют обучающую выборку. Другая сеть, дискриминатор, оценивает, являются ли эти сгенерированные данные реальными или поддельными. Сети взаимодействуют и циклично совершенствуются, поскольку дискриминатор старается лучше отделять подделки от оригиналов, а генератор пытается создавать убедительные подделки.

Как работает GAN: дискриминатору «D» показывают исходные изображения и данные, созданные генератором «G». Дискриминатор должен определить, какие изображения являются реальными, а какие поддельными.

Обучение с подкреплением

Видеоигры основаны на системе стимулов. Завершите уровень и получите награду. Победите всех монстров и заработаете бонус. Попали в ловушку – конец игры, не попадайте. Эти стимулы помогают игрокам понять, как лучше действовать в следующем раунде игры. Без обратной связи люди бы просто принимали случайные решения и надеялись перейти на следующий игровой уровень.

Обучение с подкреплением (reinforcement learning) действует по тому же принципу. Видеоигры — популярная тестовая среда для исследований.

Результат обучения с подкреплением — «агент» проходит трассу, не выезжая за ее пределы. Далее можно добивиться повышения скорости прохождения трассы.

Агенты ИИ пытаются найти оптимальный способ достижения цели или улучшения производительности для конкретной среды.

Когда агент предпринимает действия, способствующие достижению цели, он получает награду. Глобальная цель — предсказывать следующие шаги, чтобы заработать максимальную награду в конечном итоге.

При принятии решения агент изучает обратную связь, новые тактики и решения способные привести к большему выигрышу. Этот подход использует долгосрочную стратегию — так же как в шахматах: следующий наилучший ход может не помочь выиграть в конечном счете. Поэтому агент пытается максимизировать суммарную награду.

Это итеративный процесс. Чем больше уровней с обратной связи, тем лучше становится стратегия агента. Такой подход особенно полезен для обучения роботов, которые управляют автономными транспортными средствами или инвентарем на складе.

Так же, как и ученики в школе, каждый алгоритм учится по-разному. Но благодаря разнообразию доступных методов, вопрос в том, чтобы выбрать подходящий и научить вашу нейронную сеть разбираться в среде.

Интересные статьи:

Виды и классификация нейронных сетей.

Основные типы

Центральная нервная система (ЦНС) человека и животных состоит из огромного количества особых клеток, связанных между собой (нейронов). Искусственные нейронные сети являются математическим прототипом одного из отделов ЦНС. Давайте рассмотрим, какие виды нейронных сетей бывают и какие задачи решаются с их помощью.

Нейронные сети, в общем виде, представляют собой вычислительные структуры, которые моделируют простые биологические процессы. В качестве ассоциации выступают, например, процессы активации и торможения нейронов в коре головного мозга.

Элементарным преобразователем внутри любой нейронной сети является искусственный нейрон. В этой и других статьях для простоты мы будем называть его просто нейроном.

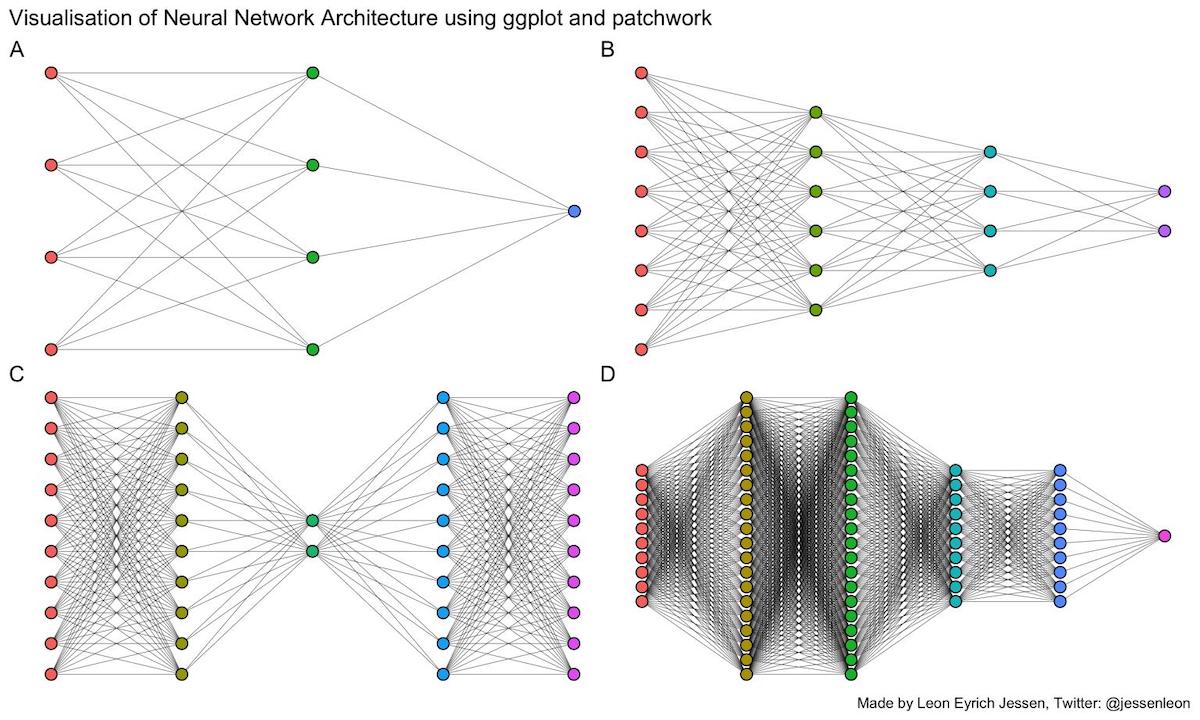

Теперь перейдем непосредственно к классификации нейронных сетей (НС).

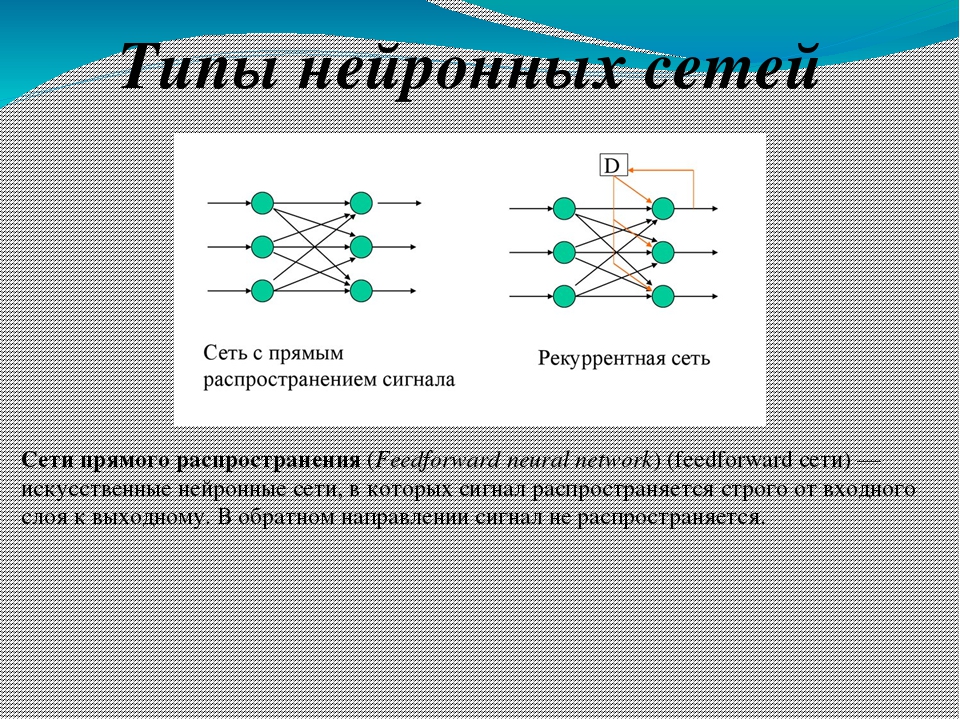

Итак, очень многие начинающие знакомиться с нейроинформатикой вообще не видят различий между архитектурами сетей, и любая нейронная сеть для них – это однослойный или многослойный перцептрон – сеть прямого распространения, итерационно обучающаяся с учителем.

Как вы увидите далее, это далеко от истины.

Существуют сети радиально-базисных функций, которые также имеют прямонаправленную структуру связей, обучаются с учителем, но веса рассчитываются однократно как один из случаев метода наименьших квадратов.

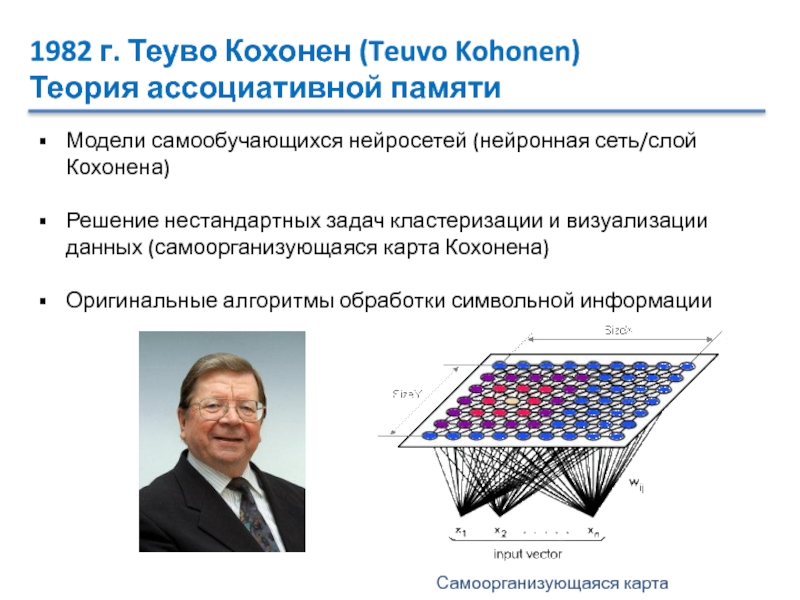

К сетям, обучающимся без учителя (самообучающимся или самоорганизующимся) относят, например, сети Кохонена и адаптивного резонанса, различающиеся корректирующими соотношениями и форматами представления входных данных. И эти сети тоже – прямого распространения.

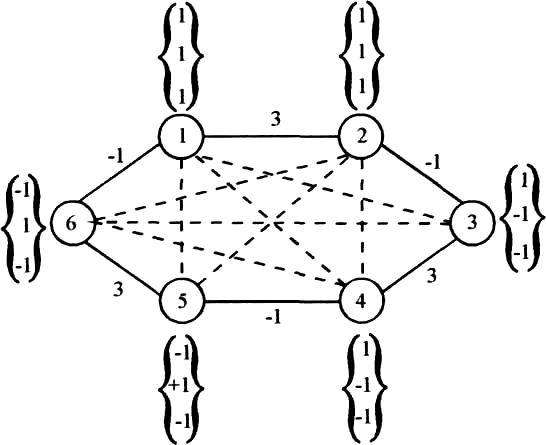

А вот обратные связи от выходов к предыдущим слоям имеют, например сети Хопфилда, Коско и Хэмминга. Внутренние различия их архитектур, а также способов представления и обработки сигналов приводят к тому, что они могут решать совершенно разные задачи.

Как классифицировать нейронные сети?

В зависимости от критерия классификации, можно разделить НС на различные типы. Мы можем классифицировать данный метод искусственного интеллекта по следующим признакам:

- По способу обучения

- По топологии

- По модели НС

- По способу настройки весовых коэффициентов

- По задачам, решаемым при помощи НС

Ниже на рисунке показана наиболее универсальная классификация по первым четырем признакам.

Универсальная классификация нейронных сетей

Классификация нейронных сетей по топологии

Классификация нейронных сетей по типу решаемой задачи

На изображении ниже показана взаимосвязь между решаемой задачей и используемом типом НС.

Выводы

Мы рассмотрели наиболее популярные виды искусственных нейронных сетей и показали, какие задачи могут решаться с их помощью, привели несколько видов классификаций нейросетей по различным критериям.

P.S. Если по вашему мнению, мы забыли какой-то тип нейронных сетей, напишите об этом ниже в комментариях!

Информация

Посетители, находящиеся в группе Гости, не могут оставлять комментарии к данной публикации.Нейронные сети. Пугающий пример — Блог Артема Краснова

В 2016 году искусственный интеллект AlphaGo обыграл лучшего игрока в го Ли Седоля со счетом 4-1. Сама по себе игра го считалась неподходящей для машинной логики, поэтому компьютер одолел человека значительно позже, чем в шахматы, где машины превзошли лучших из хомо сапиенсов 20 лет назад.

Но пугает не это.

Как известно, нейронные сети обучаются на примерах, скажем, чтобы они распознавали человеческие лица, им «показывают» огромное количество фотографий (которые берутся в том числе с наших юзерпиков в соцсетях). Примерно также обучался интеллект AlphaGo — на огромном массиве партий, в которых человек играл против человека.

В прошлом году вышла новая версия программы AlphaGo Zero, которая не использовала человеческий опыт. Она обучалась с нуля, играя против себя. Нейронной сети «объяснили» правила игры в го и больше ничего.

Короче, она начала играть сама против себя. За победу нейронная сеть получала «награду», то есть у нее был математический аналог нашего чувства триумфа, к максимизации которого система стремилась. Сначала сеть делала случайные ходы, примерно как играл бы двухлетний ребенок. Затем она анализировала ситуацию и обучалась, усложняя связи между узлами нейронной сети.

Результат? Через три дня такой практики версия Zero обыграла первую, обученную человеком, сеть AlphaGo Lee в 100 партиях из 100.

Ту самую программу, которая победила Ли Седоля.

Через 21 день обучения AlphaGo Zero достигла уровня модифицированной версии AlphaGo Masters, которая победила 60 лучших игроков в го, включая Ли Седоля — последнего в трех партиях из трех. Еще через 40 дней Zero была признана лучшим игроком в го из когда-либо существовавших.

Интересно, что обучение было нелинейным, например, в отличие от человека, программа иногда осваивала сложные комбинации быстрее, чем простые. В конечном итоге она сама разработала ряд неизвестных ранее тактических схем, которые сейчас изучают профессионалы го, почесывая свои резко обесценившиеся репы.

Но го, повторюсь, является довольно сложной игрой для искусственного интеллекта. Что до шахмат, то за четыре часа (!) самообучения AlphaZero победила компьютерную программу Stockfish 8, которая отличалась одним из самых высоких уровней мастерства.

Счет, правда, был не совсем сухой — 25 побед белыми, 3 победы черными, остальные ничьи (при таком уровне игроков право первого хода имеет важное значение).

Причем если Stockfish 8 вынуждена анализировать порядка 70 млн комбинаций в секунду, то более гибкий алгоритм нейронной сети выбирает из 80 тысяч.

Еще более разгромным было преимущество «альфы» в игре сёги — японском аналоге шахмат: здесь нейронная сеть одолела программу Elmo со счетом 90:8, две игры в ничью.

Сам по себе факт компьютерного превосходства в логических играх не вызывает удивления, ведь программа способна синтезировать качества лучших игроков за минусом волнения и человеческого фактора. Но ладно бы это был именно синтез того, что дал человек — такой подход оставляет возможность намеренно «недодать», чтобы обеспечить себе хотя бы теоретическое преимущество. Но самообучающийся интеллект выглядит зловеще как минимум потому, что мы не видим реального предела его возможностей: чему научится AlphaZero через год эмуляций?

Впрочем, логические игры все же являются абстракциями, удобными для искусственного интеллекта. Черная пешка не может подкупить белого слона, а ферзь не перестанет ходить по прямой из-за смерти любимого коня.

«Жизненный интеллект» требует гораздо большего разнообразия и гибкости.

И поэтому активно идут работы над универсальным искусственным интеллектом, который, в отличие от узкоспециализированных, способен решить любую интеллектуальную задачу.

И вот здесь нас ждет еще несколько сюрпризов. К примеру, популярная игра GTA5 используется для обучения роботов-водителей. На первый взгляд, идея выглядит бредовой, тем более, «гэ-тэ-а» поощряет жестокость и насилие, что порождает самые жуткие аллюзии на «Терминатора». На самом деле разработчики автопилота используют лишь детальный движок GTA5 для эмуляции дорожных ситуаций, чтобы не зацикливать программу только на «лабораторных» сценариях. Хорошая графика и близкая к реальной физика позволяют научить искусственный интеллект правильному распознаванию любых объектов и поведению в сложных ситуациях, от банальных до критических. Это не исключает обучения «на натуре», но можно представить, насколько быстрее и разнообразнее будет натаскивание нейронных сетей, подобных AlphaZero, на компьютерных стимуляциях.

Тем более, такое обучение почти бесплатно.

Вы все еще уверены, что автопилот не для России, потому что у нас снег и не все знаки логичны? Я уверен, одним из этапов обучения будет езда по «слепому» виртуальному городу, где не видно ни разметки, ни знаков, а половина водителей пьяные.

Обучение на играх набирает обороты, причем иногда используются самые примитивные игрушки уровня Atari, где задача нейронной сети — быстро понять правила и достигнуть высшего уровня мастерства. Есть программные среды, состоящие из десятков подобных игр, в которых нейронная сеть учится гибкости. И, кстати, игру она воспринимает «по-человечески», то есть у нее есть только визуальная пиксельная картинка с монитора и доступ к стандартным органам управления — мышки, кнопкам или джойстику.

Хотя эксперты уверены, что искусственный интеллект еще долго будет слишком «узкоспециализированным» для вызова человеку, меня заботит вот какая мысль. Я не очень любил логические игры, но меня несколько раз по уши засосало в военные стратегии или игры типа SimSity.

Позже, читая о баталиях, я находил массу параллелей с играми, которые пусть с некоторой условностью, но воспроизводили реальность. В хорошей военной стратегии вполне можно научиться оптимально распределять ресурсы, вычислять наиболее вероятный ход противника, организовывать снабжение армии…

Отсюда вопрос: что будет, если AlphaZero пару месяцев поиграет сама с собой в лучшую военную стратегию, которую можно купить долларов за 100?

Поделиться ссылкой:

Похожее

Самоорганизующиеся карты Кохонена — математический аппарат

Самоорганизующиеся карты — это одна из разновидностей нейросетевых алгоритмов. Основным отличием данной технологии от нейросетей, обучаемых по алгоритму обратного распространения, является то, что при обучении используется метод обучения без учителя, то есть результат обучения зависит только от структуры входных данных.

Нейронные сети данного типа часто применяются для решения самых различных задач, от восстановления пропусков в данных до анализа данных и поиска закономерностей, например, в финансовой задаче.

В данной статье мы рассмотрим принципы функционирования и некоторые аспекты использования самоорганизующихся карт.

Основы

Алгоритм функционирования самообучающихся карт (Self Organizing Maps — SOM) представляет собой один из вариантов кластеризации многомерных векторов. Примером таких алгоритмов может служить алгоритм k-ближайших средних (k-means). Важным отличием алгоритма SOM является то, что в нем все нейроны (узлы, центры классов…) упорядочены в некоторую структуру (обычно двумерную сетку).

При этом в ходе обучения модифицируется не только нейрон-победитель, но и его соседи, но в меньшей степени. За счет этого SOM можно считать одним из методов проецирования многомерного пространства в пространство с более низкой размерностью. При использовании этого алгоритма вектора, схожие в исходном пространстве, оказываются рядом и на полученной карте.

Структура

SOM подразумевает использование упорядоченной структуры нейронов. Обычно используются одно и двумерные сетки.

T, где n определяется размерностью исходного пространства (размерностью входных векторов). Применение одно и двумерных сеток связано с тем, что возникают проблемы при отображении пространственных структур большей размерности (при этом опять возникают проблемы с понижением размерности до двумерной, представимой на мониторе).

Обычно нейроны располагаются в узлах двумерной сетки с прямоугольными или шестиугольными ячейками. При этом, как было сказано выше, нейроны также взаимодействуют друг с другом. Величина этого взаимодействия определяется расстоянием между нейронами на карте. На рисунке 1 дан пример расстояния для шестиугольной и четырехугольной сеток.

Рисунок 1. Расстояние между нейронами на карте для шестиугольной (а) и четырехугольной (б) сеток. При этом легко заметить, что для шестиугольной сетки расстояние между нейронами больше совпадает с евклидовым расстоянием, чем для четырехугольной сетки.

Количество нейронов в сетке определяет степень детализации результата работы алгоритма, и в конечном счете от этого зависит точность обобщающей способности карты.

Начальная инициализация карты

При реализации алгоритма SOM заранее задается конфигурация сетки (прямоугольная или шестиугольная), а также количество нейронов в сети. Некоторые источники рекомендуют использовать максимально возможное количество нейронов в карте. При этом начальный радиус обучения (neighborhood в англоязычной литературе) в значительной степени влияет на способность обобщения при помощи полученной карты.

В случае, когда количество узлов карты превышает количество примеров в обучающей выборке, то успех использования алгоритма в большой степени зависит от подходящего выбора начального радиуса обучения. Однако, в случае, когда размер карты составляет десятки тысяч нейронов, то время, требуемое на обучение карты, обычно бывает слишком велико для решения практических задач. Таким образом необходимо достигать допустимого компромисса при выборе количества узлов.

Перед началом обучения карты необходимо проинициализировать весовые коэффициенты нейронов. Удачно выбранный способ инициализации может существенно ускорить обучение, и привести к получению более качественных результатов.

Существуют три способа инициирования начальных весов.

- Инициализация случайными значениями, когда всем весам даются малые случайные величины.

- Инициализация примерами, когда в качестве начальных значений задаются значения случайно выбранных примеров из обучающей выборки

- Линейная инициализация. В этом случае веса инициируются значениями векторов, линейно упорядоченных вдоль линейного подпространства, проходящего между двумя главными собственными векторами исходного набора данных. Собственные вектора могут быть найдены например при помощи процедуры Грама-Шмидта.

Обучение

Обучение состоит из последовательности коррекций векторов, представляющих собой нейроны. На каждом шаге обучения из исходного набора данных случайно выбирается один из векторов, а затем производится поиск наиболее похожего на него вектора коэффициентов нейронов. При этом выбирается нейрон-победитель, который наиболее похож на вектор входов. Под похожестью в данной задаче понимается расстояние между векторами, обычно вычисляемое в евклидовом пространстве.

Таким образом, если обозначим нейрон-победитель как c, то получим

\mid\mid\mathbf {x}- \mathbf {w_c}\mid \mid = \min_i \{ \mid \mid \mathbf {x}- \mathbf {w_i}\mid \mid \}

После того, как найден нейрон-победитель, производится корректировка весов нейросети. При этом вектор, описывающий нейрон-победитель и вектора, описывающие его соседей в сетке перемещаются в направлении входного вектора. Это проиллюстрировано на рисунке 2 для двумерного вектора.

Рисунок 2. Подстройка весов нейрона победителя и его соседей. Координаты входного вектора отмечены крестом, координаты узлов карты после модификации отображены серым цветом. Вид сетки после модификации отображен штриховыми линиями.

При этом для модификации весовых коэффициентов используется формула:

w_i (t+1)= \mathbf w_i(t) + h_{ci}(t) * [\mathbf x(t) — \mathbf w (t)],

где t обозначает номер эпохи (дискретное время). При этом вектор x(t) выбирается случайно из обучающей выборки на итерации t. Функция h(t) называется функцией соседства нейронов и представляет собой невозрастающую функцию от времени и расстояния между нейроном-победителем и соседними нейронами в сетке.

{- \frac{d}{2\sigma (t))}}

При этом лучший результат получается при использовании Гауссовой функции расстояния.

Часто эту величину называют радиусом обучения, который выбирается достаточно большим на начальном этапе обучения и постепенно уменьшается так, что в конечном итоге обучается один нейрон-победитель. Наиболее часто используется функция, линейно убывающая от времени.

Рассмотрим теперь функцию скорости обучения a(t). Эта функция также представляет собой функцию, убывающую от времени. Наиболее часто используются два варианта этой функции: линейная и обратно пропорциональная времени вида a(t) = \frac {\ A } {\ {t + B} }, где A и B — это константы.

Применение этой функции приводит к тому, что все вектора из обучающей выборки вносят примерно равный вклад в результат обучения.

Обучение состоит из двух основных фаз: на первоначальном этапе выбирается достаточно большое значение скорости обучения и радиуса обучения, что позволяет расположить вектора нейронов в соответствии с распределением примеров в выборке, а затем производится точная подстройка весов, когда значения параметров скорости обучения много меньше начальных.

В случае использования линейной инициализации первоначальный этап грубой подстройки может быть пропущен.

Применение алгоритма

Так как алгоритм SOM сочетает в себе два основных направления – векторное квантование и проецирование, то можно найти и основные применения этого алгоритма. Данную методику можно использовать для поиска и анализа закономерностей в исходных данных. После того, как нейроны размещены на карте, полученная карта может быть отображена. Рассмотрим различные способы отображения полученной карты.

Раскраска, порожденная отдельными компонентами

При данном методе отрисовки полученную карту можно представить в виде слоеного пирога. Каждый слой которого представляет собой раскраску, порожденную одной из компонент исходных данных. Полученный набор раскрасок может использоваться для анализа закономерностей, имеющихся между компонентами набора данных.

После формирования карты мы получаем набор узлов, который можно отобразить в виде двумерной картинки.

При этом каждому узлу карты можно поставить в соответствие участок на рисунке, четырех или шестиугольный, координаты которого определяются координатами соответствующего узла в решетке. Теперь для визуализации осталось только определить цвет ячеек этой картинки. Для этого и используются значения компонент.

Самый простой вариант — использование градаций серого. В этом случае ячейки, соответствующие узлам карты, в которые попали элементы с минимальными значениями компонента или не попало вообще ни одной записи, будут изображены черным цветом, а ячейки, в которые попали записи с максимальными значениями такого компонента, будут соответствовать ячейки белого цвета. В принципе, можно использовать любую градиентную палитру для раскраски.

Полученные раскраски в совокупности образуют атлас, отображающий расположение компонент, связи между ними, а также относительное расположение различных значений компонент.

Отображение кластеров

Кластером будет являться группа векторов, расстояние между которыми внутри этой группы меньше, чем расстояние до соседних групп.

Структура кластеров при использовании алгоритма SOM может быть отображена путем визуализации расстояния между опорными векторами (весовыми коэффициентами нейронов).

При использовании этого метода чаще всего используется унифицированная матрица расстояний (u-matrix). Для этого вычисляется расстояние между вектором весов нейрона в сетке и его ближайшими соседями. Затем эти значения используются для определения цвета, которым этот узел будет отрисован.

Обычно используют градации серого, причем чем больше расстояние, тем темнее отрисовывается узел. При таком использовании узлам с наибольшим расстоянием между ними и соседями соответствует черный цвет, а близлежащим узлам — белый.

Литература

- Ф.Уоссермен, «Нейрокомпьютерная техника» , М.: Мир, 1992

- А.Ежов, С.Шумский, «Нейрокомпьютинг и его применение в экономике и бизнесе»,1998.

- T.Kohonen, «Self-Organizing Maps», Springer, 1995.

- T.Kohonen, «Self-Organizing Maps»(2-nd edition), Springer, 1997.

- Juho Vensano, «Data Mining Techniques Baseg on the Self Organized Map»

Другие материалы:

Loginom Community Edition — аналитика, доступная каждому

Интервью Алексея Арустамова для медиахолдинга РБК

Объяснение: Нейронные сети | MIT News

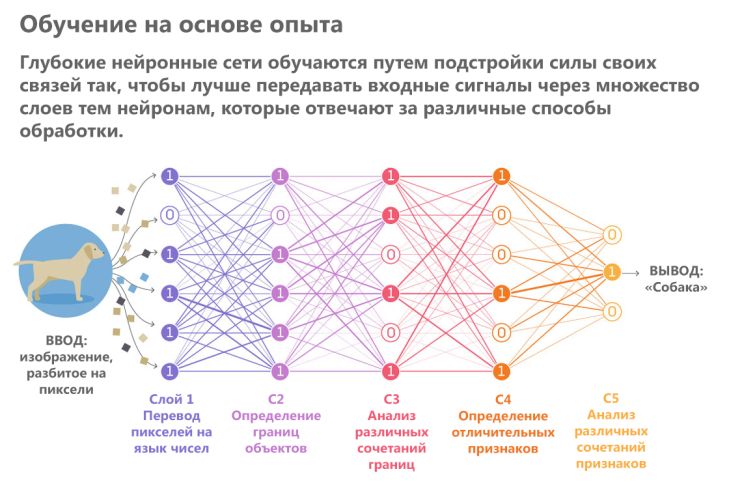

За последние 10 лет самые эффективные системы искусственного интеллекта, такие как распознаватели речи на смартфонах или новейший автоматический переводчик Google, были созданы с помощью техники, называемой «глубокое обучение».

Глубокое обучение — это фактически новое название подхода к искусственному интеллекту, называемого нейронными сетями, который входил и выходил из моды уже более 70 лет. Нейронные сети были впервые предложены в 1944 году Уорреном Маккаллоу и Уолтером Питтсом, двумя исследователями из Чикагского университета, которые переехали в Массачусетский технологический институт в 1952 году в качестве членов-основателей того, что иногда называют первым отделом когнитивной науки.

Нейронные сети были основным направлением исследований как нейробиологии, так и информатики до 1969 года, когда, согласно знаниям информатики, они были убиты математиками Массачусетского технологического института Марвином Мински и Сеймуром Папертом, которые через год стали содиректорами. новой лаборатории искусственного интеллекта Массачусетского технологического института.

Затем эта техника возродилась в 1980-х, снова потеряла свою актуальность в первом десятилетии нового века и вернулась, как громила во втором, во многом благодаря возросшей вычислительной мощности графических чипов.

«Есть мнение, что идеи в науке чем-то похожи на эпидемии вирусов», — говорит Томазо Поджио, профессор мозга и когнитивных наук Юджина Макдермотта в Массачусетском технологическом институте, исследователь Института исследований мозга Макговерна при Массачусетском технологическом институте и директор центра Массачусетского технологического института. для мозга, разума и машин. «По-видимому, существует пять или шесть основных штаммов вирусов гриппа, и, по всей видимости, каждый из них возвращается примерно через 25 лет.

Люди заражаются, у них развивается иммунный ответ, поэтому они не заражаются в течение следующих 25 лет.А еще есть новое поколение, готовое заразиться тем же штаммом вируса. В науке люди влюбляются в идею, воодушевляются ею, забивают ее до смерти, а затем получают иммунизацию — они устают от нее. Так что идеи должны иметь одинаковую периодичность! »

Важные вопросы

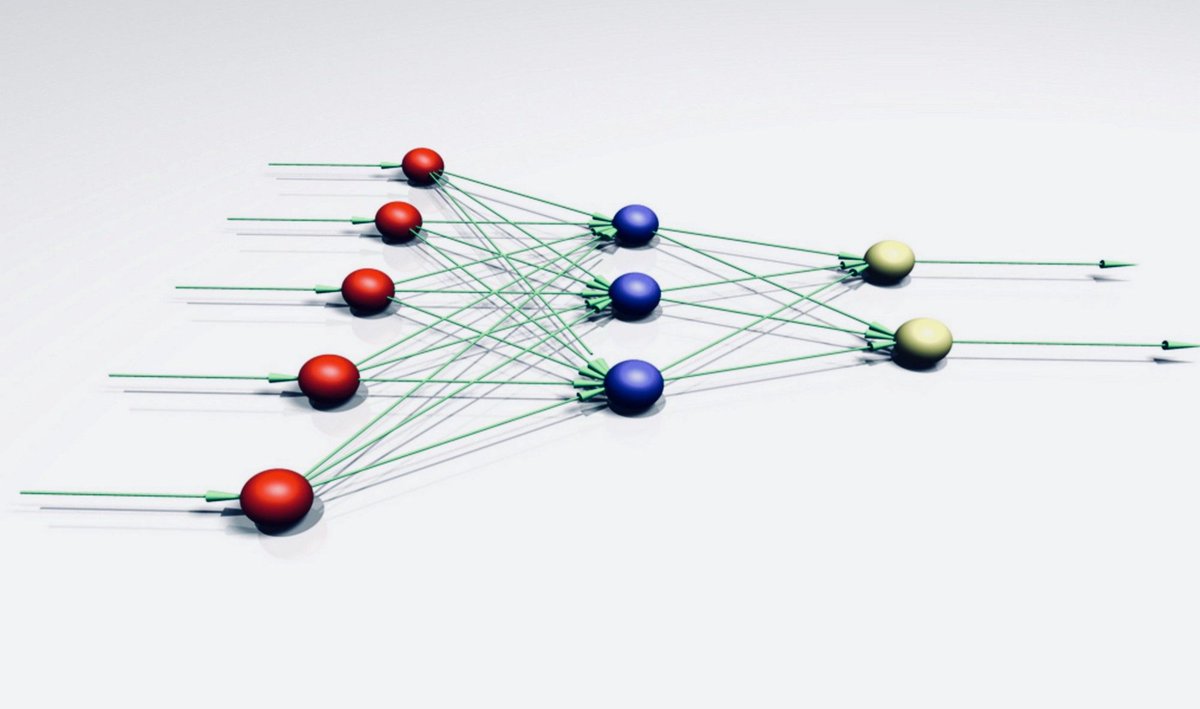

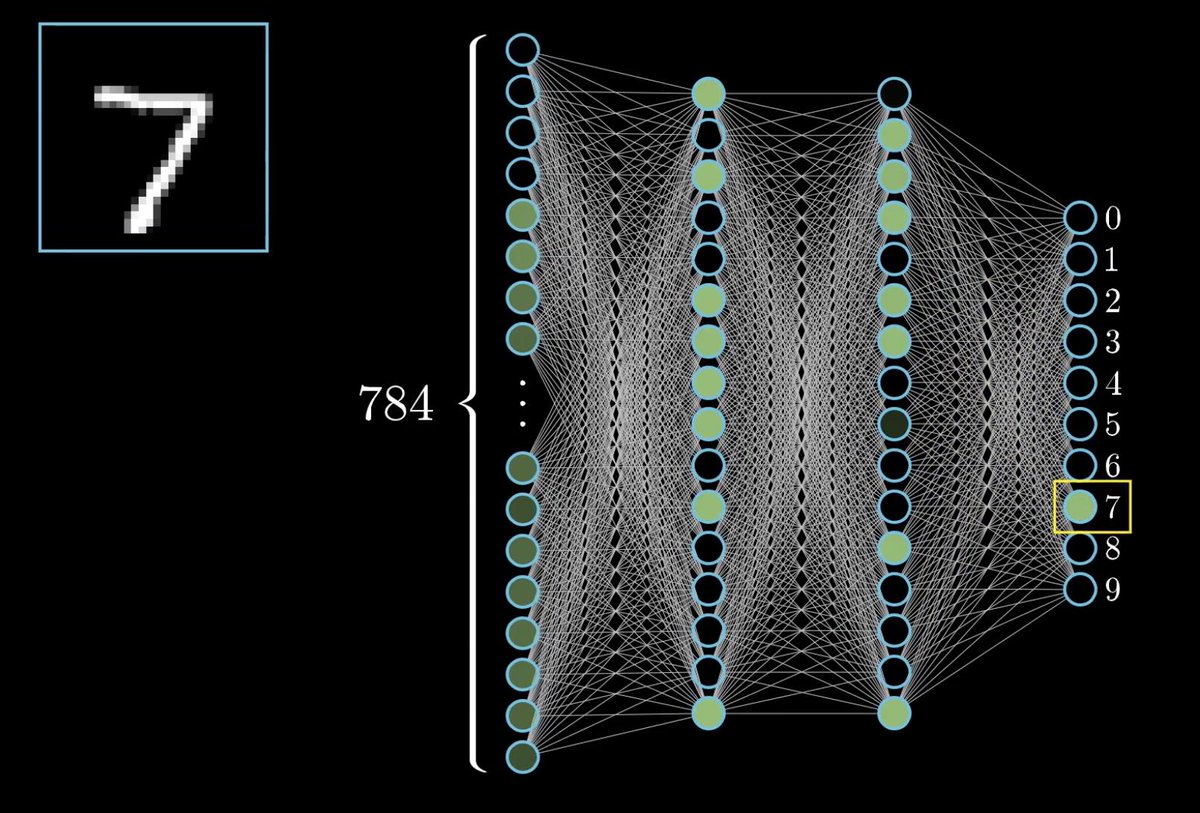

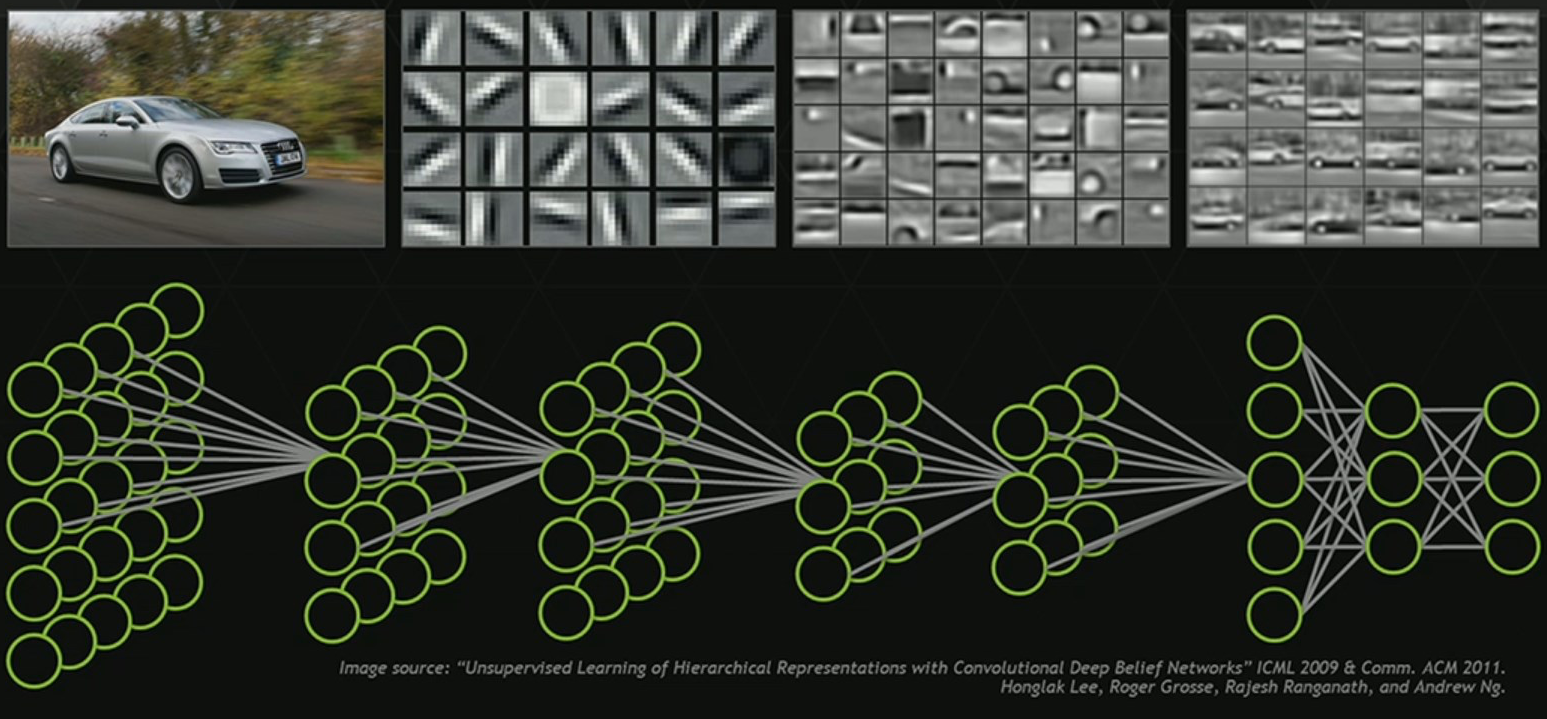

Нейронные сети — это средство машинного обучения, при котором компьютер учится выполнять некоторые задачи, анализируя обучающие примеры. Обычно образцы маркируются заранее вручную.Система распознавания объектов, например, могла бы получать тысячи изображений автомобилей, домов, кофейных чашек и т. Д. С этикетками и находить на изображениях визуальные паттерны, которые постоянно соотносятся с определенными этикетками.

Нейронная сеть, смоделированная на основе человеческого мозга, состоит из тысяч или даже миллионов простых узлов обработки, которые плотно связаны между собой. Большинство современных нейронных сетей организованы в слои узлов, и они имеют «прямую связь», что означает, что данные проходят через них только в одном направлении.

Отдельный узел может быть подключен к нескольким узлам на нижнем уровне, от которого он получает данные, и к нескольким узлам на верхнем уровне, которым он отправляет данные.

Каждому из своих входящих соединений узел присваивает номер, известный как «вес». Когда сеть активна, узел получает другой элемент данных — другое число — по каждому из своих соединений и умножает его на соответствующий вес. Затем он складывает полученные продукты вместе, получая одно число.Если это число ниже порогового значения, узел не передает данные на следующий уровень. Если число превышает пороговое значение, узел «срабатывает», что в современных нейронных сетях обычно означает отправку числа — суммы взвешенных входных данных — по всем его исходящим соединениям.

Когда нейронная сеть обучается, все ее веса и пороги изначально устанавливаются на случайные значения. Обучающие данные поступают на нижний уровень — входной уровень — и проходят через последующие уровни, умножаются и складываются сложным образом, пока, наконец, не попадают, радикально преобразованные, на выходной уровень.

Во время обучения веса и пороги постоянно корректируются до тех пор, пока данные обучения с одинаковыми метками не будут давать одинаковые результаты.

Умы и машины

У нейронных сетей, описанных Маккаллоу и Питтсом в 1944 году, были пороговые значения и веса, но они не были расположены по слоям, и исследователи не указали какой-либо механизм обучения. Маккалоу и Питтс показали, что нейронная сеть, в принципе, может вычислить любую функцию, которую может выполнить цифровой компьютер.Результатом стало больше нейробиологии, чем информатики: суть заключалась в том, чтобы предположить, что человеческий мозг можно рассматривать как вычислительное устройство.

Нейронные сети продолжают оставаться ценным инструментом для нейробиологических исследований. Например, определенные схемы сети или правила настройки весов и пороговых значений воспроизводят наблюдаемые особенности нейроанатомии и познания человека, что свидетельствует о том, что они фиксируют что-то о том, как мозг обрабатывает информацию.

Первая обучаемая нейронная сеть, Персептрон, была продемонстрирована психологом Корнельского университета Фрэнком Розенблаттом в 1957 году.Дизайн персептрона был очень похож на дизайн современной нейронной сети, за исключением того, что он имел только один слой с регулируемыми весами и порогами, зажатый между входным и выходным слоями.

Персептроны были активной областью исследований как в психологии, так и в молодой дисциплине информатики до 1959 года, когда Мински и Паперт опубликовали книгу под названием «Персептроны», которая продемонстрировала, что выполнение некоторых довольно распространенных вычислений на персептронах будет непрактично трудоемким.

«Конечно, все эти ограничения как бы исчезают, если вы возьмете немного более сложное оборудование, например, двухуровневое», — говорит Поджио. Но в то время книга оказала сдерживающее влияние на исследования нейронных сетей.

«Вы должны поместить эти вещи в исторический контекст», — говорит Поджио. «Они выступали за программирование — для таких языков, как Lisp.

Не так давно люди все еще использовали аналоговые компьютеры. В то время было совершенно неясно, что программирование — это правильный путь.Думаю, они немного переборщили, но, как обычно, это не черно-белое изображение. Если вы думаете об этом как об этой конкуренции между аналоговыми вычислениями и цифровыми вычислениями, они боролись за то, что в то время было правильным ».

Периодичность

Однако к 1980-м годам исследователи разработали алгоритмы для изменения весов и пороговых значений нейронных сетей, которые были достаточно эффективными для сетей с более чем одним слоем, устранив многие ограничения, указанные Мински и Папертом.Поле пережило ренессанс.

Но интеллектуально в нейронных сетях есть что-то неудовлетворительное. Достаточное обучение может изменить настройки сети до такой степени, что она сможет с пользой классифицировать данные, но что означают эти настройки? На какие особенности изображения смотрит распознаватель объектов и как он объединяет их в отличительные визуальные подписи автомобилей, домов и кофейных чашек? Глядя на веса отдельных связей, мы не ответим на этот вопрос.

В последние годы компьютерные ученые начали придумывать гениальные методы для вывода аналитических стратегий, используемых нейронными сетями.Но в 80-е годы стратегии сетей было невозможно расшифровать. Таким образом, на рубеже веков нейронные сети были вытеснены машинами опорных векторов, альтернативным подходом к машинному обучению, основанным на очень чистой и элегантной математике.

Недавнее возрождение нейронных сетей — революция глубокого обучения — произошло благодаря индустрии компьютерных игр. Сложные изображения и быстрый темп современных видеоигр требуют оборудования, способного не отставать, и в результате появился графический процессор (GPU), который объединяет тысячи относительно простых процессорных ядер на одном кристалле.Исследователям не потребовалось много времени, чтобы понять, что архитектура графического процессора удивительно похожа на архитектуру нейронной сети.

Современные графические процессоры позволили однослойным сетям 1960-х годов и двух- или трехуровневым сетям 1980-х годов превратиться в современные 10-, 15- и даже 50-уровневые сети.

Это то, что означает «глубокое» в «глубоком обучении» — глубина слоев сети. И в настоящее время глубокое обучение отвечает за самые эффективные системы почти во всех областях исследований искусственного интеллекта.

Под капотом

Непрозрачность сетей по-прежнему беспокоит теоретиков, но и в этом направлении есть успехи. Помимо руководства Центром мозга, разума и машин (CBMM), Поджио возглавляет исследовательскую программу центра в области теоретических основ интеллекта. Недавно Поджио и его коллеги из CBMM опубликовали теоретическое исследование нейронных сетей, состоящее из трех частей.

В первой части, опубликованной в прошлом месяце в International Journal of Automation and Computing , рассматривается диапазон вычислений, которые могут выполнять сети с глубоким обучением, и когда глубокие сети предлагают преимущества перед более мелкими.Вторая и третья части, выпущенные в виде технических отчетов CBMM, посвящены проблемам глобальной оптимизации или гарантии того, что сеть нашла настройки, наилучшим образом согласующиеся с данными обучения, и переобучения, или случаев, когда сеть становится настроенной таким образом.

к особенностям его обучающих данных, которые он не может обобщить на другие экземпляры тех же категорий.

Есть еще множество теоретических вопросов, на которые нужно ответить, но работа исследователей CBMM может помочь гарантировать, что нейронные сети наконец разорвут цикл поколений, который приводил их в популярность и выходил из нее на протяжении семи десятилетий.

Объяснение искусственного интеллекта, глубокого обучения и нейронных сетей

Таким образом, архитектура модели и ее настройка являются основными компонентами методов ИНС, помимо самих алгоритмов обучения. Все эти характеристики ИНС могут существенно повлиять на производительность модели.

Кроме того, модели характеризуются и настраиваются функцией активации, используемой для преобразования взвешенного входа нейрона в активацию его выхода. Существует множество различных типов преобразований, которые можно использовать в качестве функции активации, и их обсуждение выходит за рамки данной статьи.

Абстракция вывода в результате преобразований входных данных через нейроны и слои является формой распределенного представления, в отличие от локального представления. Смысл, представленный, например, одним искусственным нейроном, является формой локального представления. Однако смысл всей сети — это форма распределенного представления из-за множества преобразований между нейронами и слоями.

Следует отметить одну вещь: хотя ИНС чрезвычайно мощны, они также могут быть очень сложными и считаются алгоритмами черного ящика, что означает, что их внутреннюю работу очень трудно понять и объяснить.Поэтому при выборе использования ИНС для решения проблем следует помнить об этом.

Глубокое обучение Введение

Глубокое обучение, хотя и звучит кричащо, на самом деле это просто термин для описания определенных типов нейронных сетей и связанных с ними алгоритмов, которые часто используют очень необработанные входные данные. Они обрабатывают эти данные через множество уровней нелинейных преобразований входных данных для вычисления целевого выхода.

Неконтролируемое извлечение функций также является областью, в которой глубокое обучение выделяется.Извлечение признаков — это когда алгоритм может автоматически выводить или создавать значимые особенности данных, которые будут использоваться для дальнейшего обучения, обобщения и понимания. Бремя выполнения процесса извлечения признаков в большинстве других подходов к машинному обучению, наряду с выбором функций и проектированием, традиционно лежит на специалистах по обработке данных или программистах.

Извлечение признаков обычно также включает некоторое уменьшение размерности, что уменьшает количество входных объектов и данных, необходимых для получения значимых результатов.Это дает много преимуществ, в том числе упрощение, снижение вычислительной мощности и мощности памяти и так далее.

В более общем смысле, глубокое обучение относится к группе методов, известных как изучение функций или обучение представлению. Как уже говорилось, извлечение функций используется для «изучения» функций, на которых следует сосредоточиться, и использования их в решениях для машинного обучения.

Сами алгоритмы машинного обучения «изучают» оптимальные параметры для создания наиболее эффективной модели.

Перефразируя Википедию, алгоритмы изучения функций позволяют машине как обучаться для конкретной задачи, используя хорошо подобранный набор функций, так и изучать сами функции.Другими словами, эти алгоритмы учатся учиться!

Глубокое обучение успешно использовалось во многих приложениях и на момент написания этой статьи считалось одним из самых передовых методов машинного обучения и искусственного интеллекта. Соответствующие алгоритмы часто используются для задач обучения с учителем, без учителя и с учителем.

Для моделей глубокого обучения на основе нейронных сетей количество слоев больше, чем в так называемых алгоритмах поверхностного обучения. Мелкие алгоритмы, как правило, менее сложны и требуют более глубоких предварительных знаний об оптимальных функциях для использования, что обычно включает выбор функций и разработку.

Напротив, алгоритмы глубокого обучения больше полагаются на оптимальный выбор модели и оптимизацию посредством настройки модели.

Они больше подходят для решения проблем, когда предварительное знание функций менее желательно или необходимо, и где помеченные данные недоступны или не требуются для основного варианта использования.

Помимо статистических методов, нейронные сети и глубокое обучение также используют концепции и методы обработки сигналов, включая нелинейную обработку и / или преобразования.

Вы можете вспомнить, что нелинейная функция — это функция, которая не характеризуется просто прямой линией. Следовательно, для моделирования взаимосвязи между входом или независимой переменной и выходом или зависимой переменной требуется нечто большее, чем просто наклон. Нелинейные функции могут включать полиномиальные, логарифмические и экспоненциальные члены, а также любое другое преобразование, которое не является линейным.

Многие явления, наблюдаемые в физической вселенной, на самом деле лучше всего моделируются с помощью нелинейных преобразований.Это верно также для преобразований между входными данными и целевым выходом в решениях машинного обучения и искусственного интеллекта.

Более глубокое погружение в глубокое обучение — без каламбура

Как уже упоминалось, входные данные преобразуются на всех уровнях нейронной сети глубокого обучения искусственными нейронами или процессорами. Цепочка преобразований, которые происходят от ввода к выводу, известна как путь присвоения кредита или CAP.

Значение CAP является прокси для измерения или концепции «глубины» в архитектуре модели глубокого обучения.Согласно Википедии, большинство исследователей в этой области согласны с тем, что глубокое обучение имеет несколько нелинейных уровней с CAP больше двух, а некоторые считают CAP больше десяти очень глубоким обучением.

Хотя подробное обсуждение множества различных архитектур моделей глубокого обучения и алгоритмов обучения выходит за рамки данной статьи, некоторые из наиболее примечательных включают:

Нейронные сети с прямой связью

Рекуррентная нейронная сеть

Многослойные перцептроны (MLP)

Сверточные нейронные сети

Рекурсивные нейронные сети

Сети глубоких убеждений

Сверточные карты

0003

Самоорганизующиеся сети глубоких убеждений

Машины глубинного Больцмана

Составные автокодировщики с шумоподавлением

Стоит отметить, что из-за относительного увеличения сложности алгоритмы глубокого обучения и нейронных сетей могут быть подвержены переобучению.

Кроме того, увеличенная модель и алгоритмическая сложность могут привести к очень значительным требованиям к вычислительным ресурсам и времени.

Также важно учитывать, что решения могут представлять локальные минимумы в отличие от глобального оптимального решения. Это связано со сложной природой этих моделей в сочетании с методами оптимизации, такими как градиентный спуск.

Учитывая все это, необходимо проявлять должную осторожность при использовании алгоритмов искусственного интеллекта для решения проблем, включая выбор, реализацию и оценку производительности самих алгоритмов.Хотя это выходит за рамки данной статьи, машинное обучение включает в себя множество методов, которые могут помочь в этих областях.

Резюме

Искусственный интеллект — чрезвычайно мощная и захватывающая область. По мере продвижения вперед он станет только более важным и повсеместным, и, безусловно, будет продолжать оказывать очень значительное влияние на современное общество.

Искусственные нейронные сети (ИНС) и более сложные методы глубокого обучения являются одними из наиболее эффективных инструментов искусственного интеллекта для решения очень сложных проблем, и они будут продолжать развиваться и использоваться в будущем.

Хотя сценарий, похожий на терминатора, маловероятен в ближайшее время, за развитием методов и приложений искусственного интеллекта, безусловно, будет очень интересно наблюдать!

Чтобы узнать больше, ознакомьтесь с моей книгой AI для людей и бизнеса: основа для улучшения человеческого опыта и успеха в бизнесе .

Об авторе

Алекс — основатель InnoArchiTech и InnoArchiTech Institute, а также автор книги AI for People and Business , опубликованной O’Reilly Media.

10 архитектур нейронных сетей, которые необходимо изучить исследователям машинного обучения | Джеймс Ле | Примечания к данным

Модели без памяти являются стандартным подходом к этой задаче. В частности, модели авторегрессии могут предсказывать следующий член в последовательности из фиксированного числа предыдущих членов, используя «отводы задержки; и нейронные сети с прямой связью представляют собой обобщенные авторегрессионные модели, которые используют один или несколько слоев нелинейных скрытых единиц.

Однако, если мы дадим нашей генеративной модели какое-то скрытое состояние и если мы дадим этому скрытому состоянию его собственную внутреннюю динамику, мы получим гораздо более интересный вид модели: она может хранить информацию в своем скрытом состоянии в течение длительного времени.Если динамика зашумлена и то, как она генерирует выходные данные из своего скрытого состояния, зашумлено, мы никогда не сможем узнать его точное скрытое состояние. Лучшее, что мы можем сделать, — это вывести распределение вероятностей в пространстве векторов скрытого состояния. Этот вывод возможен только для двух типов модели скрытого состояния.

Первоначально введено в книге Джеффри Элмана « Поиск структуры во времени » (1990) [3] , рекуррентные нейронные сети (RNN) в основном являются перцептронами; однако, в отличие от перцептронов, которые не имеют состояния, у них есть связи между проходами, связи во времени.RNN очень мощны, потому что они сочетают в себе 2 свойства: 1) распределенное скрытое состояние, которое позволяет им эффективно хранить большой объем информации о прошлом; и 2) нелинейная динамика, которая позволяет им обновлять свое скрытое состояние сложными способами.

Имея достаточно нейронов и времени, RNN могут вычислить все, что может вычислить ваш компьютер. Итак, какое поведение могут проявлять RNN? Они могут колебаться, они могут оседать на точечных аттракторах, они могут вести себя хаотично. И они потенциально могли бы научиться реализовывать множество небольших программ, каждая из которых захватывает крупицу знаний и запускается параллельно, взаимодействуя для создания очень сложных эффектов.

Одна большая проблема с RNN — проблема исчезающего (или взрывающегося) градиента, когда, в зависимости от используемых функций активации, информация быстро теряется с течением времени. Интуитивно это не составит особой проблемы, потому что это просто веса, а не состояния нейронов, но веса во времени на самом деле являются тем местом, где хранится информация из прошлого; если вес достигает значения 0 или 1 000 000, предыдущее состояние не будет очень информативным. В принципе, RNN могут использоваться во многих областях, поскольку большинство форм данных, которые фактически не имеют временной шкалы (т.

е. в отличие от звука или видео) можно представить в виде последовательности. Изображение или строку текста можно загружать по одному пикселю или символу за раз, поэтому веса, зависящие от времени, используются для того, что было раньше в последовательности, а не фактически от того, что произошло за x секунд до этого. В общем, повторяющиеся сети — хороший выбор для продвижения или дополнения информации, такой как автозаполнение.

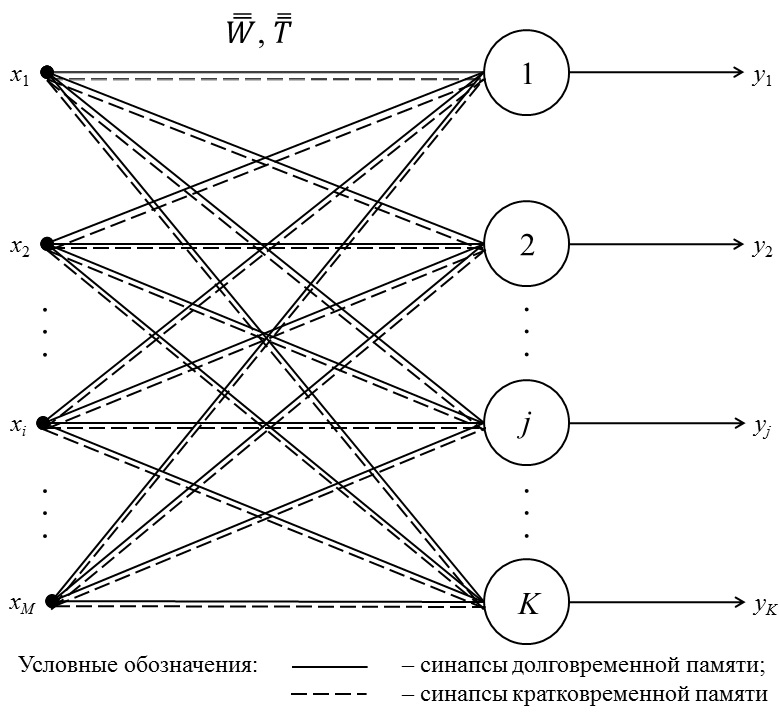

4 — Долговременная / кратковременная память

Hochreiter & Schmidhuber (1997) [4] решил проблему получения RNN запоминания на долгое время, построив так называемые сети долговременной памяти ( LSTM) .Сети LSTM пытаются бороться с проблемой исчезающего / взрывающегося градиента, вводя вентили и явно заданную ячейку памяти. Ячейка памяти хранит предыдущие значения и сохраняет их, если только «ворота забывания» не приказывают ячейке забыть эти значения. LSTM также имеют «входной вентиль», который добавляет новый материал в ячейку, и «выходной вентиль», который решает, когда переходить по векторам из ячейки в следующее скрытое состояние.

Напомним, что для всех RNN значения, поступающие из X_train и H_previous, используются для определения того, что происходит в текущем скрытом состоянии.И результаты текущего скрытого состояния (H_current) используются, чтобы определить, что происходит в следующем скрытом состоянии. LSTM просто добавляют слой ячеек, чтобы гарантировать, что передача информации о скрытом состоянии от одной итерации к следующей достаточно высока. Другими словами, мы хотим запоминать материалы из предыдущих итераций столько, сколько необходимо, и ячейки в LSTM позволяют этому происходить. Было показано, что LSTM способны изучать сложные последовательности, такие как написание Шекспира или сочинение примитивной музыки.

5 — Блокированный рекуррентный блок

Блокированный повторный блок (ГРУ) — это небольшая вариация LSTM. Они принимают X_train и H_previous в качестве входных данных. Они выполняют некоторые вычисления, а затем передают H_current.

На следующей итерации X_train.next и H_current используются для дополнительных вычислений и так далее. Что отличает их от LSTM, так это то, что GRU не нуждается в уровне ячеек для передачи значений. Вычисления в каждой итерации гарантируют, что передаваемые значения H_current либо сохраняют большой объем старой информации, либо запускаются скачком с большим объемом новой информации.

В большинстве случаев ГРУ работают так же, как LSTM, с самой большой разницей в том, что ГРУ немного быстрее и их легче запускать (но также немного менее выразительно). На практике они, как правило, нейтрализуют друг друга, так как вам нужна более крупная сеть, чтобы восстановить некоторую выразительность, что, в свою очередь, сводит на нет преимущества в производительности. В некоторых случаях, когда дополнительная выразительность не требуется, ГРУ могут превзойти LSTM. Вы можете узнать больше о ГРУ из статьи Джунён Чанг 2014 года « Эмпирическая оценка стробированных рекуррентных нейронных сетей при моделировании последовательностей » [5].

6 — Сеть Хопфилда

Рекуррентные сети нелинейных единиц обычно очень трудно анализировать. Они могут вести себя по-разному: переходить в стабильное состояние, колебаться или следовать хаотическим траекториям, которые невозможно предсказать в далеком будущем. Чтобы решить эту проблему, Джон Хопфилд представил Hopfield Net в своей статье 1982 года « Нейронные сети и физические системы с возникающими коллективными вычислительными возможностями » [6].Сеть Хопфилда (HN) — это сеть, в которой каждый нейрон соединен с каждым другим нейроном; это полностью запутанная тарелка спагетти, поскольку даже все узлы функционируют как все. Каждый узел вводится перед обучением, затем скрывается во время обучения и выводится после. Сети обучаются путем установки значения нейронов на желаемый образец, после чего можно вычислить веса. После этого веса не меняются. После обучения одному или нескольким шаблонам сеть всегда будет сходиться к одному из изученных шаблонов, потому что сеть стабильна только в этих состояниях.

Есть еще одна вычислительная роль для сетей Хопфилда. Вместо того, чтобы использовать сеть для хранения воспоминаний, мы используем ее для построения интерпретаций сенсорного ввода. Входные данные представлены видимыми единицами, интерпретация представлена состояниями скрытых единиц, а плохая интерпретация представлена энергией.

К сожалению, люди показали, что сеть Хопфилда очень ограничена в своих возможностях. Сетка Хопфилда из N единиц может запомнить только 0.15N из-за так называемых ложных минимумов в его энергетической функции. Идея состоит в том, что, поскольку функция энергии непрерывна в пространстве своих весов, если два локальных минимума расположены слишком близко, они могут «упасть» друг в друга, создав один локальный минимум, который не соответствует ни одной обучающей выборке, в то время как забывая о двух образцах, которые предполагается запомнить. Это явление значительно ограничивает количество выборок, которые может изучить сеть Хопфилда.

7 — Машина Больцмана

A Машина Больцмана — это тип стохастической рекуррентной нейронной сети.Его можно рассматривать как стохастический, генеративный аналог сетей Хопфилда. Это была одна из первых нейронных сетей, способных изучать внутренние представления, а также представлять и решать сложные комбинаторные задачи. Впервые представили Джеффри Хинтон и Терренс Сейновски в книге « Обучение и повторное обучение на машинах Больцмана » (1986) [7] , Машины Больцмана во многом похожи на сети Хопфилда, но некоторые нейроны помечены как входные нейроны и другие остаются «скрытыми».Входные нейроны становятся выходными нейронами в конце полного обновления сети. Он начинается со случайных весов и учится через обратное распространение. По сравнению с сетью Хопфилда, нейроны в основном имеют бинарные паттерны активации.

Цель обучения алгоритму машинного обучения Больцмана — максимизировать произведение вероятностей, которые машина Больцмана присваивает двоичным векторам в обучающей выборке.

Это эквивалентно максимизации суммы логарифмических вероятностей, которые машина Больцмана назначает обучающим векторам.Это также эквивалентно максимизации вероятности того, что мы получим ровно N обучающих примеров, если бы мы сделали следующее: 1) Пусть сеть установится на свое стационарное распределение N разное время без внешнего входа; и 2) Каждый раз производите выборку видимого вектора.

Эффективная процедура мини-пакетного обучения была предложена для машин Больцмана Салахутдиновым и Хинтоном в 2012 году [8].

- Для положительной фазы сначала инициализируйте скрытые вероятности на уровне 0,5, затем зафиксируйте вектор данных на видимых единицах, затем обновите все скрытые единицы параллельно до сходимости, используя обновления среднего поля.После схождения сети запишите PiPj для каждой подключенной пары устройств и усредните это значение по всем данным в мини-пакете.

- Для отрицательной фазы: сначала имейте набор «фантастических частиц». Каждая частица имеет значение, которое является глобальной конфигурацией.

Затем несколько раз последовательно обновите все юниты в каждой частице фэнтези. Для каждой подключенной пары единиц среднее значение SiSj по всем фантастическим частицам.

В общей машине Больцмана стохастические обновления единиц должны быть последовательными.Существует специальная архитектура, которая позволяет чередовать параллельные обновления, которые намного более эффективны (нет соединений внутри уровня, нет соединений с пропуском уровня). Эта процедура мини-партии делает обновления машины Больцмана более параллельными. Это называется глубокой машиной Больцмана (DBM), общей машиной Больцмана с множеством недостающих соединений.

8 — Сети глубокого убеждения

Обратное распространение считается стандартным методом в искусственных нейронных сетях для расчета вклада ошибок каждого нейрона после обработки пакета данных.Однако при использовании обратного распространения возникают некоторые серьезные проблемы. Во-первых, для этого требуются размеченные данные обучения; в то время как почти все данные немаркированы.

Во-вторых, время обучения плохо масштабируется, что означает, что оно очень медленное в сетях с несколькими скрытыми слоями. В-третьих, он может застрять в плохих локальных оптимумах, поэтому для глубоких сетей они далеки от оптимальных.

Чтобы преодолеть ограничения обратного распространения, исследователи рассмотрели возможность использования подходов к обучению без учителя. Это помогает сохранить эффективность и простоту использования градиентного метода для настройки весов, но также позволяет использовать его для моделирования структуры сенсорного ввода.В частности, они корректируют веса, чтобы максимизировать вероятность того, что генеративная модель сгенерировала бы сенсорный ввод. Вопрос в том, какую генеративную модель нам следует изучить? Может ли это быть энергетическая модель, подобная машине Больцмана? Или причинная модель из идеализированных нейронов? Или гибрид двух?

Йошуа Бенжио предложил Deep Belief Networks в своей статье 2007 г.

куча.Этот метод также известен как жадное обучение, где жадность означает принятие локально оптимальных решений для получения приличного, но, возможно, не оптимального ответа. Сеть убеждений — это ориентированный ациклический граф, составленный из стохастических переменных. Используя сеть убеждений, мы можем наблюдать некоторые из переменных, и мы хотели бы решить 2 проблемы: 1) проблема вывода: сделать выводы о состояниях ненаблюдаемых переменных и 2) проблема обучения: настроить взаимодействия между переменными, чтобы сделать сеть с большей вероятностью сгенерирует обучающие данные.

Сети глубокого убеждения можно обучить с помощью контрастного расхождения или обратного распространения и научиться представлять данные в виде вероятностной модели. После обучения или перехода к стабильному состоянию посредством обучения без учителя модель можно использовать для генерации новых данных. При обучении с контрастной дивергенцией он может даже классифицировать существующие данные, потому что нейроны были обучены искать различные особенности.

9 — Автоэнкодеры

Автоэнкодеры — это нейронные сети, разработанные для обучения без учителя, т.е.е. когда данные не помечены. В качестве модели сжатия данных они могут использоваться для кодирования заданного ввода в представление меньшего размера. Затем можно использовать декодер для восстановления входных данных из закодированной версии.

Работа, которую они выполняют, очень похожа на Анализ главных компонентов , который обычно используется для представления заданных входных данных с использованием меньшего количества измерений, чем было изначально. Так, например, в НЛП, если вы представляете слово как вектор из 100 чисел, вы можете использовать PCA для представления его в 10 числах.Конечно, это приведет к потере некоторой информации, но это хороший способ представить свой ввод, если вы можете работать только с ограниченным числом измерений. Кроме того, это хороший способ визуализировать данные, потому что вы можете легко нанести уменьшенные размеры на двухмерный график, а не на 100-мерный вектор.

Автоэнкодеры выполняют аналогичную работу — разница в том, что они могут использовать нелинейные преобразования для кодирования заданного вектора в меньшие размеры (по сравнению с PCA, который является линейным преобразованием).Таким образом, он может генерировать более сложные кодировки.

Введение в глубокое обучение и нейронные сети — глубокое обучение для новичков (1) | Науа Канг

Добро пожаловать в первый пост из моей серии Deep Learning for Rookies , написанной мной, новичком. Я пишу как стратегию обучения с подкреплением , чтобы лучше обрабатывать и усваивать знания. Но если вы новичок в области глубокого обучения, то это также для вас, потому что мы можем учиться вместе, как новички !

( Вы также можете прочитать этот пост на моем веб-сайте , который поддерживает LaTeX с MathJax )

Источник: deepinstinct.com

Глубокое обучение, вероятно, сейчас является одной из самых актуальных технических тем.

Как крупные корпорации, так и молодые стартапы стремятся к этому золотому дню. Если вы считаете, что большие данные важны, вам следует позаботиться о глубоком обучении. The Economist говорит, что данные — это новая нефть в 21 веке. Если данные — это сырая нефть, базы данных и хранилища данных — это буровые установки, которые копают и перекачивают данные в Интернете, тогда подумайте о глубоком обучении как о нефтеперерабатывающем заводе, который, наконец, превращает сырую нефть во все полезные и полезные конечные продукты.Под землей может быть спрятано много «ископаемого топлива», и на рынке есть много буровых установок и насосов, но без правильных инструментов для нефтепереработки вы не получите ничего ценного. Вот почему так важно глубокое обучение. Это часть общей картины, основанной на данных.

Хорошая новость в том, что у нас не будет исчерпания данных, и наша «перерабатывающая машина» становится все лучше и лучше. Сегодня данные генерируются практически при любых действиях в сети.

Таким образом, данные, в отличие от нефти, «устойчивы» и «стремительно растут».Между тем, пока данные не попадают в мусор, глубокое обучение не дает мусора. Следовательно, чем больше данных, тем лучше. (Ознакомьтесь с публикацией Трента МакКонаги о блокчейнах для ИИ как о решении проблемы репутации данных!).

Кроме того, этот «нефтеперерабатывающий завод» совершенствуется как в программном, так и в аппаратном отношении. Алгоритмы глубокого обучения улучшились за последние несколько десятилетий, и разработчики по всему миру внесли свой вклад в такие фреймворки с открытым исходным кодом, как TensorFlow, Theano, Keras и Torch, которые позволяют людям легко создавать алгоритмы глубокого обучения, как если бы они играли с деталями LEGO. .И благодаря спросу со стороны геймеров по всему миру графические процессоры (графические процессоры) позволяют нам использовать алгоритмы глубокого обучения для создания и обучения моделей с впечатляющими результатами в кратчайшие сроки! Итак, всем родителям, которым не нравятся ваши дети, играющие в игры: у игр есть своя серебряная подкладка .

..

Вы, наверное, читали новости и знаете, что глубокое обучение — это секретный рецепт многих захватывающих разработок, благодаря которым многие из наших сбываются самые смелые мечты и, возможно, кошмары.Кто бы мог подумать, что AlphaGo DeepMind сможет победить Ли Седола, одного из лучших игроков в го, в самой глубокой настольной игре, которая может похвастаться большим количеством возможных ходов, чем атомов во всей вселенной? Многие люди, в том числе и я, никогда этого не ожидали. Это казалось невозможным. Но теперь он здесь. Глубокое обучение побеждает нас в самой сложной настольной игре. Когда пробуждается ИИ? Некоторые думают, что скоро будет.

Ли Седол против AlphaGo в 2016 году, Источник: The New Yorker

И мы не говорили о других впечатляющих приложениях, основанных на глубоком обучении, таких как Google Translate и автономное вождение Mobileye.Вы называете это. Я забыл упомянуть, что глубокое обучение также побеждает врачей в диагностике рака? Глубокое обучение отлично справляется со многими задачами с меньшим количеством ошибок, чем люди! Это не только автоматизация скучных вещей, но и забавных вещей.

Вздох, мы земные люди…

Уважаемый господин Президент, это не иностранцы. Это автоматизация.

Вот краткий список общих задач, которые глубокое обучение может выполнять в реальных ситуациях: