Разметка датасетов: Разметка данных на заказ

Handl — сервис разметки данных для машинного обучения от Dbrain — Трибуна на vc.ru

На платформе уже зарегистрировалось 25 тысяч человек, которые помогают размечать данные для технологических компаний и получают за это деньги. Сегодня Handl официально запускается после успешного альфа-тестирования, и теперь к проекту может присоединиться любой желающий.

{«id»:63360,»url»:»https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»title»:»Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»services»:{«facebook»:{«url»:»https:\/\/www. facebook.com\/sharer\/sharer.php?u=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»short_name»:»FB»,»title»:»Facebook»,»width»:600,»height»:450},»vkontakte»:{«url»:»https:\/\/vk.com\/share.php?url=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain&title=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»short_name»:»VK»,»title»:»\u0412\u041a\u043e\u043d\u0442\u0430\u043a\u0442\u0435″,»width»:600,»height»:450},»twitter»:{«url»:»https:\/\/twitter.com\/intent\/tweet?url=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain&text=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»short_name»:»TW»,»title»:»Twitter»,»width»:600,»height»:450},»telegram»:{«url»:»tg:\/\/msg_url?url=https:\/\/vc.

facebook.com\/sharer\/sharer.php?u=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»short_name»:»FB»,»title»:»Facebook»,»width»:600,»height»:450},»vkontakte»:{«url»:»https:\/\/vk.com\/share.php?url=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain&title=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»short_name»:»VK»,»title»:»\u0412\u041a\u043e\u043d\u0442\u0430\u043a\u0442\u0435″,»width»:600,»height»:450},»twitter»:{«url»:»https:\/\/twitter.com\/intent\/tweet?url=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain&text=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»short_name»:»TW»,»title»:»Twitter»,»width»:600,»height»:450},»telegram»:{«url»:»tg:\/\/msg_url?url=https:\/\/vc. ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain&text=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»short_name»:»TG»,»title»:»Telegram»,»width»:600,»height»:450},»odnoklassniki»:{«url»:»http:\/\/connect.ok.ru\/dk?st.cmd=WidgetSharePreview&service=odnoklassniki&st.shareUrl=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»short_name»:»OK»,»title»:»\u041e\u0434\u043d\u043e\u043a\u043b\u0430\u0441\u0441\u043d\u0438\u043a\u0438″,»width»:600,»height»:450},»email»:{«url»:»mailto:?subject=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain&body=https:\/\/vc.

ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain&text=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain»,»short_name»:»TG»,»title»:»Telegram»,»width»:600,»height»:450},»odnoklassniki»:{«url»:»http:\/\/connect.ok.ru\/dk?st.cmd=WidgetSharePreview&service=odnoklassniki&st.shareUrl=https:\/\/vc.ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»short_name»:»OK»,»title»:»\u041e\u0434\u043d\u043e\u043a\u043b\u0430\u0441\u0441\u043d\u0438\u043a\u0438″,»width»:600,»height»:450},»email»:{«url»:»mailto:?subject=Handl \u2014 \u0441\u0435\u0440\u0432\u0438\u0441 \u0440\u0430\u0437\u043c\u0435\u0442\u043a\u0438 \u0434\u0430\u043d\u043d\u044b\u0445 \u0434\u043b\u044f \u043c\u0430\u0448\u0438\u043d\u043d\u043e\u0433\u043e \u043e\u0431\u0443\u0447\u0435\u043d\u0438\u044f \u043e\u0442 Dbrain&body=https:\/\/vc. ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»short_name»:»Email»,»title»:»\u041e\u0442\u043f\u0440\u0430\u0432\u0438\u0442\u044c \u043d\u0430 \u043f\u043e\u0447\u0442\u0443″,»width»:600,»height»:450}},»isFavorited»:false}

ru\/tribuna\/63360-handl-servis-razmetki-dannyh-dlya-mashinnogo-obucheniya-ot-dbrain»,»short_name»:»Email»,»title»:»\u041e\u0442\u043f\u0440\u0430\u0432\u0438\u0442\u044c \u043d\u0430 \u043f\u043e\u0447\u0442\u0443″,»width»:600,»height»:450}},»isFavorited»:false}

25 803

просмотров

Что такое разметка

Представьте маленького ребёнка, который ничего не умеет. Родители не будут объяснять, что котёнок — это маленькое животное с пушистым хвостиком. Такое описание подходит и щенку. Вместо этого они покажут много котят и щенят, поправляя ребенка до тех пор, пока он не научится отличать животных самостоятельно.

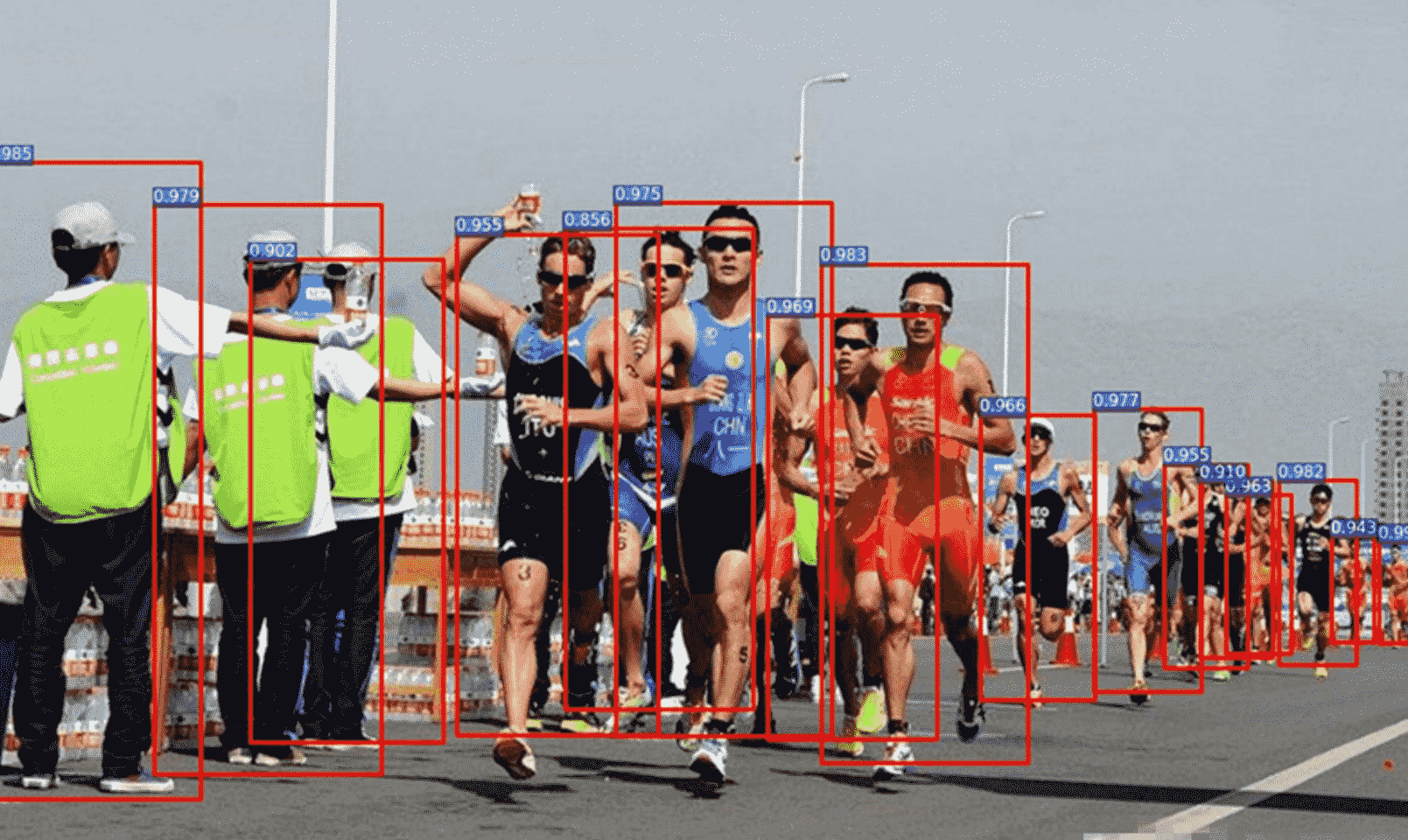

С искусственным интеллектом тот же принцип, который применим почти везде: ИИ распознает качество пиццы, преступников на улице и серьезные заболевания на ранних стадиях, но сначала ему надо показать тысячи примеров, где эту задачу уже решил человек, — другими словами, подготовил данные для машинного обучения. Это и называется разметкой.

Это и называется разметкой.

Разметка данных — самая трудозатратная задача при создании ИИ: надо без ошибок разметить тысячи единиц информации. Мы в Handl придумали, как упростить весь процесс. Наши разметчики подключаются из любой точки мира и размечают данные — к примеру, определяют, что изображено на картинке, то есть ставят «метки». Так они готовят обучающую выборку для ИИ. Переняв знания людей, алгоритм успешно решает аналогичные задачи.

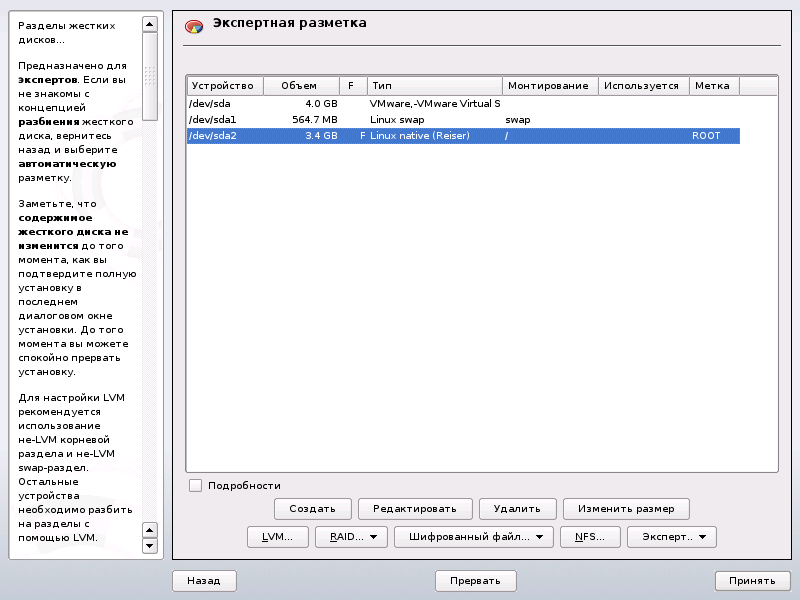

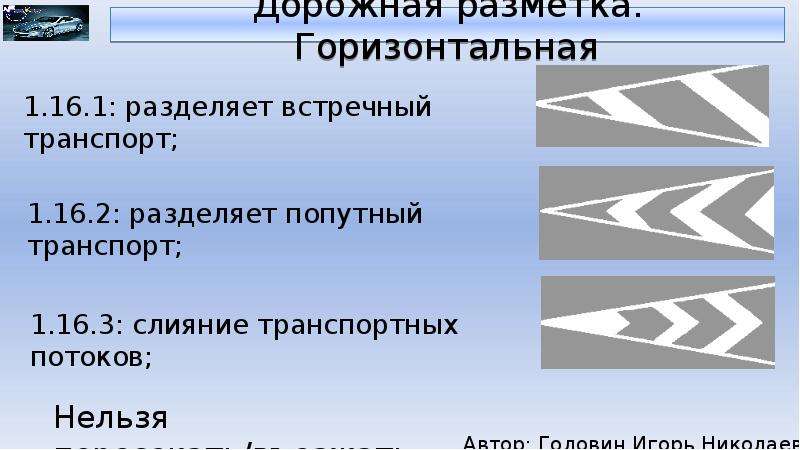

Сегментация текста на Handl

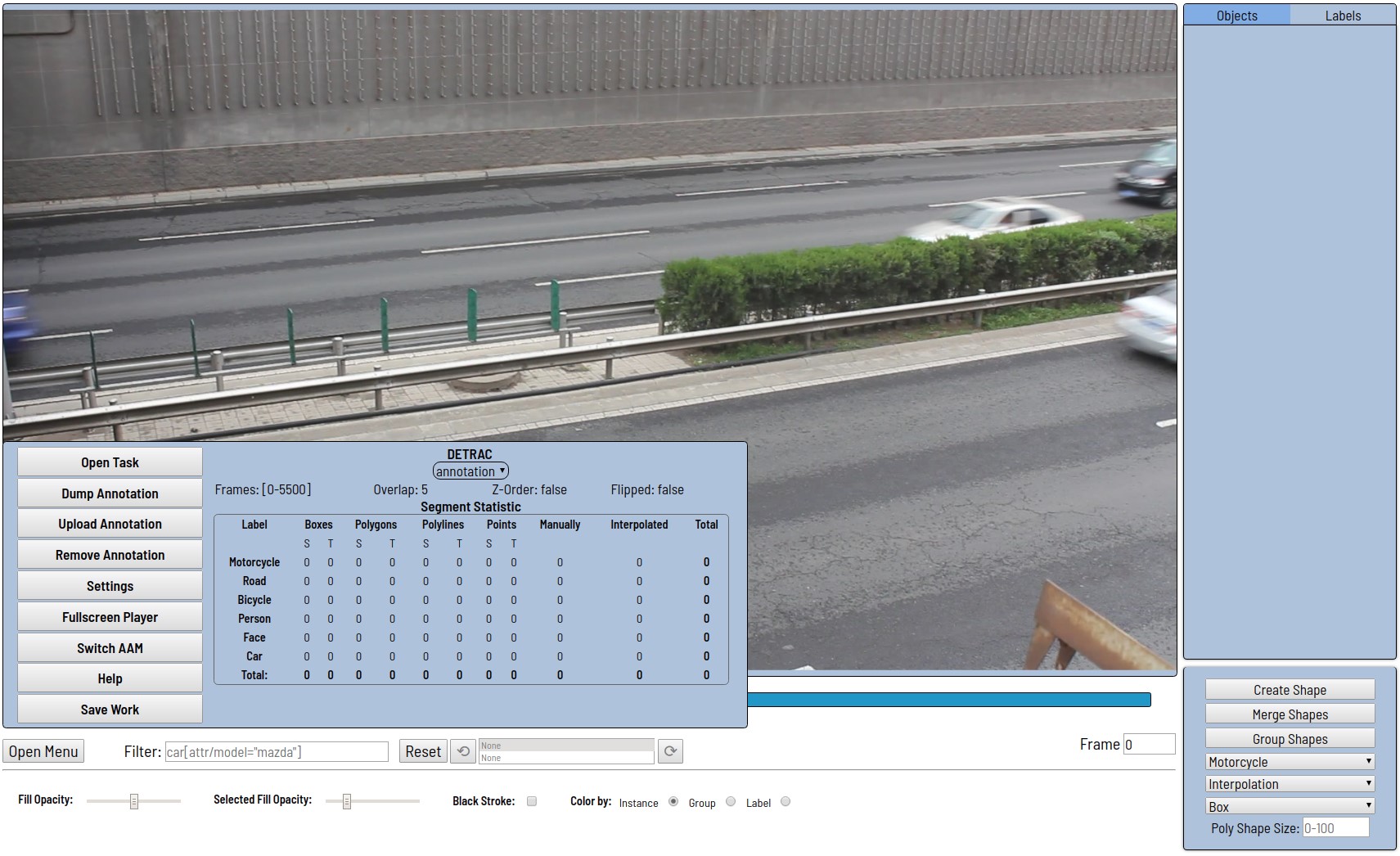

Как устроен процесс работы в Handl

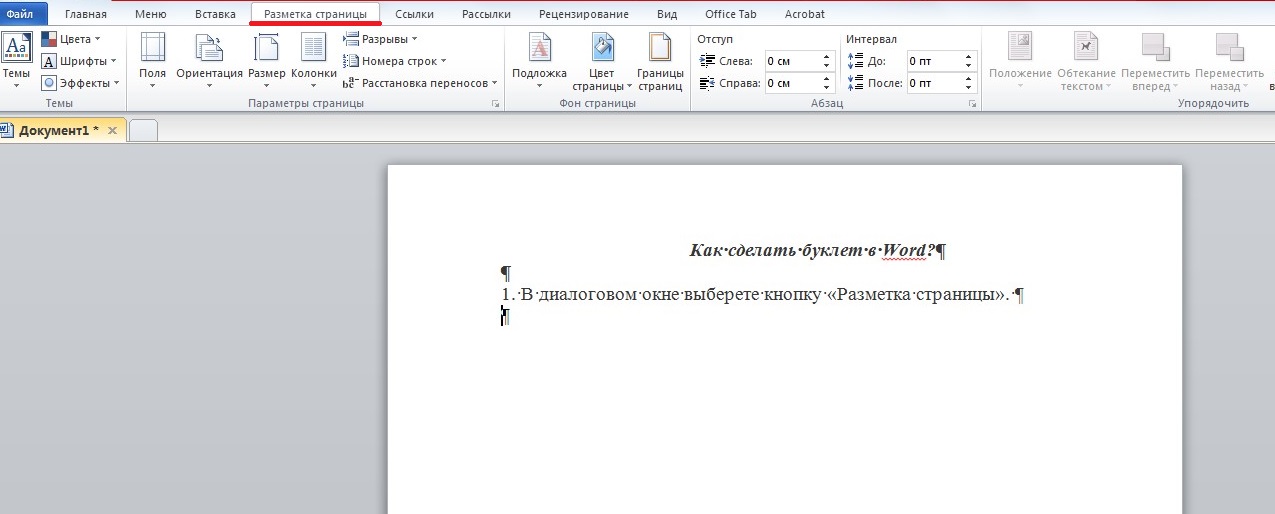

Со стороны клиента. Клиент загружает данные, выбирает шаблон задачи (классификация, сегментация, ввод текста) и запускает её в работу. Разметчики выполняют задания. Если разметка требует специальных знаний вроде китайского языка или медицинского образования, можно привлечь своих исполнителей и использовать наш интерфейс.

Клиент загружает данные, выбирает шаблон задачи (классификация, сегментация, ввод текста) и запускает её в работу. Разметчики выполняют задания. Если разметка требует специальных знаний вроде китайского языка или медицинского образования, можно привлечь своих исполнителей и использовать наш интерфейс.

{«url»:»https:\/\/booster.osnova.io\/a\/relevant?site=vc»,»place»:»between_entry_blocks»,»site»:»vc»,»settings»:{«modes»:{«externalLink»:{«buttonLabels»:[«\u0423\u0437\u043d\u0430\u0442\u044c»,»\u0427\u0438\u0442\u0430\u0442\u044c»,»\u041d\u0430\u0447\u0430\u0442\u044c»,»\u0417\u0430\u043a\u0430\u0437\u0430\u0442\u044c»,»\u041a\u0443\u043f\u0438\u0442\u044c»,»\u041f\u043e\u043b\u0443\u0447\u0438\u0442\u044c»,»\u0421\u043a\u0430\u0447\u0430\u0442\u044c»,»\u041f\u0435\u0440\u0435\u0439\u0442\u0438″]}},»deviceList»:{«desktop»:»\u0414\u0435\u0441\u043a\u0442\u043e\u043f»,»smartphone»:»\u0421\u043c\u0430\u0440\u0442\u0444\u043e\u043d\u044b»,»tablet»:»\u041f\u043b\u0430\u043d\u0448\u0435\u0442\u044b»}},»isModerator»:false}

Со стороны разметчиков. Разметчики регистрируются, проходят онбординг и получают доступ к задачам, зарабатывая до 3 долларов в час.

Разметчики регистрируются, проходят онбординг и получают доступ к задачам, зарабатывая до 3 долларов в час.

Механизм работы. Алгоритм консенсуса распределяет выплаты и следит за отсутствием ошибок: от качества разметки зависит точность распознавания будущей ИИ-модели. Система выплат работает так: как только люди размечают картинку, мы считаем объективное время, необходимое для этой задачи, а алгоритм консенсуса вычисляет коэффициент качества. Чем меньше времени затрачено на задачу и чем точнее она выполнена, тем больше начисление. Поэтому разметчики стараются выполнять задачи максимально качественно.

Мы уже разметили более 6 миллионов картинок, текстов и звуков для таких компаний как Nvidia, Nestle, Cherry Home. В отличие от других аналогичных сервисов, Handl сфокусирован только на задачах по подготовке данных для машинного обучения. Благодаря этому мы выполняем разметку с высокой точностью, скоростью и с меньшими затратами.

Благодаря этому мы выполняем разметку с высокой точностью, скоростью и с меньшими затратами.

Кейс: молочная ферма

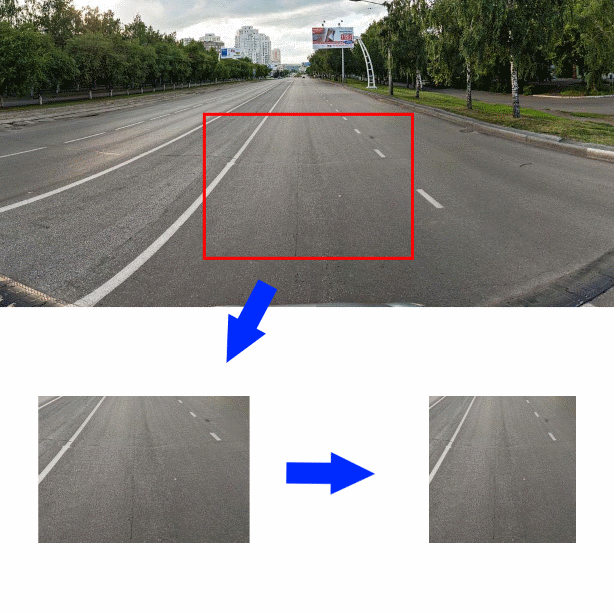

Коровам на ферме нужно правильно питаться, чтобы давать вкусное молоко. Но когда их сотни, проследить за состоянием каждой коровы сложно. Чтобы автоматизировать контроль за их здоровьем, мы разметили 143 тысячи изображений для обучения нейронной сети. Сначала люди размечали картинки, отвечая на вопрос «что тут изображено?», тем самым отсеивая коров от других животных.

Потом обводили коров по контуру, чтобы ИИ точно определил их местоположение. И наконец, работали с видео, указывая, что делает корова: ест, пьёт, лежит или ходит.

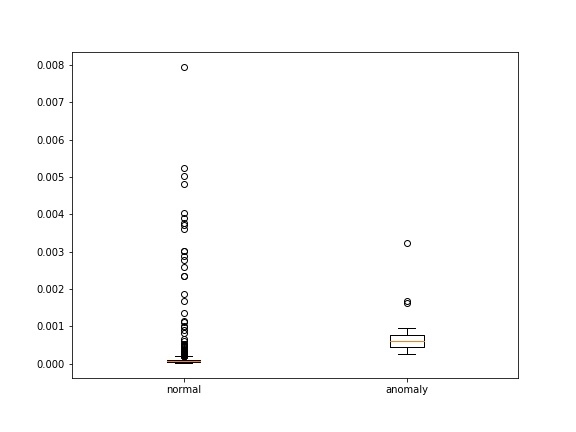

В итоге получилась нейронная сеть, которая мониторит здоровье коров и прогнозирует, как они будут себя чувствовать в будущем. Руководствуясь информацией с камер наблюдения, ИИ отслеживает поведение каждого животного по отдельности и выявляет аномалии — например, корова плохо ест или слишком долго лежит на земле. В этом случае система подаёт сигнал фермерам.

Выводы

Основная проблема в разработке ИИ — подготовить данные. Мы упростили этот процесс и запустили платформу, которая объединяет удалённых работников и технологические компании для создания искусственного интеллекта.

Сегодня мы запустились на Product Hunt. Посмотреть нашу страницу и оставить фидбек проекту можно здесь.

Что такое разметка данных?

Поговорим о том, что мы все уже давно работаем на искусственный интеллект. А именно занимаемся разметкой данных. Что это такое рассказывает Светлана Вронская, менеджер по маркетингу департамента аналитических решений ГК «КОРУС Консалтинг» в подкастеТелеграм-канала Analytics Now на портале Tadviser.

Сегодня хочу вас обрадовать: вы все уже давно работает на искусственный интеллект. Cейчас объясню почему.

Набившее оскомину выражение «данные – это новая нефть» особенно верно, если вспомнить, что сама по себе нефть, сырая, — вы особенно не сможете нигде применить. Ее надо очистить и переработать. Точно также дело обстоит и с нашей новой нефтью, информацией. Даже собрав большое количество неструктурированных данных, вы не сможете никак их применить в работе. И здесь появляется новый сегмент работы в области машинного обучения – разметка данных, data labelling.

Ее надо очистить и переработать. Точно также дело обстоит и с нашей новой нефтью, информацией. Даже собрав большое количество неструктурированных данных, вы не сможете никак их применить в работе. И здесь появляется новый сегмент работы в области машинного обучения – разметка данных, data labelling.

Пусть объем этого рынка пока сравнительно небольшой — по оценке аналитиков из Cognica Research в 2023 году он достигнет 1,2 млрд. долларов США, работа по разметке данных занимает до четверти всего времени на реализацию ML-проектов. Плюс, как вы увидите дальше, не факт, что мы когда-либо сможем достоверно узнать, сколько реально тратиться денег на data labelling.

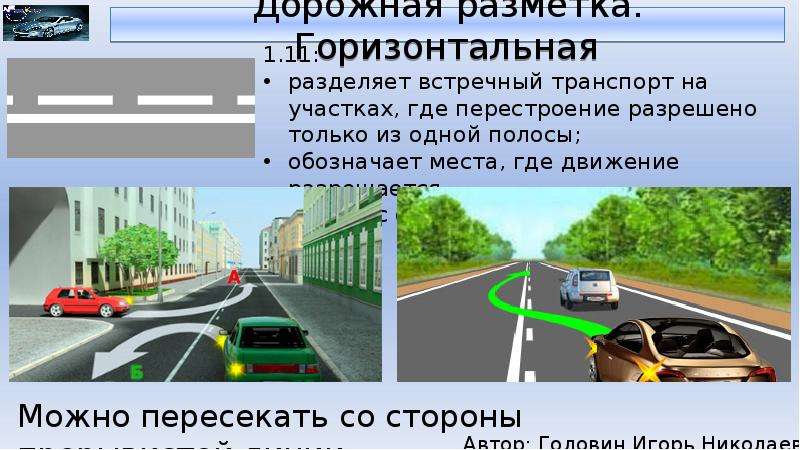

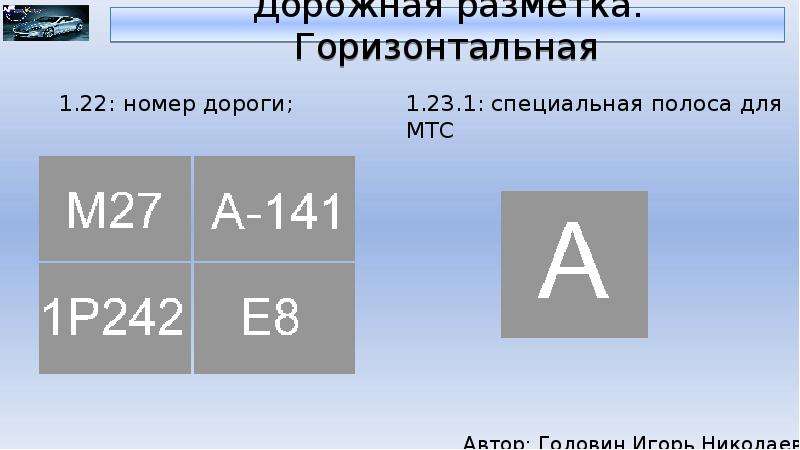

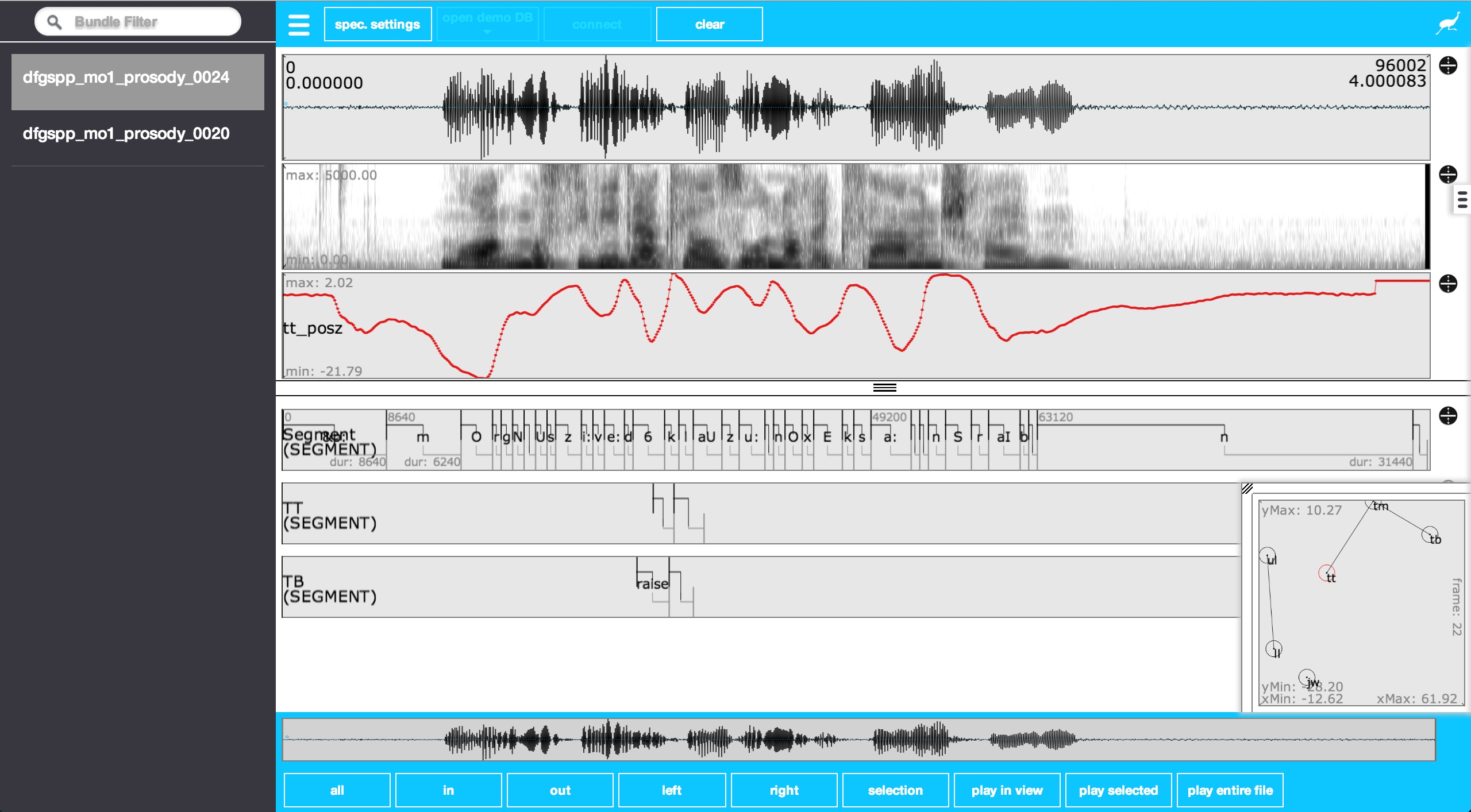

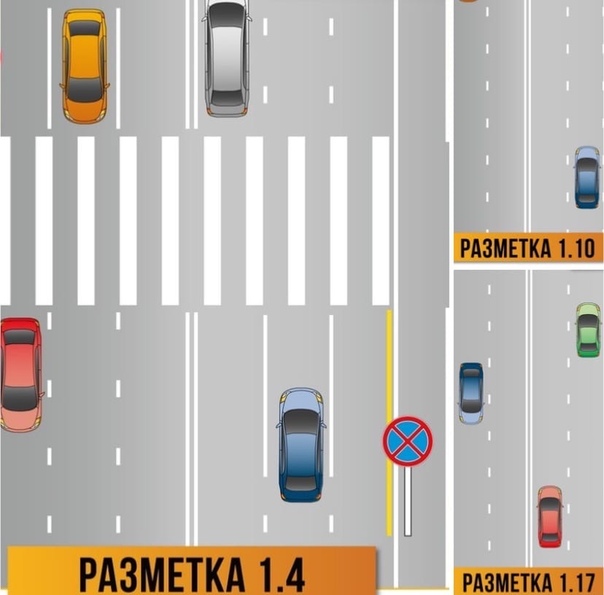

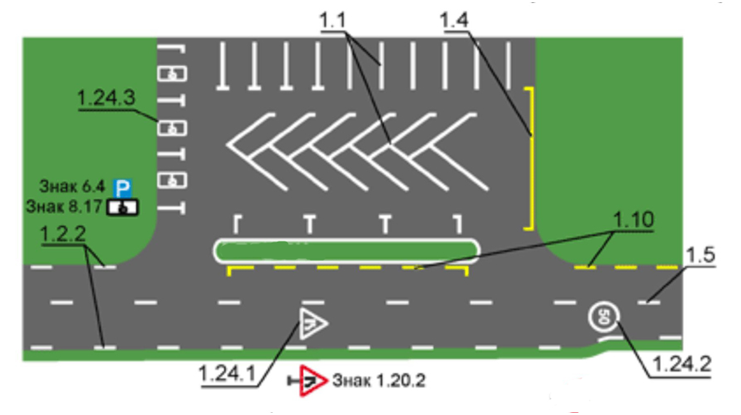

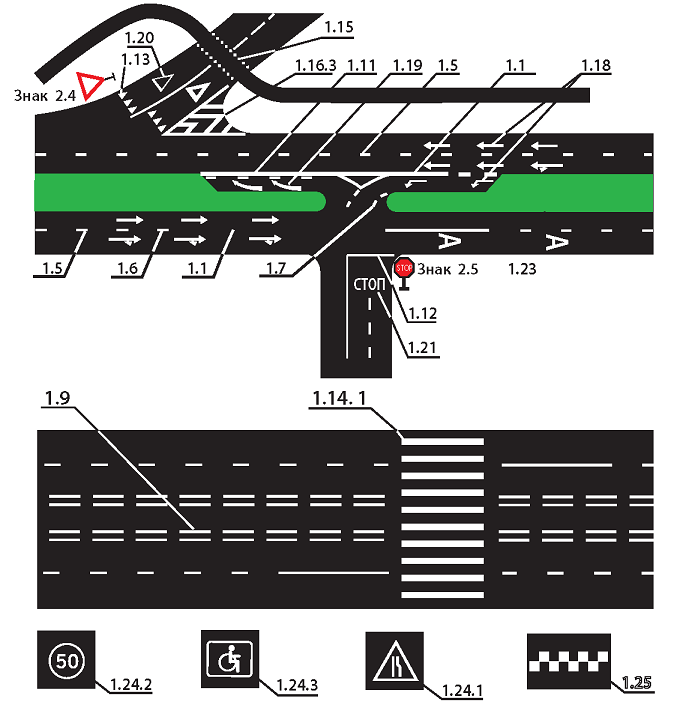

Итак, что же это такое – разметка данных? Основной задачей машинного обучения является обучение алгоритма – будь то традиционные статистические модели или новые нейронные сети, — искать и использовать закономерности из обучающего набора вопросов и ответов. При этом эти вопросы и ответы могут быть в виде текста, в виде изображения, в виде аудио или видео файла. К примеру, мы хотим научить модель определять тональность голоса человека, который звонит в колл-центр. Тогда вопрос будет звучать: какая интонация у звонящего? А ответами – положительная или негативная. Такие же примеры можно привести про видеозаписи, которые фиксируют нарушение автомобилем линии STOP перед светофором или нарушение привычной формы органа на рентгеновском снимке пациента. Чтобы искусственный интеллект научился давать правильные ответы на эти вопросы, за него это задачу сначала должен решить человек. То есть человек должен подготовить данные для машинного обучения. Это и разметка данных.

При этом эти вопросы и ответы могут быть в виде текста, в виде изображения, в виде аудио или видео файла. К примеру, мы хотим научить модель определять тональность голоса человека, который звонит в колл-центр. Тогда вопрос будет звучать: какая интонация у звонящего? А ответами – положительная или негативная. Такие же примеры можно привести про видеозаписи, которые фиксируют нарушение автомобилем линии STOP перед светофором или нарушение привычной формы органа на рентгеновском снимке пациента. Чтобы искусственный интеллект научился давать правильные ответы на эти вопросы, за него это задачу сначала должен решить человек. То есть человек должен подготовить данные для машинного обучения. Это и разметка данных.

Теперь вы понимаете, почему data labelling— самая трудозатратная задача при создании решений на базе искусственного интеллекта: надо без ошибок разметить тысячи единиц информации и сделать это нужно быстро.

Как и в случае, когда нужно было генерить большой объем программного кода и Индия оказалась самым подходящим ресурсом для этого и стала (и остается) лидером в области оффшорного программирования, так и в случае с разметкой данных основной ресурс находится в Азии. Прежде всего это Китай, в котором миллионы сотрудников, без квалификации или с низкой квалификацией и маленькой заработной платой, ежедневно отсматривают десятки и сотни тысяч данных и размечают ее. Так что старая картинка с шуткой о сервисе распознавания музыкальных треков Shazam, где в огромном зале в наушниках сидят сотрудники и один из них кричит: «Кто-нибудь знает, чья эта песня?» не так уж далека от истины. Каким бы умным ни был искусственный интеллект, он ничто без человека. Смею надеяться, что так будет еще очень долго.

Прежде всего это Китай, в котором миллионы сотрудников, без квалификации или с низкой квалификацией и маленькой заработной платой, ежедневно отсматривают десятки и сотни тысяч данных и размечают ее. Так что старая картинка с шуткой о сервисе распознавания музыкальных треков Shazam, где в огромном зале в наушниках сидят сотрудники и один из них кричит: «Кто-нибудь знает, чья эта песня?» не так уж далека от истины. Каким бы умным ни был искусственный интеллект, он ничто без человека. Смею надеяться, что так будет еще очень долго.

Несмотря на то, что количество данных растет, пока нет полноценных средств автоматизации для процесса разметки данных. Да, появляются решения, которые частично облегчают процесс – такие, например, как MarkLab, Handl, Annotate.online, Clarifai, — но все равно пока главная роль отдана человеку. Именно поэтому на рынке – и за рубежом, и в России, — появилось большое количество компаний, которые предоставляют услуги по разметке данных, нанимая фрилансеров, работающих из дому из всех точек земного шара.

Крупные поставщики инфраструктуры данных также создали хабы для разметки данных. В Штатах лидирует решение от Amazon, Amazon Mechanical Turk, названное в честь уловки 18 века, когда было модно играть в автоматизированные шахматы, хотя в ящике под шахматным столом сидел человек и физически передвигал фигуры. В России более популярна площадка Яндекс.Толока, которая, как и механический турок позволяет свести заказчиков наборов данных, датасетов, и специалистов по разметке данных.

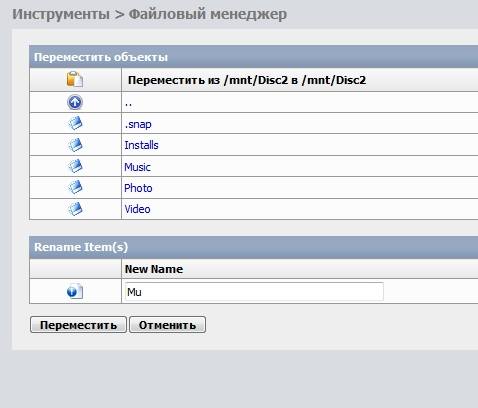

Пару слов о том, как этот процесс работает. Все очень просто: клиент загружает «грязные» данные, выбирает шаблон задачи – классификацию, сегментацию, ввод текста, — и запускает процесс. Площадка сама находит исполнителей и выдает потом заказчику размеченные данные. Для справки, примерная стоимость такой работы у Яндекса – 15 долларов США за 1000 заданий, длительностью около 3 часов. Площадка берет себе около 20% комиссионных. Наверно, не так много, но за время самоизоляции многим очень пригодилась такая работа на дому.

Напоследок, как обещала, расскажу, почему мы с вами все работаем на искусственный интеллект. Вспомните, как при доступе на некоторые сайты, Google просит вас отметить все светофоры или автомобили (по крайней мере, мне он подсовывает именно их)? Так вот, каждый раз, когда вы кликаете по частям автомашин и горящих светофоров, вы работаете специалистом по разметке данных. Где же только наши 15 долларов?

Источник: Tadviser

Специалист по разметке данных / Блог компании New Professions Lab / Хабр

Сегодня замечательный день (if you know what I mean), чтобы анонсировать нашу новую программу — Специалист по разметке данных.

На текущий момент в сфере искусственного интеллекта сложилась такая ситуация, при которой для обучения сильной нейронной сети нужны несколько компонентов: железо, софт и, непосредственно, данные. Много данных.

Железо, в общем-то, доступно каждому через облака. Да, оно может быть недешевым, но GPU-инстансы на EC2 вполне по карману большинству исследователей. Софт опенсорсный, большинство фреймворков можно скачать себе куда-то и работать с ними. Некоторые сложнее, некоторые проще. Но порог для входа вполне приемлемый. Остается только последний компонент — это данные. И вот здесь и возникает загвоздка.

Софт опенсорсный, большинство фреймворков можно скачать себе куда-то и работать с ними. Некоторые сложнее, некоторые проще. Но порог для входа вполне приемлемый. Остается только последний компонент — это данные. И вот здесь и возникает загвоздка.

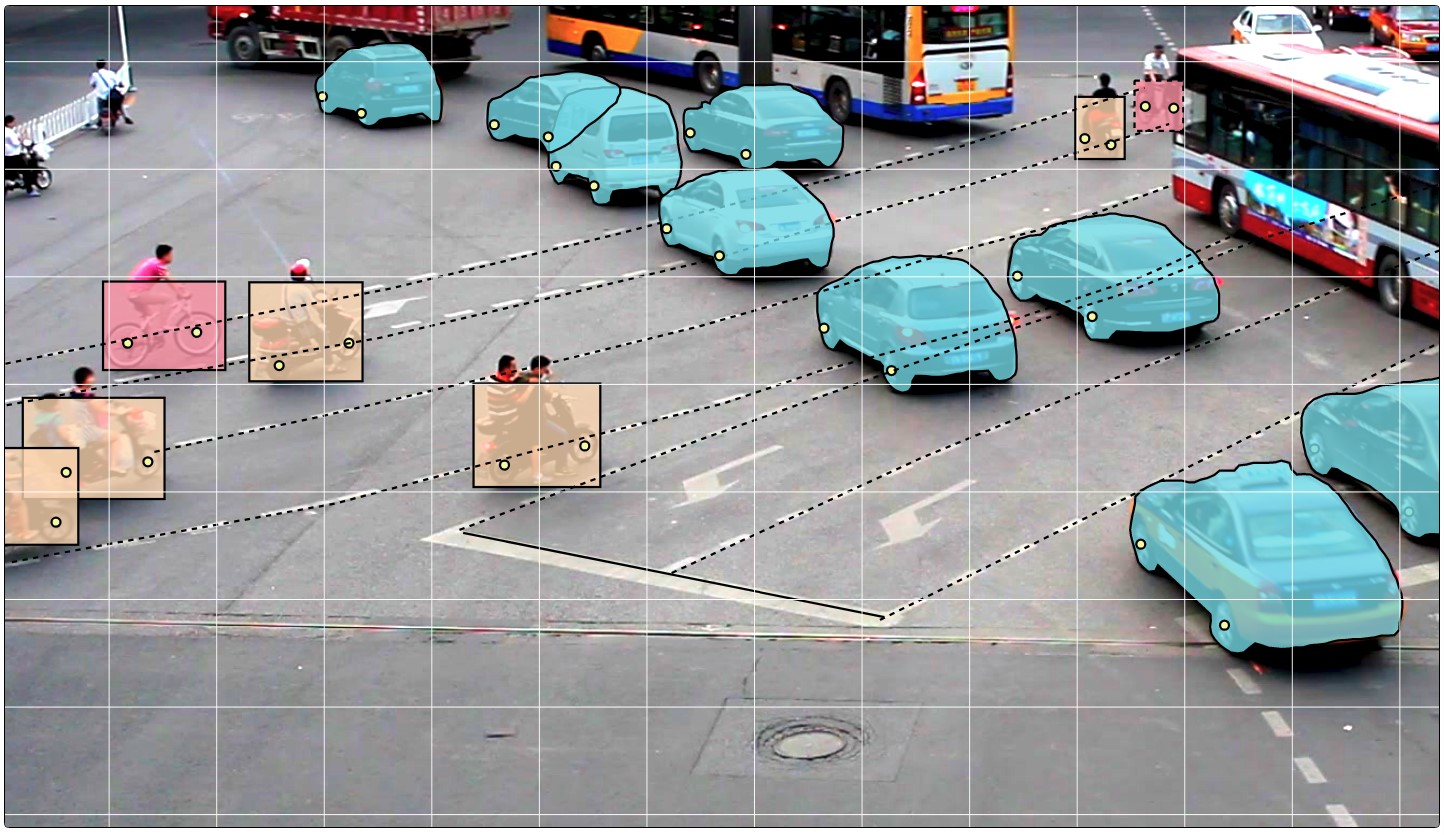

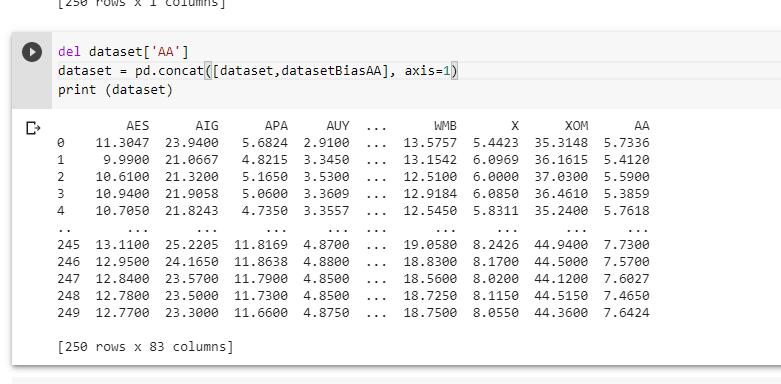

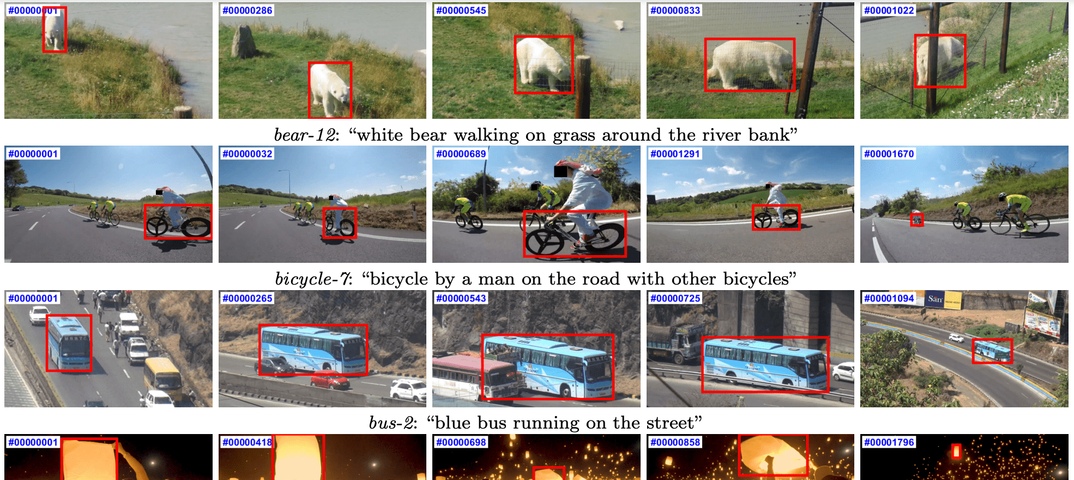

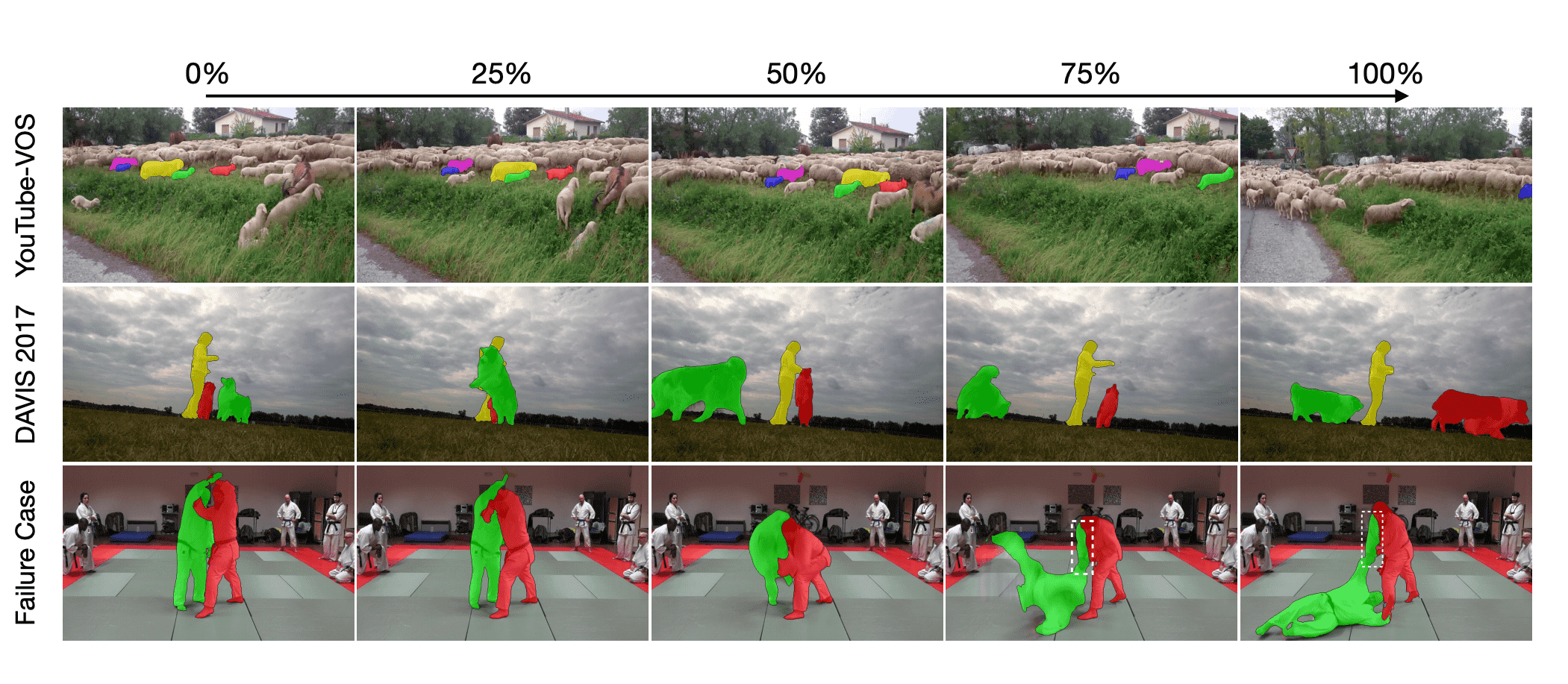

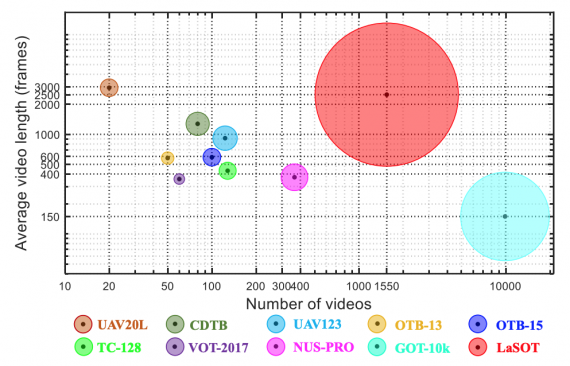

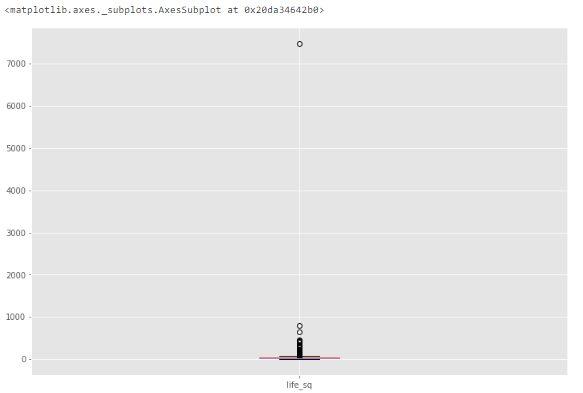

Deep learning требует действительно больших данных: сотни тысяч–миллионы объектов. Если вы хотите заниматься, например, задачей классификации изображений, то вам, помимо самих данных, нужно передать нейронке информацию, к какому классу относится тот или иной объект. Если у вас задача связана еще и с сегментацией изображения, то получение хорошего датасета — это уже фантастически сложно. Представьте, что вам нужно на каждом изображении выделить границы каждого объекта.

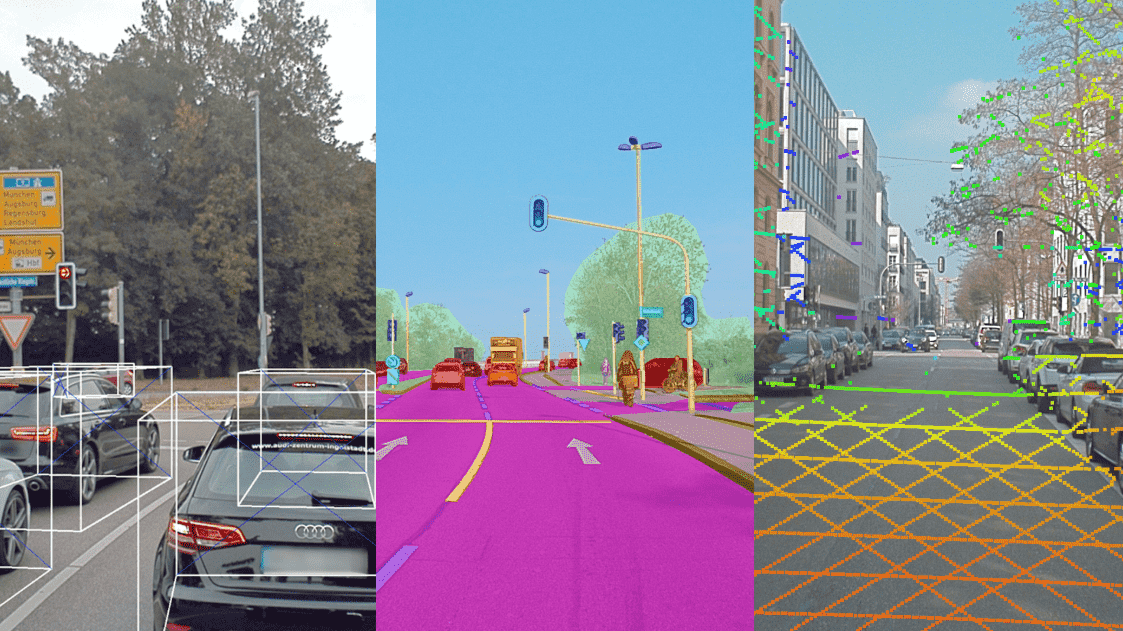

В этом посте хочется сделать обзор тех инструментов (коммерческих и бесплатных), которые пытаются облегчить жизнь этих прекрасных людей — разметчиков данных.

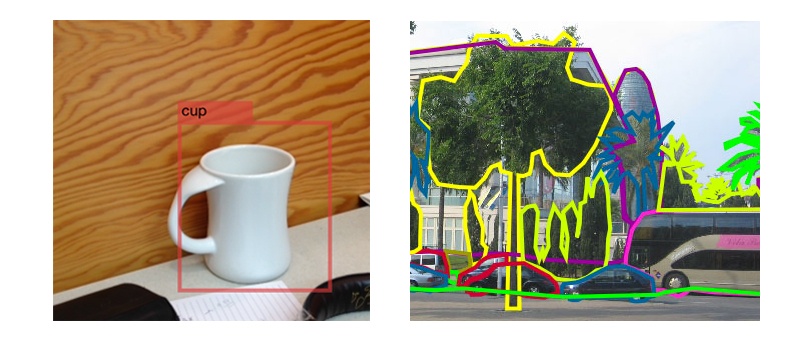

LabelMe

Начнем с того, что это бесплатная тулза, сделанная в MIT. С ее помощью вы можете размечать свои изображения: это могут быть просто bounding boxes, либо попиксельная сегментация.

По сути дела, это некий UI, в котором можно выделять контуры изображения и ставить точки. Это всё. Ничего более умного эта тулза не умеет. Еще одна фича: у LabelMe есть мобильное приложение. Можно не терять зря время в метро, электричке, автобусе, на скучной лекции.

Prodi.gy

Одна из самых продвинутых active learning-систем. Идея такова, что уже заранее натренированная модель с минимальным обучением пытается разметить ваши данные, а ваша задача — лишь направлять ее. Целевая аудитория — аналитики и инженеры, которым необходимо качественно размечать данные, а больших ресурсов на внешних разметчиков у них нет. UX, по словам разработчиков, похож на Тиндер.

Тулза просит разметить только те объекты, по которым она не уверена. Вроде как, они делают больший упор на работу с текстами, но computer vision у них тоже есть, в том числе работа с видео. Сами мы ею не пользовались. Она платная. Стоимость лицензии начинается от 390$.

Scale API

Эти ребята подходят к процессу разметки в формате “под ключ”. Дайте нам ваши данные, мы отдадим их нашим разметчикам, проконтролируем качество, дадим вам уже результат через какое-то время. И всё это через API.

Дайте нам ваши данные, мы отдадим их нашим разметчикам, проконтролируем качество, дадим вам уже результат через какое-то время. И всё это через API.

Естественно, это тоже не бесплатный инструмент. Например, разметка одной картинки для задачи семантической сегментации (то есть выделить на изображении объекты контурами и сказать, что это за объекты) будет стоить 8$, если вам нужно срочно, или 6.4$ если готовы подождать.

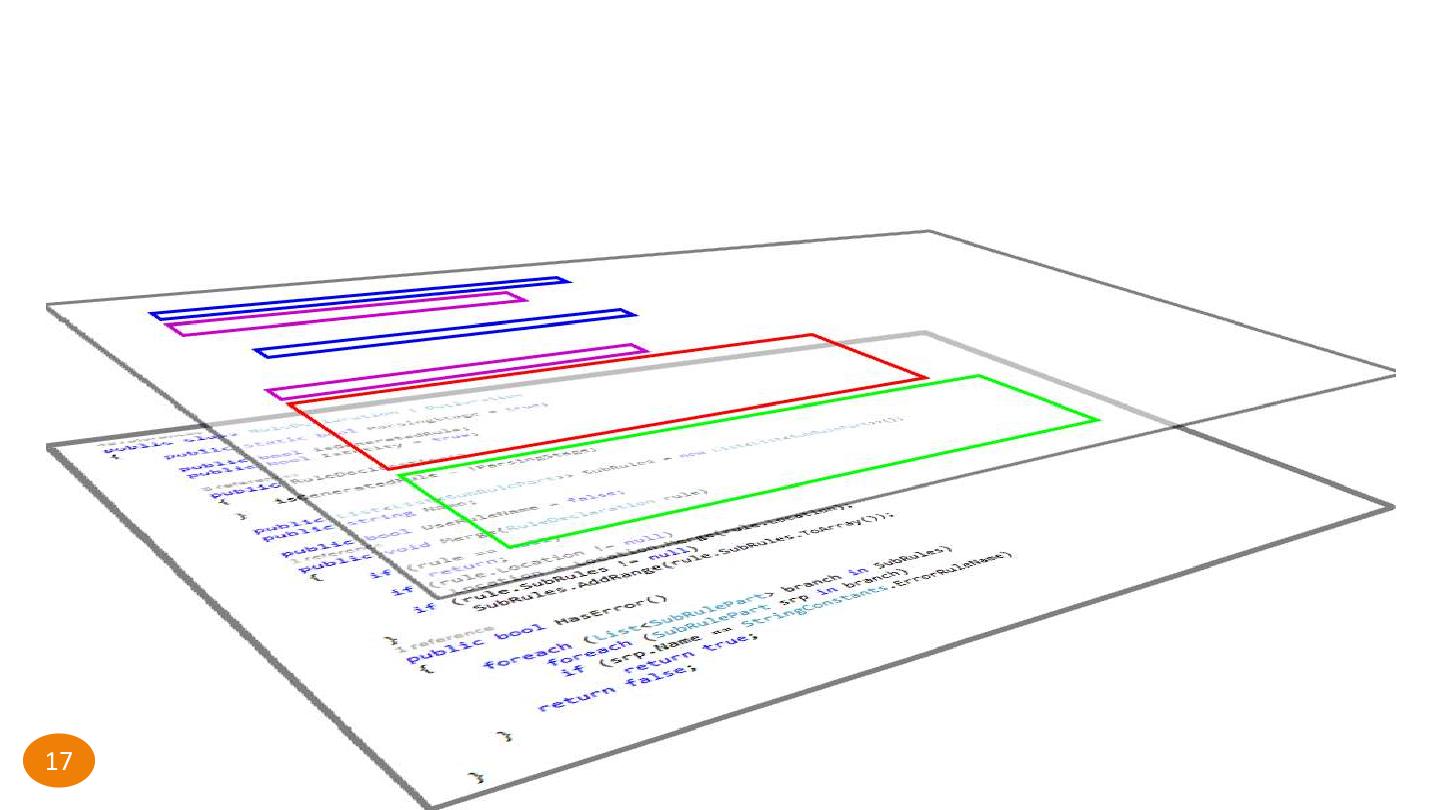

Supervise.ly

Этот инструмент предназначен для упрощения разметки типа instance segmentation. Под капотом (по ощущению) работает что-то вроде Polygon-RNN. Вы выделяете прямоугольниками объекты, а система сама находит границы объекта внутри прямоугольника. У них есть разные натренированные сетки под разные предметные области.

Ребята ещё умеют генерировать синтетические данные из игр и разбавлять ими реальные, если реальные сложно достать. Плюс они же могут завести всю свою систему внутри вашего энтерпрайза, чтобы данные от вас никуда не уходили. В общем, по ощущениям, может хорошо ускорять работу разметчика. Но это не точно.

Но это не точно.

Mechanical Turk

Сила индусской разметки на кончиках ваших пальцев. Дорого для вас, копейки для них, плохое качество, непонятный quality control, но все пользуются. В России есть аналог — Яндекс.Толока.

Когда-нибудь мы возьмем интервью у пользователей этих платформ и узнаем, как проходит их рабочий день, в чем возникают сложности.

CrowdFlower

Этот инструмент — стандарт де-факто для разметки. Тоже используют живых людей, но предоставляют им более продвинутые инструменты, нежели Толока или MTurk, чтобы размечать было проще.

Помимо стандартных bounding boxes, семантической сегментации, полигонов, они еще размечают точки, например, для складов или полок в магазинах.

Как видите, рынок подобных решений пока очень узкий, но потенциал довольно большой, потому что бутылочное горлышко AI сейчас — это именно хорошо размеченные данные. И кроме шуток, за этим действительно будущее.

Если знаете еще другие инструменты, пишите в комментариях.

Marketing Logic разработала платформу разметки данных MarkLab

, Текст: Владимир Бахур

Marketing Logic, специализирующаяся на разработке и предоставлении инновационных решений для бизнеса, представила новый сервис MarkLab — платформу для разметки данных. MarkLab позволяет выполнять разметку различных видов документов, изображений, фотографий, сканов, скриншотов, видео, рукописей, аудиоданных — форматов, необходимых для работы в различных сферах бизнеса.

Платформа позволяет размечать документы и изображения в любой последовательности и делить на классы и подразделы на каждом этапе с помощью удобных инструментов. Тепловые карты проектов отражают степень готовности датасетов, выделяют области с отличающимся качеством данных и размеченных областей.

Для управления проектами в MarkLab разработана удобная система для формирования и управления командой разметки: платформа даёт возможность разграничить функционал, уровни доступа, распределять задачи по исполнителям. Алгоритм позволяет рассчитывать эффективность выполнения каждой задачи или блока задач в баллах, процентах или деньгах, а также проводить кросс-валидацию и последующий контроль.

«Обучение моделей для нейросетей при создании умных продуктов и сервисов – это задача, с которой мы сталкиваемся ежедневно на протяжении всей истории компании. Мы хорошо знаем, насколько важно подготовить данные и качественно их разметить. Наша команда проектировала и разрабатывала платформу MarkLab для себя, но на текущем этапе её развития мы готовы предложить сервис нашим клиентам и партнёрам, так как инструменты, интерфейс MarkLab позволяют реализовывать практически любые задачи по разметке и самостоятельно администрировать процесс. Благодаря MarkLab, у нас появилась возможность различных способов сотрудничества: когда мы всё делаем сами и передаём готовый продукт, когда мы сопровождаем проекты с поддержкой на любом этапе или когда мы передаём программное обеспечение, а команда клиента с его помощью обрабатывает данные и размечает датасет. Гибкий подход часто бывает выгодным для обеих сторон», — сказал управляющий партнёр компании Marketing Logic Дмитрий Галкин.

Технически платформа MarkLab может использоваться посредством облачных технологий Marketing Logic или устанавливаться внутри IT-контура компании-клиента.

Данные — новая нефть. Как на них заработать?

Алексей Шабанов, исследователь Neuromation, рассказывает, какие данные представляют ценность для компаний, и раскрывает пять способов заработка на них.

Данные — новая нефть. Как на них заработать?

Полина Константинова

Сегодня многие технологические компании активно используют методы машинного обучения, чтобы встраивать в свои продукты и бизнес-процессы умные алгоритмы. Так, с каждым днем рекламная выдача становится прицельнее, автоматический перевод точнее, а голосовые ассистенты понятливее. Необходимый ингредиент для создания таких систем — данные, много данных.

Следовательно, первый ответ на вопрос из заголовка будет таким: нужно найти релевантные к деятельности компании данные и использовать их, чтобы сделать выпускаемые продукты «умнее». Но подобный ответ лежит на поверхности и едва ли может считаться полным. Мы поможем открыть читателю менее очевидные способы заработка на данных, но для этого придется совершить небольшой экскурс в предметную область.

Но подобный ответ лежит на поверхности и едва ли может считаться полным. Мы поможем открыть читателю менее очевидные способы заработка на данных, но для этого придется совершить небольшой экскурс в предметную область.

Какие данные представляют ценность?

Задачи машинного обучения подразумевают, что необходимо научить некоторый алгоритм извлекать закономерности из обучающего набора «вопросов» и «ответов», чтобы обобщить полученный опыт для ответов на новые вопросы. В качестве алгоритма могут использоваться классические статистические модели, а могут и искусственные нейронные сети — для нашего повествования это не играет роли. Например, мы желаем научить какую-то модель определять тональности рецензий на фильмы, тогда вопрос — это текст рецензии, а ответ — один из двух вариантов: положительной была рецензия или отрицательной. Еще несколько примеров:

- Вопрос — рентген-снимок пациента; ответ — локализация аномалий и диагноз.

- Вопрос — аудиозапись человеческой речи; ответ — текстовая расшифровка.

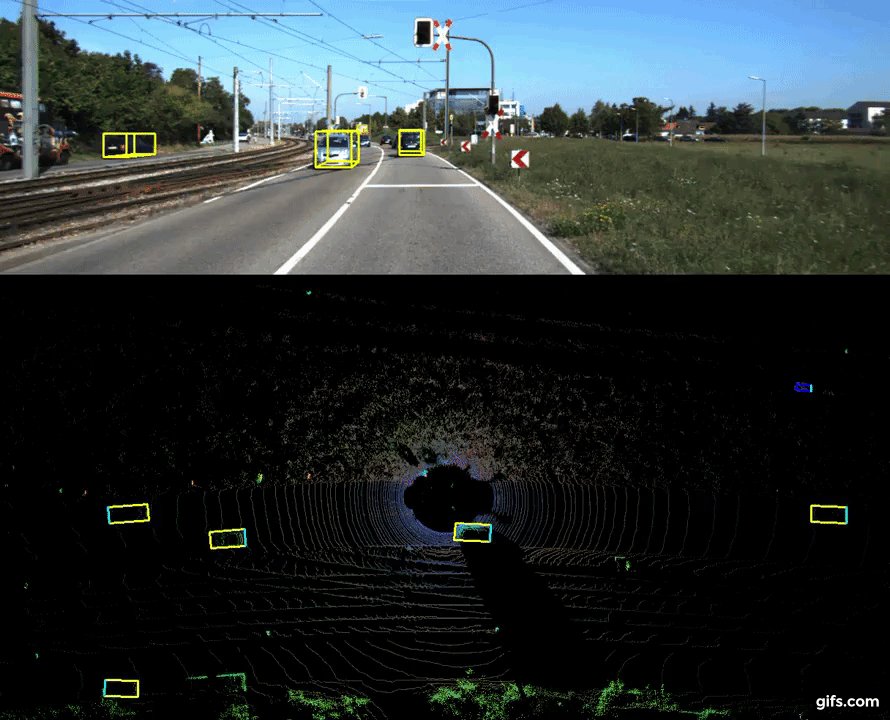

- Вопрос — видеозапись с камеры, установленной на перекрестке; ответ — обведенные контуры автомобилей на каждом кадре.

Процесс получения ответов на заданные вопросы (в приведенном узком смысле) называется разметкой или аннотированием данных, а совокупность полученных данных называется датасетом. Итак, с точки зрения машинного обучения ценность представляют не любые данные, а размеченные. Стоимость аннотирования зависит от многих факторов: требуемой компетенции разметчиков, сложности технической организации процесса, конфиденциальности данных и других.

Так, отсортировать рецензии к фильмам может любой человек, используя примитивный текстовый редактор. Чтобы выделить контуры автомобилей на изображении перекрестка, особых знаний тоже не нужно, но потребуется специализированное ПО.

Наконец, чтобы разметить серию рентген-снимков, потребуется и ПО, и специалисты с медицинским образованием — такие данные представляют особую ценность.

Растущий спрос на все большие объемы аннотированных данных привел к созданию таких площадок как Amazon Mechanical Turk и его отечественного аналога Яндекс.Толоки. Эти сервисы позволяют свести заказчиков датасетов и специалистов по разметке данных. Часто последними являются малообеспеченные граждане азиатских стран, таких как Индия, Пакистан и Бангладеш. В большинстве случаев они за целый день работы получают всего несколько долларов, в то время как владельцы площадок получают большую часть стоимости заказа. Обладатели уже размеченных данных тоже могут извлечь выгоду: либо косвенно, выкладывая их в открытый доступ для продвижения своего бренда, либо напрямую, перепродавая датасеты другим заинтересованным лицам.

Кроме стоимости, у ручного аннотирования есть еще один существенный недостаток: для некоторых задач невозможно предложить приемлемый способ ручной разметки. Скажем, в случае с перекрестком мы можем захотеть дополнительно определять скорости автомобилей на каждом кадре: точно проставить такие метки вручную крайне проблематично. Избежать названных проблем помогает использование синтетических данных.

Избежать названных проблем помогает использование синтетических данных.

Что такое синтетические данные?

Под словосочетанием «синтетические данные» обычно подразумеваются объекты реального мира, смоделированные с помощью компьютера. Главное преимущество такого подхода в том, что разметка к ним прилагается автоматически. Вновь обратимся к примеру с перекрестком: если смоделировать его средствами для создания компьютерных игр, мы сразу получим полную информацию о любом объекте в кадре: его скорость, цвет, массу, положение и что угодно еще! Другой пример: использование синтезатора для озвучивания текста позволяет с точностью до миллисекунд сопоставлять буквы и их фонемы, что недостижимо при использовании ручного труда.

Кроме того, синтетические датасеты отлично масштабируются: например, получив в распоряжение синтезатор речи, можно озвучить миллионы страниц текста!

Вдумчивый читатель мог догадаться, что самое сложное при работе с синтетическими данными — сделать их достаточно реалистичными. Действительно, взаимосвязи между объектами в синтетическом датасете должны иметь место в реальном мире. К счастью, сейчас активно развиваются архитектуры нейронных сетей, предназначенные для генерации контента (Generative Adversarial Networks, GAN), которые позволяют адаптировать синтетические данные под задачи реального мира. Кроме того, GAN’ы могут использоваться и для генерации контента «с нуля», получаемые таким способом сущности тоже можно назвать синтетическими. Однако, практика показывает, что качество такой генерации уступает адаптированной синтетике.

Действительно, взаимосвязи между объектами в синтетическом датасете должны иметь место в реальном мире. К счастью, сейчас активно развиваются архитектуры нейронных сетей, предназначенные для генерации контента (Generative Adversarial Networks, GAN), которые позволяют адаптировать синтетические данные под задачи реального мира. Кроме того, GAN’ы могут использоваться и для генерации контента «с нуля», получаемые таким способом сущности тоже можно назвать синтетическими. Однако, практика показывает, что качество такой генерации уступает адаптированной синтетике.

Кто работает с синтетическими данными?

Приведем пример компаний, использующих синтетические данные для создания своих продуктов:

- В 2016 году компания Avito собрала огромный датасет объявлений и организовала соревнование для специалистов по машинному обучению. Призовой фонд составил 20 тысяч долларов, а для хостинга была выбрана площадка Kaggle. Участникам предлагалось найти объявления, которые вручную были отмечены как дубликаты, при этом соответствующие им тексты и изображения могли значительно отличаться.

Таким образом, были успешно апробированы алгоритмы, способные на большее, чем механическое сравнение данных.

Таким образом, были успешно апробированы алгоритмы, способные на большее, чем механическое сравнение данных. - В 2016 году научная группа из Apple опубликовала статью «Learning from Simulated and Unsupervised Images through Adversarial Training», рассказывающую об определении направления взгляда с использованием изображений адаптированных синтетических глаз. Интересно, что авторы предложили тестовой группе попытаться отличить фотографии настоящих глаз от синтетических: оказалось, что люди не смогли показать результат, превосходящий случайное угадывание.

Синтетические глаза сверху, снизу их более реалистичные версии, полученные с помощью GAN’ов.

- Исследователи из Berkeley и Glidwell Dental Labs в 2018 году представили работу «Learning Beyond Human Expertise with Generative Models for Dental Restorations», посвященную использованию генерируемых данных для решения задачи стоматологической реставрации. Авторы рассказывают, как с помощью GAN’ов можно автоматизировать дорогостоящий процесс создания вручную формы зубных коронок.

Сгенерированные формы для зубных коронок.

- Успех киностудии и по совместительству онлайн-кинотеатра Netflix во многом связан с работой рекомендательной системы Cinematch. Она позволяет индивидуально подбирать для каждого зрителя потенциально интересные фильмы, основываясь на поведении пользователей со схожими вкусами. Разумеется, создание такой системы невозможно без сбора гигантского количества записей о том, какой рейтинг пользователи поставили тем или иным фильмам.

- Мы также активно используем синтетические данные в большей части своих проектов, один из которых — создание системы для классификации товаров на продуктовых полках. Одна из возникающих проблем состоит в том, что каталог товаров огромен, при этом некоторые наименования и внешний вид товаров отличаются незначительно. Другая проблема — размечающим пришлось бы узнавать развернутые и находящиеся в дальних рядах товары. Наконец, вручную определить дополнительные параметры, такие как угол поворота упаковки или расстояние от камеры до полки почти невозможно.

Выйти из затруднительного положения удалось с помощью рендеринга миллионов искусственных полок, содержащих 3D-модели оцифрованных товаров из настоящих магазинов.

Выйти из затруднительного положения удалось с помощью рендеринга миллионов искусственных полок, содержащих 3D-модели оцифрованных товаров из настоящих магазинов.

Синтетическая полка с товарами.

Итак, как же заработать на данных?

Напоследок, вооружившись знаниями о предметной области, вновь ответим на вопрос, поставленный в заголовке. Условно способы заработка можно разбить на пять групп:

- Упомянутое в самом начале статьи извлечение дополнительной выгоды из продуктов, улучшенных методами машинного обучения.

- Деятельность, связанная с процессом аннотирования: вы можете предложить свой ручной труд, организовать площадку и/или поставлять специализированное ПО для разметки.

- Сбор и предоставление датасетов на коммерческой основе.

- Участие в соревнованиях по анализу данных или предоставление сервиса, позволяющие такие соревнования хостить.

- Работа с синтетическими данными: создание цифровых копий реальных объектов с использованием специальной аппаратуры; рендеринг разнообразных сцен с этими объектами; предоставление вычислительных мощностей для рендеринга.

Материалы по теме:

эксперты рынка о проблемах и возможностях

Эффективность систем искусственного интеллекта как правило достигается за счет достаточного количества данных. В идеале — готовых датасетов, то есть наборов данных, специальным образом размеченных для того, чтобы их понимали и воспринимали нейросети и алгоритмы искусственного интеллекта. Объемы данных тем временем растут год от года: по оценке IDC, если в 2018-м в мире было накоплено 33 зеттабайта (миллиарда терабайт) данных, то в 2025-м это число будет равняться 175 зеттабайтам.

Казалось бы, это хорошо, но где большие данные, там и большие проблемы. Главная заключается в недостаточно высоком качестве общедоступных данных. Так называемые «грязные данные» считались главной проблемой отрасли три года назад и продолжают считаться сегодня. В конце 2019-го телеком-оператор Telenor определил «грязные данные» в список самых популярных технологических трендов 2020-го.

О том, какова ситуация с Big Data сегодня и как компании решают связанные с этим сложности, мы поговорили с экспертами индустрии: разработчиками и специалистами в области данных.

Две главные проблемы больших данных

В случае с искусственным интеллектом действует простое правило: чем больше данных, тем эффективнее будет работа с ИИ. По мнению бизнес-архитектора Predictive Analytic Solutions компании Mail.ru Group Владимира Новоселова, хорошие и качественные наборы данных с разметкой — один из самых ценных компонентов, необходимых для разработки эффективного решения в области машинного обучения (ML).

Их ценность обусловлена двумя основными факторами, которые широко обсуждаются профессиональным сообществом как на тематических мероприятиях, так и в социальных сетях:

- общая нехватка данных;

- недостаточно высокое качество данных.

Относительно первой проблемы большинство опрошенных нами экспертов сходятся во мнении: много данных никогда не бывает, в некотором смысле их не хватает всегда.

Любая команда, которая занимается разработкой ML-based систем, сталкивается с этой проблемой. Крупные компании инвестируют большие средства в то, чтобы обеспечить инфраструктуру сбора и агрегации данных, необходимых для обучения и анализа. То, насколько эффективно компании решают проблему доступности данных, во многом обеспечивает ее конкурентоспособность на этом рынке.

Даже в случае достаточного количества открытых данных по нужному направлению, их может не хватать для решения конкретных задач компании.

В областях обработки естественного языка (NLP) и компьютерного зрения (CV) есть большое количество как качественных датасетов под разные задачи, так и предобученных на этих датасетах моделей. При этом для решения прикладной задачи помимо публичных данных обязательно надо дообучить модель на собственных.

Денис Власов

ведущий аналитик и специалист по машинному обучению «Учи.ру»

С этой точкой зрения согласна глава компании в области ИИ-решений в сфере здравоохранения «Третье мнение» Анна Мещерякова:

Мы используем открытые датасеты на стадии research. Работаем с опубликованными в России данными и взаимодействуем с зарубежными коллегами. Собственная научная деятельность и сотрудничество с медицинскими и техническими вузами в России и за рубежом позволяет получать качественные датасеты для целей research. Но на стадии обучения мы редко используем открытые датасеты — у нас собственные требования к классификаторам, к разметке.

Работаем с опубликованными в России данными и взаимодействуем с зарубежными коллегами. Собственная научная деятельность и сотрудничество с медицинскими и техническими вузами в России и за рубежом позволяет получать качественные датасеты для целей research. Но на стадии обучения мы редко используем открытые датасеты — у нас собственные требования к классификаторам, к разметке.

Андрей Воробьев, президент МТП «Ньюдиамед», считает, что из больших данных в медицине можно собирать только изображения, и те размечать и анализировать надо самостоятельно.

Врачам приходится писать истории болезни «для прокурора». Зачастую это недостоверные или неполные данные. Потому искать правды в больших массивах клинических данных бессмысленно, ничего полезного вы там не найдете. Гораздо эффективнее устранить человеческий фактор в источнике данных и собирать структурированную информацию от самих пациентов. Мы задаем вопросы пациенту за врача, получаем полный объем необходимых данных об анамнезе и жалобах и уже на этих данных «учимся».

R&D-директор компании UBIC Technologies в качестве примера тоже приводит медицинские данные:

В сети есть отличные качественные датасеты, которые, к сожалению, не охватывают все многообразие клинических проявлений исследуемого заболевания. Поэтому самое сложное — отделять зерна от плевел, особенно в тех предметных областях, в которых не являешься экспертом и не можешь быстро найти эксперта поблизости, но задачу решать надо. Отчасти помогают специализированные инструменты: Google Dataset Search или Яндекс.Толока.

Исполнительный директор Департамента анализа данных и моделирования «Газпромбанка» Адель Валиуллин считает, что найти качественные примеры открытых данных не так сложно, приводя в пример наборы MNIST, MS СОСО, OpenImages, ImageNet, которые обычно подготавливают крупные институты и корпорации.

При решении задач анализа данных на основе текстовых данных часто возникает проблема наличия размеченных датасетов, особенно на русском языке. Размечать данные обычно долго и дорого. Если есть открытые данные и принцип разметки легко объясним, то могут подойти такие инструменты как Яндекс.Толока и Amazon Mechanical Turk. Если же данные выгружать наружу нельзя или же требуется экспертиза при разметке, как например, врача-радиолога или эксперта-лингвиста, то создание такого размеченного набора данных будет трудоемким и требовать значительных затрат.

Если есть открытые данные и принцип разметки легко объясним, то могут подойти такие инструменты как Яндекс.Толока и Amazon Mechanical Turk. Если же данные выгружать наружу нельзя или же требуется экспертиза при разметке, как например, врача-радиолога или эксперта-лингвиста, то создание такого размеченного набора данных будет трудоемким и требовать значительных затрат.

Адель Валиуллин

исполнительный директор Департамента анализа данных и моделирования «Газпромбанка»

Действительно, во многих случаях открытые датасеты не являются панацеей, и компаниям приходится использовать общедоступные инструменты поиска и генерации данных, а также самостоятельно собирать нужную информацию.

В случае нехватки данных мы обычно майнили сами: собирали данные в офисе и других местах, использовали Яндекс.Толоку, просили людей записывать короткие ролики. Специфика сбора сильно зависит от предметной области исследования.

Дмитрий Акимов

инженер по данным VisionLabs

В целом все зависит от конкретных задач, объясняет аналитик данных в Sever. ai ИТ-холдинга TalentTech Алексей Иванов.

ai ИТ-холдинга TalentTech Алексей Иванов.

Задачи бывают общие, схожие с научными, а бывают прикладные, узкоспециализированные. Первые решаются и оцениваются с помощью открытых датасетов (ImageNet, SQuAD, Wiki corpus, например). Для второго типа задач открытых датасетов просто нет. Например, для скоринга резюме без собственноручного сбора и разметки данных не обойтись. Открытые данные здесь помогают уменьшить размер специфического датасета — это нужно для повышения точности, поскольку качественные модели на маленьких датасетах часто дают плохие результаты.

Алексей Иванов

аналитик данных в Sever.AI ИТ-холдинга TalentTech

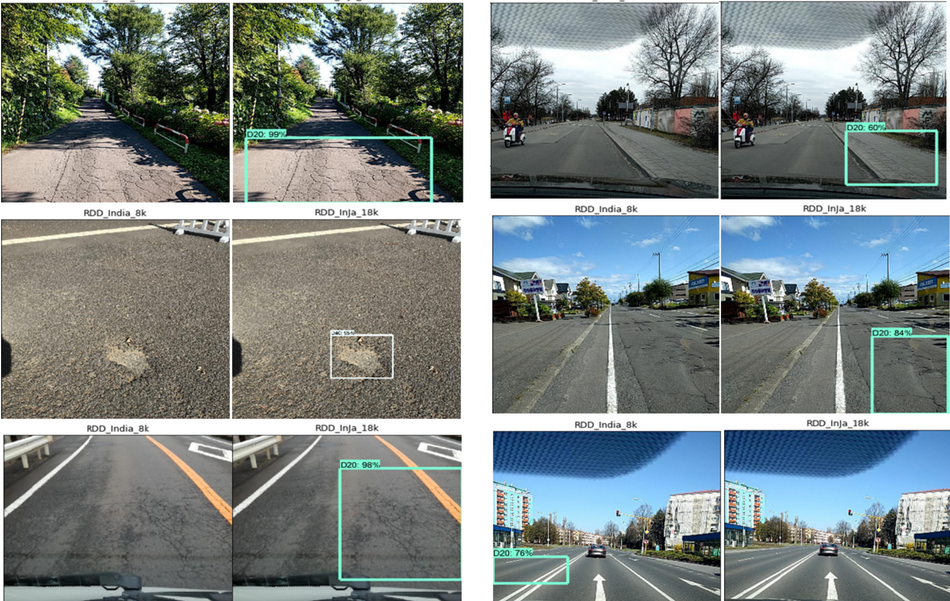

Владимир Новоселов из Mail.ru Group добавляет, что в высококонкурентных областях применения, таких как беспилотные автомобили, общедоступные датасеты по полноте и качеству подходят только для решения любительских и экспериментальных задач.

Наталья Соколова, глава Brand Analytics — компании в области мониторинга социальных сетей и СМИ, где данных по определению огромное количество, — тоже считает, что наличие общедоступных датасетов, безусловно, помогает только на начальном этапе проверки гипотез. В таких случаях куда более актуальная проблема — недостаточно высокое качество данных и большое количество ошибок. Или, как рассказывает Алексей Карначев из Just AI, наоборот:

В таких случаях куда более актуальная проблема — недостаточно высокое качество данных и большое количество ошибок. Или, как рассказывает Алексей Карначев из Just AI, наоборот:

Зачастую открытые датасеты слишком чистые — настолько, что специфика доменной информации, которая должна присутствовать в этих данных, попросту теряется. Наша R&D-команда изучала датасеты для разработки функционала «болталки» на естественном языке внутри диалоговой системы и использовала открытый датасет «Yandex.Toloka Persona Chat Rus», состоящий из 10 тыс. диалогов. Он как раз был чересчур чистым — таких диалогов в жизни не бывает: в них нет ошибок, разговорной или ненормативной лексики. Поэтому для конкретно этой цели качество датасета невысокое, хотя с ним все в порядке с точки зрения формальных критериев.

Датасеты, которые находятся в открытом доступе, создаются в основном для каких-то академических целей – например, для оценки качества моделей, при написании исследований. Поэтому они хороши для research-стадии, проверки гипотез, но не для финальных разработок.

Алексей Карначев

руководитель команды R&D Just AI

К слову, директор и учредитель Ассоциации участников рынка данных Иван Бегтин тоже подтверждает, что академические и коммерческие датасеты как правило лучше государственных и некоммерческих — последние чаще бывают плохого или среднего качества. Но Дмитрий Акимов из VisionLabs с этим не согласен:

Качество публичных датасетов достаточно хорошее, однако существуют ошибки в разметке и их объемы, как правило, малы. Кроме того, их нельзя использовать в коммерческих целях. Подобные наборы данных больше подходят для образовательных целей, а для выпуска продукта в продакшен нужны собственные данные.

Дмитрий Акимов

инженер по данным VisionLabs

Путаницу с качеством датасетов проясняет руководитель лаборатории машинного интеллекта компании Яндекс Александр Крайнов: в данном случае нужно говорить не о качестве, а о репрезентативности. И его вывод о работе компаний с данными вполне однозначен:

В целом редко бывает, что датасет, собранный не под очень конкретную задачу, полностью репрезентативен. Можно также говорить, что в каких-то областях датасетов хватает, в каких-то — нет. Но вся наука живет на общедоступных датасетах, и живет успешно.

Можно также говорить, что в каких-то областях датасетов хватает, в каких-то — нет. Но вся наука живет на общедоступных датасетах, и живет успешно.

В любом случае, сбор, поиск, генерация, разметка данных — это важная часть работы. Никто не должен подносить тебе данные. Хочешь делать ИИ-решения? Занимайся данными сам.

Как очищать данные и нужно ли это в принципе

Один из главных критериев некачественных данных — их недостаточная «чистота». Что это значит, объясняет эксперт:

Словосочетание «грязные данные» — это собирательный образ.

Во-первых, это набор неточностей и ошибок механического характера: опечатки, пропуски, разные форматы и прочее. Методы борьбы тут тоже исключительно механические — скучные, трудоемкие, но в целом понятные: аккуратность, прозрачные и документированные ETL-процедуры.

Во-вторых, семантические ошибки — например, оксюмороны вроде «беременных мужчин» и «пожилых пионеров». Лечение таких проблем чуть более творческая задача, но методы детектирования аномалий и выбросов существуют давно.

В-третьих (во многом это следствие предыдущих пунктов), это вопрос доверия к решениям и выводам ИИ-алгоритмов и их легитимность.

Адель Валиуллин напоминает о принципе GIGO — «Garbage In, Garbage Out» («Мусор на входе — мусор на выходе»).

Если входные данные включают в себя ошибки, то будут получены искаженные выводы, даже если сам по себе алгоритм правильный. Если данных действительно много, то можно пожертвовать грязным набором данных, удалив их из всего датасета. Также эффективные методы очистки можно реализовать на таких инструментах разметки данных как Яндекс.Толока и Amazon Mechanical Turk.

Адель Валиуллин

исполнительный директор Департамента анализа данных и моделирования «Газпромбанка»

Алексей Карначев из Just AI развивает мысль коллеги и на примерах показывает, как нейронные сети воспринимают подобные данные.

Например, мы хотим сделать классификатор документов. Допустим, корпус документов у нас «грязный»: слова содержат орфографические и пунктуационные ошибки, опечатки. Каждая ошибка в слове, по сути, раздувает словарь: есть слово «данные», а есть «даные» — с одной «н». Для алгоритма это два разных слова, в итоге данные зашумляются.

Каждая ошибка в слове, по сути, раздувает словарь: есть слово «данные», а есть «даные» — с одной «н». Для алгоритма это два разных слова, в итоге данные зашумляются.

С другой стороны, есть современные методы: нейронные LSTM-сети или трансформеры, любые современные NLP-модели. Для них часто вообще не нужно чистить данные. Если мы возьмем датасет диалогов с форума и исправим в них ошибки, можно убрать и полезную информацию, которая содержится в данных. Поэтому важнее не то, как чистить данные, а как понять, что данные «грязные» и нуждаются в чистке. Если же понятно, что нуждаются, то очистить их не проблема, просто на это нужно потратить время.

Алексей Карначев

руководитель команды R&D Just AI

Дмитрий Акимов из VisionLabs делится опытом — каким образом лучше работать с «грязными» данными:

Один из эффективных способов — переразметка. Мы используем краудсорсинг — это довольно затратно, но эффективно. Как правило, чем больше мы платим разметчикам, тем чище на выходе данные. Также мы используем технологию human in the loop: когда асессор исправляет уже размеченные ML-алгоритмом данные, на которых потом обучаются нейронные сети.

Также мы используем технологию human in the loop: когда асессор исправляет уже размеченные ML-алгоритмом данные, на которых потом обучаются нейронные сети.

Дмитрий Акимов

инженер по данным VisionLabs

Александр Крайнов из Яндекса тоже считает, что лучше краудсорсиноговой разметки ничего нет. Может помочь и количество данных, напоминает он: если их много, то «грязность» не так страшна.

Другие эксперты видят необходимость в превентивных мерах и системном подходе к решению проблемы.

Абсолютно чистых данных не бывает, вопрос степени загрязнения. Избегать следует системных искажений в выборке. Если же речь про случайные баги в разметке или признаках, то не вижу в этом проблемы: некоторая регуляризация не повредит. Это скорее всего не относится к по-настоящему грязным данным, с которыми мы не сталкивались.

Денис Власов

ведущий аналитик и специалист по машинному обучению «Учи.ру»

Директор Ассоциации участников рынка данных Иван Бегтин отмечает важность работы с «первоисточниками»: по его мнению, самый эффективный метод работы с «грязными» данными — убедить владельцев контролировать их ввод и очистку. С этой точкой зрения согласен Алексей Иванов из Sever.AI:

С этой точкой зрения согласен Алексей Иванов из Sever.AI:

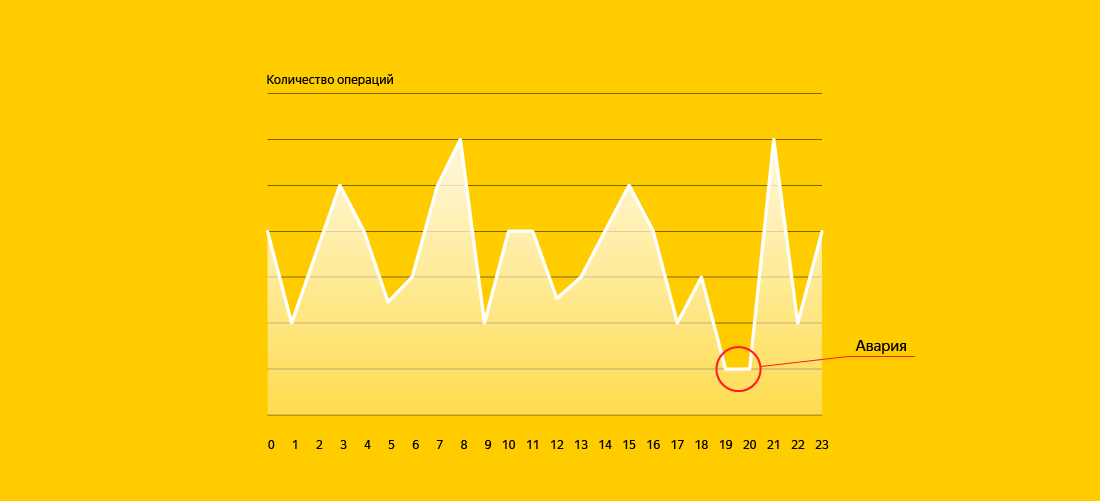

Для борьбы с «грязными» данными мне видится эффективным повышение культуры работы с датой внутри организации в целом. Нужны понятные структуры и дашборды, с помощью которых специалист может быстро определить, что что-то пошло не так.

Алексей Иванов

аналитик данных в Sever.AI ИТ-холдинга TalentTech

По мнению Петра Емельянова из UBIC Technologies, даже этот процесс в будущем может быть решен техническими способами:

В целом проблема грязных данных исключительно инфраструктурная. Мне кажется, что все самое интересное и прорывное, что ждет нас в индустрии в ближайшие годы, случится именно в инфраструктуре: появятся системы, которые будут эффективно чистить данные, закрывать вопросы конфиденциальности и т.д.

Не проще ли генерировать данные искусственно

Сегодня к подобным системам отчасти можно отнести синтетические данные. Это инструмент, который позволяет нейросетям обучаться на «виртуальных данных» — например, сгенерированных другими нейросетями, — и затем применяться в реальности. Мы попросили экспертов оценить, насколько такой подход действенен и оправдан.

Мы попросили экспертов оценить, насколько такой подход действенен и оправдан.

Есть разные подходы к созданию синтетических данных, и от выбора конкретного подхода в большой степени зависит эффективность их применения. В некоторых случаях без них не обойтись, и они помогают решить задачу, но в других случаях могут эффективно помочь только на стартовом этапе подготовки нейронных сетей.

Наталья Соколова

CEO Brand Analytics

То же самое говорит Алексей Карначев из Just AI: эффективность зависит от задачи.

Генерирование синтетических данных может быть оправдано, когда модель нам не принадлежит либо она чересчур тяжелая. В ином случае, если бы у нас на руках была модель, которая генерирует данные и удовлетворяет потребностям по размеру и быстродействию, мы скорее всего приспособили бы ее для основной задачи, а не для генерации данных. В любом случае, такая модель должна быть сильнее той, которая будет на этих данных обучаться.

В случае с обучением модели классификации текста есть альтернативный вариант. Если данных мало, мы можем дополнить датасет при помощи техники back translation. Переводим текст с русского на английский в «Google Переводчике», а потом обратно. Эффект известен — предложение меняется, иногда не совсем адекватно, но в основном мы получаем просто новую формулировку. Ее можно добавлять в датасет с тем же классом, расширяя его за счет синтетических данных.

Если данных мало, мы можем дополнить датасет при помощи техники back translation. Переводим текст с русского на английский в «Google Переводчике», а потом обратно. Эффект известен — предложение меняется, иногда не совсем адекватно, но в основном мы получаем просто новую формулировку. Ее можно добавлять в датасет с тем же классом, расширяя его за счет синтетических данных.

Алексей Карначев

руководитель команды R&D Just AI

Дмитрий Акимов из VisionLabs соглашается: синтетические данные не могут решить все проблемы, но позволяет обеспечить базовое обучение. Но на следующих этапах, предостерегает он, все равно потребуются реальные данные, поскольку «синтетика» не всегда дает прирост точности.

Того же мнения придерживается аналитик данных в Sever.AI Алексей Иванов:

Если мы говорим, например, про понимание естественного языка, про определение личностных характеристик человека по видео, то «живые» данные людей не заменит ничто. Впрочем, для выделения голоса из посторонних шумов можно использовать вариант синтетических данных, но и в этом случае исходные звуки и шумы должны быть настоящими.

Алексей Иванов

аналитик данных в Sever.AI ИТ-холдинга TalentTech

Важна также специфика отрасли. Например, Денис Власов из образовательной площадки «Учи.Ру» рассказывает, что компания не применяет этот метод, поскольку он в их случае не дает существенного преимущества, но повышает риск ошибок. То же самое говорит Анна Мещерякова про область здравоохранения:

«Синтетику» используют в более простых задачах: распознавании текста или дорожных знаков — там, где генерирование синтетических данных выполнить относительно просто. Задача создания качественной «синтетики», которая будет похожа на реальные данные и покрывать сложные и редкие случаи, намного сложнее. В медицине данные отличаются от аппарата к аппарату. Невозможно сгенерировать синтетические данные для аппарата, по которому не было получено «чистых», реальных данных.

Могут ли помочь новые регуляторные меры

Одним из вариантов частичного решения проблем с датасетами может стать эффективное государственное регулирование в этой области. Мы спросили у экспертов, считают ли они необходимым ввод дополнительных регуляторных инструментов.

Мы спросили у экспертов, считают ли они необходимым ввод дополнительных регуляторных инструментов.

Не считаю, что нужно дополнительное регулирование. На мой взгляд, датасеты должны быть открытыми, если они не являются коммерческой тайной или не содержат персональных данных. Ограничения приведут к образованию монополии на данные и снижению конкуренции, что всегда негативно сказывается на конечном продукте.

Дмитрий Акимов

инженер по данным VisionLabs

К слову, открытость датасетов — определяющий критерий для всех опрошенных нами экспертов. Директор Ассоциации участников рынка данных Иван Бегтин считает необходимым регулирование по раскрытию данных государством, поскольку открытые данные необходимы для развития рынка ИИ.

Директор Brand Analytics, Наталья Соколова смотрит на этот вопрос с другой стороны:

Внутри компаний дополнительное регулирование не нужно. Большие данные — всегда совокупность «малых» данных, которые и так регулируются законодательством. Практически все датасеты отмечены используемыми правами и источниками. Регулироваться могут персонализированные исходные данные при передаче во внешнюю компанию или организацию.

Практически все датасеты отмечены используемыми правами и источниками. Регулироваться могут персонализированные исходные данные при передаче во внешнюю компанию или организацию.

Наталья Соколова

CEO Brand Analytics

Анна Мещерякова из «Третьего мнения», в свою очередь, уже успела оценить положительный эффект от принятых ранее регуляторных решений в области здравоохранения.

Регулирование нужно, так как оно позволяет ускорить развитие отрасли и повысить число внедренных решений. Разработчики ИИ-сервисов для здравоохранения до недавнего времени не могли осуществлять продажи продуктов, так как критерии их отнесения к медицинским изделиям и соответствующие требования не были определены регулятором. На данный момент разъяснения получены, сертификация идет в ускоренном режиме.

Напомним, что недавно решение компании «Третье мнение» — умная система видеонаблюдения за пациентами — начало применяться в одной из клиник «Медси», где лечат больных коронавирусом.

Петр Емельянов из UBIC Technologies, в свою очередь, поднял вопрос безопасности данных — области, которая, по его мнению, безусловно требует дополнительных регуляторных мер.

Важно понимать, что есть разница между безопасностью и конфиденциальностью. Если, например, у человека крадут данные кредитной карты, то это вопрос безопасности: в общем случае человек звонит в банк и за две минуты аннулирует дискредитированную карту. А вот если человек серьезно болен, и об этом узнают, например, в результате утечки данных, то это более серьезная проблема — нарушение конфиденциальности. Поэтому, я считаю, что дополнительное разумное регулирование необходимо, а устранение преград должно происходить в технической плоскости.

Вопрос приватности данных в целом довольно активно обсуждается участниками индустрии.

В России пока нет закона, который бы регулировал использование ИИ в HR-сфере. Компаниям, которые планируют использовать ИИ, нужно быть прозрачными, научиться понимать и объяснять принципы работы алгоритмов. Было бы полезно ограничивать действия людей или даже компаний, которые хотят извлечь выгоду из повсеместного сбора данных. Но государственное и юридическое регулирование работы ИИ должно быть направлено на защиту интересов граждан и пользователей продуктов, а не на торможение развития современных технологий.

Алексей Иванов

аналитик данных в Sever.AI ИТ-холдинга TalentTech

По мнению Дениса Власова из «Учи.ру», важно устранить неопределенность в отношении персональных данных и барьеров в получении обезличенных данных. Ничто не подтолкнет разработки ИИ так, как появление открытых специализированных датасетов в здравоохранении, образовании и так далее.

О необходимости поиска баланса между персональными и обезличенными данными говорит и Александр Крайнов из Яндекса:

Всегда нужно искать баланс между защитой пользовательской информации и сбором данных для развития технологий и сервисов. Регулирование должно постоянно меняться вместе с развитием технологий и общества. Хорошее регулирование должно помогать прогрессу и минимизировать неприятные побочные эффекты.

Адель Валиуллин, в свою очередь, напоминает, что такие области как большие данные и ИИ активно развиваются и входят в большее количество сфер: медицина, финансы, образование, транспорт и др. А значит, регулирование в этой области неизбежно. Владимир Новоселов из Mail.Ru Group уточняет, что эта работа в интересах индустрии уже активно ведется:

Владимир Новоселов из Mail.Ru Group уточняет, что эта работа в интересах индустрии уже активно ведется:

В настоящий момент компетентные участники рынка задействованы в работе комитетов по разработке новых регуляторных норм. Это позволит, в частности, облегчить доступ к данным, необходимым для обучения ИИ, которыми располагают государственные органы, разрабатывать ML-сервисы на объединенных наборах данных из разных источников в режиме «песочниц».

Напомним, что 24 апреля Владимир Путин подписал закон об экспериментальном правовом режиме для ИИ-разработчиков в Москве. Он должен вступить в силу 1 июля и продлиться пять лет.

Больше информации о разработках в области искусственного интеллекта можно посмотреть в Базе знаний ИИ.

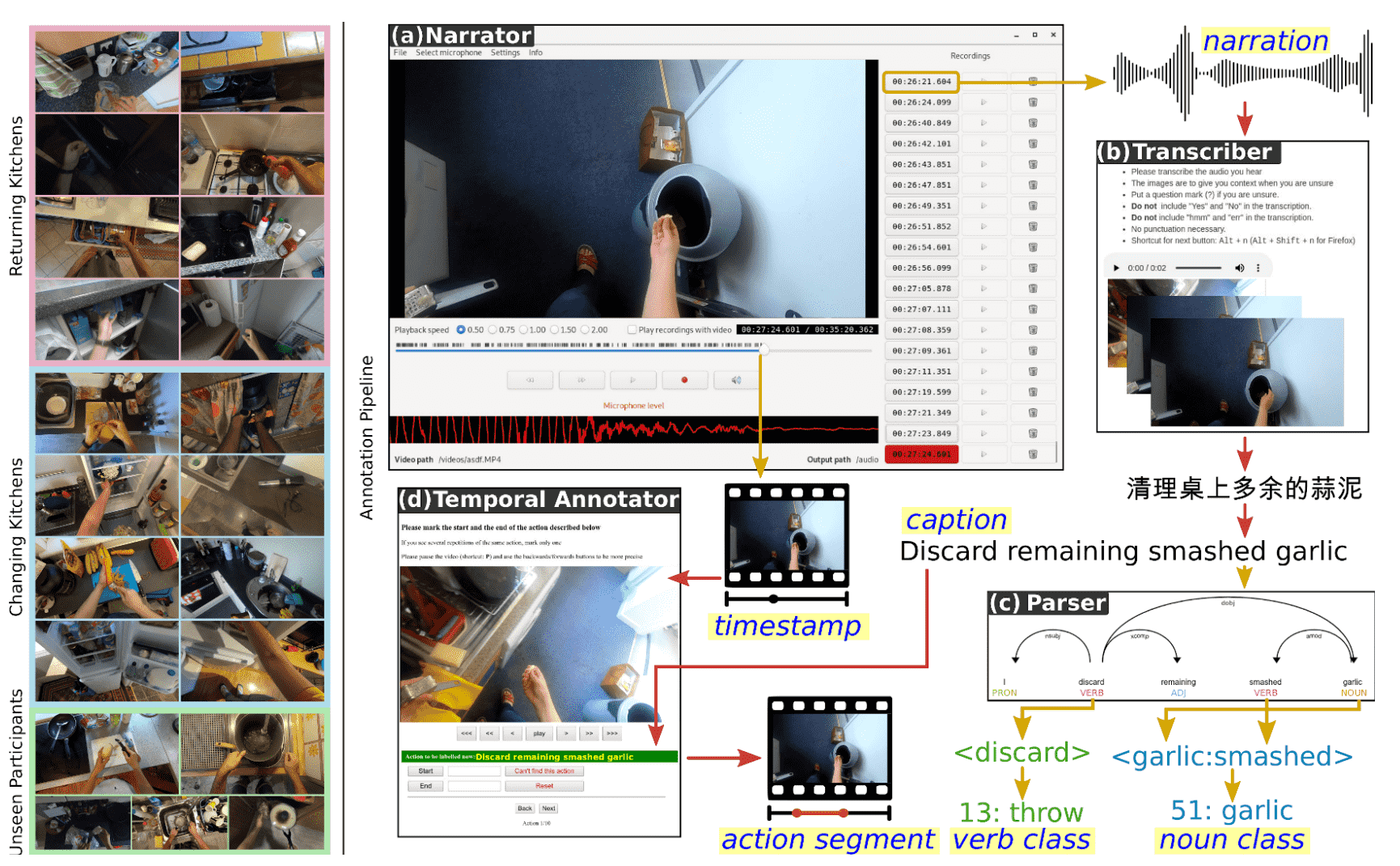

Google AI представила Fluid Annotation, «умный» интерфейс для разметки изображений

Команда Google AI разработала основанный на машинном обучении интерфейс, который сокращает время разметки объектов на фотографиях в три раза. Это позволит быстрее создавать большие корпуса изображений для систем компьютерного зрения. Разработчики создали демонстрационную веб-версию интерфейса, где каждый пользователь может попробовать очертить границы объектов на нескольких фотографиях.

Разработчики создали демонстрационную веб-версию интерфейса, где каждый пользователь может попробовать очертить границы объектов на нескольких фотографиях.

Проблема ручной разметки

Системы компьютерного зрения учатся распознавать объекты на изображениях, где эти объекты уже очерчены и подписаны. Разметка одной фотографии для набора COCO+Stuff занимает у человека около 19 минут, а всего датасета — 53 тысячи часов. Это налагает серьёзные ограничения на развитие распознающих моделей.

Подробнее о Fluid Annotation

В первую очередь нейросеть с архитектурой Mask-RCNN разбивает изображение на сегменты по грубым контурам объектов. Их получается больше тысячи, и каждому присваивается название и оценка доверия. Человек начинает работать с сегментами, получившими наиболее высокую оценку, после чего может:

- изменять подписи сегментов с помощью выпадающего меню;

- добавлять сегменты для объектов, которые модель не смогла распознать;

- удалять существующие сегменты;

- изменять карту глубины для сегментов, перекрывающих друг друга.

Таким образом, интерфейс позволяет человеку корректировать разметку объектов, а не выполнять работу с нуля.

Команда Google AI представит посвящённую Fluid Annotation статью 25 октября 2018 года на ACM Multimedia Conference 2018 в секции Brave New Ideas.

Помимо проблемы аннотации изображений, исследователи в области машинного обучения решают вопрос наполнения датасетов. Качество распознавания объекта зависит от того, насколько часто интеллектуальная система «встречала» его во время обучения. Летом 2018 года команда Google AI представила алгоритм, который генерирует уникальные изображения на основе существующих: с помощью обрезки, изменения цвета или отражения. Это позволяет увеличить размер датасета, не затрачивая время и силы на поиск новых изображений.

Source: блог Google AI

Набор данных | Центр поиска Google | Разработчики Google

Наборы данных

легче найти, если вы предоставите вспомогательную информацию, такую как их название, описание, создатель и форматы распространения.

как структурированные данные. Подход Google к обнаружению наборов данных

использует schema.org и другие стандарты метаданных, которые можно добавлять на страницы, описывающие наборы данных. Цель этой разметки —

улучшить обнаружение наборов данных из таких областей, как науки о жизни, социальные науки, машины

обучение, гражданские и правительственные данные и многое другое.Вы можете найти наборы данных, используя

Инструмент поиска по набору данных.

Вот несколько примеров того, что можно квалифицировать как набор данных:

- Таблица или файл CSV с некоторыми данными

- Организованный набор таблиц

- Файл в собственном формате, содержащий данные

- Набор файлов, которые вместе составляют некоторый значимый набор данных

- Структурированный объект с данными в другом формате, который вы, возможно, захотите загрузить в

специальный инструмент для обработки - Данные захвата изображений

- Файлы, относящиеся к машинному обучению, такие как обученные параметры или определения структуры нейронной сети

- Все, что вам кажется набором данных

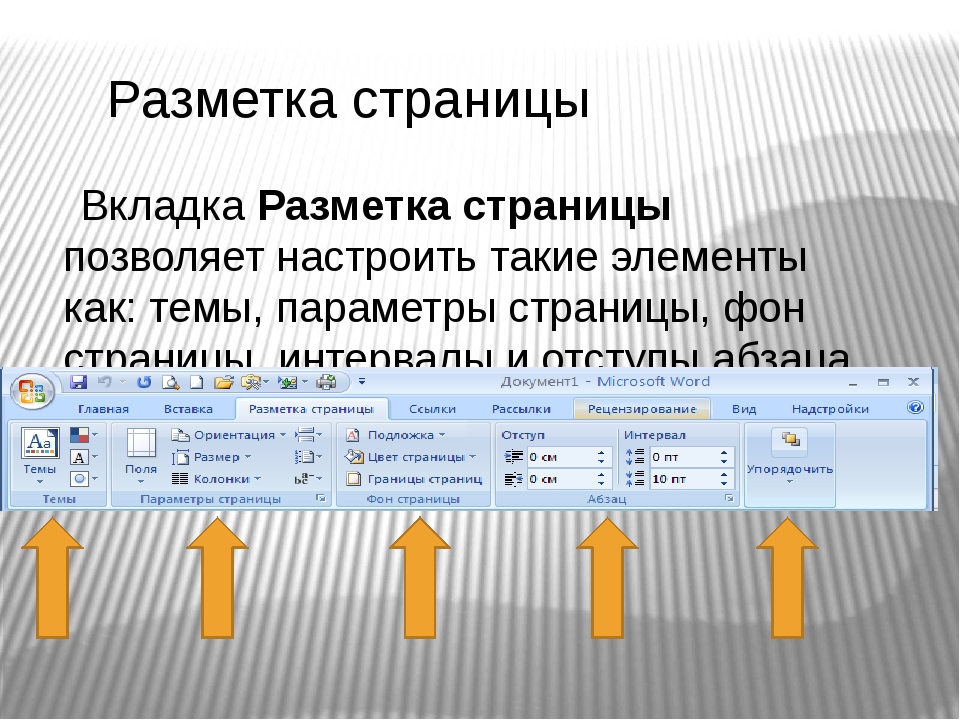

Как добавить структурированные данные

Структурированные данные — это стандартизированный формат для предоставления информации о странице и классификации страницы.

содержание.Если вы новичок в структурированных данных, вы можете узнать больше о

как работают структурированные данные.

Вот обзор того, как создавать, тестировать и выпускать структурированные данные. Пошаговое руководство

о том, как добавить структурированные данные на веб-страницу, см.

структурированный

данные codelab.

- Добавьте необходимые свойства. Для информации о том, где поставить

структурированные данные на странице, смотрите, как структурирован JSON-LD

данные: Куда вставить на странице. - Следуйте инструкциям.

- Подтвердите свой код с помощью

Богатый тест результатов. - Разверните несколько страниц, содержащих ваши структурированные данные, и используйте инструмент проверки URL-адресов, чтобы проверить, как Google видит страницу. Убедитесь, что ваша страница

доступны для Google и не блокируются файлом robots.txt, тегомnoindexили

требования для входа в систему. Если страница выглядит нормально, вы можете

Если страница выглядит нормально, вы можете

попросить Google

повторно просканируйте ваши URL.

Примечание : Дайте время для повторного сканирования и повторной индексации.Помните, что это

После публикации страницы Google может найти и просканировать ее через несколько дней. - Чтобы держать Google в курсе будущих изменений, мы рекомендуем вам

представить

карта сайта. Вы можете автоматизировать это с помощью

Карта сайта Search Console

API.

Удаление набора данных из результатов поиска набора данных

Если вы не хотите, чтобы набор данных отображался в результатах поиска по набору данных, используйте метатег robots, чтобы управлять тем, как ваш набор данных индексируется.Имейте в виду, что может потребоваться некоторое время (дни или недели, в зависимости от расписания сканирования), чтобы изменения отразились в поиске по набору данных.

Наш подход к обнаружению наборов данных

Мы можем понять структурированные данные на веб-страницах о наборах данных, используя либо разметку schema.org Dataset , либо эквивалентную

структуры, представленные в формате W3C Data Catalog Vocabulary (DCAT). Мы также изучаем

экспериментальная поддержка структурированных данных на основе W3C CSVW, и мы ожидаем развития и адаптации нашего подхода по мере появления передовых методов описания наборов данных.Для получения дополнительной информации о наших

подход к обнаружению наборов данных, см.

Упрощение поиска наборов данных.

Примеры

Вот пример для наборов данных, использующих синтаксис JSON-LD и schema.org (предпочтительно) в

Богатый тест результатов. Тот же словарь schema.org может также использоваться в синтаксисах RDFa 1.1 или Microdata.

Вы также можете использовать словарь W3C DCAT для описания метаданных. Следующий пример основан на

реальный мир

описание набора данных.

JSON-LD

Вот пример набора данных в JSON-LD:

База данных штормовых событий NCDC

RDFa

Вот пример набора данных в RDFa с использованием словаря DCAT:

- Имя:

- Данные о движении денежных средств ACME Inc

- Идентификаторы:

- https: // doi.org / 10.1000 / 182

- https://identifiers.

org/ark:/12345/fk1234

- Описание:

- Финансовая отчетность - Консолидированный отчет о движении денежных средств

- Категория:

- Финансы

- Загрузки:

Руководящие принципы

Сайты должны соответствовать структурированным данным

руководящие указания. В дополнение к рекомендациям по структурированным данным мы рекомендуем следующие

карта сайта, источник и происхождение

передовой опыт, указанный ниже.

Лучшие практики карты сайта

Используйте файл карты сайта в помощь

Google найдите ваши URL-адреса.Использование файлов карты сайта и разметки sameAs помогает документировать, как

описания наборов данных публикуются на вашем сайте.

Если у вас есть репозиторий наборов данных, вы, вероятно, имеете как минимум два типа страниц: канонические

(«целевые») страницы для каждого набора данных и страницы со списком нескольких наборов данных (например, поиск

результатов или некоторого подмножества наборов данных). Мы рекомендуем вам добавить структурированные данные о наборе данных в

Мы рекомендуем вам добавить структурированные данные о наборе данных в

канонические страницы. Используйте так же, как

для ссылки на каноническую страницу, если вы добавляете структурированные данные в несколько копий

набор данных, например списки на страницах результатов поиска.

Google не требует явной пометки всех упоминаний одного и того же набора данных.

вверх, но если вы сделаете это по другим причинам, мы настоятельно рекомендуем использовать

такой же как.

Источники и лучшие практики

Обычно открытые наборы данных переиздаются, агрегируются и основываются на других наборах данных.

Это начальная схема нашего подхода к представлению ситуаций, в которых набор данных является копией.

из другого набора данных или иным образом основанный на нем.

- Используйте

как

свойство для указания наиболее канонических URL-адресов для оригинала в случаях, когда набор данных или

description — это простое переиздание материалов, опубликованных в другом месте. Значение

Значение

то же, что и

однозначно указать идентичность набора данных — другими словами, два разных набора данных должны

не используйте тот же URL, что и

то же, что и значение. - Используйте свойство

isBasedOn

в случаях, когда повторно опубликованный набор данных (включая его метаданные) был изменен

существенно. - Если набор данных является производным или объединяет несколько оригиналов, используйте

isBasedOnсобственности. - Используйте идентификатор

свойство для прикрепления любых соответствующих идентификаторов цифровых объектов (DOI) или

Компактные идентификаторы. Если

набор данных имеет более одного идентификатора, повторите свойство идентификатора . Если

Если

используя JSON-LD, это представляется с использованием синтаксиса списка JSON.

Мы надеемся улучшить наши рекомендации на основе отзывов, в частности, в отношении описания

происхождение, управление версиями и даты, связанные с публикацией временных рядов.Пожалуйста, присоединяйтесь

обсуждения сообщества.

Рекомендации по текстовым свойствам

Мы рекомендуем ограничить все текстовые свойства до 5000 символов или меньше. Поиск по набору данных Google использует только первые 5000 символов любого текстового свойства. Имена и заголовки обычно состоят из нескольких слов или коротких предложений.

Известные ошибки и предупреждения

Вы можете столкнуться с ошибками или предупреждениями в Google Structured

Инструмент проверки данных и другие системы проверки.В частности, системы проверки могут

Предлагаем организациям иметь контактную информацию, включая contactType ; полезные значения включают

служба поддержки клиентов , экстренная помощь , журналист , отдел новостей и взаимодействие с общественностью .

Вы также можете игнорировать ошибки для csvw: Таблица является неожиданным значением для свойства mainEntity .

Определения структурированных типов данных

Вы должны включить необходимые свойства, чтобы ваш контент имел право на отображение в качестве расширенного результата.Вы также можете включить рекомендуемые свойства, чтобы добавить дополнительную информацию о своем контенте,

что может обеспечить лучший пользовательский опыт.

Вы можете использовать структурированный

Инструмент проверки данных для проверки вашей разметки.

Основное внимание уделяется описанию информации о наборе данных (его метаданных) и представлении его

содержание. Например, метаданные набора данных указывают, о чем этот набор данных, какие переменные

меры, кто это создал и так далее. Например, он не содержит конкретных значений для

переменные.

Набор данных

Полное определение набора данных доступно на

schema.org/Dataset.

Вы можете описать дополнительную информацию о публикации набора данных, например

лицензия, когда она была опубликована, ее

DOI,

или sameAs , указывающий на каноническую версию набора данных в другом

репозиторий. Добавьте идентификатор , лицензию и то же, что и для

наборы данных, содержащие информацию о происхождении и лицензии.

| Обязательные свойства | |

|---|---|

описание | Текст Краткое описание набора данных. Руководящие принципы

|

наименование | Текст Описательное имя набора данных. Например, «Высота снежного покрова в Северном полушарии». Руководящие принципы

Рекомендовано: Не рекомендуется: |

| Рекомендуемые свойства | |

|---|---|

альтернативное имя | Текст Альтернативные имена, которые использовались для обозначения этого набора данных, например псевдонимы или "name": "Быстрый рисунок! Набор данных" "alternateName": ["Набор данных быстрого рисования", "набор данных быстрого рисования"] |

создатель | Лицо или Организация Создатель или автор этого набора данных.

"создатель": [

{

"@type": "Человек",

«sameAs»: «http://orcid.org/0000-0000-0000-0000»,

"givenName": "Джейн",

"familyName": "Фу",

"name": "Джейн Фу"

},

{

"@type": "Человек",

«sameAs»: «http://orcid.org/0000-0000-0000-0001»,

"givenName": "Джо",

"familyName": "Бар",

"name": "Джо Бар"

},

{

"@type": "Организация",

«sameAs»: «http: // ror.org / xxxxxxxxx ",

"name": "Консорциум фиктивных исследований"

}

] |

цитата | Текст или CreativeWork Обозначает академические статьи, которые поставщик данных рекомендует цитировать в дополнение к "цитата": "https://doi.org/10.1111/111" "цитата": "https://identifiers.org/pubmed:11111111" "цитата": "https://identifiers.org/arxiv:0111.1111v1" "цитата": "Доу Дж. (2014) Влияние X... https://doi.org/10.1111/111 " Дополнительные указания |

hasPart или isPart | URL или Набор данных Если набор данных представляет собой набор небольших наборов данных, используйте свойство

"hasPart": [

{

"@type": "Набор данных",

"name": "Дополнительный набор данных 01",

"description": "Информативное описание первого набора данных ...",

«лицензия»: «https://creativecommons.org/publicdomain/zero/1.0/»

},

{

"@type": "Набор данных",

"name": "Дополнительный набор данных 02",

"description": "Информативное описание второго набора данных... ",

«лицензия»: «https://creativecommons.org/publicdomain/zero/1.0/»

}

]

"isPartOf": "https://example. |

идентификатор | URL , Текст или PropertyValue Идентификатор, например DOI или компактный идентификатор. Если в наборе данных более одного |

ключевых слов | Текст Ключевые слова, обобщающие набор данных. |

лицензия | URL или CreativeWork Лицензия, по которой распространяется набор данных. «лицензия»: «https://creativecommons.org/publicdomain/zero/1.0/»

"лицензия": {

"@type": "CreativeWork",

"name": "Специальная лицензия",

"url": "https: // пример.ru / custom_license "

} Дополнительные указания |

Методика измерения | Текст или URL Метод, технология или методология, используемые в наборе данных, который может соответствовать переменной (ам), описанной в Измерение |

как | URL URL-адрес справочной веб-страницы, недвусмысленно указывающий на идентичность набора данных. |

пространственное покрытие | Текст или Место Вы можете указать одну точку, которая описывает пространственный аспект набора данных.Только Очки

"SpaceCoverage:" {

"@type": "Место",

"geo": {

"@type": "ГеоКоординаты",

«широта»: 39,3280,

«долгота»: 120,1633

}

} Формы Используйте GeoShape для описания областей различной формы.

"SpaceCoverage:" {

"@type": "Место",

"geo": {

"@type": "GeoShape",

"box": "39.3280 120.1633 40.445 123.7878"

}

} точек внутри Именованные места "SpaceCoverage:" "Тахо-Сити, Калифорния" |

временное покрытие | Текст Данные в наборе данных охватывают определенный временной интервал. Одна дата "temporalCoverage": "2008" Период времени "temporalCoverage": "1950-01-01 / 2013-12-18" Бессрочный временной период "temporalCoverage": "2013-12-19 /.. » |

переменная Измеренная | Текст или PropertyValue Переменная, которую измеряет этот набор данных. Переменная |

версия | Текст или Номер Номер версии для набора данных. |

url | URL Расположение страницы с описанием набора данных. |

Каталог данных

Полное определение DataCatalog доступно на

schema.org/DataCatalog.

Наборы данных часто публикуются в репозиториях, содержащих много других

наборы данных. Один и тот же набор данных может быть включен в более чем один такой репозиторий.Ты

Один и тот же набор данных может быть включен в более чем один такой репозиторий.Ты

может ссылаться на каталог данных, к которому принадлежит этот набор данных, ссылаясь на него

напрямую.

| Рекомендуемые свойства | |

|---|---|

включены в каталог данных | Каталог данных Каталог, которому принадлежит набор данных. |

Данные Загрузить

Полное определение DataDownload доступно на

schema.org/DataDownload.Помимо свойств набора данных,

добавьте следующие свойства для наборов данных, которые предоставляют варианты загрузки.

Распределение Свойство описывает, как получить сам набор данных, поскольку URL-адрес

часто указывает на целевую страницу с описанием набора данных. Распределение

Распределение

Свойство описывает, где и в каком формате брать данные. Это свойство может

имеют несколько значений: например, версия CSV имеет один URL и Excel

версия доступна у другой.

| Обязательные свойства | |

|---|---|

distribution.contentUrl | URL Ссылка для скачивания. |

| Рекомендуемые свойства | |

|---|---|

распределение | ДанныеСкачать Описание места для загрузки набора данных и формат файла для |

Распределение.encodingFormat | Текст или URL Формат файла раздачи. |

Табличные наборы данных