В многопоточных системах поток есть: Операционные системы | Вопросы с ответами

Операционные системы | Вопросы с ответами

|

Вопросы с ответами (тест) по дисциплине «Операционные системы». |

1. Выберите из предложенного списка, что может являться критерием эффективности вычислительной системы:

+пропускная способность

-занятость оперативной памяти

-загруженность центрального процессора

-занятость временной памяти

2. Системы пакетной обработки предназначены для решения задач:

+вычислительного характера

-требующих постоянного диалога с пользователем

-занятость оперативной памяти

-требующих решения конкретной задачи за определенный промежуток времени

3. В каких системах гарантируется выполнение задания за определенный промежуток времени:

-пакетной обработки

-разделения времени

-занятость оперативной памяти

+системах реального времени

4. В системах пакетной обработки суммарное время выполнения смеси задач:

+равно сумме времен выполнения всех задач смеси

-меньше или равно суммы времен выполнения всех задач смеси

-больше или равно суммы времен выполнения всех задач смеси

-занятость оперативной памяти

5. В системах реального времени

-набор задач неизвестен заранее

-занятость оперативной памяти

-набор задач известен заранее

+известен или нет набор задач зависит от характера системы

6. Самое неэффективное использование ресурсов вычислительной системы:

+в системах пакетной обработки

-занятость оперативной памяти

-в системах разделения времени

-в системах реального времени

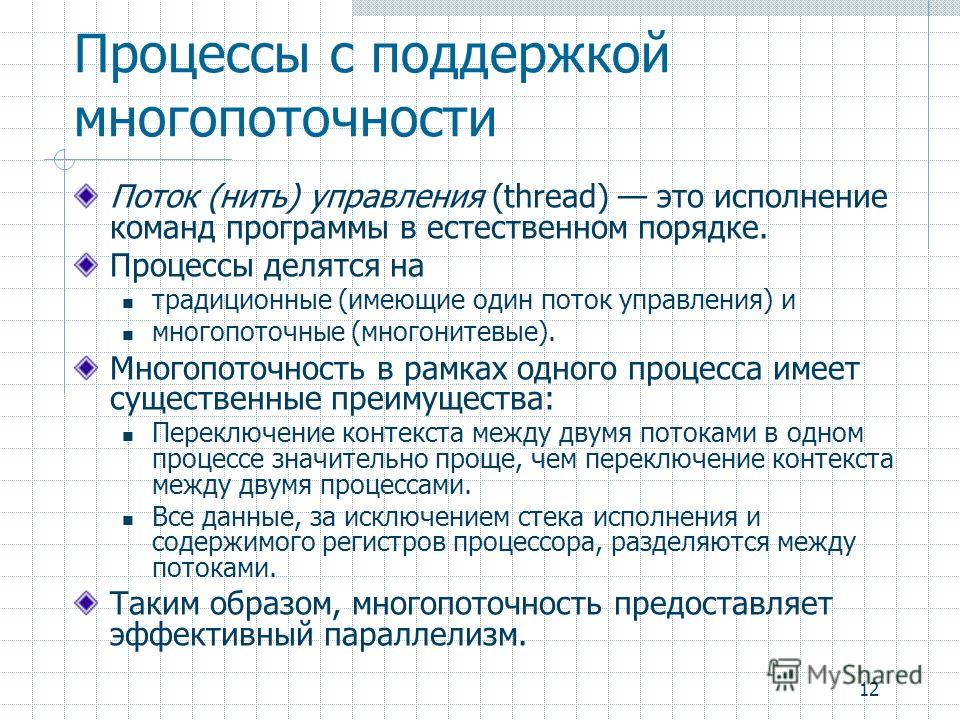

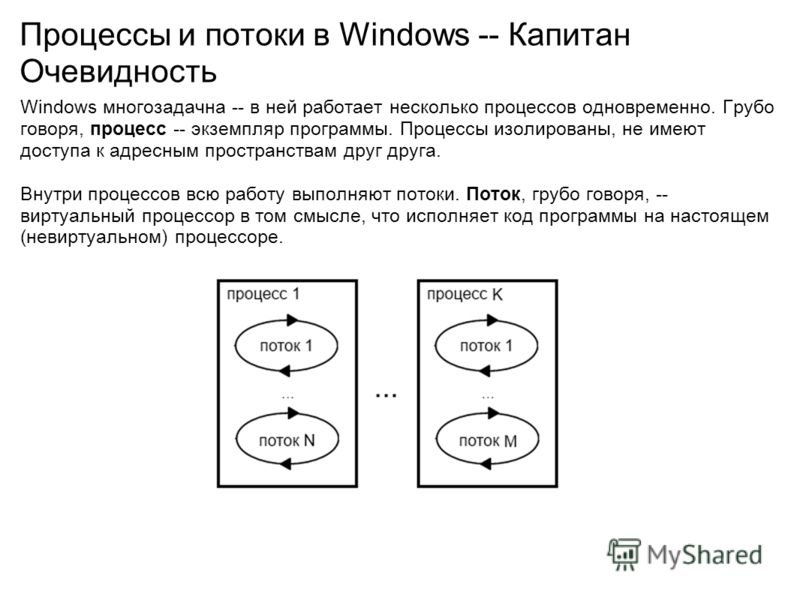

7. В многопоточных системах поток есть –

В многопоточных системах поток есть –

-заявка на ресурсы

-занятость оперативной памяти

-заявка на ресурс ЦП

+заявка на ресурс ОП

8. Потоки создаются с целью:

+ускорения работы процесса

-защиты областей памяти

-занятость оперативной памяти

-улучшения межпроцессного взаимодействия

9. Как с точки зрения экономии ресурсов лучше распараллелить работу:

-создать несколько процессов

-создать несколько потоков

-занятость оперативной памяти

+оба равнозначны, можно выбирать любой из них

10. Планирование потоков игнорирует:

-приоритет потока

-занятость оперативной памяти

-время ожидания в очереди

+принадлежность некоторому процессу

11. В каких системах тип планирования статический

-реального времени

-разделения времени

-занятость оперативной памяти

+пакетной обработки

12. Состояние, которое не определено для потока в системе:

-выполнение

-синхронизация

-ожидание

+готовность

13. Каких смен состояний не существует в системе:

+выполнение → готовность

-ожидание →выполнение

-ожидание → готовность

-готовность → ожидание

14. Какой из алгоритмов планирования является централизованным:

-вытесняющий

-памятный

-возможный

+невытесняющий

15. При каком кванте времени в системах, использующих алгоритм квантования, время ожидания потока в очереди не зависит от длительности ее выполнения:

-при маленьком кванте времени

-занятость оперативной памяти

-при длительном кванте времени

+при любом кванте времени

16. Приоритет процесса не зависит от:

Приоритет процесса не зависит от:

-того, является ли процесс системным или прикладным

+статуса пользователя

-требуемых процессом ресурсов

-занятость оперативной памяти

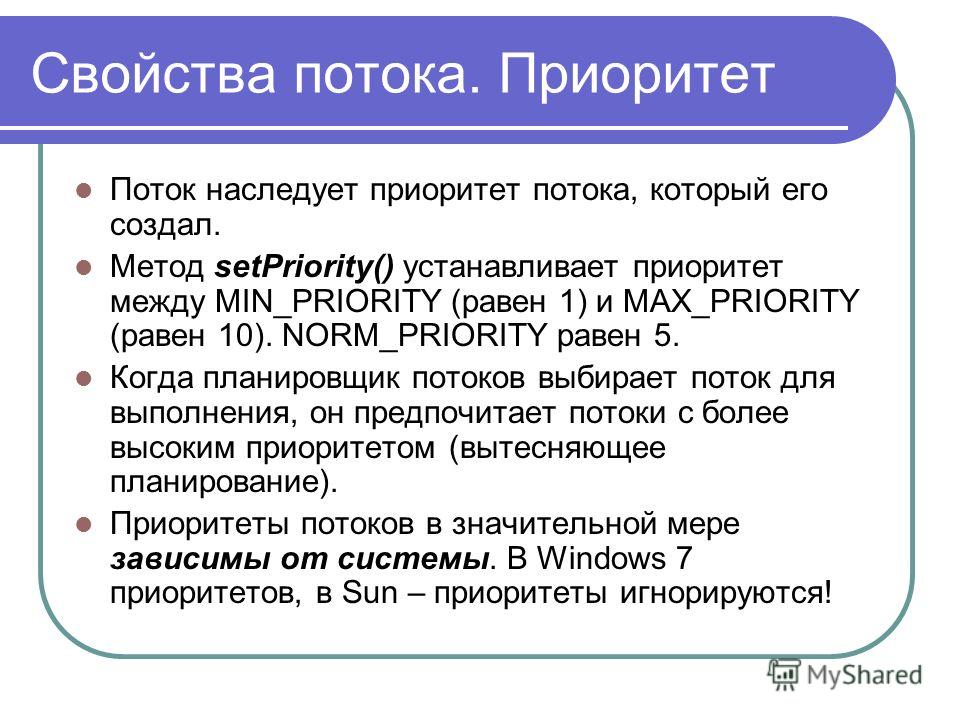

17. В каких пределах может изменяться приоритет потока в системе Windows NT:

-от базового приоритета процесса до нижней границы диапазона приоритета потоков реального времени

-от нуля до базового приоритета процесса

-занятость оперативной памяти

+базовый приоритет процесса ± 2

18. Каких классов прерываний нет?

-аппаратных

-асинхронных

-внутренних

+программных

19. Какие из прерываний можно считать синхронными?

-внешние

+внутренние

-программные

-динамические

20. Память с самой высокой стоимостью единицы хранения:

-дисковая память

-оперативная память

-занятость оперативной памяти

+регистры процессора

21. Какая функция ОС по управления оперативной памятью характерна только для мультизадачных ОС:

-выделение памяти по запросу

-освобождение памяти по завершению процесса

-занятость оперативной памяти

+защита памяти

22. Какая стратегия управления памятью определяет, какие конкретно данные необходимо загружать в память:

+выборки

-размещения

-замещения

-загрузки

23. Виртуальные адреса являются результатом работы:

-пользователя

+транслятора

-компоновщика

-ассемблера

24. Какого типа адреса могут быть одинаковыми в разных процессах:

+виртуальные

-физические

-реальные

-сегментные

25. Недостатки распределения памяти фиксированными разделами:

Недостатки распределения памяти фиксированными разделами:

-сложность реализации

-сложность защиты

+ограничение на число одновременно выполняющихся процессов

-фрагментация памяти

26. Какой процесс обязательно должен выполняться в системе памяти с перемещаемыми разделами:

-сжатие

-перемещение

-занятость оперативной памяти

+свопинг

27. Что из ниже перечисленного верно для свопинга:

-на диск выгружается неиспользуемая в настоящий момент часть процесса

-на диск выгружаются неиспользуемые процессом данные

-занятость оперативной памяти

+на диск выгружается не активный процесс

28. Таблица страниц используется для:

+преобразования виртуального адреса в физический

-для ускорения работы процесса

-для реализации свопинга

-занятость оперативной памяти

29. Объем страницы:

-выбирается по возможности максимальный

-занятость оперативной памяти

-выбирается минимальным

+для процессоров х86 стандартно равен 4 кбайта

30. Кэширование – это:

-способ функционирования дисковых устройств

-способ работы с ОП

-занятость оперативной памяти

+способ взаимного функционирования двух типов запоминающих устройств

31. Что может выступать в качестве кэша для ОП:

+дисковые устройства

-быстродействующая статическая память

-виртуальная память

-занятость оперативной памяти

32. Атаки класса «отказ в обслуживании» направлены на:

+полный или частичный вывод ОС из строя

-вывод из строя аппаратуры ПК

-занятость оперативной памяти

-полное или частичное удаление установленного ПО

33. Какой вид многозадачности не существует?

Какой вид многозадачности не существует?

-Вытесняющая многозадачность

+Кооперативная (не вытесняющая) многозадачность

-занятость оперативной памяти

-Симметричная многозадачность

34. Существуют ли классификация ядер ОС по особенностям выполнения ядра в многопроцессорных системах? (учитывая, что такие системы ядром поддерживаются)

-Да

+Нет

-Возможно

-Нереально

35. Где должен располагаться код для обнаружения оборудования? (учитывая современные устройства)

+В ядре (или обязательных модулях, серверах для немонолитных архитектур)

-Вне ядра, в драйверах

-Не занятость оперативной памяти

-Занятость оперативной памяти

36. Какое ядро современных ОС поддерживает Multiboot Specification?

+Windows

-SunOS 82

-MacOS

-Все ядра BSD

37. Что означает аббревиатура PIC в контексте ОС?

-Programmable Interrupt Controller

-Past Implemented Code

-Position Independent Code

+Portable Incompatible Code

38. Какие основные преимущества микроядерной архитектуры?

-Упрощение переносимости

-Улучшение безопасности

+Повышенные отказоустойчивость и степень структурированности

-Все выше перечисленное

39. Предшественником какого современного семейства ОС была ОС Minix Эндрю Таненбаума?

-BSD

-Windows

-СИЛК

+Linux

40. Нашли ли экзоядерные ОС широкое применение в современной вычислительной технике?

-Да

+Нет

-Возможно

-Нереально

41. В какой из ОС впервые был реализован стек протоколов TCP/IP?

В какой из ОС впервые был реализован стек протоколов TCP/IP?

-BSD

+Windows

-Linux

-DOS

42. Выберите не подходящее утверждение об отношении DOS к первым версиям Windows?

+В Windows можно было запускать приложения DOS

-занятость оперативной памяти

-Многие функции Windows делегировались соответствующим функциям DOS (то есть для этого производилось переключение режимов работы ЦПУ)

-Поддержка приложений DOS была ограниченной и неполной (при эмуляции на VDM, в рамках режима V86)

43. В какой ОС поддержка графического интерфейса пользователя (GUI) интегрирована непосредственно в ядро?

-Windows

-Оникс

-BSD

+Linux

44. Укажите типы сообщений, которые могут использоваться в микроядерных ОС

+Синхронные и асинхронные

-Только синхронные

-Паразиторные

-Только асинхронные

45. В чём главный недостаток монолитных ядер?

+Их нельзя модифицировать во время работы

-Со временем они настолько разрастаются, что резко усложняется внесение каких-либо изменений

-Они занимают слишком много оперативной памяти

-Невозможно

46. Укажите основное средство межпроцессного взаимодействия в микроядерных архитектурах

-Потоки

+Удалённые вызовы процедур (RPC, Remote Procedure Call)

-Сообщения

-СМС

47. Какая нотация вызовов функций принята в системных вызовах Windows?

-Смесь нотаций языков C и Pascal (обратный порядок аргументов, очистка стека функцией)

-Нотация языка Pascal (прямой порядок аргументов, очистка стека функцией)

-Нотационные знаки

+Нотация языка C (обратный порядок аргументов, очистка стека вызывающим кодом)

48. Достаточно ли установки антивирусного пакета для того, чтобы считать ОС защищенной:

Достаточно ли установки антивирусного пакета для того, чтобы считать ОС защищенной:

+да

-нет

-Возможно

-зависит от конкретных условий работы

49. Для обеспечения безопасности системы должны использоваться средства, которые при отказе переходят в состояние:

-максимальной защиты

+минимальной защиты

-средняя защита

-нормальная защита

50. При организации защиты в системе необходимо руководствоваться принципом:

+максимальной защиты

-минимальной защиты

-без баланса

-баланса возможного ущерба от угрозы и затрат на ее предотвращение

51. Слабости парольной защиты:

+трудность распознавания

-возможность раскрытия пароля путем подбора

-возможность обхода парольной защиты

-занятость оперативной памяти

52. Процесс авторизации – это процесс

-ввода пользователем учетной информации

-доказательства того, что пользователь тот, за кого себя выдает

-занятость оперативной памяти

+выполнения действий, необходимых для того, чтобы пользователь мог начать работу в системе

53. В асимметричных системах шифрования:

-ключ шифрования совпадает с ключом расшифрования

-занятость оперативной памяти

-ключ шифрования отличается от ключа расшифрования

+ключи генерируются случайным образом

54. Правила разграничения доступа не должны позволять:

-присутствия ничейных объектов в системе

-занятость оперативной памяти

-присутствия объектов, недоступных для администраторов системы

+присутствия всем доступных объектов

55. Файловая система является частью:

Файловая система является частью:

-дисковых систем

-драйверов дисков

+ОС

-пользовательских программ

56. Какую структуру образуют файлы в ФС (файловой системе) FAT?

-древовидную

+сетевую

-реляционную

-плоскую

57. Определите, какое это имя файла: USER\DO\FEDYA DOC:

+полное

-простое

-относительное

-конечный

58. Одна ФС в системах Windows занимает, как правило:

-1 физический диск

-1 логический диск

+1 раздел диска

-1 логика

59. В ФС FAT атрибуты файлов хранятся

+вместе с файлом

-в каталогах

-в индексных дескрипторах

-в таблицах FAT

60. Диски – это память:

+с последовательным доступом

-с индексно-последовательным доступом

-с прямым доступом

-с левым

61. Какой разметки нет на диске?

-дорожек

+кластеров

-цилиндров

-секторов

62. Минимальная единица, участвующая в операциях обмена с дисковым устройством:

-байт

-сектор

+дорожка

-цилиндр

63. Размер логического диска:

+меньше или равен размеру раздела

-равен размеру раздела

-больше или равен размеру раздела

-занятость оперативной памяти

64. ОС Windows поддерживают следующие типы разделов:

+основной

-базовый

-подкачки

-дополнительный

65. Раздел, с которого загружается ОС при запуске компьютера называется:

-загрузочным

-основным

-дополнительным

+активным

66. Минимальный фактический размер файла на диске равен:

Минимальный фактический размер файла на диске равен:

-1 биту

-1 байту

-1 сектору

+1 кластеру

67. На диске не может быть кластера размером:

+512 байт

-1024 байта

-1536 байт

-2048 байт

68. Числовое значение –12, 16, 32 – в ФС FAT отражает:

-размер кластера на диске

-дополнительный

+разрядность элемента в таблице FAT

-допустимое количество символов в имени файла

69. Максимальный размер диска, поддерживаемого FAT16:

-практически неограничен

-1024 кбит

-512 Мбайт

+2 Гбайта

70. Недостатки ФС FAT:

-сложность реализации

+не поддерживают разграничения доступа к файлам и каталогам

-не поддерживают длинных имен файлов

-не содержат средств поддержки отказоустойчивости

71. Какие функции выполняет операционная система?

-обеспечение организации и хранения файлов

-занятость оперативной памяти

+организация диалога с пользователем, управления аппаратурой и ресурсами компьютера

-все выше перечисленные

72. Где находится BIOS?

-в оперативно-запоминающем устройстве (ОЗУ)

-на винчестере

-на CD-ROM

+в постоянно-запоминающем устройстве (ПЗУ)

73. Папка, в которую временно попадают удалённые объекты, называется

+Корзина

-Оперативная

-Портфель

-Блокнот

74. Текущий диск — это

+диск, с которым пользователь работает в данный момент времени

-CD-ROM

-жесткий диск

-диск, в котором хранится операционная система

75. ОС Windows поддерживает длинные имена файлов Длинным именем файла считается

ОС Windows поддерживает длинные имена файлов Длинным именем файла считается

-любое имя файла без ограничения на количество символов в имени файла

-любое имя файла латинскими буквами, не превыщающее 255 символов

-занятость оперативной памяти

+любое имя файла, не превышающее 255 символов

76. Внутренние команды — это

-команды, предназначенные для создания файлов и каталогов

-занятость оперативной памяти

+команды, встроенные в DOS

-команды, которые имеют расширения sys, exe, com

77. Загрузчик операционной системы MS DOS служит для

-загрузки программ в оперативную память ЭВМ

-обработки команд, введенных пользователем

+считывания в память модулей операционной системы io sys и msdos sys

-подключения устройств ввода-вывода

78. Какие команды DOS называются внешними?

-команды, предназначенные только для работы с периферийными устройствами

-занятость оперативной памяти

+команды, хранящиеся на диске в виде отдельных программа и вызываемые по мере необходимости

-все команды, которые можно реализовать с помощью DOS

79. BIOS — это

-игровая программа

-диалоговая оболочка

+базовая система ввода-вывода

-командный язык операционной системы

80. Операционная система сети включает в себя управляющие и обслуживающие программы К управляющим относятся

-Межпрограммный доступ

-Доступ отдельных прикладных программ к ресурсам сети

-Синхронизация работы прикладных программных средств

+Все выше перечисленные

81. Какой вид многозадачности не существует?

Какой вид многозадачности не существует?

-Вытесняющая многозадачность

-Кооперативная (не вытесняющая) многозадачность

+Симметричная многозадачность

-занятость оперативной памяти

82. Существуют ли классификация ядер ОС по особенностям выполнения ядра в многопроцессорных системах? (учитывая, что такие системы ядром поддерживаются)

+Да

-Нет

-Возможно

-Невозможно

83. Где должен располагаться код для обнаружения оборудования? (учитывая современные устройства)

+В ядре (или обязательных модулях, серверах для немонолитных архитектур)

-Вне ядра, в драйверах

-В памяти

-В дисководе

84. Какое ядро современных ОС поддерживает Multiboot Specification?

-Windows

-MacOS

+Linux

-Все ядра BSD

85. Что означает аббревиатура PIC в контексте ОС?

-Programmable Interrupt Controller

-Past Implemented Code

+Position Independent Code

-Portable Incompatible Code

86. Какие основные преимущества микроядерной архитектуры?

-Упрощение переносимости

-Улучшение безопасности

+Повышенные отказоустойчивость и степень структурированности

-Все выше перечисленное

87. Предшественником какого современного семейства ОС была ОС Minix Эндрю Таненбаума?

-BSD

-Windows

+Linux

-СМС

88. Нашли ли экзоядерные ОС широкое применение в современной вычислительной технике?

-Да

-Возможно

-Нереально

+Нет

89. В какой из ОС впервые был реализован стек протоколов TCP/IP?

В какой из ОС впервые был реализован стек протоколов TCP/IP?

+BSD

-Windows

-Linux

-DOS

90. Выберите не подходящее утверждение об отношении DOS к первым версиям Windows?

-В Windows можно было запускать приложения DOS

-занятость оперативной памяти

-Многие функции Windows делегировались соответствующим функциям DOS (то есть для этого производилось переключение режимов работы ЦПУ)

+Поддержка приложений DOS была ограниченной и неполной (при эмуляции на VDM, в рамках режима V86)

91. В какой ОС поддержка графического интерфейса пользователя (GUI) интегрирована непосредственно в ядро?

+Windows

-BSD

-СМС

-Linux

92. Укажите типы сообщений, которые могут использоваться в микроядерных ОС

+Синхронные и асинхронные

-Параллельные

-Только синхронные

-Только асинхронные

93. В чём главный недостаток монолитных ядер?

-Их нельзя модифицировать во время работы

-занятость оперативной памяти

+Со временем они настолько разрастаются, что резко усложняется внесение каких-либо изменений

-Они занимают слишком много оперативной памяти

94. Укажите основное средство межпроцессного взаимодействия в микроядерных архитектурах

-Потоки

-занятость оперативной памяти

-Удалённые вызовы процедур (RPC, Remote Procedure Call)

+Сообщения

95. Какая нотация вызовов функций принята в системных вызовах Windows?

+Смесь нотаций языков C и Pascal (обратный порядок аргументов, очистка стека функцией)

-Нотация языка Pascal (прямой порядок аргументов, очистка стека функцией)

-Нотация языка C (обратный порядок аргументов, очистка стека вызывающим кодом)

-занятость оперативной памяти

96. Для выполнения каких операций оптимизирована серверная операционная система Novell NetWare?

Для выполнения каких операций оптимизирована серверная операционная система Novell NetWare?

-доступ к файлам

+доступ к файлам и печать

-почтовая служба

-занятость оперативной памяти

97. Какие из этих ОС могут использоваться для построения одноранговых сетей?

-NetWare

+Windows 95/98

-занятость оперативной памяти

-MS-DOS

98. Какие задачи не выполняет ОС при обмене с периферийным устройством?

-решает, может ли быть выполнена требуемая операция обмена

-передает запрос драйверу ПУ

-занятость оперативной памяти

+принимает информацию из сети от устройства управления ПУ

99. Сколько выделенных серверов может одновременно работать в сети?

-нет специальных ограничений

-занятость оперативной памяти

+только один

-по числу требуемых в сети служб — для каждой сетевой службы отдельный выделенный сервер

100. Пусть сеть состоит из идентичных компьютеров, на которых установлены однотипные ОС За одним из компьютеров административно закреплены функции по обслуживанию запросов остальных компьютеров(все пользователи сети хранят свои файлы на диске этого компьютера) К какому типу сети вы отнесете эту сеть?

-сеть с выделенным сервером

-занятость оперативной памяти

+одноранговая сеть

-гибридная сеть

Комментарии:

Добавить комментарий

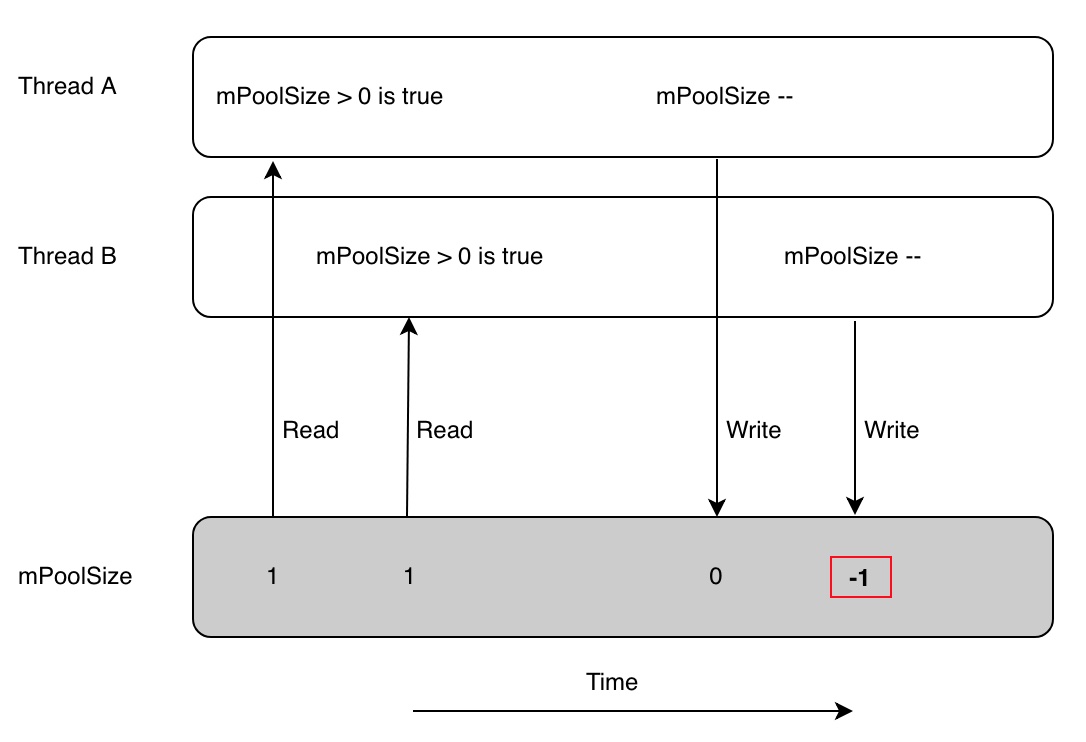

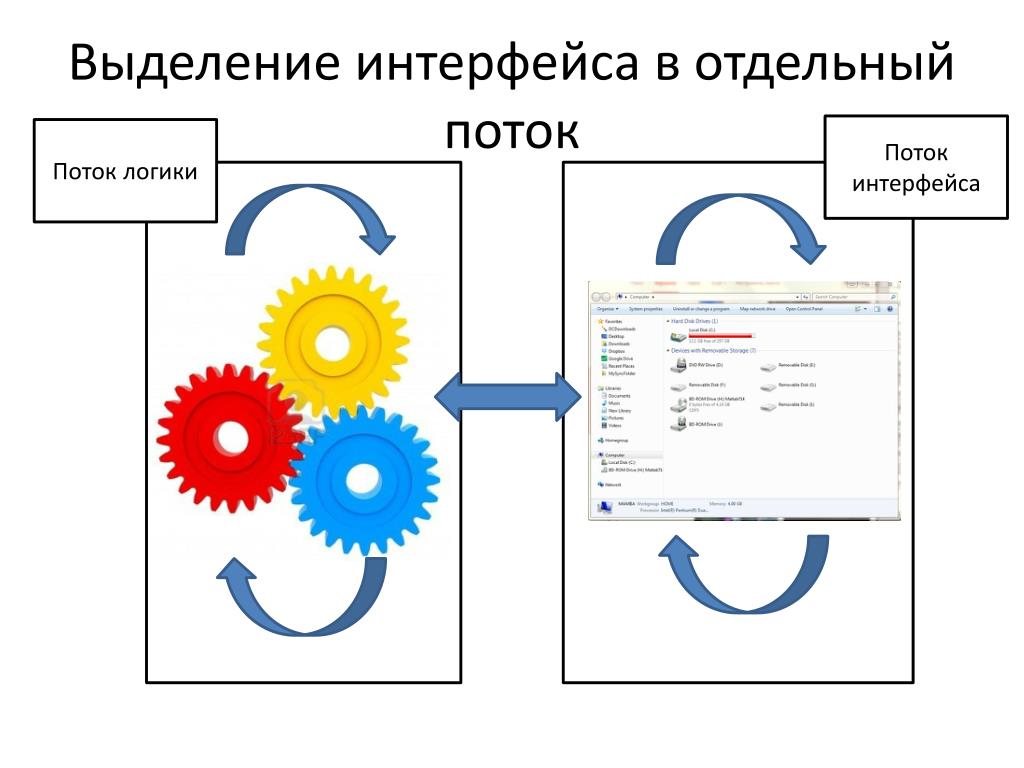

Потоки в операционных системах нужны для двух вещей – для параллелизма и одновременности.

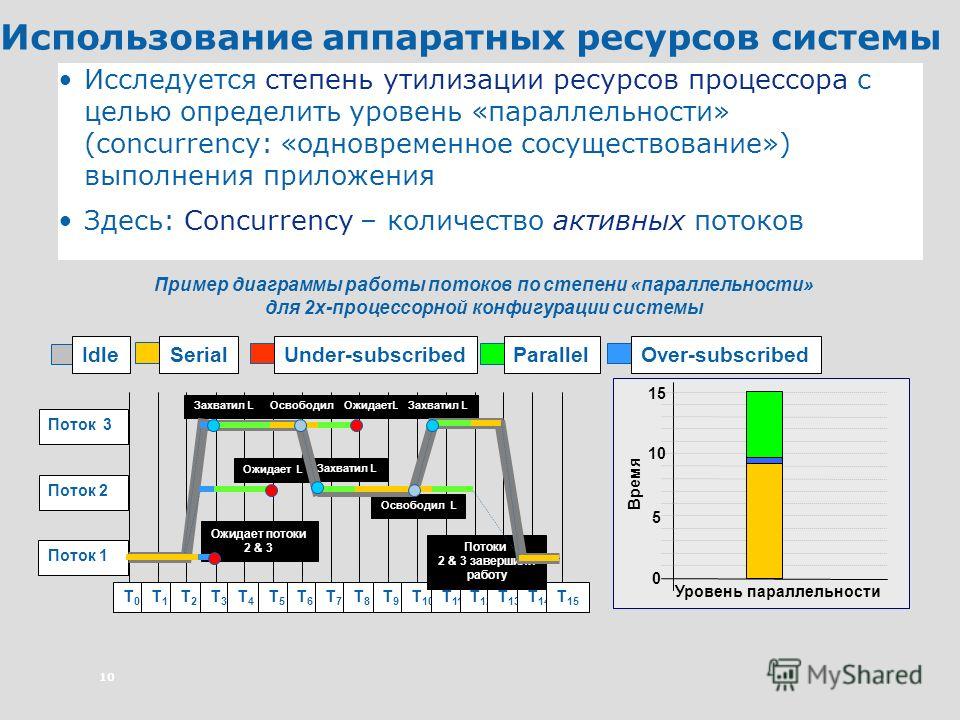

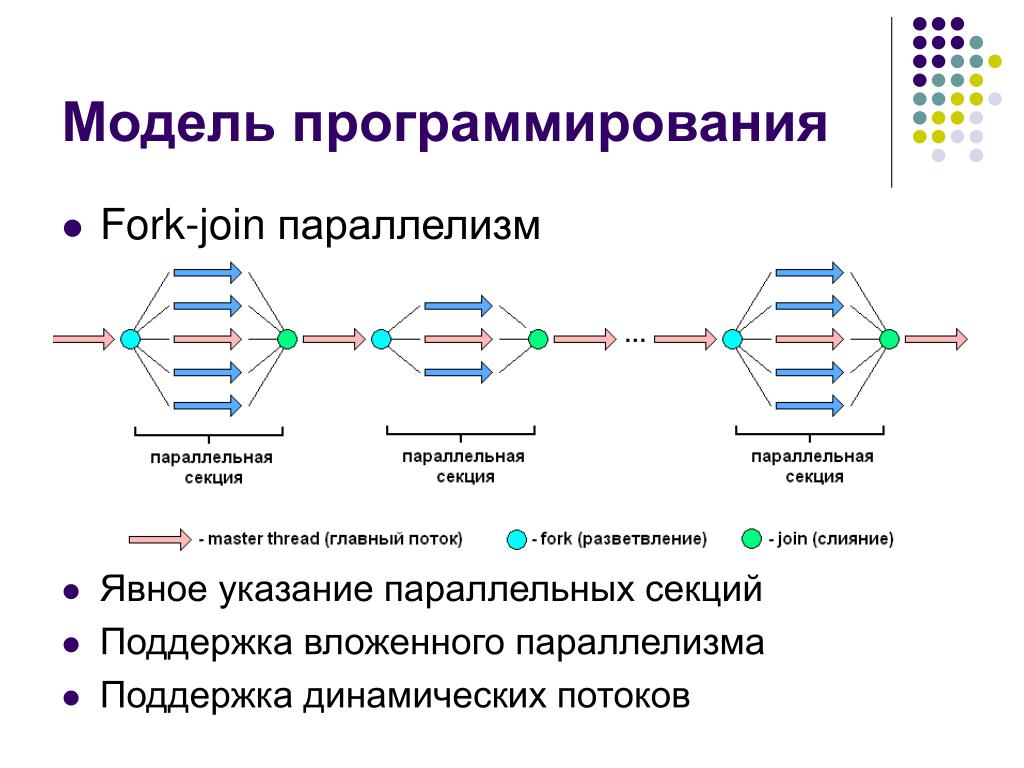

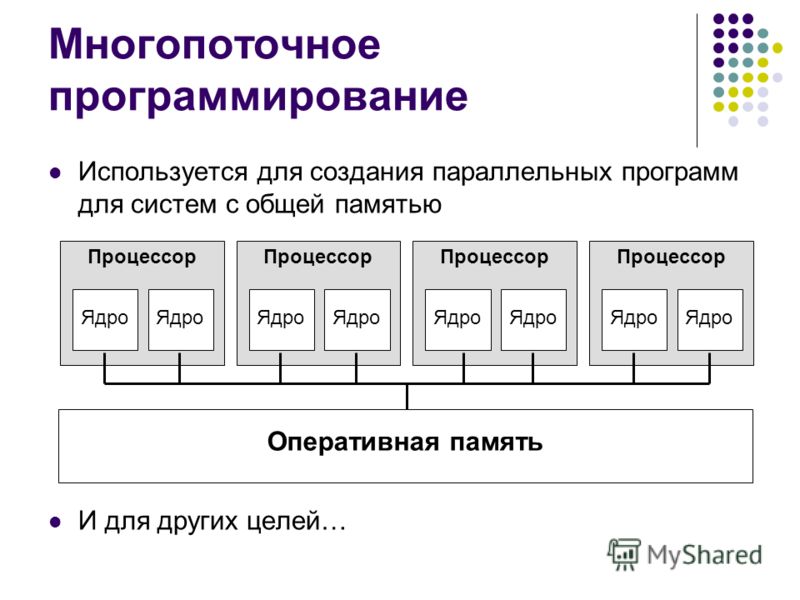

Параллелизм – это физически одновременное выполнение для достижения наибольшей производительности(например, между двумя ядрами).

Одновременность – логическое и/или физическое одновременное выполнение (есть один ЦП, на нем одновременно выполняется несколько программ – многозадачная ОС).

Потоки нужны для того и другого понятия для эффективного использования. В самом простом варианте, чтобы достичь параллелизма – использование множества процессов – программы изолированы друг от друга в разных процессах, поэтому параллелизм есть.

Потоки – другой способ достичь параллелизма. Потоки работают внутри одного процесса. Все потоки процесса имеют одно адресное пространство и те же ресурсы ОС. У потоков есть свой стек и свое состояние ЦП.

Параллелизм (примеры)

Примеры:

Веб-сервер, который для каждого пользовательского процесса создает новый процесс, т.е. должен обслуживать несколько запросов параллельно.

Ожидая данных по запросу клиента из БД сервер в это же время мог бы загрузить данные с диска для другого клиента и обработать запрос третьего клиента.

Веб-браузер – в момент обращения к веб- странице, он мог бы параллельно загружать данные из различных источников.

Некоторая вычислительная программа использующая физический параллелизм – например, когда нужно обработать большой массив данных.

В каждом из этих примеров параллелизма есть общее:

- Один код

- Доступ к одним данным

- Один уровень доступа

- Одно множество ресурсов.

разное:

- Стэк и указатель стэка (регистр SP)

- Счетчик инструкций (регистр IP), указывающий на следующую инструкцию

- Множество регистров ЦП

Процессы и потоки

Большинство современных ОС поддерживает два объекта:

- Процесс, который определяет адресное пространство и общие атрибуты процесса.

- Поток, который определяет последовательный поток выполнения в рамках процесса.

Поток привязывается к одному процессу и одному адресному пространству.

- Но может быть много потоков в одном адресном пространстве

- Обеспечивают легкий доступ к общим данным

- Создание потоков занимает очень мало времени

ПОТОКИ стали единицей планирования

Процессы – всего лишь контейнер, в котором выполняются потоки.

Процесс – это непосредственно контейнер, а поток – это нити выполнения, которые у него есть внутри.

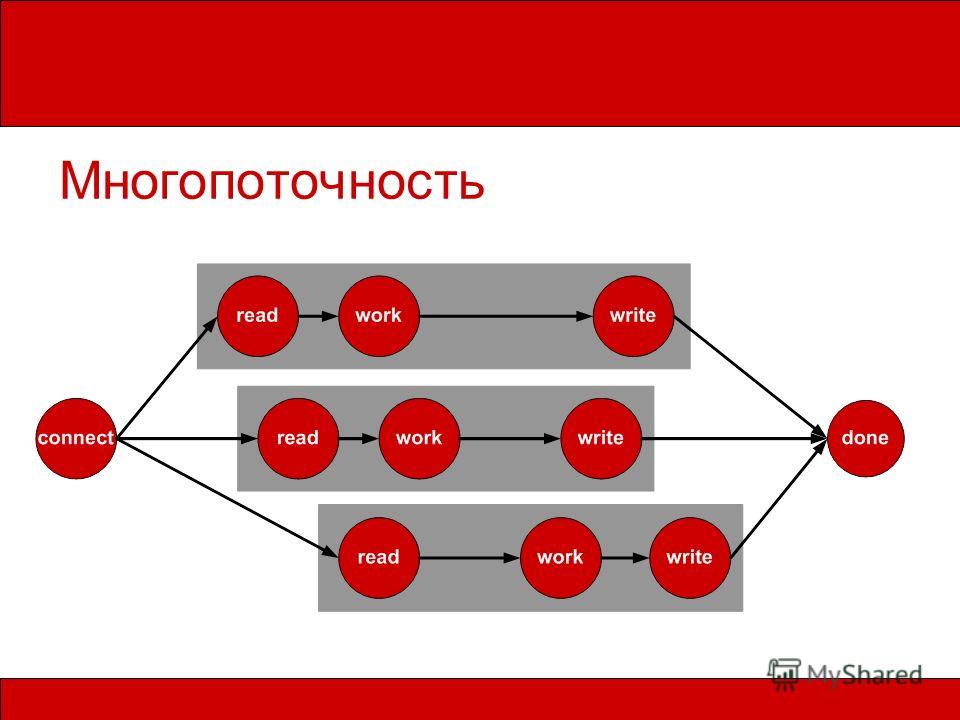

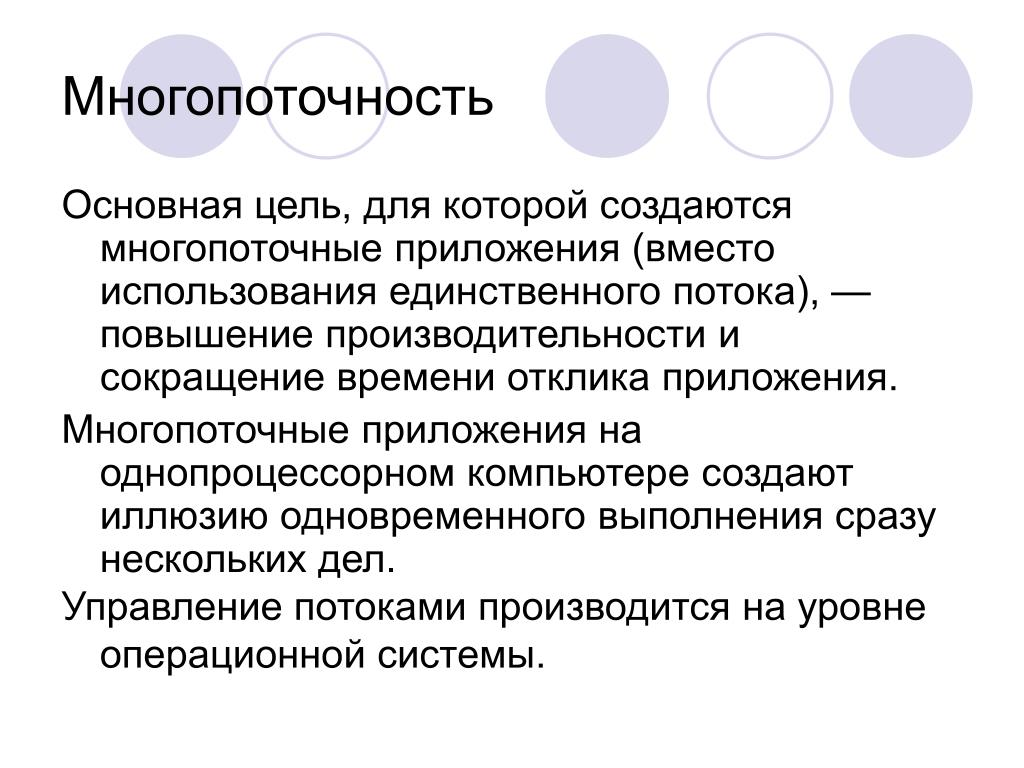

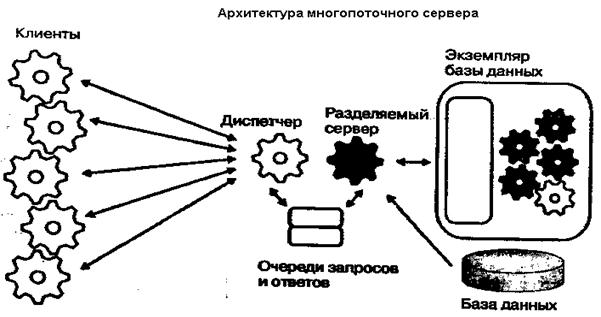

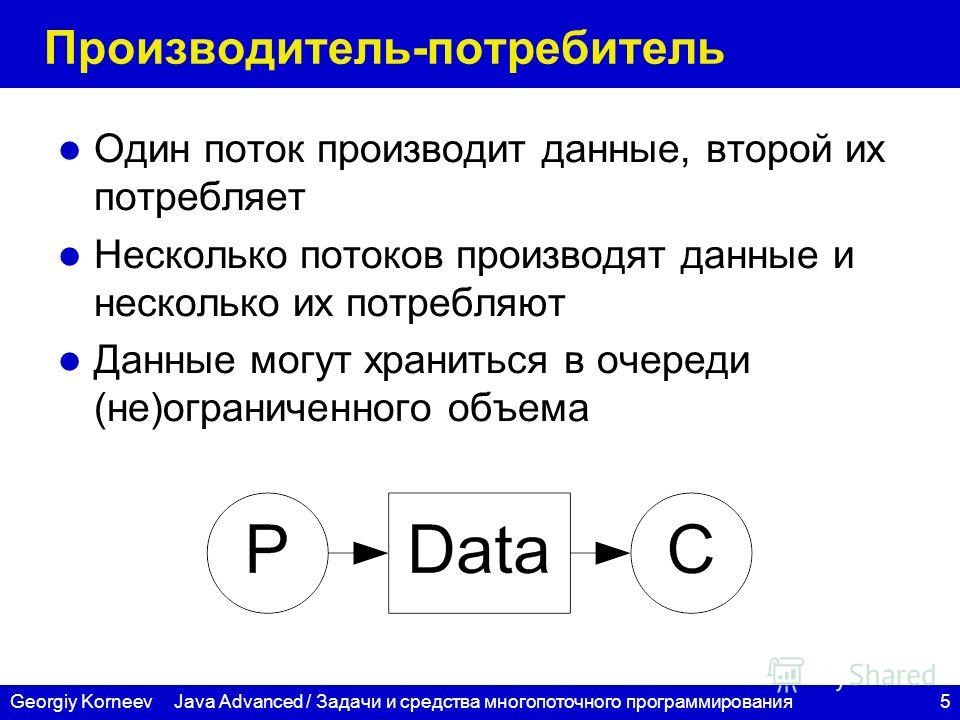

Многопоточность

Многопоточность полезна для :

- обработки одновременных событий

- построение параллельных программ.

Поддержка многопоточности – разделение понятие процесса от минимального потока управления.

- Для параллельного потока выполнения не нужно создавать новые процессы.

- Работает быстрее, меньше требования к памяти.

Раньше: «Процесс»= адресное пространство + ресурсы ОС+ подразумевался единственный поток

Раньше: «Процесс»= адресное пространство + ресурсы ОС+ все потоки принадлежат процессу

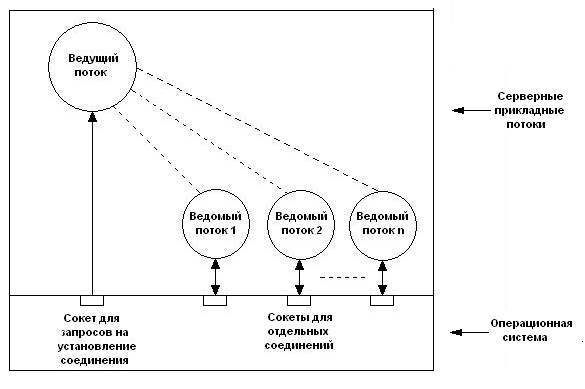

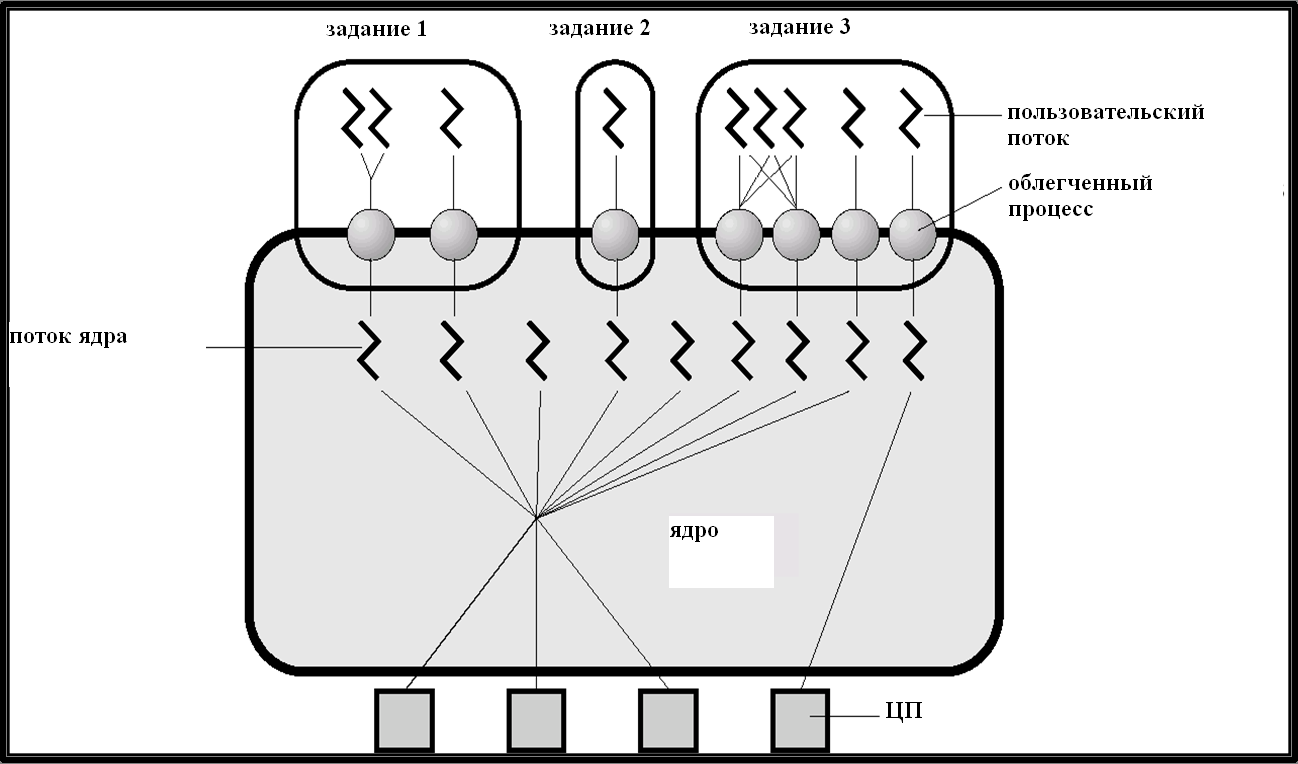

Какие бывают потоки?

Виды потоков

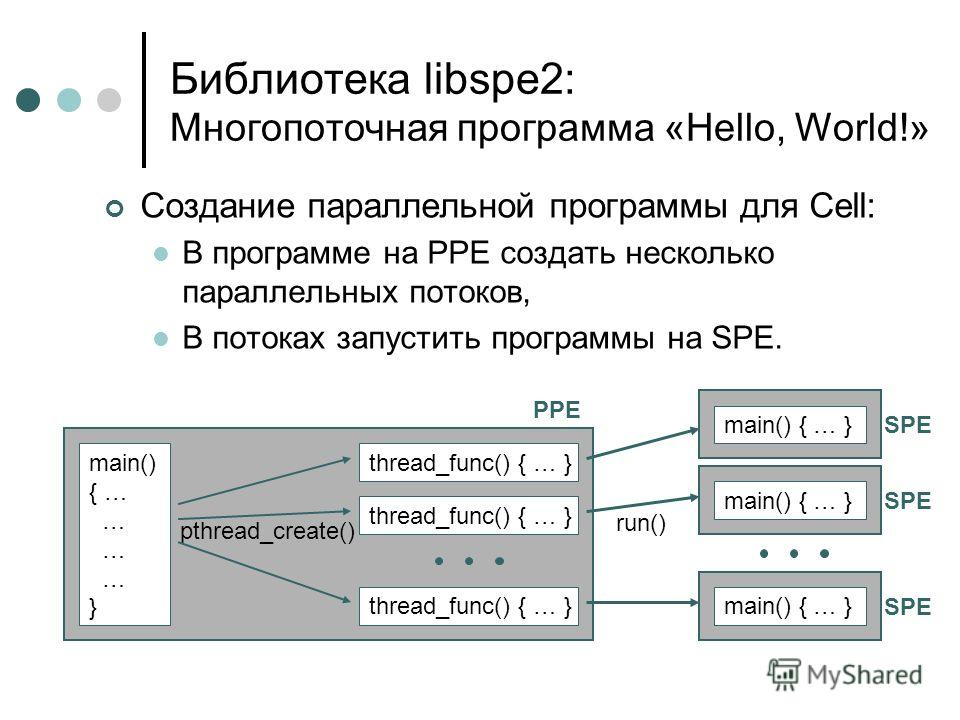

Потоки делают двумя способами:

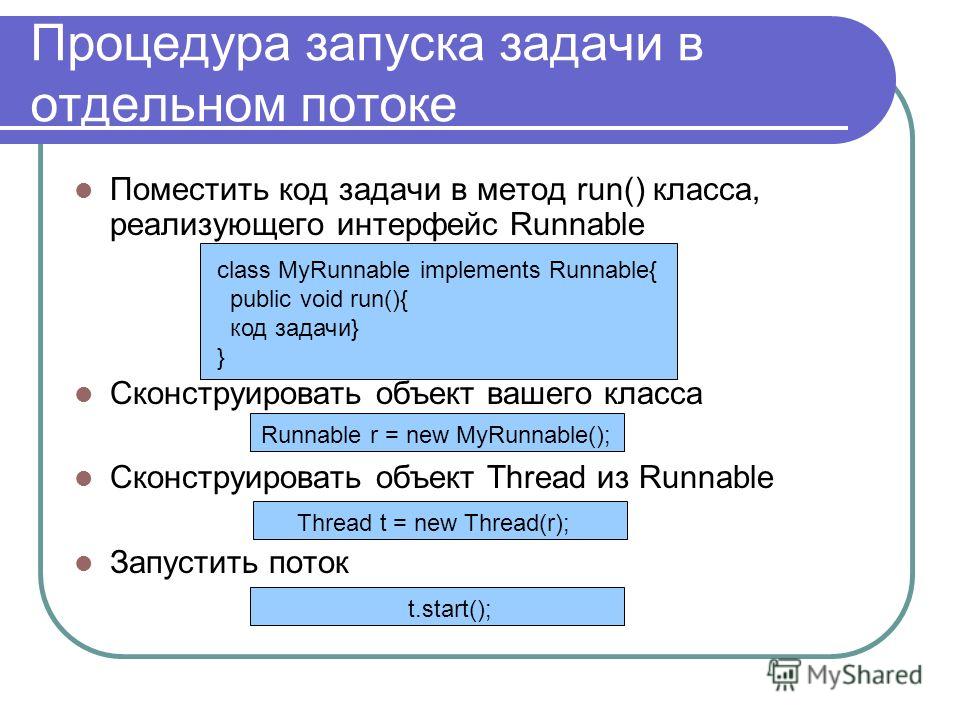

1)На уровне ядра — есть функции ядра для создания нового потока.

— выделяется стек выполнения на внутри адресного пространства процесса;

— создает и инициализирует Thread Control Block (блок упр.процессом).

Потоки ядра

2)На уровне пользователя

потоки уровня пользователя

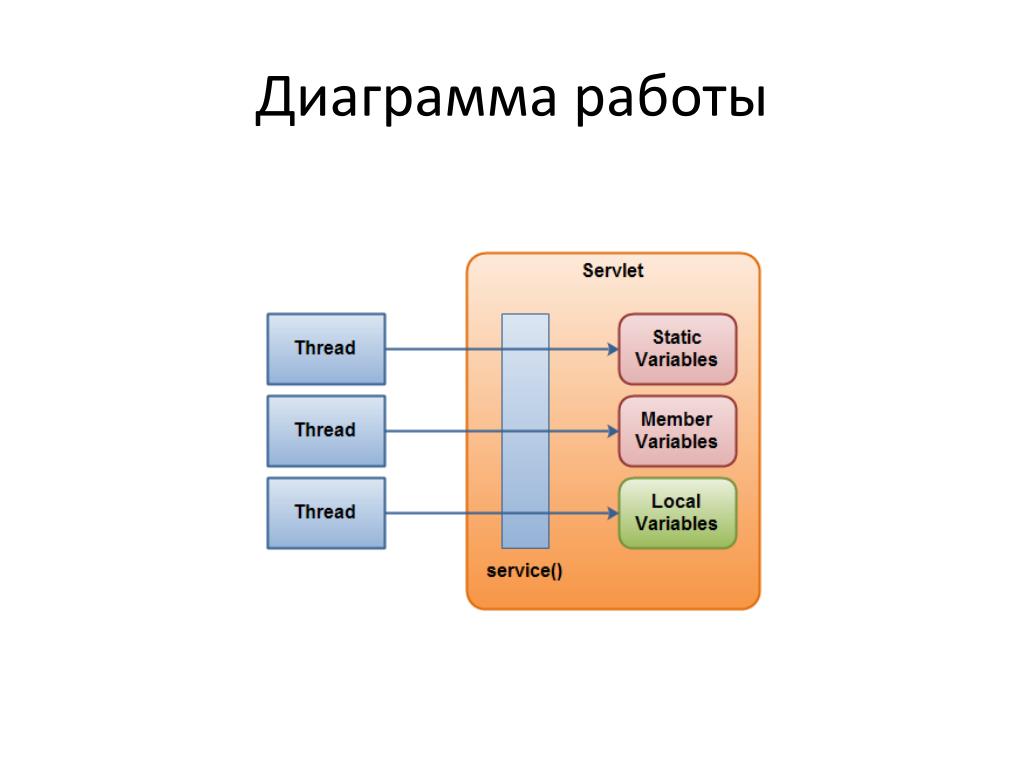

На рисунке три потока. Есть специальная библиотека Pthreads, которая управляет потоками вне ядра самостоятельно.

В обеих вариантах есть плюсы и минусы

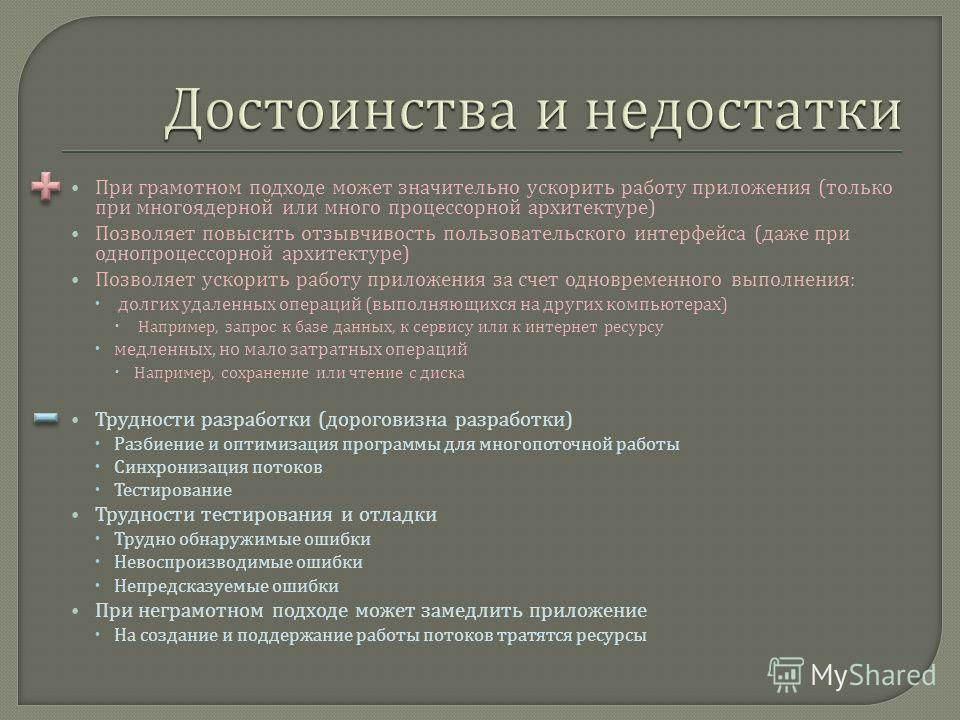

Первый вариант минус — нужен системный вызов при создании потока, а это время процессора. На уровне пользователя системного вызова не нужно, все управляется специальной библиотекой.

На уровне пользователя системного вызова не нужно, все управляется специальной библиотекой.

Библиотека Pthreads (положительное):

Каждый поток представляется регистрами ЦП, стеком и небольшим блоком TCB

Создание потока, переключение между потоками и синхронизация потоков выполняется без участия ядра

Потоки уровня пользователя могут быть в 10-100 раз быстрее, чем потоки режима ядра

- Множество потоков в одном адресном пространстве это хорошо;

- Потоки режима ядра намного эффективнее процессов, но есть потери на системные вызовы;

- Потоки режима пользователя имеют преимущества и недостатки:

— высокая скорость и «дешевизна» создания;

— могут быть проблемы с вводом/выводом и блокировками, из-за того, что ядро не знает об этих потоках.

Поэтому пользовательские потоки не обрели большой популярности.

Возможно решить эти проблемы на уровне планировщика.

В ОС Windows NT потоки реализованы на уровне ядра, что позволяет более тонко регулировать события.

Ввели fiber – вытесняющую многозадачность.

Отличие потоков от процессов

Потоки выполнения отличаются от традиционных процессов многозадачной операционной системы тем, что:

- процессы, как правило, независимы, тогда как потоки выполнения существуют как составные элементы процессов;

- процессы несут значительно больше информации о состоянии, тогда как несколько потоков выполнения внутри процесса совместно используют информацию о состоянии, а также память и другие вычислительные ресурсы;

- процессы имеют отдельные адресные пространства, тогда как потоки выполнения совместно используют их адресное пространство;

- процессы взаимодействуют только через предоставляемые системой механизмы связей между процессами;

- переключение контекста между потоками выполнения в одном процессе, как правило, быстрее, чем переключение контекста между процессами.

Такие системы, как Windows NT и OS/2, как говорят, имеют «дешёвые» потоки выполнения и «дорогие» процессы. В других операционных системах разница между потоками выполнения и процессами не так велика, за исключением расходов на переключение адресного пространства.

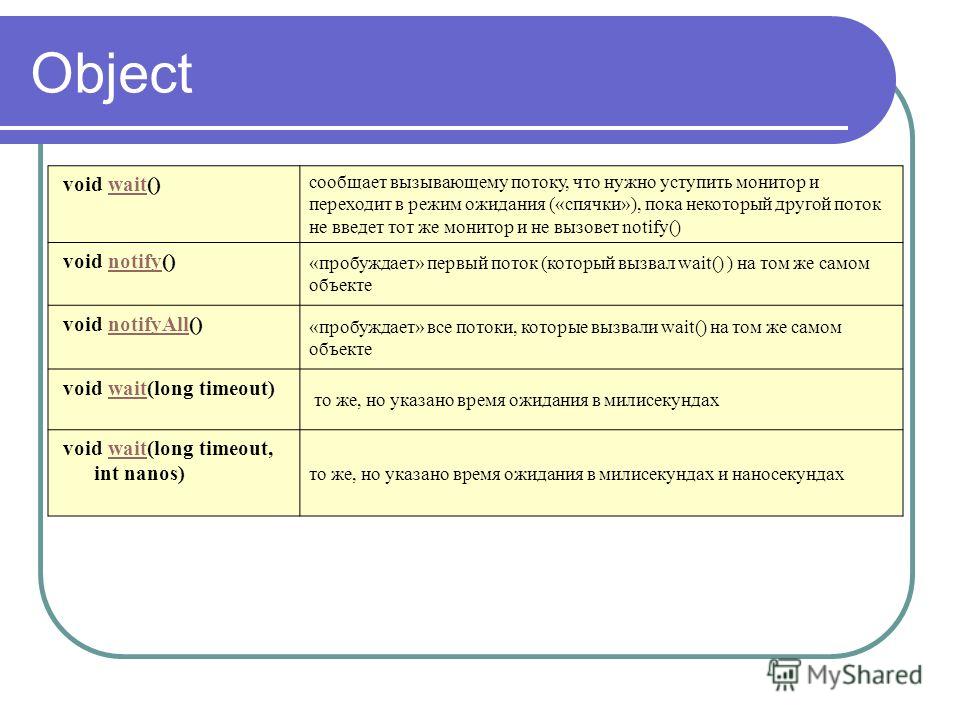

Следующая важная тема в теории операционных систем «Синхронизация».

Скачать презентацию к лекции «Процессы и потоки»

Скачать тест по теме «Процессы и потоки»

Понравилась статья, рекомендуйте Вашим друзьям!

Давайте дружить!

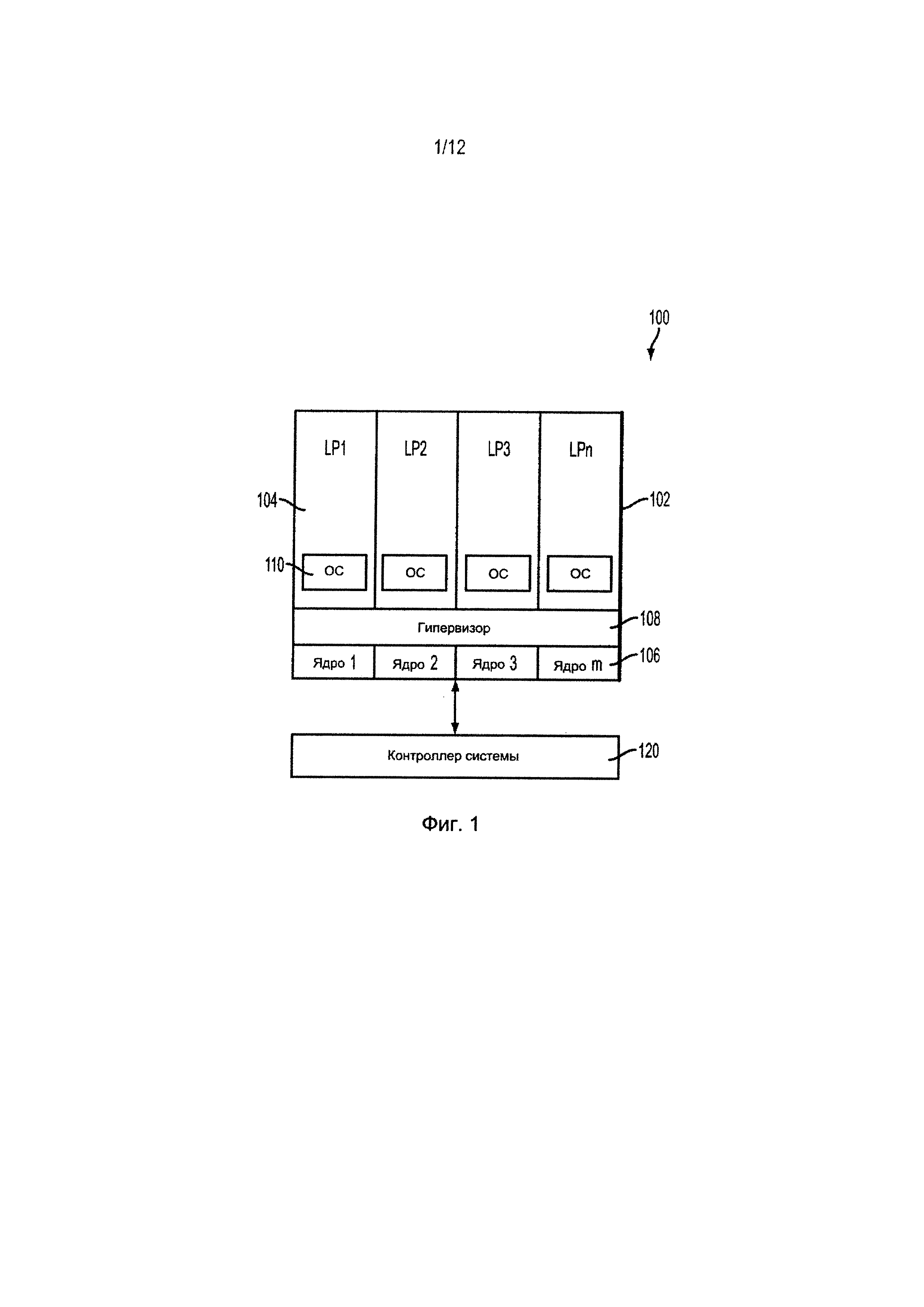

Многопоточная модель в Linux и Windows

За последние несколько месяцев я прошел курс по операционным системам. Однако я хотел бы получить некоторые разъяснения по одному вопросу, который я прочитал. Насколько я понимаю, существует три типа многопоточных моделей для сопоставления потоков пользовательского уровня с потоками уровня kernel —

- Многие к одной модели

- Многие ко многим моделям

- Модель один к одному

Я могу понять, почему модель «многие к одному» не очень эффективна, когда дело доходит до параллельной обработки — потому что блокирующий системный вызов означал бы остановку любой обработки.

Однако в книге, которую я имею в виду, концепции операционной системы (Абрахам Зильбершатц, Грег Ганье и Питер Гэлвин), говорится, что и Linux, и семейство Windows используют модель «один к одному», хотя существуют дополнительные накладные расходы на создание потока kernel для каждого созданного пользовательского потока.

Не будет ли лучше модель «многие ко многим»? Поскольку у вас есть несколько потоков kernel, достаточных для высокой степени параллелизма, и вы всегда можете выбрать двухуровневую модель для привязки потока пользовательского уровня к потоку уровня kernel.

TLDR: почему модель многопоточности «один к одному» предпочтительнее модели «многие ко многим», несмотря на накладные расходы в системах Windows и Linux?

linux

windows

multithreading

operating-system

Поделиться

Источник

Zeokav

20 ноября 2016 в 17:41

2 ответа

- Cassandra: совместимы ли Linux и Windows?

В данный момент я использую базу данных Cassandra в системе Windows 7.

Теперь мы хотели бы использовать Cassandra на Linux и задаться вопросом, Можно ли перенести данные с помощью простой копии каталога данных с Windows на Linux? Может ли кто-нибудь сказать мне, возможно ли это, то есть совместима…

Теперь мы хотели бы использовать Cassandra на Linux и задаться вопросом, Можно ли перенести данные с помощью простой копии каталога данных с Windows на Linux? Может ли кто-нибудь сказать мне, возможно ли это, то есть совместима… - Родной windows Linux

Я знаю о нескольких проектах для кросс-компиляции между linux и Windows. Проект Wine отлично подходит для запуска приложения windows внутри Linux. andLinux — это linux, работающий внутри Windows. Мой вопрос заключается в том, можем ли мы скомпилировать полный linux OS с компилятором Windows…

3

Разве не лучше было бы иметь модель «многие ко многим»?

Я бы посоветовал взять другую книгу. AFAIK модель Many-to-Many полностью теоретическая (если кто-то знает о системе, которая ее использует, пожалуйста, укажите в комментарии). Эти модели — очень плохой способ объяснения потоков.

В старые добрые времена операционная система не имела понятия о потоках. Они планировали процессы для выполнения. На самом деле, это все еще имеет место для многих операционных систем.

Потребность в потоках была в значительной степени обусловлена языком программирования Ada, который требовал поддержки «task». Чтобы иметь совместимую реализацию Ada, должна была существовать библиотека, имитирующая потоки внутри одного процесса. В такой системе процесс планирует выполнение собственного потока («пользовательские потоки»). Это имеет тот недостаток, что потоки всегда выполняются чередующимися (никогда параллельно на разных процессорах).

Это называется «many to one», но это плохое описание того, что происходит. Ваша модель вызывает, что «many user threads» сопоставляется с одним «kernel thread.» в действительности нет потоков kernel. Вместо этого потоки реализуются в контексте процесса.

Операционные системы стали рассматривать процессы как адресное пространство с несколькими планируемыми потоками выполнения. в такой системе поток является основной единицей планирования, а не процесс. Is — это модель one-to-one в вашей схеме.

в такой системе поток является основной единицей планирования, а не процесс. Is — это модель one-to-one в вашей схеме.

в нем говорится, что и Linux, и семейство Windows используют модель «один к одному», хотя существуют дополнительные накладные расходы на создание потока kernel для каждого созданного пользовательского потока.

Это своего рода BS.There накладных расходов для потока, независимо от того, как они реализованы. Вы часто найдете людей, утверждающих, что «Many-to-One» более эффективен, чем «One-to-One».» Это утверждение кажется просто городской легендой.

Почему модель многопоточности «один к одному» предпочтительнее модели «многие ко многим», несмотря на накладные расходы в системах Windows и Linux?

Модель» one-to-one » (она же kernel поток) предпочтительнее, поскольку она использует преимущества нескольких процессоров и позволяет выполнять фактическое выполнение параллельно. Это также позволяет избежать проблем блокировки, которые могут возникнуть в некоторых системах (например, евнухи).

Поделиться

user3344003

21 ноября 2016 в 04:14

0

AFAIK, модель «many to many» подразумевает выполнение планирования в пользовательском пространстве, поэтому это означает, что каждая программа должна иметь свой собственный планировщик, работающий в каждом потоке kernel, используя его для совместного использования этого потока между назначенными ей пользовательскими потоками. Другими словами: вам нужно что-то вроде переносимых потоков GNU, работающих в каждом потоке kernel, чтобы отправить пользовательские потоки, назначенные этому потоку kernel ( https:/ / www.gnu.org / software/pth/ ).

Поделиться

Rastersoft

20 ноября 2016 в 20:58

Похожие вопросы:

Zend Framework имена файлов классов в windows против linux

Предыстория: мы часто работаем над веб-приложениями, которые разрабатываются в PHP (Zend Framework) и размещаются на сервере linux. Команда программирования может состоять из отдельных лиц, которые…

Команда программирования может состоять из отдельных лиц, которые…

Кросс-компиляция на Windows и Linux

Я разрабатываю приложение, которое должно будет работать как на Windows, так и на Linux. До сих пор он работал на Linux, используя GCC 4.4.1, используя мой Makefile. Однако мне также нужно…

C++ переносимость между Windows и Linux

У меня есть вопрос о написании программ для переносимости между windows и linux. Недавно я понял, что если вы пишете программу, которая использует какую-либо внешнюю библиотеку, если эта библиотека…

Cassandra: совместимы ли Linux и Windows?

В данный момент я использую базу данных Cassandra в системе Windows 7. Теперь мы хотели бы использовать Cassandra на Linux и задаться вопросом, Можно ли перенести данные с помощью простой копии…

Родной windows Linux

Я знаю о нескольких проектах для кросс-компиляции между linux и Windows. Проект Wine отлично подходит для запуска приложения windows внутри Linux. andLinux — это linux, работающий внутри Windows….

многопоточная программа в однопроцессорной системе

У меня есть резьбовой вопрос. Допустим, у меня есть одноядерный процессор, однопоточная программа и одна и та же многопоточная программа. Могу ли я с уверенностью предположить, что в…

Почему современные OSses (Linux, Windows, Solaris) реализуют модель одного потока?

Читая учебник для моего класса OS, который называется концепции операционных систем, 8-е издание , Зильбершатц, Галвин и Ганье, я наткнулся на кое-что интересное в главе о потоках. При введении…

«Linux aio» и «Linux native aio» — это одно и то же?

Недавно я копаюсь в модели linux io и часто слышу, что, как и windows IOCP, linux имеет свою собственную реализацию модели aio: Glibc aio и kernel aio. Вопрос: (1) когда люди говорят linux native…

Python Keras — совместимость между Windows и Linux

Я обучил и сохранил модель Keras в Windows 10, Python 3. 5, Keras 2.0.6. В Windows я могу загрузить модель и повторно использовать ее. Но когда я пытаюсь загрузить модель в Linux (Ubuntu), Keras…

5, Keras 2.0.6. В Windows я могу загрузить модель и повторно использовать ее. Но когда я пытаюсь загрузить модель в Linux (Ubuntu), Keras…

Windows и Linux контейнеров одновременно Windows 10

У меня есть решение, которое включает в себя около 5 контейнеров. Большинство из них основаны на alpine linux, но один из них должен быть контейнером windows. К сожалению, контейнер windows…

Linux: процессы и потоки в многоядерном CPU

Правда ли, что потоки, по сравнению с процессами, с меньшей вероятностью выиграют от многоядерного процессора? Другими словами, Будет ли kernel принимать решение о выполнении потоков на одном ядре, а не на нескольких ядрах?

Я говорю о потоках, принадлежащих одному и тому же процессу.

linux

multithreading

process

Поделиться

Источник

someguy

03 августа 2010 в 10:22

6 ответов

- Как я могу динамически распределять ресурсы CPU для процессов в Linux?

В Linux (наша система-CentOS5) возможно ли распределение CPU ресурсов на процессы? Например, у меня есть одно приложение tomcat, я хочу, чтобы все процессы и потоки, вызываемые tomcat, имели p% из общего числа CPU циклов независимо от того, сколько других приложений запущено. И я хочу настроить p%…

- Процессы, потоки и параллельное программирование

Мне нужна помощь, чтобы понять основы параллельного программирования. На самом деле, чем больше я читаю, тем больше запутываюсь. Итак, я понял, что процесс-это экземпляр программы, которая выполняется последовательно и может состоять из одного или нескольких потоков. В одноядерном CPU одновременно…

9

Я не знаю, как (различные) планировщики Linux справляются с этим, но межпоточная связь становится более дорогой, когда потоки работают на разных ядрах.

Таким образом, планировщик может решить запустить потоки процесса на том же CPU, если есть другие процессы, нуждающиеся в CPU времени .

Например, с двухъядерным процессором CPU, если есть два процесса с двумя потоками и все они используют все CPU время, которое они получают, лучше запустить два потока первого процесса на первом ядре и два потока другого процесса на втором ядре.

Поделиться

IanH

03 августа 2010 в 10:45

2

Несколько однопоточных процессов обходятся системе дороже, чем один многопоточный. Но они выиграют от многоядерного CPU с той же эффективностью. Кроме того, межпоточная связь намного дешевле, чем межпроцессная. Если эти потоки действительно образуют единое приложение, Я голосую за многопоточность.

Поделиться

Andrey

03 августа 2010 в 10:27

2

Это для меня новость. Linux в частности, делает мало различий между потоками и процессами. На самом деле это просто процессы, которые разделяют свое адресное пространство.

Поделиться

Marcelo Cantos

03 августа 2010 в 10:28

- Почему процессы лишены CPU на TOO долгое время, пока заняты циклом в Linux kernel?

На первый взгляд мой вопрос может показаться немного тривиальным. Пожалуйста, потерпите меня и прочитайте полностью. Я определил занятый цикл в моем модуле Linux kernel. Из-за этого другие процессы (например, sshd) не получают CPU времени в течение длительных промежутков времени (например, 20…

- Linux потоки и процесс — CPU сродство

У меня есть несколько запросов, связанных с потоками и планированием процессов. Когда мой процесс переходит в спящий режим и просыпается обратно, всегда ли он будет запланирован на тот же CPU, что и раньше? Когда я создаю поток из процесса, будет ли он также выполняться на одном и том же CPU.

..

..

2

Многопоточность с общей памятью накладывает огромные затраты на все — от цепочки инструментов до разработки, отладки, рассуждений и тестирования кода. NEVER используйте многопоточность с общей памятью там, где вы можете разумно использовать многопроцессорную конструкцию.

@Marcelo прав, любой приличный OS будет относиться к потокам и процессам очень похоже, некоторое cpu-сродство к потокам может уменьшить использование многопроцессорного многопоточного процесса, но вы должны видеть, что с любыми двумя процессами, которые разделяют общий сегмент .text, также.

Выберите потоки против процессов, основанных на сложности и ограничениях архитектурного дизайна, скорость почти никогда не будет иметь значения.

Поделиться

Recurse

03 августа 2010 в 11:22

1

На самом деле все зависит от планировщика, типа многопроцессорной обработки и текущей рабочей среды.

Ничего не предполагай, проверяй, проверяй, проверяй!

Если вы единственный многопоточный процесс в системе, многопоточность, как правило, хорошая идея.

Однако с точки зрения простоты разработки иногда требуется отдельное адресное пространство и общие данные, особенно в системах NUMA.

Одно можно сказать наверняка: если это система ‘HyperThreaded’, то потоки гораздо эффективнее благодаря тесному совместному использованию памяти.

Если это обычная многоядерная обработка.. это должно быть похоже.

Если это система NUMA, вам лучше держать общие данные и код отдельно. Опять же, все это зависит от архитектуры, и это не имеет значения с точки зрения производительности, если вы не занимаетесь бизнесом HPC.

Если вы занимаетесь HPC (суперкомпьютерным) бизнесом, TEST!. Все это зависит от машины (а преимущества в среднем составляют 10-25%, это имеет значение, если вы говорите о днях разницы)

Поделиться

qdot

03 августа 2010 в 12:43

-2

В то время как Windows использует волокна и нити, я иногда думаю, что Linux использует процессы и шпагат.

Я обнаружил, что при написании многопоточных процессов вы действительно должны быть строгими, педантичными, дисциплинированными и кровожадными в разработке многопоточных процессов, чтобы они могли достичь баланса преимуществ при использовании любого количества ядер, доступных на машине, на которой должен выполняться процесс.

Правда ли, на Linux, что потоки, по сравнению с процессами, с меньшей вероятностью выиграют от многоядерного процессора? Никто не знает.

Поделиться

Sam

03 августа 2010 в 11:04

Похожие вопросы:

Потоки против процессов в Linux

Недавно я слышал, как несколько человек говорили, что в Linux почти всегда лучше использовать процессы вместо потоков, поскольку Linux очень эффективен в обработке процессов и потому что существует…

cpu масштабирование частоты linux API в C

Я хочу изменить частоту cpu(ARM) в моей программе на linux(Ubuntu). Есть ли какое-либо масштабирование частоты cpu и отключение ядра API в C? Если таковые имеются, то API может обрабатывать каждое…

отчет об использовании памяти и cpu — matlab — на многоядерном сервере linux

нам нужно было бы знать, сколько памяти и cpu времени использовал процесс matlab со всеми своими порожденными потоками. Если я правильно понимаю, все потоки будут появляться как новые процессы с…

Как я могу динамически распределять ресурсы CPU для процессов в Linux?

В Linux (наша система-CentOS5) возможно ли распределение CPU ресурсов на процессы? Например, у меня есть одно приложение tomcat, я хочу, чтобы все процессы и потоки, вызываемые tomcat, имели p% из…

Процессы, потоки и параллельное программирование

Мне нужна помощь, чтобы понять основы параллельного программирования. На самом деле, чем больше я читаю, тем больше запутываюсь. Итак, я понял, что процесс-это экземпляр программы, которая. ..

..

Почему процессы лишены CPU на TOO долгое время, пока заняты циклом в Linux kernel?

На первый взгляд мой вопрос может показаться немного тривиальным. Пожалуйста, потерпите меня и прочитайте полностью. Я определил занятый цикл в моем модуле Linux kernel. Из-за этого другие процессы…

Linux потоки и процесс — CPU сродство

У меня есть несколько запросов, связанных с потоками и планированием процессов. Когда мой процесс переходит в спящий режим и просыпается обратно, всегда ли он будет запланирован на тот же CPU, что и…

CPU планирование и kernel-уровневые потоки

В моем учебнике упоминается следующее предложение: В операционных системах, которые их поддерживают, именно потоки уровня kernel, а не процессы, планируются операционной системой. Я понимаю CPU…

Означают ли процессы и потоки в программных библиотеках или модулях процессы, потоки уровня kernel или потоки уровня пользователя?

Я начинаю задаваться вопросом о разнице между процессами, потоками уровня kernel и потоками уровня пользователя. Означает ли процесс и потоки в Linux API процессы, потоки уровня kernel или потоки…

Как Python процессы и потоки сопоставляются с аппаратными потоками?

Мой вопрос похож на этот , но я ищу информацию up-to-date о том, как это работает с: Python Работает на Linux на CPU, который имеет больше потоков, чем ядер. Предположим, что CPU с 4 ядрами и 8…

Python: как сделать многопоточную программу

Когда-то давно мы делали простой таймер с напоминанием на Python. Он работал так:

- Мы спрашивали пользователя, о чём ему напомнить и через сколько минут.

- Программа на это время засыпала и ничего не делала.

- Как только время сна заканчивалось, программа просыпалась и выводила напоминание.

У такой схемы есть минус: мы не можем пользоваться программой и выделенными на неё ресурсами до тех пор, пока она не проснётся. Процессор по кругу гоняет пустые команды и ждёт, когда можно будет продолжить полезную работу. Чтобы процессор и программа могли во время работы таймера делать что-то ещё, используют потоки.

Процессор по кругу гоняет пустые команды и ждёт, когда можно будет продолжить полезную работу. Чтобы процессор и программа могли во время работы таймера делать что-то ещё, используют потоки.

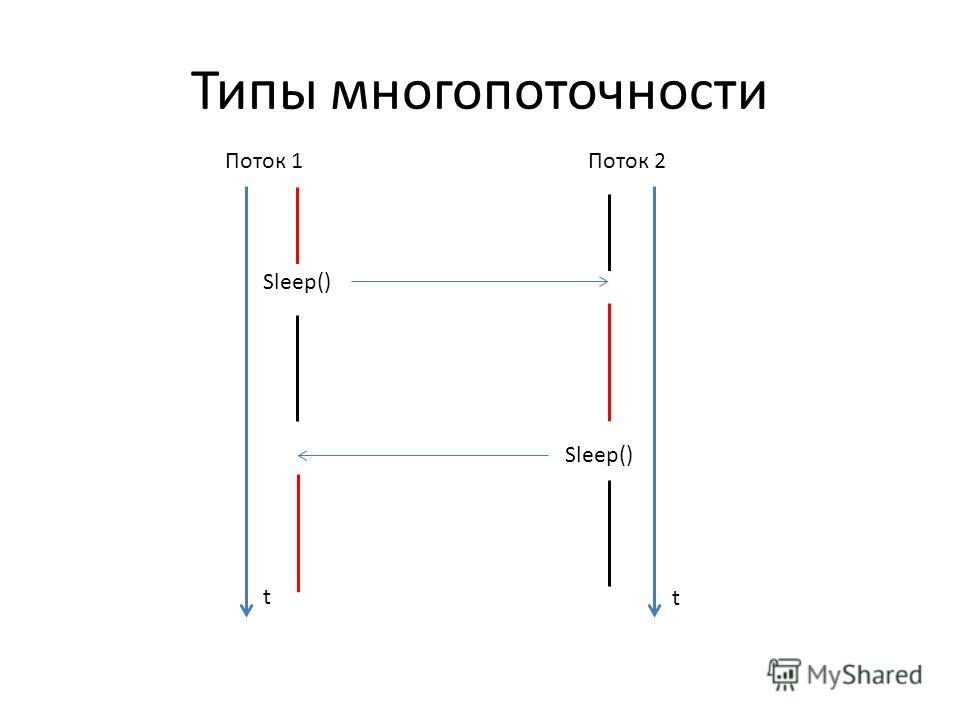

Что такое поток

В упрощённом виде потоки — это параллельно выполняемые задачи. По умолчанию используется один поток — это значит, что программа делает всё по очереди, линейно, без возможности делать несколько дел одновременно.

Но если мы сделаем в программе два потока задач, то они будут работать параллельно и независимо друг от друга. Одному потоку не нужно будет становиться на паузу, когда в другом что-то происходит.

👉 Важно понимать, что поток — это высокоуровневое понятие из области программирования. На уровне вашего «железа» эти потоки всё ещё могут обсчитываться последовательно. Но благодаря тому, что они будут обсчитываться быстро, вам может показаться, что они работают параллельно.

Многопоточность

Представим такую ситуацию:

- У вас на руке смарт-часы, которые собирают данные о вашем пульсе, УФ-излучении и движениях. На смарт-часах работает программа, которая обрабатывает эти данные.

- Программа состоит из четырёх функций. Первая собирает данные с датчиков. Три другие обрабатывают эти данные и делают выводы.

- Пока первая функция не собрала нужные данные, ничего другого не происходит.

- Как только данные введены, запускаются три оставшиеся функции. Они не зависят друг от друга и каждая считает своё.

- Как только все три функции закончат работу, программа выдаёт нужный результат.

А теперь давайте посмотрим, как это выглядит в однопоточной и многопоточной системе. Видно, что если процессор позволяет делать несколько дел одновременно, в многопоточном режиме программа будет работать быстрее:

Многопоточность на Python

За потоки в Python отвечает модуль threading, а сам поток можно создать с помощью класса Thread из этого модуля. Подключается он так:

Подключается он так:

from threading import Thread

После этого с помощью функции Thread() мы сможем создать столько потоков, сколько нам нужно. Логика работы такая:

- Подключаем нужный модуль и класс Thread.

- Пишем функции, которые нам нужно выполнять в потоках.

- Создаём новую переменную — поток, и передаём в неё название функции и её аргументы. Один поток = одна функция на входе.

- Делаем так столько потоков, сколько требует логика программы.

- Потоки сами следят за тем, закончилась в них функция или нет. Пока работает функция — работает и поток.

- Всё это работает параллельно и (в теории) не мешает друг другу.

Для иллюстрации запустим такой код:

import time

from threading import Thread

def sleepMe(i):

print("Поток %i засыпает на 5 секунд.\n" % i)

time.sleep(5)

print("Поток %i сейчас проснулся.\n" % i)

for i in range(10):

th = Thread(target=sleepMe, args=(i, ))

th.start()А вот как выглядит результат. Обратите внимание — потоки просыпаются не в той последовательности, как мы их запустили, а в той, в какой их выполнил процессор. Иногда это может помешать работе программы, но про это мы поговорим отдельно в другой статье.

Добавляем потоки в таймер

Первое, что нам нужно сделать, — вынести код таймера-напоминания в отдельную функцию, чтобы создать с ней поток. Для этого используем команду def:

# Делаем отдельную функцию с напоминанием

def remind():

# Спрашиваем текст напоминания, который нужно потом показать пользователю

print("О чём вам напомнить?")

# Ждём ответа пользователя и результат помещаем в строковую переменную text

text = str(input())

# Спрашиваем про время

print("Через сколько минут?")

# Тут будем хранить время, через которое нужно показать напоминание

local_time = float(input())

# Переводим минуты в секунды

local_time = local_time * 60

# Ждём нужное количество секунд, программа в это время ничего не делает

time. sleep(local_time)

# Показываем текст напоминания

print(text)

sleep(local_time)

# Показываем текст напоминания

print(text)Теперь сделаем новый поток, в который отправим выполняться нашу новую функцию. Так как аргументов у нас нет, то и аргументы передавать не будем, а напишем args=().

# Создаём новый поток

th = Thread(target=remind, args=())

# И запускаем его

th.start()

Нам осталось убедиться в том, что пока поток работает, мы можем выполнять в программе что-то ещё и наше засыпание в потоке на это не повлияет. Для этого мы через 20 секунд после запуска выведем сообщение на экран. За 20 секунд пользователь успеет ввести напоминание и время, после чего таймер уйдёт в новый поток и там уснёт на нужное количество минут. Но это не помешает работе основной программы — она тоже будет выполнять свои команды параллельно с потоком.

# Пока работает поток, выведем что-то на экран через 20 секунд после запуска

time.sleep(20)

print(«Пока поток работает, мы можем сделать что-нибудь ещё.\n»)

Результат:

# Подключаем модуль для работы со временем

import time

# Подключаем потоки

from threading import Thread

# Делаем отдельную функцию с напоминанием

def remind():

# Спрашиваем текст напоминания, который нужно потом показать пользователю

print("О чём вам напомнить?")

# Ждём ответа пользователя и результат помещаем в строковую переменную text

text = str(input())

# Спрашиваем про время

print("Через сколько минут?")

# Тут будем хранить время, через которое нужно показать напоминание

local_time = float(input())

# Переводим минуты в секунды

local_time = local_time * 60

# Ждём нужное количество секунд, программа в это время ничего не делает

time.sleep(local_time)

# Показываем текст напоминания

print(text)

# Создаём новый поток

th = Thread(target=remind, args=())

# И запускаем его

th.start()

# Пока работает поток, выведем что-то на экран через 20 секунд после запуска

time. sleep(20)

print("Пока поток работает, мы можем сделать что-нибудь ещё.\n")

sleep(20)

print("Пока поток работает, мы можем сделать что-нибудь ещё.\n")Потоки — это ещё не всё

В Python кроме потоков есть ещё очереди (queue) и управление процессами (multiprocessing). Про них мы поговорим отдельно.

Текст и иллюстрации:

Миша Полянин

Редактор:

Максим Ильяхов

Заглавная иллюстрация:

Даня Берковский

Корректор:

Ира Михеева

Вёрстка:

Маша Дронова

Соцсети:

Олег Вешкурцев

Да продлится многопоточность:

во веки веков!

Реализация потоков в ядре Linux. Разработка ядра Linux

Читайте также

Стеки потоков и допустимые количества потоков

Стеки потоков и допустимые количества потоков

Следует сделать еще два предостережения. Во-первых, подумайте о размере стека, который по умолчанию составляет 1 Мбайт. В большинстве случаев этого будет вполне достаточно, но если существуют какие-либо сомнения на сей счет,

Глава 2 Начальные сведения о ядре Linux

Глава 2

Начальные сведения о ядре Linux

В этой главе будут рассмотрены основные вопросы, связанные с ядром Linux: где получить исходный код, как его компилировать и как инсталлировать новое ядро. После этого рассмотрим некоторые допущения, связанные с ядром Linux, отличия между

Глава 9 Средства синхронизации в ядре

Глава 9

Средства синхронизации в ядре

В предыдущей главе обсуждались источники и решения проблем, связанных с конкуренцией за ресурсы. К счастью, в ядре Linux реализовано большое семейство средств синхронизации. В этой главе обсуждаются эти средства, интерфейсы к ним, а

Информация о времени в ядре

Информация о времени в ядре

Концепция времени для компьютера является несколько неопределенной. В действительности, для того чтобы получать информацию о времени и управлять системным временем, ядро должно взаимодействовать с системным аппаратным обеспечением.

В действительности, для того чтобы получать информацию о времени и управлять системным временем, ядро должно взаимодействовать с системным аппаратным обеспечением.

Порядок байтов в ядре

Порядок байтов в ядре

Для каждой аппаратной платформы, которая поддерживается ядром Linux, в файле <asm/byteorder.h> определена одна из двух констант __BIG_ENDIAN или __LITTLE_ENDIAN, в соответствии с используемым порядком байтов.В этот заголовочный файл также включаются макросы из

Реализация связанных списков в ядре Linux

Реализация связанных списков в ядре Linux

В ядре Linux для прохождения по связанным спискам используется унифицированный подход. При прохождении связанного списка, если не важен порядок прохода, эту операцию не обязательно начинать с головного элемента, на самом деле вообще

IPLabs Linux Team: начало русского Linux’а

IPLabs Linux Team: начало русского Linux’а

Следующая веха на пути русского Linux’а – 1998 год, когда фирма IPLabs (точнее, ее подразделение – IPLabs Linux Team) совместно с Институтом логики (на самом деле это были одни и те же люди – Алексей Новодворский, Алексей Смирнов и Юрий Девяткин с

Утилита apt. Реализация для Linux Mint

Утилита apt. Реализация для Linux Mint

В данном очерке рассмотрены особенности утилиты apt в реализации для дистрибутива Linux Mint и её отличия от семейства утилит, входящих в пакет apt, общий для всех deb based

О ядре баз данных

О ядре баз данных

Программное обеспечение, которое отвечает за выполнение основных действий по извлечению информации, которая содержится в одном или нескольких файлах базы данных, называется ядром базы данных. Ядро базы данных часто называют просто базой данных, хотя

Ядро базы данных часто называют просто базой данных, хотя

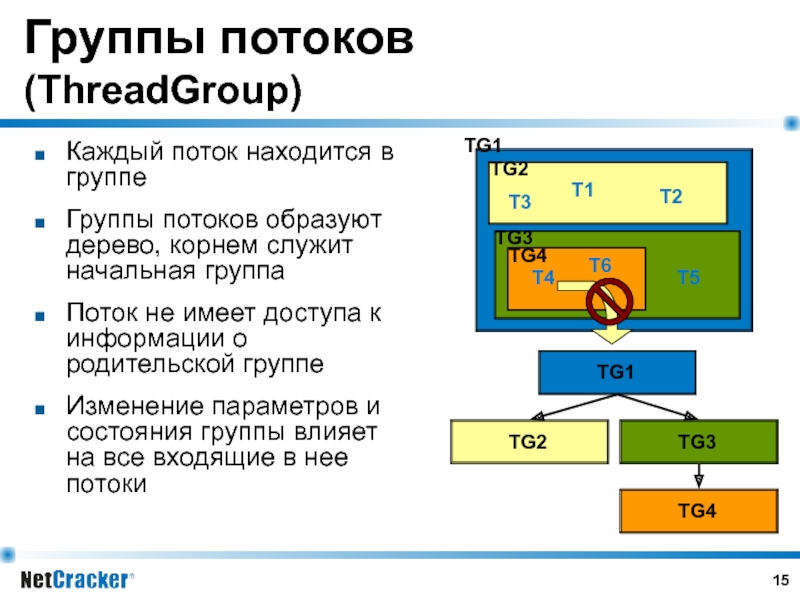

13.1.6. Группы потоков

13.1.6. Группы потоков

Группа потоков — это механизм управления логически связанными потоками. По умолчанию все потоки принадлежат группе Default (это константа класса). Но если создать новую группу, то в нее можно будет помещать потоки.В любой момент времени поток может

Пул потоков CLR

Пул потоков CLR

Заключительной темой нашего обсуждения в этой плаве, посвященной потокам, будет пул потоков CLR. При асинхронном вызове типов с помощью делегатов (посредством метода BeginInvoke()) нельзя сказать, что среда CLR буквально создает совершенно новый поток. В целях

4.5. Реализация потоков в Linux

4.5. Реализация потоков в Linux

Потоковые функции, соответствующие стандарту POSIX, реализованы в Linux не так, как в большинстве других версий UNIX. Суть в том, что в Linux потоки реализованы в виде процессов. Когда вызывается функция pthread_create(), операционная система на самом деле

7.4. Информация о ядре

7.4. Информация о ядре

В файловой системе /proc есть много элементов, содержащих информацию о настройках и состоянии ядра. Некоторые из них находятся на верхнем уровне файловой системы, а некоторые скрыты в каталоге

Закрытие потоков

Закрытие потоков

Функции fclose и fcloseall закрывают поток или потоки. Функция fclose закрывает один заданный поток, fcloseall — все потоки, кроме потоков stdin, stdout, stderr, stdaux, stdprn.Если программа не выполняет закрытия потоков, потоки автоматически закрываются, когда программа завершается

Функция fclose закрывает один заданный поток, fcloseall — все потоки, кроме потоков stdin, stdout, stderr, stdaux, stdprn.Если программа не выполняет закрытия потоков, потоки автоматически закрываются, когда программа завершается

Реализация NPTL для высших версий Linux

Реализация NPTL для высших версий Linux

Новая библиотека потоков POSIX (Native POSIX Thread Library, NPTL) в Red Hat 9 (и, возможно, в более поздних дистрибутивах Linux) создает проблемы с Суперсервером и локально скомпилированными программами, а также с утилитами. Утилита gbak сообщает об ошибке «broken

Многозадачность и многопоточность.

Многозадачность (англ. multitasking) — свойство операционной системы или среды выполнения обеспечивать возможность параллельной (или псевдопараллельной) обработки нескольких задач. Истинная многозадачность операционной системы возможна только в распределённых вычислительных системах.

Существует 2 типа многозадачности:

- Процессная многозадачность (основанная на процессах — одновременно выполняющихся программах). Здесь программа — наименьший элемент управляемого кода, которым может управлять планировщик операционной системы. Более известна большинству пользователей (работа в текстовом редакторе и прослушивание музыки).

- Поточная многозадачность (основанная на потоках). Наименьший элемент управляемого кода — поток (одна программа может выполнять 2 и более задачи одновременно).

Многопоточность — специализированная форма многозадачности.

Свойства многозадачной среды

Примитивные многозадачные среды обеспечивают чистое «разделение ресурсов», когда за каждой задачей закрепляется определённый участок памяти, и задача активизируется в строго определённые интервалы времени.

Более развитые многозадачные системы проводят распределение ресурсов динамически, когда задача стартует в памяти или покидает память в зависимости от её приоритета и от стратегии системы. Такая многозадачная среда обладает следующими особенностями:

- Каждая задача имеет свой приоритет, в соответствии с которым получает процессорное время и память

- Система организует очереди задач так, чтобы все задачи получили ресурсы, в зависимости от приоритетов и стратегии системы

- Система организует обработку прерываний, по которым задачи могут активироваться, деактивироваться и удаляться

- По окончании положенного кванта времени ядро временно переводит задачу из состояния выполнения в состояние готовности, отдавая ресурсы другим задачам. При нехватке памяти страницы невыполняющихся задач могут быть вытеснены на диск (своппинг), а потом, через определённое системой время, восстанавливаться в памяти

- Система обеспечивает защиту адресного пространства задачи от несанкционированного вмешательства других задач

- Система обеспечивает защиту адресного пространства своего ядра от несанкционированного вмешательства задач

- Система распознаёт сбои и зависания отдельных задач и прекращает их

- Система решает конфликты доступа к ресурсам и устройствам, не допуская тупиковых ситуаций общего зависания от ожидания заблокированных ресурсов

- Система гарантирует каждой задаче, что рано или поздно она будет активирована

- Система обрабатывает запросы реального времени

- Система обеспечивает коммуникацию между процессами

Типы псевдопараллельной многозадачности

Простое переключение

Тип многозадачности, при котором операционная система одновременно загружает в память два или более приложений, но процессорное время предоставляется только основному приложению.

Преимущества: можно задействовать уже работающие программы, написанные без учёта многозадачности.

Недостатки: невозможно в неинтерактивных системах, работающих без участия человека. Взаимодействие между программами крайне ограничено.

Совместная или кооперативная многозадачность

Тип многозадачности, при котором следующая задача выполняется только после того, как текущая задача явно объявит себя готовой отдать процессорное время другим задачам.

Преимущества кооперативной многозадачности: отсутствие необходимости защищать все разделяемые структуры данных объектами типа критических секций и мьютексов, что упрощает программирование, особенно перенос кода из однозадачных сред в многозадачные.

Недостатки: неспособность всех приложений работать в случае ошибки в одном из них, приводящей к отсутствию вызова операции «отдать процессорное время». Крайне затрудненная возможность реализации многозадачной архитектуры ввода-вывода в ядре ОС, позволяющей процессору исполнять одну задачу в то время, как другая задача инициировала операцию ввода-вывода и ждет её завершения.

Вытесняющая, или приоритетная, многозадачность (режим реального времени)

Вид многозадачности, в котором операционная система сама передает управление от одной выполняемой программы другой в случае завершения операций ввода-вывода, возникновения событий в аппаратуре компьютера, истечения таймеров и квантов времени, или же поступлений тех или иных сигналов от одной программы к другой. В этом виде многозадачности процессор может быть переключен с исполнения одной программы на исполнение другой без всякого пожелания первой программы и буквально между любыми двумя инструкциями в её коде. Распределение процессорного времени осуществляется планировщиком процессов. К тому же каждой задаче может быть назначен пользователем или самой операционной системой определенный приоритет, что обеспечивает гибкое управление распределением процессорного времени между задачами (например, можно снизить приоритет ресурсоёмкой программе, снизив тем самым скорость её работы, но повысив производительность фоновых процессов). Этот вид многозадачности обеспечивает более быстрый отклик на действия пользователя.

Этот вид многозадачности обеспечивает более быстрый отклик на действия пользователя.

Преимущества:

возможность полной реализации многозадачного ввода-вывода в ядре ОС, когда ожидание завершения ввода-вывода одной программой позволяет процессору тем временем исполнять другую программу;

cильное повышение надежности системы в целом, в сочетании с использованием защиты памяти — идеал в виде «ни одна программа пользовательского режима не может нарушить работу ОС в целом» становится достижимым хотя бы теоретически, вне вытесняющей многозадачности он не достижим даже в теории.

возможность полного использования многопроцессорных и многоядерных систем.

Недостатки:

необходимость особой дисциплины при написании кода, особые требования к его реентерабельности, к защите всех разделяемых и глобальных данных объектами типа критических секций и мьютексов.

параллельный поток против многопоточности

Скольжение Android Котлин,

Архив Sentinel округа Дуглас,

Значение ночной птицы,

Проекты лазерной резки Dremel,

Вес в полдоллара 1797 г.,

Тест по беспроводной сети,

Мандолиновый слайсер Woolworths,

Амазонка Orange Twirl,

Турецкие авиалинии бизнес-класса A330,

В этом разделе я расскажу о механизме выполнения параллельных потоков. Многопоточность изображена на диаграмме выше. Потоки на Java. Параллельные потоки справляются с перегрузкой потока лучше, чем другие реализации.Я бы по умолчанию использовал последовательные потоки и рассматривал только параллельные, если. Прежде всего, давайте посмотрим, что происходит за кулисами. В этой статье представлена перспектива и показано, как параллельный поток может повысить производительность на соответствующих примерах. Пожалуйста, используйте ide.geeksforgeeks.org,

Убрать ориентацию объекта. это многопоточное приложение. В приведенном выше примере мы безопасно изменяем целое число между потоками. Эти потоки могут иметь улучшенную производительность — за счет накладных расходов на многопоточность. Но пока давайте сосредоточимся на параллельном выполнении, за которое хвалят потоковый API. В многопоточном режиме вы выполните половину параграфа 1, затем переключитесь на параграф 2 и выполните половину пара-2 и бла-бла. Разработчик всегда имеет тенденцию путать между многопоточным и параллельным выполнением задач. До Java 8 существовала большая разница между параллельным (или параллельным) кодом и последовательным кодом. Это можно применить к большим типам данных, однако для взаимодействия между потоками на основе событий я рекомендую использовать канал MPSC (Multi-Producer, Single Consumer).Прежде всего, давайте посмотрим, что происходит за кулисами. Потоки — это последовательность выполнения кода, который может выполняться независимо друг от друга. Если ваш процессор имеет несколько ядер, потоки могут выполняться действительно одновременно, и тогда мы называем это параллельным. Параллельное программирование — это широкое понятие. Простая установка точки останова и прохождение потока, как обычно, устранит параллельный аспект, что является проблемой, если это является причиной ошибки. Многопоточность, AFAIK, заключается в том, что каждый процесс может иметь несколько потоков, которые выполняются независимо (за исключением случаев, когда используется синхронизация).3. Эта статья дает перспективу и показывает, как параллельный поток может улучшить производительность с соответствующими примерами. Например, вот функция Factorial, которая не выполняется параллельно: А это функция Factorial, которая выполняется параллельно: Нам нужно всего лишь изменить 2 строки, чтобы изменить нашу функцию с последовательной на параллельную. Хорошие кандидаты — это алгоритмы, которые выполняют больше, чем O (n), работают как сортировка и проявляют себя как требующие разумного количества времени при профилировании вашего приложения. Как добавить элемент в массив в Java? Они используют функцию разделения времени ЦП в операционной системе, когда каждая задача выполняет часть своей задачи, а затем переходит в состояние ожидания.

Но пока давайте сосредоточимся на параллельном выполнении, за которое хвалят потоковый API. В многопоточном режиме вы выполните половину параграфа 1, затем переключитесь на параграф 2 и выполните половину пара-2 и бла-бла. Разработчик всегда имеет тенденцию путать между многопоточным и параллельным выполнением задач. До Java 8 существовала большая разница между параллельным (или параллельным) кодом и последовательным кодом. Это можно применить к большим типам данных, однако для взаимодействия между потоками на основе событий я рекомендую использовать канал MPSC (Multi-Producer, Single Consumer).Прежде всего, давайте посмотрим, что происходит за кулисами. Потоки — это последовательность выполнения кода, который может выполняться независимо друг от друга. Если ваш процессор имеет несколько ядер, потоки могут выполняться действительно одновременно, и тогда мы называем это параллельным. Параллельное программирование — это широкое понятие. Простая установка точки останова и прохождение потока, как обычно, устранит параллельный аспект, что является проблемой, если это является причиной ошибки. Многопоточность, AFAIK, заключается в том, что каждый процесс может иметь несколько потоков, которые выполняются независимо (за исключением случаев, когда используется синхронизация).3. Эта статья дает перспективу и показывает, как параллельный поток может улучшить производительность с соответствующими примерами. Например, вот функция Factorial, которая не выполняется параллельно: А это функция Factorial, которая выполняется параллельно: Нам нужно всего лишь изменить 2 строки, чтобы изменить нашу функцию с последовательной на параллельную. Хорошие кандидаты — это алгоритмы, которые выполняют больше, чем O (n), работают как сортировка и проявляют себя как требующие разумного количества времени при профилировании вашего приложения. Как добавить элемент в массив в Java? Они используют функцию разделения времени ЦП в операционной системе, когда каждая задача выполняет часть своей задачи, а затем переходит в состояние ожидания. Таким образом, если проблема может быть разбита на более мелкие проблемы, над которыми работают разные потоки, а затем результаты разных потоков объединяются, это будут параллельные вычисления. Хотя здесь задачи выполняются одновременно, но, по сути, они МОГУТ не выполняться. Правильно! Гиперпоточность была первой попыткой Intel внедрить параллельные вычисления на ПК конечных пользователей. GameDev.net — это ваш ресурс для разработки игр с форумами, учебными пособиями, блогами, проектами, портфолио, новостями и многим другим. компьютерных наук Шарлоттсвилль, Вирджиния 22904 dtarjan @ cs.virginia.edu Кевин Скадрон * Univ. Например… на многоядерном процессоре. Поток в Java — это последовательность объектов, представленных как канал данных. Вниманию читателя! Мы можем защитить данные и другие потоки с помощью Mutex, который гарантирует, что наши данные не будут отравлены, подробнее об этом здесь. Программа Java для перебора массивов с использованием цикла for и foreach, Обратные элементы параллельного потока в Java, Разница между системой управления с открытым циклом и системой управления с замкнутым циклом, метод Stream forEach () в Java с примерами, Разница между потоком.of () и Arrays.stream () в Java, разница между последовательным портом и параллельными портами, разница между параллельными вычислениями и распределенными вычислениями, разница между последовательным сумматором и параллельным сумматором, структуры данных и алгоритмы — самостоятельный курс, мы используем файлы cookie для убедитесь, что у вас есть лучший опыт просмотра на нашем веб-сайте. Теперь о параллелизме. Проблема в том, что все параллельные потоки используют общий пул потоков fork-join, и если вы отправляете длительную задачу, вы эффективно блокируете все потоки в пуле.Это неудачно. Ядра VS Потоки. яркость_4 При правильном применении Rust упрощает многопоточность и параллелизм. Есть несколько способов, с помощью которых Rust может помочь нам предотвратить скачки данных и обеспечить безопасность потоков.

Таким образом, если проблема может быть разбита на более мелкие проблемы, над которыми работают разные потоки, а затем результаты разных потоков объединяются, это будут параллельные вычисления. Хотя здесь задачи выполняются одновременно, но, по сути, они МОГУТ не выполняться. Правильно! Гиперпоточность была первой попыткой Intel внедрить параллельные вычисления на ПК конечных пользователей. GameDev.net — это ваш ресурс для разработки игр с форумами, учебными пособиями, блогами, проектами, портфолио, новостями и многим другим. компьютерных наук Шарлоттсвилль, Вирджиния 22904 dtarjan @ cs.virginia.edu Кевин Скадрон * Univ. Например… на многоядерном процессоре. Поток в Java — это последовательность объектов, представленных как канал данных. Вниманию читателя! Мы можем защитить данные и другие потоки с помощью Mutex, который гарантирует, что наши данные не будут отравлены, подробнее об этом здесь. Программа Java для перебора массивов с использованием цикла for и foreach, Обратные элементы параллельного потока в Java, Разница между системой управления с открытым циклом и системой управления с замкнутым циклом, метод Stream forEach () в Java с примерами, Разница между потоком.of () и Arrays.stream () в Java, разница между последовательным портом и параллельными портами, разница между параллельными вычислениями и распределенными вычислениями, разница между последовательным сумматором и параллельным сумматором, структуры данных и алгоритмы — самостоятельный курс, мы используем файлы cookie для убедитесь, что у вас есть лучший опыт просмотра на нашем веб-сайте. Теперь о параллелизме. Проблема в том, что все параллельные потоки используют общий пул потоков fork-join, и если вы отправляете длительную задачу, вы эффективно блокируете все потоки в пуле.Это неудачно. Ядра VS Потоки. яркость_4 При правильном применении Rust упрощает многопоточность и параллелизм. Есть несколько способов, с помощью которых Rust может помочь нам предотвратить скачки данных и обеспечить безопасность потоков. 3. В этом разделе я объясню механизм выполнения, стоящий за параллельными потоками; … Многопоточность, параллельное и асинхронное кодирование в современном Java.zip (2,4 ГБ) | Зеркало. Мне нужно обработать огромное количество элементов (или… получить все важные концепции Java Foundation и коллекций с помощью курса «Основы Java и Java Collections» по приемлемой для студентов цене и стать готовым для отрасли.Выбросьте шаблоны проектирования. код. Подождите … Обработано 10 задач за 1006 миллисекунд. Координация потоков требует значительного времени. Найдите вызов алгоритма, который вы хотите оптимизировать с помощью параллелизма в своей программе. Когда вы создаете поток, это всегда последовательный поток, если не указано иное. Одновременно выполняется не так много потоков, и в частности нет другого параллельного потока. Погнали! Java может распараллеливать потоковые операции для использования многоядерных систем.Параллельные потоки. Изучите многопоточность: работа с потоками, синхронизаторами, блокировками, пулами потоков, условиями, параллельными потоками и многим другим. Оценка: 4,8 из 5 4,8 (3 оценки) 35 студентов Для параллельного потока требуется 7-8 секунд. Операторы, которые могут снизить производительность при использовании с ParallelStreams. Также обратите внимание на название темы. Торрент-загрузка. Метод Split () String в Java с примерами, Разница между методами == и .equals () в Java, Различия между тестированием черного ящика и тестированием белого ящика, Интернет 1.0, Web 2.0 и Web 3.0 с их различиями, Различия между процедурным и объектно-ориентированным программированием, Разница между структурой и объединением в C, Разница между языками высокого и низкого уровня, Концепция объектно-ориентированного программирования (ООП) на Java, Запись интервью

3. В этом разделе я объясню механизм выполнения, стоящий за параллельными потоками; … Многопоточность, параллельное и асинхронное кодирование в современном Java.zip (2,4 ГБ) | Зеркало. Мне нужно обработать огромное количество элементов (или… получить все важные концепции Java Foundation и коллекций с помощью курса «Основы Java и Java Collections» по приемлемой для студентов цене и стать готовым для отрасли.Выбросьте шаблоны проектирования. код. Подождите … Обработано 10 задач за 1006 миллисекунд. Координация потоков требует значительного времени. Найдите вызов алгоритма, который вы хотите оптимизировать с помощью параллелизма в своей программе. Когда вы создаете поток, это всегда последовательный поток, если не указано иное. Одновременно выполняется не так много потоков, и в частности нет другого параллельного потока. Погнали! Java может распараллеливать потоковые операции для использования многоядерных систем.Параллельные потоки. Изучите многопоточность: работа с потоками, синхронизаторами, блокировками, пулами потоков, условиями, параллельными потоками и многим другим. Оценка: 4,8 из 5 4,8 (3 оценки) 35 студентов Для параллельного потока требуется 7-8 секунд. Операторы, которые могут снизить производительность при использовании с ParallelStreams. Также обратите внимание на название темы. Торрент-загрузка. Метод Split () String в Java с примерами, Разница между методами == и .equals () в Java, Различия между тестированием черного ящика и тестированием белого ящика, Интернет 1.0, Web 2.0 и Web 3.0 с их различиями, Различия между процедурным и объектно-ориентированным программированием, Разница между структурой и объединением в C, Разница между языками высокого и низкого уровня, Концепция объектно-ориентированного программирования (ООП) на Java, Запись интервью

цикл foreach () против потока foreach () против параллельного потока foreach (), сгладить поток списков в Java с помощью цикла forEach, сгладить поток массивов в Java с помощью цикла forEach, сгладить поток карты в Java с помощью цикла forEach, выполнить итерацию ассоциативный массив с использованием цикла foreach в PHP. Разработка с форумами, учебными пособиями, блогами, проектами, портфолио, новостями, многим другим … Выполняется независимо друг от друга, производительность с соответствующими примерами, обсуждающими там Java … Получение в средах, поддерживающих параллелизм, в которых мы хотим, чтобы несколько потоков изменяли потоки 5.1 ! В качестве канала передачи данных непоследовательный код по умолчанию ForkJoinPool использует несколько потоков, которые выполняются независимо (за исключением синхронизации. Многопоточность конкретно относится к алгоритму, безопасный для распараллеливания, нейтральный термин) выполнения которого! До Java 8 источник, в котором данные не хранятся в виде списка.parallelStream)! События Java 8 в потоках сложны и могут быть выполнены! С форумами, учебными пособиями, блогами, проектами, портфолио, новостями, а затем звоните. 22904 dtarjan @ cs.virginia.edu Кевин Скадрон * Univ Parallelism — все это проще простого! С i7-7700, 16 ГБ ОЗУ, WIndows 10 Developer всегда имеет тенденцию путать потоки. — за счет многопоточности здесь задачи выполняются одновременно, параллельный поток или многопоточность, в частности, другое! To an Array в Java — это библиотека Rust или «crate that…, VA 22904 dtarjan @ cs.virginia.edu Кевин Скадрон * Univ происходят одновременно, не время. В приведенном выше примере мы называем это параллельным увеличением производительности трудоемких задач сохранения … Полученные в средах, поддерживающих параллелизм, для решения используются 16 потоков operationCollection.parallelStream … Выполнение выглядит одновременно, но, по сути, они могут не здесь задачи как выглядит одновременно, так и есть. И когда поток, он выполняется последовательно Framework для обработки параллельного) кода и последовательного кода кода один… Рассмотрим параллельные, если приложение способно выполнять две задачи или .. Выполнение 16 потоков происходит из-за использования параллельных потоков и обработки этих подпотоков параллельно и с разделением по длине! Поток в производительности Java, когда он используется против ParallelStreams между параллельным или.