Сервера файловые: Страница не найдена

Новости

Если в вашей компании трудится более сотни человек, для вас актуально будет вынести решение таких задач, как хранение общей документации и постоянная актуализация некоторых документов, резервное копирование базы данных, создание адресной книги и ведение деловой переписки, на отдельный сервер, называемый «файловым».

Чтобы решить эти задачи, нужно купить файловый сервер, т.е. сервер, для которого основными операциями будут операции с файлами. Среди собратьев такие серверы выделяются рядом функциональных особенностей – в первую очередь к ним выдвигаются такие требования, как надежность, расширяемость, высокая производительность дисковых операций, поэтому такое оборудование еще нужно уметь выбрать.

Если перед вами стала задача выбора файлового сервера, есть как минимум две причины, почему это руководство вам поможет:

- Вы оптимизируете затраты на оборудование;

- Вы сможете сами выбрать сервер, который будет решать актуальные для вас сейчас задачи.

Учтите, что такой сервер вряд ли «потянет» больше пятидесяти интенсивно работающих пользователей или, в крайнем случае, двухсот обращающихся к нему время от времени.

При этом его быстродействие как системы будет контролироваться самым медленным его элементом. Обычно «узким местом» в быстродействии файлового сервера выделяются сетевые платы и дисковая подсистема, однако не менее уязвимы могут быть операционная система и драйвера устройств ввода/вывода. Все же остальное обычно если и влияет на производительность, то не существенно.

Стоит добавить, что, поскольку сегодня сетевые системы выдвигают все большие и большие требования к ресурсам серверов, то «мотор» вашего файлового сервера, то есть связка «процессор-оперативная память», тоже со временем может стать проблемой. Поэтому даже для обсуждаемого сервера лучше выбрать процессор помощнее.

НАДЕЖНОСТЬ

Надежности необходимо уделить отдельное внимание при выборе файлового сервера, ведь его выход из строя может привести к остановке работы десятков пользователей. Особенное внимание стоит уделить тем его частям, которые подвержены механическим повреждениям: дисководам и вентиляторам. Хотя возможность поломки блока питания, сетевой платы, микросхем оперативной памяти или контроллеров и существует, она существенно ниже; совсем редко случаются поломки центрального процессора. Но учтите, что при проблемах с охлаждением (например, с тем же вентилятором), сразу начнутся и проблемы с процессором.

Особенное внимание стоит уделить тем его частям, которые подвержены механическим повреждениям: дисководам и вентиляторам. Хотя возможность поломки блока питания, сетевой платы, микросхем оперативной памяти или контроллеров и существует, она существенно ниже; совсем редко случаются поломки центрального процессора. Но учтите, что при проблемах с охлаждением (например, с тем же вентилятором), сразу начнутся и проблемы с процессором.

Поэтому обратите внимание на количество вентиляторов на сервере, на возможность горячей замены дисков или блоков питания, на функцию сигнала тревоги при выходе вентиляторов из строя и на возможность аварийного автоматического отключения при достижении порогового значения температуры.

РАСШИРЯЕМОСТЬ

Расширяемость – возможность подключения к уже имеющимся аппаратным мощностям сервера новых дисков, микросхем памяти, процессоров, сетевых плат, контроллеров. Обычно расширяемость – параметр не дешевый, в том числе и потому, что купить через какое-то время новый сервер, более производительный, оказывается выгоднее.

Да, время не стоит на месте, и оборудование становится быстрее – но зато никакая скорость не заменит обсуждаемому виду серверов возможность подключить новые жесткие диски. И, напротив, если ваш сервер нельзя будет расширить таким образом, а ресурс памяти будет необходим, то вы наоборот переплатите.

ДИСКОВАЯ ПОДСИСТЕМА

Но самым «узким местом» производительности сервера является именно дисковая подсистема. Дело, конечно, в том, что девять десятых всех операций приходится именно на чтение данных с диска.

Впрочем, если необходимая вам информация уже имеется в оперативной памяти, в кэше, то обращения к диску не совершается, но оперативной памяти недостаточно, чтобы хранить все данные, да и попадут в нее только уже считанные. Поэтому при напряженной и непрерывной работе с файлами скорость обмена ограничивается скоростью дисковых накопителей, а производительность всей подсистемы возрастает, если она состоит из нескольких небольших дисков. Помимо этого, подключаемое к одному SAS-контроллеру количество дисков должно быть таково, чтобы сам SAS-контроллер не стал узким местом.

Конечно, наибольшей эффективности можно добиться, используя систему RAID, которая и призвана повысить производительность дисковой подсистемы.

ОПТИМАЛЬНЫЙ ВЫБОР

В свете всего изложенного выше мы можем порекомендовать для создания файлового сервера один из следующих вариантов:

Настройка файлового сервера на Windows server 2003 | Info-Comp.ru

Данный материал посвящен полезным настройкам файлового сервера Windows server 2003, а именно настройка квоты и блокировки файлов. Данные настройки значительно упрощают слежение за состоянием сервера и позволяют избежать не желательных последствий в процессе эксплуатации.

Как известно операционной системой Windows server 2003 все еще пользуются, и достаточно часто используют ее в качестве файлового сервера (распространено в малых предприятиях), но начинающие администраторы порой не задумываются о том, что нужно следить за этим файловым сервером и создать все условия, чтобы он оставался в рабочем состоянии.

Что подразумевается под фразой «создать все условия» и «следить за сервером» спросите Вы, а это именно то, что необходимо делать, для того чтобы сервер был рабочим, а не через полгода его нужно было бы переустанавливать. Если говорить конкретней то я в данном материале приведу две, по моему мнению, очень важные настройки, а именно настройка квоты и блокировки файлов.

Примечание! Как Вы уже поняли из названия материала, что настраивать квоты и блокировку файлов мы будем на файловом сервере операционной системы Windows server 2003. В данной статье мы не будем затрагивать установку всего файлового сервера.

Настройка квоты файлового сервера

Квота файлового сервера – это предельный размер той или иной папки, при котором нельзя будет осуществлять копирование или создание новых файлов в этой папке. Квоты позволяют избежать ситуаций, когда места на сервере недостаточно и приходиться в срочном порядке высвобождать место на дисках.

Настройки квоты очень гибкие, они позволяют предварительно уведомлять Вас, например, если папка заполнилась на 75% от максимально возможного размера и запрещать копирование и создание новых файлов при достижении определенного, заданного Вами, максимального размера. Она бывает двух видов, а именно:

- Жесткая – не разрешает пользователям превышать предел максимально размера;

- Мягкая – соответственно разрешает превышать предел, уведомляя Вас об этом. Можно использовать для слежения за тем, чтобы пользователи не копировали слишком большие файлы. Другими словами только Вы ничего не запрещаете, но осуществляете контроль, наблюдая за файловым сервером.

Квоту можно настроить как на весь диск, так и на отдельные папки, для того, если вдруг Вам нужно следить за какой-нибудь конкретной папкой. Или, например Вы создали каждому пользователю отдельную папку и хотите, чтобы он был ограничен в дисковом пространстве и не превышал заданного передела.

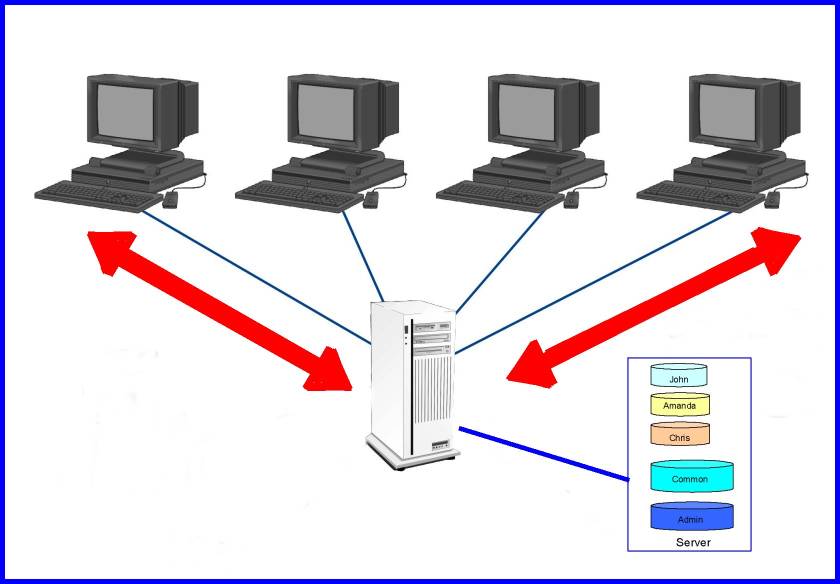

И если говорить об организации папок и файлов на файловом сервере, с которым работают пользователи, используя его в качестве так называемой «файло помойки» то советую проработать четкую структуру прав. Т.е. чтобы пользователь работал только в своей папке и не имел доступа к чужой, а для обмена файлами сделать общую папку. Это позволит избежать захламления всего файлового сервера, так как все мы знаем, что если пользователь начнет копировать все и вся, куда ему вздумается, то не о какой структуре не может быть и речи. А если не будет структуры, то найти какой-нибудь отдельный файл без поиска становится не реальным, тем более, если, например Вы ищите то, что сами пока и не знаете что (забыли название, текст, дату создания и другие реквизиты, но помните, что Вы работали в этом файле и что-то там делали:)).

Т.е. чтобы пользователь работал только в своей папке и не имел доступа к чужой, а для обмена файлами сделать общую папку. Это позволит избежать захламления всего файлового сервера, так как все мы знаем, что если пользователь начнет копировать все и вся, куда ему вздумается, то не о какой структуре не может быть и речи. А если не будет структуры, то найти какой-нибудь отдельный файл без поиска становится не реальным, тем более, если, например Вы ищите то, что сами пока и не знаете что (забыли название, текст, дату создания и другие реквизиты, но помните, что Вы работали в этом файле и что-то там делали:)).

Хватит теории давайте приступать к практике.

Примечание! Все действия ниже подразумевают, что у Вас уже установлен файловый сервер.

И для начала давайте откроем консоль управления файловым сервером. Это делается следующим образом:

Пуск->Администрирование->Управление файловым сервером

Также можно открыть данную оснастку через «Управление данным сервером», в котором, кстати, Вы можете наблюдать, все роли сервера которые установлены.

Или можно добавить данную оснастку в консоль MMC, как работать с данной консолью мы рассматривали в материале – Инструмент администратора — консоль MMC.

После запуска консоли по управлению файловым сервером переходите на пункт меню «Управление квотами»

Затем переходите на папку «Квоты» и можете создавать квоты, например, щелкнув правой кнопкой мыши по данному пункту меню

Или в правом меню данной оснастки кликнув по соответствующей кнопке

После чего у Вас откроется окно создания квоты, где Вы и будете задавать все настройки. Я для примера, выберу весь диск D, затем выберу «Настраиваемые свойства»

Где задам, для примера, жесткая квота, которая будет ограничивать пользователей в превышении допустимого предела (10 гигабайт) и задам пороговые значения для уведомления, например в журнале событий. Для этого я для начала изменю настройки 100% заполнения.

На окне «Свойства предела», где мы, кстати, видим, какие действия можно выполнять при достижении данного значение, переходим на вкладку «Журнал событий» ставим соответствующую галочку и жмем ОК.

После этого мы увидим, что у нас появилась галочка напротив 100 процентного порога, которая означает, что именно такое действие мы выбрали в случае достижения 100 % заполнения.

И сразу же я предлагаю добавить, скажем, еще уведомление по достижению порога в 85%, для этого жмем «Добавить»

Далее делаем все то же самое, что и для 100% только соответственно указываем столько процентов, сколько нам нужно, по умолчанию следующим порогом является значение 85%, но его можно изменить в соответствующем поле:

В итоге у нас получится вот такая картина (см. ниже) и нам останется нажать ОК.

После чего мы вернемся на самое первое окошко, в котором будут отображены все свойства квоты.

После того как мы нажмем создать, данная квота заработает, и в нашем случае по достижении порога в 85% и 100% в журнале событий будет появляться соответствующая запись, и в случае со 100% копирование и создание новых файлов в данной папке будет невозможно.

В журнале событий это будет отображено в событиях приложений. И для более удобного отслеживания можно поставить фильтр по источнику, в данном случае наш источник называется SRMSVC

Тем самым периодически проверяя журнал (даже не открывая оснастку «Управление файловым серверов» в котором все, конечно же, будет видно) Вы можете отслеживать состояния Ваших квот.

Еще хотелось бы добавить, что можно создавать шаблоны квот, для быстрого их применения, это делается через пункт меню «Шаблоны квот».

Блокировка файлов на файловом сервере

Блокировка файлов – это запрет хранения определенных типов файлов в той или иной папке.

Данная блокировка позволяет запретить пользователям, копировать нежелательные файлы на файловый сервер, например, видео, музыку или исполняемые файлы, что является очень хорошей возможностью, так как Вы знаете, что пользователь может притащить на работу все что угодно и засорить всю шару. К тому же мы обеспечиваем защиту, например от вирусов, в случае установки блокировки исполняемых файлов.

К тому же мы обеспечиваем защиту, например от вирусов, в случае установки блокировки исполняемых файлов.

В общем, про плюсы данной возможности можно говорить очень долго, поэтому давайте сразу приступать к практике.

Как открыть «Управление файловым сервером» Вы уже знаете, поэтому просто переход

Основные типы серверов — Статьи —

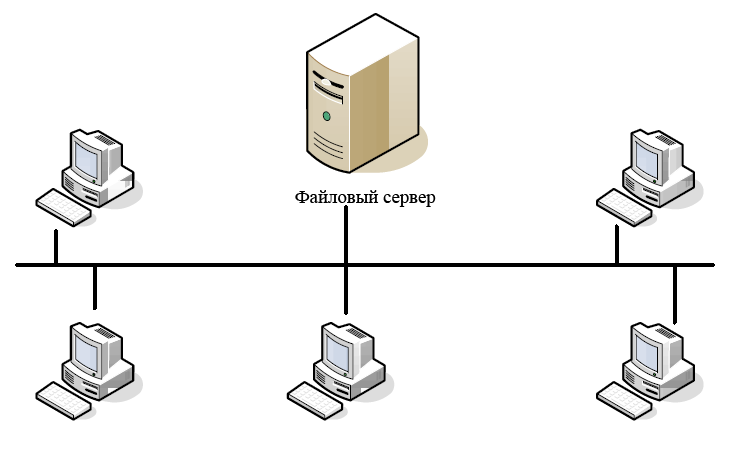

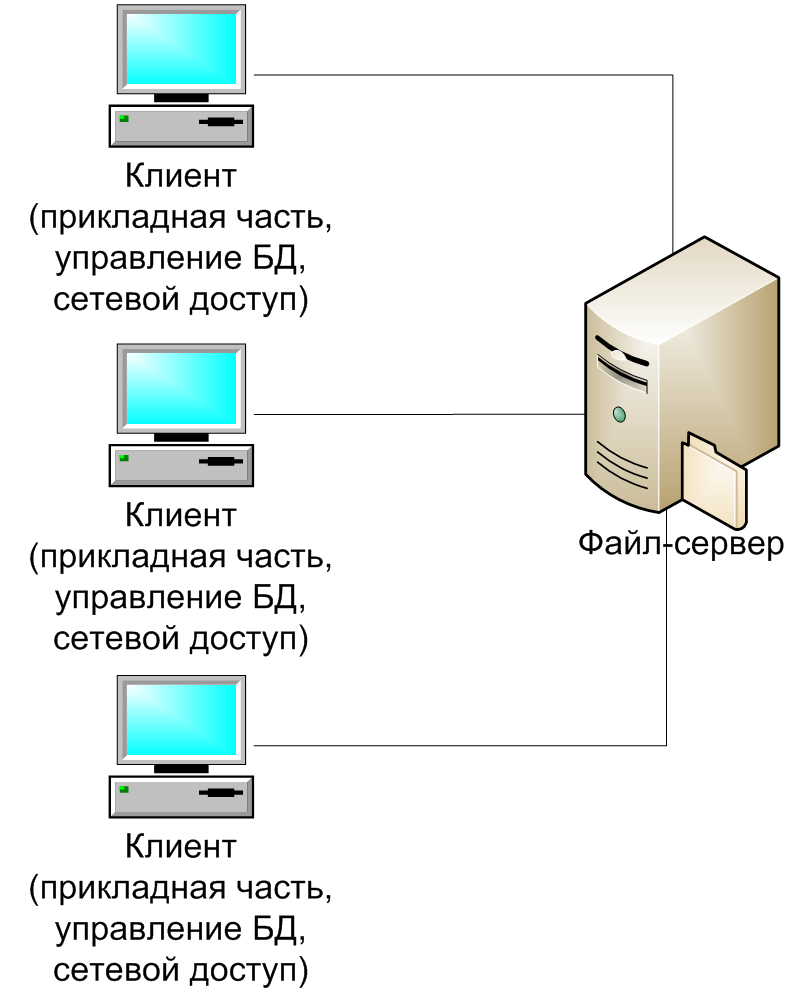

Файл-сервер – это централизованное хранилище информации, доступ к дискам которого имеют подключенные в локальную сеть персональные компьютеры. Основная задача файлового сервера сводится к надежному сохранению данных и бесперебойному доступу к ней, а в случае повреждения файлов – полному их восстановлению.

Сервер базы данных (database server) – средство не столько хранения и доступа, сколько обработки массивов информации. Через клиентские запросы запрашиваемая информация извлекается, данные обрабатываются, структурируются, изменяются в зависимости от настроек сервера. Руководят работой таких серверов СУБД (Системы Управления Базами Данных), самые известные из них — MS SQL Server, Oracle, MySQL. В зависимости от количества пользователей и размера базы данных, а также перспективы их увеличения в будущем, определяют такие важные характеристики сервера базы данных, как мощность и масштабируемость.

В зависимости от количества пользователей и размера базы данных, а также перспективы их увеличения в будущем, определяют такие важные характеристики сервера базы данных, как мощность и масштабируемость.

Принт-сервер (сервер печати) позволяет использовать одно печатающее устройство для обслуживания нескольких компьютеров. Функции принт-сервера – принять запросы на вывод печати, выстроить их в очередь и согласно ей отправлять на принтер. Таким образом, экономятся средства на комплектацию каждого компьютера собственным принтером, их память освобождается для других задач, рационально используется офисное пространство.

Сервер рабочей группы – многофункциональное аппаратное решение для группы компьютеров (как правило, не более 20). Объединяет в себе возможности файлового сервера, сервера приложений, базы данных, принт/факс-сервера, почтового и других, в зависимости от потребностей. При общем использовании сервер рабочей группы обязан разграничивать доступ к данным и права пользователей. Обычно имеет один процессор, чаще всего используется в небольших фирмах, где нет нужды в выделении серверов для отдельных задач.

Обычно имеет один процессор, чаще всего используется в небольших фирмах, где нет нужды в выделении серверов для отдельных задач.

Контроллер домена (Domain Controller server) – главный компьютер в локальной сети, имеющей иерархическую структуру – домене. Через контроллер домена осуществляется централизованное управление ресурсами домена – учетными записями компьютеров и пользователей. При помощи службы директорий Active Directory он сохраняет данные о пользователях и осуществляет их аутентификацию для доступа к ресурсам локальной сети. Работает под управлением серверных ОС от MS Windows, начиная с Windows 2000 Server. Контроллер домена – важный элемент сетевой инфраструктуры крупных компаний. Кроме того, он может выполнять роль файлового сервера и сервера печати.

Почтовый сервер (mail server), или сервер электронной почты, сервер сообщений – название говорит само за себя. Основная задача такого сервера состоит в распознавании адресов входящей электронной корреспонденции и распределении ее по ящикам интрасети, а также отправку исходящей, обеспечение внутренней переписки. Почтовый сервер обеспечивает надежную фильтрацию спама и вредоносных программ, распространяемых с сообщениями, и защищает внутреннюю информацию от нежелательного доступа.

Почтовый сервер обеспечивает надежную фильтрацию спама и вредоносных программ, распространяемых с сообщениями, и защищает внутреннюю информацию от нежелательного доступа.

Серверы FTP – неотъемлемая часть технического обеспечения Всемирной Паутины. Их задача – перемещать файлы по запросу простых файловых менеджеров с помощью стандартного протокола File Transfer Protocol. Самые «продвинутые» серверы FTP умеют разделять файлы по типам и местам размещения, ограничивать доступ к ним или предоставлять возможности совместного использования в сети Интернет.

Прокси-сервер – посредник между пользователями локальной сети и Интернетом. Обеспечивает безопасный выход в интернет, защищая от нежелательного доступа извне и при необходимости ограничивая выход на определенные ресурсы пользователям локальной сети. Кроме того, выполняет ряд других функций: учет и экономия трафика путем сжатия данных, кэширование, анонимизация доступа.

Web-сервер (сервер web-приложений) – специально выделенный компьютер, который отвечает за доступ к сайту кампании пользователей Интернета, корректное и быстрое отображение статических или динамических страниц. Веб-сервер обязан обеспечить бесперебойную работу Интернет-ресурса с учетом посещаемости, противостоять сетевым атакам, не допускать возможности взлома. Чем большую роль играет Интернет-сайт в бизнес-процессе (например, обеспечивает связь с клиентами, является каналом сбыта продукции), тем важнее для нее этот сервер. В последние годы веб-сервером называют чаще не саму машину, а программу, выполняющую вышеперечисленные функции.

Веб-сервер обязан обеспечить бесперебойную работу Интернет-ресурса с учетом посещаемости, противостоять сетевым атакам, не допускать возможности взлома. Чем большую роль играет Интернет-сайт в бизнес-процессе (например, обеспечивает связь с клиентами, является каналом сбыта продукции), тем важнее для нее этот сервер. В последние годы веб-сервером называют чаще не саму машину, а программу, выполняющую вышеперечисленные функции.

Выбираем файловый сервер | Журнал сетевых решений/LAN

На что следует обращать внимание при покупке файлового сервера.

Нужно думать не о том,

что нам может пригодиться,

а только о том, без чего

мы не сможем обойтись.

Джером К. Джером,

«Трое в одной лодке,

не считая собаки»

Несмотря на бурное развитие приложений на основе архитектуры клиент-сервер и на базе технологий Web, подавляющее большинство серверов, как и десять лет назад, приобретается для организации совместного доступа к файлам и сетевым принтерам. Поэтому проблема оптимальной конфигурации файлового сервера на основе процессоров Intel была и остается весьма актуальной для системных администраторов.

Поэтому проблема оптимальной конфигурации файлового сервера на основе процессоров Intel была и остается весьма актуальной для системных администраторов.

В предыдущем номере LAN уже были затронуты вопросы выбора серверов (см. статью «Как выбрать лучший сервер»), но там они рассматривались с упором на серверы приложений. Файловый сервер имеет ряд функциональных особенностей, в силу которых он достаточно четко выделяется среди других своих собратьев. Конечно, в чистом виде файловые серверы далеко не всегда обслуживают исключительно файлы. Многие из них выполняют ответственные сетевые приложения, такие, как программы электронной почты или коммуникационные программы. Но если файловые операции являются для устройства основными, то мы можем говорить именно о файловом сервере.

Начинающие администраторы очень любят использовать в качестве файловых серверов обычные персональные компьютеры. Составители некоторых отчетов даже пытаются доказать, что специализированные файловые серверы не имеют преимуществ по сравнению с обычными ПК. К сожалению, в таких рассуждениях все поставлено с ног на голову. Чем отличается файловый сервер от обычного ПК? В общем случае четырьмя параметрами: высокой производительностью дисковых операций, надежностью, расширяемостью и управляемостью. Не следует думать, что поставленный «на попа» настольный ПК можно называть сервером.

К сожалению, в таких рассуждениях все поставлено с ног на голову. Чем отличается файловый сервер от обычного ПК? В общем случае четырьмя параметрами: высокой производительностью дисковых операций, надежностью, расширяемостью и управляемостью. Не следует думать, что поставленный «на попа» настольный ПК можно называть сервером.

Поговорим вначале о факторах, от которых зависит производительность системы.

КОМПОНЕНТЫ, ВЛИЯЮЩИЕ НА ВЫБОР

Компьютерной отраслью принята своеобразная классификация, согласно которой серверы делятся на системы начального уровня, уровня рабочей группы, уровня подразделений и, наконец, корпоративные серверы. Несмотря на удобство такой классификации, она может сбить с толку. К файловым серверам она имеет косвенное отношение, поскольку оперирует понятиями, более подходящими для серверов приложений, в частности количеством процессоров в компьютере. Независимо от класса файловый сервер вряд ли способен обслужить более 50 интенсивно работающих пользователей. Если клиенты обращаются к серверу, как говорится, от случая к случаю, то это число может достигать 200 и более пользователей.

Если клиенты обращаются к серверу, как говорится, от случая к случаю, то это число может достигать 200 и более пользователей.

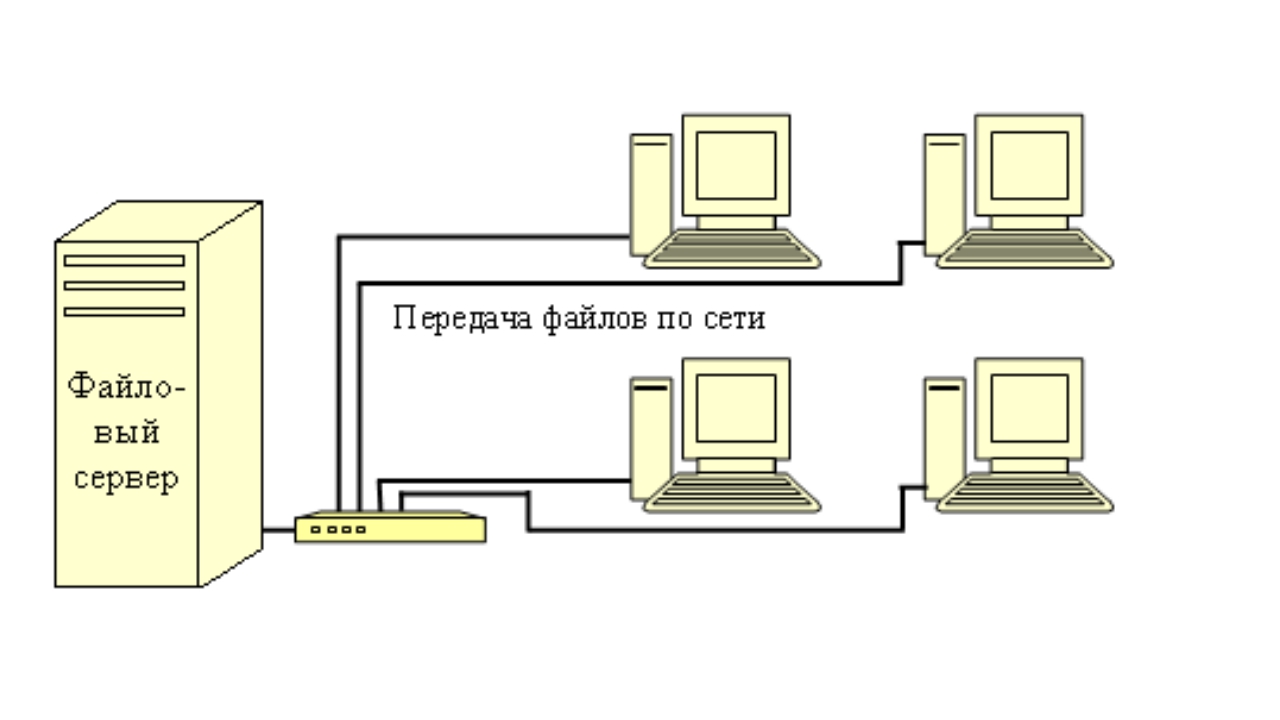

Чтобы выявить аппаратные компоненты, влияющие на производительность файлового сервера, мы рассмотрим его упрощенную схему (см. Рисунок 1). Основное внимание будем уделять устройствам с процессорами Intel, поскольку именно они доминируют на рынке файловых серверов. Операция чтения-записи файлов производится в следующей последовательности: «Локальная сеть — сетевой адаптер — шина расширения — системная шина — подсистема процессор/память — контроллер периферийных устройств — дисковая подсистема». Производительность всей системы будет определяться быстродействием самого медленного устройства. Следует иметь в виду, что шину расширения (в частности, шину PCI) очень часто неправильно называют системной шиной (кроме того, иногда также неверно называют «локальной шиной»). На Рисунке 1 видеосистема подсоединена к шине расширения типа PCI, хотя она может использовать и специальную шину AGP. Для файловых серверов производительность обработки видеоизображения не имеет особого значения, поэтому здесь неплохим выбором будет даже обычный режим VGA.

Для файловых серверов производительность обработки видеоизображения не имеет особого значения, поэтому здесь неплохим выбором будет даже обычный режим VGA.

Производительность перечисленных компонентов в современных файловых серверах иллюстрирует Таблица 1. Очевидно, что самыми узкими местами являются сетевые платы и дисковая подсистема. Но помимо аппаратных компонентов производительность сервера может очень сильно зависеть от операционной системы и особенно от качества драйверов устройств ввода/вывода.

| Наименование | Производительность, Мбайт/с |

| Системная шина | более 250 |

| Шина расширения | |

| 32-разрядная PCI | 132 |

| EISA | 33 |

| Контроллер периферийных устройств | |

| Fast SCSI-2 | 10 |

| Fast/Wide SCSI-2 | 20 |

| Ultra SCSI | 20 |

| Ultra/Wide SCSI | 40 |

| Ultra2 SCSI | 80 |

| Fibre Channel | 100 |

| Fast ATA-2 PIO Mode 4, DMA Mode 2 | 16,6 |

| Ultra DMA/33 Mode 2 | 33 |

| Диск | |

| Частота вращения 5400 об/мин | 3—5 |

| Частота вращения 7200 об/мин | 4—7 |

| Частота вращения 10 000 об/мин | 6—9 |

| Сетевая плата | |

| Ethernet | 1 |

| Fast Ethernet | 10 |

| Gigabit Ethernet | 100 |

Другие компоненты (видеосистема, параллельные и последовательные порты и т. д.) в общем случае не должны существенно влиять на производительность файлового сервера. Тем не менее некоторые из них при неправильной настройке операционной системы и прикладных программ могут серьезно ухудшить характеристики сервера. Но об этом мы поговорим позже.

д.) в общем случае не должны существенно влиять на производительность файлового сервера. Тем не менее некоторые из них при неправильной настройке операционной системы и прикладных программ могут серьезно ухудшить характеристики сервера. Но об этом мы поговорим позже.

ОПЕРАЦИОННАЯ СИСТЕМА

Наиболее популярными операционными системами для выделенных файловых серверов являются Novell NetWare, Microsoft Windows NT и IBM OS/2 Warp. Все они имеют достаточно близкие характеристики, но все же по производительности, благодаря своей архитектуре, лидирует NetWare. Она предъявляет и более низкие требования к сетевым ресурсам, в частности к объему оперативной памяти и к видеосистеме. Кроме того, NetWare обладает рядом уникальных характеристик, такими, как поддержка параллельной работы нескольких сетевых плат между сервером и коммутатором (см. заметку «Повышение сетевой производительности сервера» в разделе «Тысяча мелочей» в октябрьском номере LAN за 1997 г.).

Windows NT также имеет весьма неплохие показатели производительности и на мощных машинах ничем не уступает NetWare. Кроме того, она обладает удобным пользовательским интерфейсом и высокой надежностью.

Кроме того, она обладает удобным пользовательским интерфейсом и высокой надежностью.

IBM OS/2 в качестве операционной системы файлового сервера используется значительно реже. Основные претензии к ней — недостаточное количество поддерживаемых устройств и низкое качество драйверов.

Для сетей рабочих станций UNIX обычной практикой является установка серверов с сетевой файловой системой NFS (Network File System). UNIX-серверами могут быть как машины на базе процессоров Intel, так и RISC-системы. Следует помнить, что наиболее распространенной версией NFS остается вторая, а для нее характерны весьма низкие скорости файловых операций, особенно при записи данных.

Мы не будем подробно исследовать влияние операционной системы на производительность файлового сервера, поскольку вопрос выбора ОС часто сугубо субъективен и обусловлен второстепенными (с точки зрения файловых операций) причинами, как-то: удобство интерфейса, надежность системы, поддержка прикладных программ и т. д.

«МОТОР» СЕРВЕРА

Основным двигателем любого компьютера является тандем «процессор — оперативная память».

В настоящее время потенциальные покупатели находятся в некотором замешательстве относительно того, насколько мощный сервер выбрать. Дело в том, что Pentium Pro давно морально устарел, а более современный Pentium II имеет множество ограничений.

Pentium Pro обладал новаторской архитектурой. Кэш-память второго уровня располагалась на одной плате с процессором, причем объем ее может достигать 1 Мбайт. Процессор взаимодействовал с кэш-памятью второго уровня на внутренней частоте шины процессора (до 200 МГц). За счет этого производительность работы системы резко возросла. Обмен данными между кэш-памятью второго уровня и оперативной памятью осуществлялся на частоте системной шины (66 МГц). Pentium Pro может использоваться в многопроцессорных системах, причем число процессоров может достигать четырех, восьми и даже более. К сожалению, Pentium Pro оказался весьма дорогим изделием — слишком много заготовок отбраковывается при его изготовлении. Компания Intel посчитала бесперспективным дальнейшее увеличение тактовой частоты этого процессора.

Более современные Pentium II значительно проще по своей архитектуре. В настоящее время уже вышли процессоры с частотой 400 МГц. Сам процессор и кэш-память второго уровня разнесены между собой. Взаимодействие между ними осуществляется на частоте системной шины, которая составляет 66 МГц для набора микросхем 440LX и 100 МГц для более нового набора микросхем 440BX. По данным тестов, уже процессор Pentium II 300 МГц работает быстрее, чем Pentium Pro 200 МГц. Однако процессорам Pentium II присущ один неприятный недостаток: в один сервер можно установить максимум два процессора (самые последние модели Pentium II Xeon допускают установку до 4 процессоров).

Сразу стоит оговориться, что данная проблема не имеет прямого отношения к файловым серверам. Для выполнения файловых операций в большинстве случаев вполне достаточно одного процессора Pentium II, независимо от операционной системы. Тем не менее и здесь недостатки Pentium II сказываются. И дело не в количестве процессоров в компьютере, а в особенностях системной платы или, точнее, набора микросхем.

Сейчас для Pentium II используются главным образом наборы микросхем 440LX и 440BX. Стандартные системные платы на их основе могут иметь максимум 512 Мбайт оперативной памяти. Но этого может оказаться мало для файлового сервера. Почему?

Диски представляют собой механические устройства с относительно невысокой скоростью обмена. Для повышения скорости файловых операций считываемые с диска или записываемые на диск данные обязательно кэшируются. Это позволяет во много раз повысить скорость обмена с диском. Чем больше оперативной памяти выделяется под кэш диска, тем быстрее работает сервер.

Например, Novell рекомендует исходить из следующего упрощенного расчета: 16 Мбайт оперативной памяти на каждый гигабайт дискового пространства. Кроме того, 16 Мбайт памяти требуется для функционирования самой операционной системы и выполнения прикладных программ. Таким образом, в случае NetWare 4.x предел в 512 Мбайт оперативной памяти ограничивает размер дисковой подсистемы цифрой 30 Гбайт. Такая величина становится обычной в повседневной практике. Между прочим, современные серверы уровня рабочих групп и выше позволяют установить диски объемом 100 Гбайт и более.

Такая величина становится обычной в повседневной практике. Между прочим, современные серверы уровня рабочих групп и выше позволяют установить диски объемом 100 Гбайт и более.

Конечно, вышеперечисленное не означает, что сервер не будет работать с дисковой подсистемой емкостью в 40 или 60 Гбайт, но он оказывается неспособен эффективно обслуживать большое количество пользователей при больших объемах данных.

Для Pentium Pro такой проблемы нет, и мощные серверы могут иметь до 2—4 Гбайт оперативной памяти.

Но все же эта характеристика больше относится к вопросу расширяемости сервера, чем к вопросу его производительности.

Как уже было показано ранее, такие компоненты сервера, как системная шина, тактовая частота процессора, производительность оперативной и кэш-памяти, не являются «узкими местами» с точки зрения выполнения файловых операций в обычной конфигурации, поэтому их выбор вряд ли имеет значение. Какой процессор будет установлен на файловом сервере, Pentium II на 233 МГц или на 450 МГц, — не играет сколько-нибудь серьезной роли не только для NetWare, но даже и для Windows NT и UNIX. То же относится к частоте системной шины (66 или 100 МГц), а также к архитектуре оперативной памяти (EDO или SDRAM). В мощной системе процессор и память, скорее всего, большую часть времени будут простаивать, дожидаясь завершения дисковых операций или обращения к сетевым платам.

То же относится к частоте системной шины (66 или 100 МГц), а также к архитектуре оперативной памяти (EDO или SDRAM). В мощной системе процессор и память, скорее всего, большую часть времени будут простаивать, дожидаясь завершения дисковых операций или обращения к сетевым платам.

И все же с учетом того, что сервер покупается на несколько лет вперед с расчетом на перспективу, весьма уместным будет выбрать машину помощнее. Как известно, сетевые операционные системы развиваются в направлении увеличения требований к ресурсам, и неизвестно, какие новые требования выдвинут очередные версии NetWare или Windows NT. Еще одним стимулом в пользу выбора мощной процессорной системы может оказаться то, что в грамотно сконфигурированной высокопроизводительной сетевой среде (при использовании массивов RAID и параллельно работающих сетевых плат Fast Ethernet на сервере) самым слабым местом может оказаться цепочка «процессор — оперативная память». В данном конкретном случае неплохим решением будет установка второго процессора.

ШИНЫ РАСШИРЕНИЯ

В компьютерах на основе процессоров Intel в разное время доминировали различные типы шин расширения: ISA, EISA, VESA local bus, PCI. Правда, в отличие от других, VESA local bus является истинно локальной шиной.

Шина ISA до сих пор применяется в настольных персональных компьютерах (обычно в дополнение к PCI), но имеет очень невысокую пропускную способность (около 5 Мбайт/с). Ее можно встретить в серверах самого низкого уровня, где она подключается через мост между PCI и ISA к основной шине PCI. Шина ISA используется для обеспечения совместимости со старым оборудованием.

В ранних моделях серверов основной шиной расширения была EISA (в продуктах компании IBM встречалась также шина MCA). Однако в связи с быстрым развитием более мощной архитектуры PCI шина EISA потеряла свою привлекательность. Тем не менее шина EISA до сих пор остается стандартным компонентом серверов среднего и старшего класса в целях обеспечения работы унаследованного оборудования. Характерно, что количество слотов в серверах для плат EISA быстро уменьшается (сейчас эта величина обычно составляет 1-2 посадочных места). Шина EISA в современных серверах подключается к шине PCI через мост.

Характерно, что количество слотов в серверах для плат EISA быстро уменьшается (сейчас эта величина обычно составляет 1-2 посадочных места). Шина EISA в современных серверах подключается к шине PCI через мост.

Шина VESA local bus использовалась на компьютерах с 486-ми процессорами главным образом для видеосистемы, и сейчас она практически не встречается.

Основной шиной расширения в современных компьютерах (и не только на базе процессоров Intel) является 32-разрядная шина PCI. При частоте 33 МГц она обеспечивает пиковую пропускную способность 132 Мбайт/с и среднюю пропускную способность 80 Мбайт/с. В настоящее время разработана 64-разрядная спецификация PCI. Она применяется в компьютерах на базе процессора DEC Alpha; для систем Intel новая шина PCI будет актуальна, скорее всего, не ранее появления процессора Merced (2001 год).

Вследствие конструктивных особенностей, шина PCI поддерживает максимум 3-4 слота — это количество явно недостаточно для современных серверов. Кроме того, при установке большого числа высокопроизводительных периферийных устройств (дисковых массивов, сетевых адаптеров) ограничения в пропускной способности 32-разрядной шины уже начинают сказываться. Поэтому в серверах среднего и старшего класса обычно устанавливают две и даже три шины PCI.

Поэтому в серверах среднего и старшего класса обычно устанавливают две и даже три шины PCI.

Иногда вторую шину PCI подключают через мост к первой. Но этот вариант вряд ли можно считать приемлемым, поскольку основная шина будет испытывать перегрузки. Гораздо выгоднее, чтобы шины работали параллельно. Данный подход сейчас реализован практически всеми солидными производителями серверов.

При наличии параллельно работающих шин PCI задача администратора состоит в равномерном распределении нагрузки между ними. Т. е. при использовании двух SCSI-контроллеров или двух сетевых плат их лучше всего установить на разные шины. Правда, это сопряжено с проблемой обнаружения того, где кончается одна шина и начинается другая. Здесь лучше обратиться к документации. В крайнем случае, мы рекомендуем задействовать наиболее удаленные друг от друга слоты.

ДИСКОВАЯ ПОДСИСТЕМА

Одним из самых слабых мест в обеспечении высокой производительности оказывается дисковая подсистема. Чаще всего разговор сводится к вопросу выбора подходящего контроллера периферийных устройств (IDE, SCSI, Fibre Channel). Но это не совсем вер-

Но это не совсем вер-

но. Так, нередко утверждается, что, поскольку контроллер Ultra DMA/33 имеет почти одинаковую производительность с Ultra/Wide SCSI, то он неплохо подходит для файлового сервера. Такие утверждения в корне неверны. И вопрос даже не в том, что Ultra DMA/33 поддерживает только четыре диска, в то время как Ultra/Wide SCSI — до шестнадцати. Интерфейс IDE/ATA и все производные от него (Fast ATA-2, Ultra DMA/33) плохо подходят для многозадачных и многопользовательских операционных систем, коими являются NetWare, Windows NT, OS/2 или UNIX.

Будучи по сути интеллектуальными устройствами, SCSI-контроллеры сами выполняют большинство низкоуровневых операций ввода/вывода, при этом они оптимизируют запросы к периферийному оборудованию. IDE/ATA-контроллеры перекладывают выполнение значительной части низкоуровневых задач на центральный процессор, тем самым снижая общую производительность сервера.

Исходя из этих соображений устройства IDE выпускаются в расчете на массового пользователя. Самым главным критерием является минимальная цена. Поэтому практически все диски с интерфейсом IDE имеют частоту вращения шпинделя 5400 оборотов в минуту, что обеспечивает скорость дисковых операций 3—5 Мбайт/с.

Самым главным критерием является минимальная цена. Поэтому практически все диски с интерфейсом IDE имеют частоту вращения шпинделя 5400 оборотов в минуту, что обеспечивает скорость дисковых операций 3—5 Мбайт/с.

Диски SCSI устанавливаются для поддержки ответственных приложений, в частности на серверах и рабочих станциях. Частота вращения шпинделя дисков SCSI составляет 7200 оборотов в минуту, что соответствует скорости 4—7 Мбайт/с. Недавно компании Seagate и IBM выпустили дисководы с частотой вращения 10 000 оборотов в минуту, тем самым установив новую планку производительности (скорость 6—9 Мбайт/с).

Справедливости ради стоит отметить, что ряд известных производителей (например, Compaq) устанавливает в серверах IDE/ATA-контроллеры, но исключительно для работы с ATAPI CD-ROM. При этом такие CD-ROM служат лишь для инсталляции операционной системы и приложений на сервере и не предназначены для обслуживания сетевых клиентов.

Под скоростью дисковых операций подразумевают обычно среднюю скорость чтения/записи головок накопителя на поверхности дисковых пластин. Скорость зависит от множества параметров (помимо частоты вращения шпинделя), в частности от места, где располагаются данные, от расстояния между дорожками и т. д. Поэтому она носит несколько обобщенный характер.

Скорость зависит от множества параметров (помимо частоты вращения шпинделя), в частности от места, где располагаются данные, от расстояния между дорожками и т. д. Поэтому она носит несколько обобщенный характер.

Может возникнуть вопрос: а так ли важны эти параметры, если все дисковые операции кэшируются в оперативной памяти? Кроме того, дисковые накопители сами могут располагать встроенными буферами для ускорения обмена.

Здесь нужно иметь в виду следующее. В типичных сетевых средах более 90% всех дисковых операций на сервере приходится на чтение данных с дисков. Конечно, если запрашиваемые данные уже имеются в оперативной памяти (в области кэша), то обращения к диску не происходит вовсе. Однако объем оперативной памяти недостаточен для хранения всего объема дисков, и, кроме того, в памяти может содержаться лишь уже считанная информация. При интенсивном и особенно непрерывном обращении к файлам скорость обмена будет лимитирована скоростью работы дисковых накопителей.

Следовательно, с точки зрения производительности дисковой подсистемы иметь несколько небольших дисков выгоднее, чем один большой. Помимо этого, подключаемое к одному SCSI-контроллеру количество дисков должно быть таково, чтобы сам SCSI-контроллер не стал узким местом. Например, для контроллера Ultra SCSI разумным будет установить не более 3-4 дисководов с частотой 7200 об/мин и 2-3 дисководов на 10 000 об/мин.

Помимо этого, подключаемое к одному SCSI-контроллеру количество дисков должно быть таково, чтобы сам SCSI-контроллер не стал узким местом. Например, для контроллера Ultra SCSI разумным будет установить не более 3-4 дисководов с частотой 7200 об/мин и 2-3 дисководов на 10 000 об/мин.

Но самым эффективным способом повышения производительности дисковой подсистемы является применение RAID. Несколько лет назад массивы дисков использовались лишь в корпоративных серверах и мэйнфреймах. Однако за последнее время цены на RAID-устройства резко упали. Поэтому массивы RAID стали привлекательными не только для серверов старшего и среднего уровня, но даже и для систем начального уровня. Наряду с выполнением задачи повышения надежности хранения информации, массивы RAID позволяют поднять производительность дисковых операций в несколько раз. Особенно высокую скорость имеет спецификация RAID-0.

Технология Fibre Channel считается в настоящее время самой перспективной для дисководов. Однако очень высокая цена препятствует ее использованию для обычных файловых серверов. Прежде всего ее позиционируют для мощных серверов баз данных и информационных хранилищ.

Прежде всего ее позиционируют для мощных серверов баз данных и информационных хранилищ.

СЕТЕВЫЕ ПЛАТЫ

Пожалуй, наиболее узким местом файловых серверов до недавнего времени были сетевые платы. Лет пять назад самой популярной сетевой средой была Ethernet. Хотя теоретическая пропускная способность Ethernet составляет 10 Мбит/с, в типичной разделяемой сети Ethernet оптимальная загрузка составляла 30-35% (т. е. всего 0,3 Мбайт/с). Для сравнения, самый посредственный дисковод имеет производительность 3 Мбайт/с. Увеличение загрузки приводило к геометрическому росту коллизий, что в итоге делало сеть неработоспособной.

После разработки коммутируемого Ethernet острота проблемы ослабла, но не намного. Коммутируемая Ethernet обеспечивала реальную пропускную способность в 0,8 Мбайт/с, что крайне мало для современных технологий.

Технология Fast Ethernet повторяет путь Ethernet, но на более высоком уровне: разделяемая сеть Fast Ethernet дает 3 Мбайт/с, а коммутируемая — 8 Мбайт/с. К сожалению, этого также недостаточно.

К сожалению, этого также недостаточно.

Современные технологии применяют новые подходы к повышению производительности. Сразу оставим в стороне ATM. Эта технология имеет слишком много недостатков, чтобы занять хоть сколько-либо значимое место на уровне соединений «файловый сервер — коммутатор». Высокая цена, большая загрузка процессоров сервера и отсутствие потребности в качестве услуг при выполнении файловых операций делают неперспективным использование для этих целей ATM.

Гораздо более в

Windows Server 2012: настраиваем постоянно доступные общие файловые ресурсы | Windows IT Pro/RE

Постоянно доступные общие файловые ресурсы, Continuously Available File Shares (CAFS), – это новая технология, появившаяся в системе Windows Server 2012. На базовом уровне технология CAFS в системе Server 2012 расширяет возможности Windows по совместной работе с файлами с помощью кластерной технологии Server 2012. Механизмы CAFS используют преимущества новых функций протокола Server Message Block (SMB) 3.0, повышающих доступность общих ресурсов системы Windows Server, используемых для хранения документов и поддержки приложений. В число новых возможностей технологии SMB 3.0, позволяющих задействовать ресурсы CAFS, входят механизмы SMB Scale-Out, SMB Direct и SMB Multichannel.

Технология CAFS призвана решить проблемы, возникающие в ранних версиях файловых серверов высокой доступности, построенных на основе отказоустойчивых кластеров Windows Server. Предыдущие версии обеспечивали высокую доступность общих ресурсов, но были подвержены перерывам в работе и кратковременным потерям подключений в случаях отказа узла. Такие кратковременные сбои, как правило, допустимы в работе офисных приложений (например, Microsoft Office), часто выполняющих операции открытия и закрытия файлов, так как эти приложения могут повторно подключиться к ресурсу и сохранить изменения после отработки отказа. Однако подобные сбои недопустимы в работе таких приложений, как Hyper-V или SQL Server, которые держат файлы открытыми на протяжении длительного времени. В таких схемах сбой может привести к потере данных. До появления системы Server 2012 компания Microsoft не поддерживала установку серверов Hyper-V или SQL Server на общие ресурсы. Обеспечение поддержки приложений было одной из основных задач Microsoft при разработке технологии CAFS. Хотя вы можете использовать механизмы CAFS просто для предоставления клиентского доступа к общим ресурсам, реальной задачей данной технологии является поддержка серверных приложений. Технология CAFS дает возможность использовать преимущества недорогих механизмов хранения системы Windows Server применительно к критически важным приложениям. Технология CAFS обеспечивает непрерывный доступ к общим ресурсам, снижая время простоя практически до нуля.

Выберите решение

Существует два подхода к созданию ресурса CAFS.

- Файловый сервер общего назначения. Это очень похожая на поддержку файлового сервера с высокой доступностью в системе Windows Server 2008 R2, наиболее распространенная реализация технологии CAFS на файловом сервере, которая обеспечивает поддержку размещения общих ресурсов на отказоустойчивом кластере. Технология CAFS повышает доступность и производительность данной схемы, благодаря новому высокопроизводительному механизму клиентского доступа SMB 3.0.

- Масштабируемый файловый сервер. Реализация масштабируемого файлового сервера – это новая возможность технологии CAFS, предназначенная для обеспечения поддержки таких приложений как Hyper-V и SQL Server без простоя в работе. Данная реализация ограничена четырьмя серверами.

Обзор архитектуры CAFS приведен на рисунке.

| Рисунок. Архитектура CAFS |

Одной из ключевых технологий, сделавшей возможным использование ресурсов CAFS, является поддержка механизмов SMB Transparent Failover системой Server 2012. Механизмы SMB Transparent Failover позволяют службам файлового сервера выполнять аварийное переключение на резервный узел кластера, благодаря чему приложения, имеющие открытые файлы на файловом сервере, не заметят обрывов в подключениях. Технология CAFS обеспечивает нулевой простой в работе приложений как при плановом обслуживании, так и при незапланированных отказах.

Соответствие требованиям

Поскольку технология CAFS использует механизмы SMB 3.0 системы Server 2012, наличие операционной системы Server 2012 является обязательным требованием. Технология поддерживается в обеих редакциях, Server 2012 Standard и Server 2012 Datacenter. В редакциях Essentials или Foundation технология CAFS не поддерживается.

Кроме того, для использования технологии CAFS необходимо наличие отказоустойчивого кластера Server 2012. Это означает, что у вас должен быть настроен кластер Server 2012 как минимум из двух узлов. Отказоустойчивые серверы Server 2012 поддерживают до 64 узлов. Вы можете найти пошаговые инструкции по настройке отказоустойчивого кластера в моей статье «Windows Server 2012: Building a Two-Node Failover Cluster» (опубликованной в Windows IT Pro/RE № за 2012 год).

Помимо собственно наличия кластера, на каждый его узел должна быть установлена роль файлового сервера. На кластерном файловом сервере должна быть настроена одна или несколько общих папок с активным новым параметром, отвечающим за постоянную доступность ресурса. Далее я подробно расскажу о создании и настройке постоянно доступных общих папок.

В отказоустойчивом кластере из двух узлов на кластерном хранилище должны быть настроены как минимум два различных тома LUN. На одном томе хранятся общие файлы. Этот том должен быть настроен в качестве общего тома кластера cluster shared volume (CSV). Другой том будет работать в качестве диска-свидетеля. В большинстве решений используется большее количество томов.

Также рекомендуется настроить сеть таким образом, чтобы между узлами было несколько путей. Благодаря такой топологии сеть перестает быть единственной точкой отказа. Использование объединения сетевых адаптеров и/или дублирующих маршрутизаторов позволяет повысить уровень отказоустойчивости вашей сети.

Наконец, для использования преимуществ нового механизма SMB Transparent Failover на компьютерах с клиентом SMB должны быть установлены операционные системы Windows 8 или Server 2012. Когда клиент SMB 3.0 подключается к ресурсу CAFS, он уведомляет службу-свидетеля кластера. Кластер назначает узел, который будет свидетелем для данного подключения. Узел-свидетель отвечает за переключение клиента на новый хост-сервер в случае остановки в работе службы, не вынуждая клиента дожидаться, пока пройдет время отклика протокола TCP.

Создание ресурсов CAFS общего назначения

Для настройки ресурса CAFS откройте мастер Failover Cluster Manager на любом из узлов кластера. Затем щелкните мышью на узле Roles в панели навигации. Как показано на экране 1, в окне Roles отображаются установленные роли.

| Экран 1. Мастер Failover Cluster Manager |

Кластер может поддерживать несколько ролей и обеспечивает высокий уровень доступности для каждой из них. На экране 1 мы видим настроенную виртуальную машину с высоким уровнем доступности. Для создания нового ресурса CAFS общего назначения щелкните мышью по ссылке Configure Role…, отмеченной в окне Actions. Будет запущен мастер High Availability Wizard, показанный на экране 2.

| Экран 2. Мастер High Availability Wizard |

Прокручивайте список ролей до тех пор, пока не увидите роль файлового сервера. Роль файлового сервера поддерживает ресурсы CAFS обоих типов: общего назначения и масштабируемых приложений. Выберите роль File Server и щелкните мышью на кнопке Next, чтобы перейти к экрану выбора типа ресурса CAFS, см. экран 3.

| Экран 3. Окно выбора типа ресурса CAFS |

Диалоговое окно File Server Type позволяет выбрать, какой сервер необходимо создать: файловый сервер общего назначения (File Server for general use) или масштабируемый файловый сервер для данных приложений (Scale-Out File Server for application data). Роль «общего назначения» может быть использована для настройки как общих папок на основе механизма Windows SMB, так и общих папок на основе NFS. Ресурсы CAFS общего назначения также поддерживают устранение дублирования данных, репликацию DFS и шифрование данных. Щелкните мышью на кнопке Next, чтобы продолжить создание ресурса CAFS общего назначения. На экране появится диалоговое окно Client Access Point, показанное на экране 4.

| Экран 4. Окно Client Access Point |

Для создания нового ресурса CAFS общего назначения необходимо указать имя сервера, которое клиенты будут использовать при обращении к ресурсу CAFS. Это имя будет зарегистрировано в DNS, и клиенты будут указывать его по аналогии с именем сервера. Кроме того, ресурсу CAFS общего назначения также необходим IP-адрес. На экране 4 я присвоил службе имя CAFS-Gen (для ресурса CFAS общего назначения) и статический IP-адрес 192.168.100.177. Щелкнув кнопку Next, вы сможете выбрать кластерное хранилище для ресурса CAFS.

Диалоговое окно Select Storage, показанное на экране 5, позволяет выбрать хранилище для ресурса CAFS общего назначения.

| Экран 5. Окно Select Storage |

Хранилище должно быть доступно для служб кластера. Другими словами, оно должно быть в списке узлов хранения кластера и должно быть отмечено как доступное хранилище. Вы не можете использовать предварительно назначенные общие тома кластера CSV для создания ресурса CAFS общего назначения. В данном примере я мог задействовать три различных диска, и выбрал Cluster Disk 5, потому что изначально готовил это хранилище под размещение ресурса CAFS (экран 5). Однако вы можете выбрать любой из доступных дисков кластера. Щелкнув мышью на кнопке Next, вы перейдете к экрану Confirmation. На нем можно подтвердить выбранные настройки или вернуться к диалоговым окнам мастера High Availability Wizard и внести изменения. Если все параметры вас устраивают, щелкните мышью на кнопке Next экрана Confirmation и перейдите к окну Configure High Availability, которое отображает прогресс настройки ресурса CAFS. По окончании настройки вы увидите экран Summary. Щелчок мышью на кнопке Finish экрана Summary закроет мастер High Availability Wizard и вернет вас в окно Failover Cluster Manager, показанное на экране 6.

| Экран 6. Создание постоянно доступной общей файловой папки |

Следующим шагом после создания роли CAFS будет создание постоянно доступной общей файловой папки, использующей данную роль. На экране 6 видно, что роль CAFS-Gen активно работает и использует роль файлового сервера. Для добавления новой постоянно доступной общей файловой папки выберите ссылку Add File Share в окне, которое вы видите в правой части экрана 6. Вы увидите диалоговое окно Task Progress, которое отображает процесс получения информации с сервера. Сразу по завершении на экране появится диалоговое окно New Share Wizard, которое вы видите на экране 7.

| Экран 7. Окно New Share Wizard |

Первым делом мастер New Share Wizard спросит, какой тип ресурса CAFS вы хотите создать. Вы можете выбрать ресурс CAFS одного из двух типов: SMB или NFS. Режим SMB Share—Quick активирует создание ресурса CAFS общего назначения. Режим SMB Share—Applications отвечает за создание высоконадежного общего ресурса приложений для таких систем как Hyper-V или SQL Server. Создание масштабируемых ресурсов CAFS для приложений я рассматриваю ниже. Для создания ресурса CAFS общего назначения выберите режим SMB Share—Quick и щелкните кнопку Next. Мастер New Share Wizard отобразит диалоговое окно Share Location, показанное на экране 8.

| Экран 8. Окно Share Location |

Имя роли CAFS отображается в поле Server Name. На экране 8 мы видим имя роли CAFS-Gen, которую я создал ранее, и ее состояние – online. Вы может выбрать размещение общего ресурса с помощью полей в нижней части экрана. В данном примере по умолчанию был выбран диск G (экран 8). Если вы хотите использовать другой диск, то можете ввести альтернативный путь в поле Type a custom path, расположенном внизу экрана. В этом примере я оставляю предложенный по умолчанию диск G и нажимаю кнопку Next для перехода к диалоговому окну Share Name, показанному на экране 9.

| Экран 9. Имя общего ресурса |

Диалоговое окно Share Name позволяет вам ввести имя общего файлового ресурса. Для простоты я использовал для ресурса CAFS то же имя, что и для службы, CAFS-Gen (экран 9), но это не обязательно. Вы можете дать общей папке любое корректное имя SMB. В центре экрана мы видим локальный и удаленный пути к ресурсу CAFS. Локальный путь в данном примере — G:\Shares\CAFS-Gen. Сетевые системы будут обращаться к общей папке по пути \\CAFS-gen\CAFS-Gen. Щелкнув мышью по кнопке Next, вы откроете диалоговое окно настройки общего ресурса Configure, показанное на экране 10.

| Экран 10. Окно настройки общего ресурса |

Диалоговое окно настройки общего ресурса Configure позволяет контролировать процесс обработки ресурса сервером. Чтобы сделать файловый ресурс постоянно доступным, требуется установить флаг Enable continuous availability. Этот параметр активируется по умолчанию. Параметр Enable access-based enumeration управляет возможностью просмотра файлов и папок пользователями без привилегий. Этот параметр выключен по умолчанию. Параметр Allow caching of share разрешает доступ к ресурсу для пользователей, работающих автономно, посредством технологии BranchCache. И наконец, параметр Encrypt data access позволяет обезопасить удаленный доступ к файлам путем шифрования данных, передаваемых ресурсу и извлекаемых из него. Этот параметр по умолчанию отключен. Щелкнув мышью по кнопке Next, вы откроете диалоговое окно Permissions, показанное на экране 11.

| Экран 11. Назначение общему ресурсу разрешений |

По умолчанию ресурс CAFS создается с привилегиями Full Control, предоставленными группе Everyone. В большинстве решений вы, скорее всего, захотите изменить настройку прав доступа. В данном примере я соглашаюсь с правами доступа, заданными по умолчанию. Щелкнув мышью на кнопке Next, вы перейдете к диалоговому окну Confirmation, где сможете просмотреть сводку действий, выполненных на предыдущих экранах мастера New Share Wizard. Вы можете щелкнуть мышью по кнопке Previous, чтобы вернуться к этим экранам и изменить любые параметры. Нажатие мышью кнопки Create в диалоговом окне Confirmations приведет к созданию ресурса CAFS и настройке прав доступа для общей папки. После того, как ресурс CAFS будет создан, мы сможете обратиться к нему, как к любой общей файловой папке. На экране 12 показано, как подключиться к общему ресурсу, введя в проводнике Windows Explorer имена сервера и общей папки – \\cafs-gen\CAFS-Gen.

| Экран 12. Подключение к общему ресурсу |

Теперь вы можете наполнить общую папку документами и файлами других типов, использование которых станет более эффективным благодаря высокой доступности ресурсов CAFS.

Создание масштабируемых ресурсов CAFS

Основная задача ресурсов CAFS — обеспечить высокий уровень доступности приложений, хранящих данные в общих файловых папках. В прошлом компания Microsoft не предоставляла поддержку такого типа для приложений, подобных системе SQL Server, хранящих свои базы данных на общих файловых ресурсах. Ситуация изменилась с выпуском платформы Server 2012, поддерживающей технологию CAFS. Настройка масштабируемых ресурсов CAFS отличается от настройки ресурсов CAFS общего назначения. Однако для создания масштабируемого решения используется тот же мастер High Availability Wizard. Чтобы создать новый ресурс CAFS для поддержки масштабируемых приложений, выберите ссылку Configure Role… в окне Actions оснастки Failover Cluster Manager (см. экран 1). Далее в диалоговом окне Select Role выберите роль File Server (см. экран 2). Эти два шага такие же, как при создании ресурса CAFS общего назначения. Однако, как показано на экране 13, в диалоговом окне File Server Type необходимо выбрать режим Scale-Out File Server for application data.

| Экран 13. Выбор режима масштабирования ресурсов |

Механизм масштабируемого файлового сервера разработан для приложений, которые оставляют свои файлы открытыми на продолжительное время. Щелкнув мышью кнопку Next, вы перейдете к диалоговому окну Client Access Point, показанному на экране 14.

| Экран 14. Окно Client Access Point |

Диалоговое окно Client Access Point позволяет вам задать имя для роли CAFS. Я назвал масштабируемый ресурс CAFS именем CAFS-Apps (экран 14). Это серверное имя, которое клиентские приложения используют при обращении к общему ресурсу. Щелкнув мышью кнопку Next, вы перейдете на экран Confirmation, где можно подтвердить выбранные решения или вернуться назад к окнам High Availability Wizard и внести изменения. Если все верно, щелкните мышью на кнопке Next экрана Confirmation, чтобы перейти к диалоговому окну Configure High Availability, который отображает прогресс настройки ресурса CAFS. По завершении процесса настройки вы увидите экран Summary. Щелчок мышью на кнопке Finish на экране Summary приведет к закрытию мастера High Availability Wizard и вернет вас к оснастке Failover Cluster Manager.

Следующий шаг — добавление общей файловой папки к CAFS-серверу масштабируемых приложений. Чтобы создать новый файловый ресурс для роли CAFS, выберите ссылку Add File Share из окна Actions, по аналогии с созданием файловой папки общего назначения на экране 6. Щелкните мышью по ссылке Add File Share для масштабируемого ресурса CAFS, чтобы запустить мастер New Share Wizard, показанный на экране 15.

| Экран 15. Выбор профиля для общего ресурса |

Для создания масштабируемого ресурса CAFS из диалогового окна Select Profile выделите профиль SMB Share—Applications в списке File share profile, после чего щелкните мышью кнопку Next, чтобы перейти к диалоговому окну Share Location, показанному на экране 16.

Развертывание кластеризованного файлового сервера с двумя узлами

-

- Чтение занимает 18 мин

В этой статье

Применяется к: Windows Server 2019, Windows Server 2016Applies to: Windows Server 2019, Windows Server 2016

Отказоустойчивый кластер — это группа независимых компьютеров, совместная работа которых позволяет повысить доступность приложений и служб.A failover cluster is a group of independent computers that work together to increase the availability of applications and services. Кластерные серверы (называемые «узлы») соединены физическими кабелями и программным обеспечением.The clustered servers (called nodes) are connected by physical cables and by software. При сбое на одном из узлов кластера его функции немедленно передаются другому узлу (этот процесс называется отработкой отказа).If one of the cluster nodes fails, another node begins to provide service (a process known as failover). В службе можно столкнуться с минимальными нарушениями.Users experience a minimum of disruptions in service.

В этом руководстве описаны шаги по установке и настройке отказоустойчивого кластера файлового сервера общего назначения с двумя узлами.This guide describes the steps for installing and configuring a general purpose file server failover cluster that has two nodes. Создавая конфигурацию в этом руководство, вы можете изучить отказоустойчивые кластеры и ознакомиться с интерфейсом оснастки управления отказоустойчивыми кластерами в Windows Server 2019 или Windows Server 2016.By creating the configuration in this guide, you can learn about failover clusters and familiarize yourself with the Failover Cluster Management snap-in interface in Windows Server 2019 or Windows Server 2016.

Общие сведения о кластере файлового сервера с двумя узламиOverview for a two-node file server cluster

Серверы в отказоустойчивом кластере могут работать в различных ролях, включая роли файлового сервера, сервера Hyper-V или сервера базы данных, а также обеспечивают высокий уровень доступности для различных служб и приложений.Servers in a failover cluster can function in a variety of roles, including the roles of file server, Hyper-V server, or database server, and can provide high availability for a variety of other services and applications. В этом руководство описано, как настроить кластер файлового сервера с двумя узлами.This guide describes how to configure a two-node file server cluster.

Отказоустойчивый кластер обычно включает в себя единицу хранения, которая физически подключена ко всем серверам в кластере, хотя каждый заданный том в хранилище доступен только одному серверу за раз.A failover cluster usually includes a storage unit that is physically connected to all the servers in the cluster, although any given volume in the storage is only accessed by one server at a time. На следующей схеме показан отказоустойчивый кластер с двумя узлами, подключенный к единице хранения.The following diagram shows a two-node failover cluster connected to a storage unit.

Тома хранилища или логические номера устройств (LUN), предоставляемые узлам в кластере, не должны предоставляться другим серверам, включая серверы в другом кластере.Storage volumes or logical unit numbers (LUNs) exposed to the nodes in a cluster must not be exposed to other servers, including servers in another cluster. Это показано на схеме ниже.The following diagram illustrates this.

Обратите внимание, что для обеспечения максимальной доступности любого сервера важно следовать рекомендациям по управлению сервером, например, тщательному управлению физической средой серверов, тестированию изменений программного обеспечения перед их полным внедрением и тщательно отслеживать обновления программного обеспечения и изменения конфигурации на всех кластеризованных серверах.Note that for the maximum availability of any server, it is important to follow best practices for server management—for example, carefully managing the physical environment of the servers, testing software changes before fully implementing them, and carefully keeping track of software updates and configuration changes on all clustered servers.

В следующем сценарии описано, как можно настроить отказоустойчивый кластер файлового сервера.The following scenario describes how a file server failover cluster can be configured. Общие файлы находятся в хранилище кластера, а кластеризованный сервер может работать как файловый сервер, который их использует.The files being shared are on the cluster storage, and either clustered server can act as the file server that shares them.

В следующем списке описаны функции конфигурации общих папок, интегрированные в отказоустойчивую кластеризацию.The following list describes shared folder configuration functionality that is integrated into failover clustering:

Область отображения ограничена только кластеризованными общими папками (без смешивания с некластеризованными общими папками). когда пользователь просматривает общие папки, указывая путь к кластеризованному файловому серверу, на экран будут включены только общие папки, которые являются частью конкретной роли файлового сервера.Display is scoped to clustered shared folders only (no mixing with non-clustered shared folders): When a user views shared folders by specifying the path of a clustered file server, the display will include only the shared folders that are part of the specific file server role. Она будет исключать некластеризованные общие папки и использует часть отдельных ролей файлового сервера, которые находятся на узле кластера.It will exclude non-clustered shared folders and shares part of separate file server roles that happen to be on a node of the cluster.

Перечисление на основе доступа. можно использовать перечисление на основе доступа, чтобы скрыть указанную папку от представления пользователей.Access-based enumeration: You can use access-based enumeration to hide a specified folder from users’ view. Вместо того чтобы разрешить пользователям просматривать папку, но не обращаться к ней, можно запретить им просматривать папку.Instead of allowing users to see the folder but not access anything on it, you can choose to prevent them from seeing the folder at all. Перечисление на основе доступа для кластеризованной общей папки можно настроить так же, как и для некластеризованной общей папки.You can configure access-based enumeration for a clustered shared folder in the same way as for a non-clustered shared folder.

Автономный доступ. можно настроить автономный доступ (кэширование) для кластеризованной общей папки таким же образом, как и для некластеризованной общей папки.Offline access: You can configure offline access (caching) for a clustered shared folder in the same way as for a nonclustered shared folder.

Кластерные диски всегда распознаются как часть кластера: независимо от того, используется ли интерфейс отказоустойчивого кластера, проводник или оснастка управления хранилищем, Windows определяет, назначен ли диск в хранилище кластера.Clustered disks are always recognized as part of the cluster: Whether you use the failover cluster interface, Windows Explorer, or the Share and Storage Management snap-in, Windows recognizes whether a disk has been designated as being in the cluster storage. Если такой диск уже был настроен в оснастке управления отказоустойчивыми кластерами как часть кластеризованного файлового сервера, можно использовать любой из упомянутых выше интерфейсов для создания общего ресурса на диске.If such a disk has already been configured in Failover Cluster Management as part of a clustered file server, you can then use any of the previously mentioned interfaces to create a share on the disk. Если такой диск не был настроен как часть кластеризованного файлового сервера, создать на нем общую папку по ошибке невозможно.If such a disk has not been configured as part of a clustered file server, you cannot mistakenly create a share on it. Вместо этого для предоставления общего доступа необходимо сначала настроить диск в составе кластеризованного файлового сервера.Instead, an error indicates that the disk must first be configured as part of a clustered file server before it can be shared.

Интеграция служб для сетевой файловой системы. роль файлового сервера в Windows Server включает в себя дополнительную службу ролей под названием службы для NFS.Integration of Services for Network File System: The File Server role in Windows Server includes the optional role service called Services for Network File System (NFS). Установив службу роли и настроив общие папки с помощью служб для NFS, можно создать кластеризованный файловый сервер, который поддерживает клиенты на базе UNIX.By installing the role service and configuring shared folders with Services for NFS, you can create a clustered file server that supports UNIX-based clients.

Требования к отказоустойчивому кластеру с двумя узламиRequirements for a two-node failover cluster

Для отказоустойчивого кластера в Windows Server 2016 или Windows Server 2019, который считается официально поддерживаемым решением корпорации Майкрософт, решение должно удовлетворять следующим критериям.For a failover cluster in Windows Server 2016 or Windows Server 2019 to be considered an officially supported solution by Microsoft, the solution must meet the following criteria.

Все компоненты оборудования и программного обеспечения должны отвечать требованиям сертификации для логотипа соответствующей ОС.All hardware and software components must meet the qualifications for the appropriate logo. Для Windows Server 2016 это логотип «сертифицировано для Windows Server 2016».For Windows Server 2016, this is the «Certified for Windows Server 2016» logo. Для Windows Server 2019 это логотип «сертифицировано для Windows Server 2019».For Windows Server 2019, this is the «Certified for Windows Server 2019» logo. Дополнительные сведения о сертифицированных оборудовании и программном обеспечении см. на веб-сайте каталога Microsoft Windows Server .For more information about what hardware and software systems have been certified, please visit the Microsoft Windows Server Catalog site.

Полностью настроенное решение (серверы, сеть и хранилище) должно пройти все тесты в мастере проверки, который является частью оснастки отказоустойчивого кластера.The fully configured solution (servers, network, and storage) must pass all tests in the validation wizard, which is part of the failover cluster snap-in.

Для отказоустойчивого кластера с двумя узлами необходимо следующее:The following will be needed for a two-node failover cluster.

Серверы: Рекомендуется использовать совпадающие компьютеры с одинаковыми или аналогичными компонентами.Servers: We recommend using matching computers with the same or similar components. Серверы для отказоустойчивого кластера с двумя узлами должны работать под управлением одной и той же версии Windows Server.The servers for a two-node failover cluster must run the same version of Windows Server. Они также должны иметь одинаковые обновления программного обеспечения (исправления).They should also have the same software updates (patches).

Сетевые адаптеры и кабель: Сетевое оборудование, как и другие компоненты решения отказоустойчивого кластера, должно быть совместимо с Windows Server 2016 или Windows Server 2019.Network Adapters and cable: The network hardware, like other components in the failover cluster solution, must be compatible with Windows Server 2016 or Windows Server 2019. При использовании iSCSI сетевые адаптеры должны быть выделены для сетевого взаимодействия или iSCSI, а не для обоих.If you use iSCSI, the network adapters must be dedicated to either network communication or iSCSI, not both. Избегайте единственных точек отказа в сетевой инфраструктуре, соединяющей узлы кластера.In the network infrastructure that connects your cluster nodes, avoid having single points of failure. Это достигается несколькими способами.There are multiple ways of accomplishing this. Вы можете подключать узлы кластера к разным сетям.You can connect your cluster nodes by multiple, distinct networks. Можно также соединить узлы кластера в одну сеть, основанную на сгруппированных сетевых адаптерах, дублированных коммутаторах и маршрутизаторах и аналогичном оборудовании, исключающем появление единственных точек отказа.Alternatively, you can connect your cluster nodes with one network that is constructed with teamed network adapters, redundant switches, redundant routers, or similar hardware that removes single points of failure.

Примечание

Если узлы кластера подключены к одной сети, сеть будет передавать требование избыточности в мастере проверки конфигурации.If the cluster nodes are connected with a single network, the network will pass the redundancy requirement in the Validate a Configuration wizard. Однако в отчет будет включено предупреждение о том, что сеть не должна иметь единой точки отказа.However, the report will include a warning that the network should not have a single point of failure.

Контроллеры устройств или соответствующие адаптеры для хранилища:Device Controllers or appropriate adapters for storage:

- Последовательный подключенный SCSI или Fibre Channel: Если вы используете последовательный подключенный SCSI или Fibre Channel, во всех кластеризованных серверах все компоненты стека хранилища должны быть идентичными.Serial Attached SCSI or Fibre Channel: If you are using Serial Attached SCSI or Fibre Channel, in all clustered servers, all components of the storage stack should be identical. Необходимо, чтобы программное обеспечение Multipath I/O (MPIO) и программные компоненты модуля для конкретных устройств (DSM) были идентичными.It is required that the multipath I/O (MPIO) software and Device Specific Module (DSM) software components be identical. Рекомендуется, чтобы контроллеры запоминающих устройств, то есть адаптер шины (HBA), драйверы HBA и встроенное ПО HBA, присоединенные к хранилищу кластера, были идентичными.It is recommended that the mass-storage device controllers—that is, the host bus adapter (HBA), HBA drivers, and HBA firmware—that are attached to cluster storage be identical. При использовании различных HBA следует уточнить у поставщика хранилища, обеспечиваются ли при этом поддерживаемые или рекомендуемые конфигурации.If you use dissimilar HBAs, you should verify with the storage vendor that you are following their supported or recommended configurations.

- iSCSI: При использовании iSCSI на каждом кластерном сервере должен быть один или несколько сетевых адаптеров или адаптеров шины, выделенных для хранилища ISCSI.iSCSI: If you are using iSCSI, each clustered server must have one or more network adapters or host bus adapters that are dedicated to the ISCSI storage. Сеть, используемая для iSCSI, не может использоваться для сетевого взаимодействия.The network you use for iSCSI cannot be used for network communication. На всех кластеризованных серверах сетевые адаптеры для подключения к целевому хранилищу iSCSI должны быть одинаковыми. Рекомендуется использовать адаптеры Gigabit Ethernet или с более высокой пропускной способностью.In all clustered servers, the network adapters you use to connect to the iSCSI storage target should be identical, and we recommend that you use Gigabit Ethernet or higher.

Хранилище: Необходимо использовать общее хранилище, сертифицированное для Windows Server 2016 или Windows Server 2019.Storage: You must use shared storage that is certified for Windows Server 2016 or Windows Server 2019.

Для отказоустойчивого кластера с двумя узлами хранилище должно содержать по крайней мере два отдельных тома (LUN), если для кворума используется диск-свидетель.For a two-node failover cluster, the storage should contain at least two separate volumes (LUNs) if using a witness disk for quorum. Диск-свидетель — это диск в хранилище кластера, предназначенный для хранения копии базы данных конфигурации кластера.The witness disk is a disk in the cluster storage that is designated to hold a copy of the cluster configuration database. Для этого примера кластера с двумя узлами в качестве конфигурации кворума будет использоваться большинство узлов и дисков.For this two-node cluster example, the quorum configuration will be Node and Disk Majority. Большинство узлов и дисков означает, что узлы и диск-свидетель содержат копии конфигурации кластера, и кластер имеет кворум, если большинство из них (два из трех) этих копий доступны.Node and Disk Majority means that the nodes and the witness disk each contain copies of the cluster configuration, and the cluster has quorum as long as a majority (two out of three) of these copies are available. Другой том (LUN) будет содержать файлы, общие для пользователей.The other volume (LUN) will contain the files that are being shared to users.

К хранилищу предъявляются следующие требования.Storage requirements include the following:

- Для использования собственной поддержки дисков, включенной в компонент отказоустойчивого кластера, применяйте базовые, а не динамические диски.To use the native disk support included in failover clustering, use basic disks, not dynamic disks.

- Рекомендуется отформатировать разделы с файловой системой NTFS (для диска-свидетеля раздел должен быть NTFS).We recommend that you format the partitions with NTFS (for the witness disk, the partition must be NTFS).

- Для разделения диска на разделы можно использовать основную загрузочную запись (MBR) или таблицу разделов GPT.For the partition style of the disk, you can use either master boot record (MBR) or GUID partition table (GPT).

- Хранилище должно правильно реагировать на определенные команды SCSI. хранилище должно соответствовать стандарту, именуемому SCSI PRIMARY Commands-3 (SPC-3).The storage must respond correctly to specific SCSI commands, the storage must follow the standard called SCSI Primary Commands-3 (SPC-3). В частности, хранилище должно поддерживать постоянные резервирования, как указано в стандарте SPC-3.In particular, the storage must support Persistent Reservations as specified in the SPC-3 standard.

- Драйвер минипорта, используемый для хранения данных, должен работать с драйвером хранилища Microsoft Storport.The miniport driver used for the storage must work with the Microsoft Storport storage driver.

Развертывание сетей хранения данных с отказоустойчивыми кластерамиDeploying storage area networks with failover clusters

При развертывании сети хранения данных (SAN) с отказоустойчивым кластером следует соблюдать следующие рекомендации.When deploying a storage area network (SAN) with a failover cluster, the following guidelines should be observed.

Подтвердите сертификацию хранилища: С помощью сайта каталога Windows Server убедитесь, что хранилище поставщика, включая драйверы, встроенное по и программное обеспечение, сертифицировано для windows Server 2016 или windows Server 2019.Confirm certification of the storage: Using the Windows Server Catalog site, confirm the vendor’s storage, including drivers, firmware and software, is certified for Windows Server 2016 or Windows Server 2019.

Изоляция устройств хранения данных, один кластер на устройство: Серверы из разных кластеров не должны иметь доступ к одним и тем же устройствам хранения.Isolate storage devices, one cluster per device: Servers from different clusters must not be able to access the same storage devices. В большинстве случаев LUN, используемый для одного набора серверов кластера, должен быть изолирован от всех других серверов через маскирование или зонирование LUN.In most cases, a LUN that is used for one set of cluster servers should be isolated from all other servers through LUN masking or zoning.